Facebook@ICLR2021:GNN中加入标签传播,训练时间直降100倍

极市导读

本文介绍了一篇ICLR2021的工作,通过组合忽略图结构的浅层模型和利用标签结构相关性的两个简单后处理步骤,获得比GNN训练时间快100倍的性能。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

图神经网络(GNN)是学习图的主要技术,并且已经得到非常广泛的应用。但是GNN训练往往需要大量的参数且训练时间很长。这里我们可以通过组合忽略图结构的浅层模型和利用标签结构相关性的两个简单后处理步骤,来获得GNN性能的提升。例如,在OGB-Products数据集上,相对性能最好的GNN模型,我们将参数减少_137倍_,训练时间减少超过100倍,还能获得更好的性能。

(1)“误差相关性”,它分散训练数据中的残留错误以纠正测试数据中的错误

(2)“预测相关性”,它使测试数据上的预测变平滑。我们称此过程为“纠正和平滑”(C&S)

后处理步骤是通过从早期基于图的半监督学习方法对标准标签传播技术进行简单修改而实现的。我们的方法在各种各样的网络上都超过或接近了最新的GNN的性能基准,并且参数和运行时间大大减小。我们将标签信息直接整合到学习算法中,从而获得简单而可观的性能提升。我们还将该技术融合到大型GNN模型中,从而获得性能的提升。

01前言

近年来,研究人员提出了各种GNN,但是它们的性能提升却非常困难,也很难将它们扩展到大型数据集。因此我们决定结合简单的多个模型来达到同样的目标。

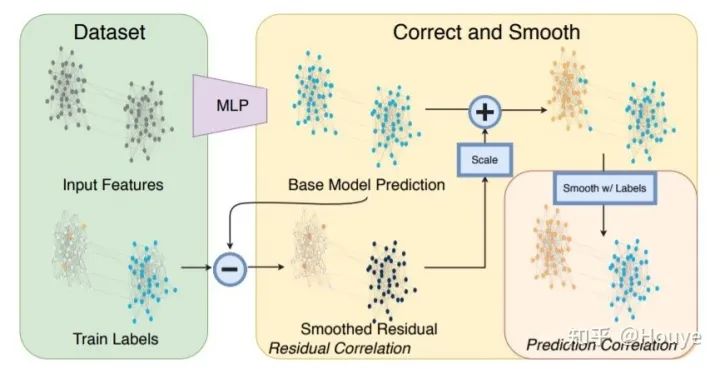

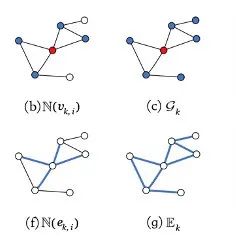

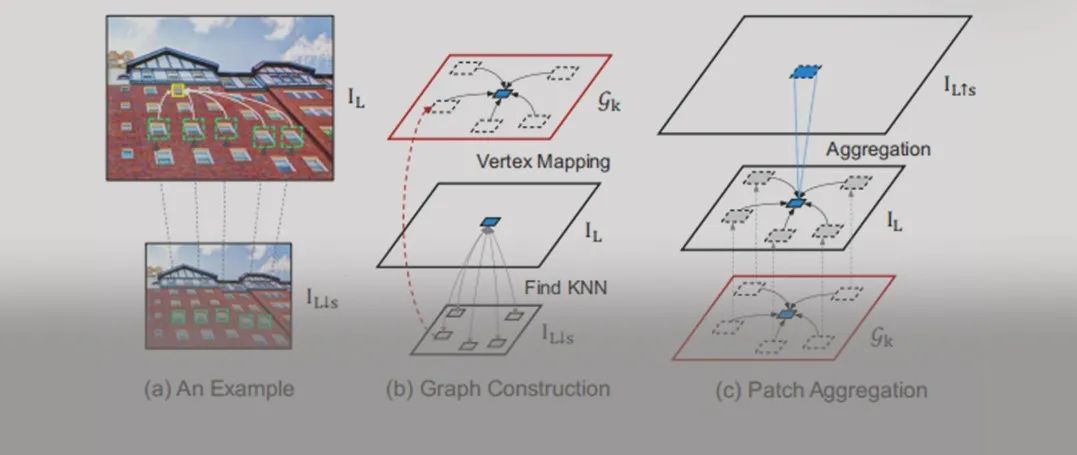

我们提出了包含三个主要部分的简单管道,如图1所示

(1)使用节点特征(忽略图结构)做出基本预测(例如MLP或线性模型)

(2)校正步骤,其将训练数据中的不确定性传播到整个图上,以校正基本预测

(3)平滑图上的预测

图1

左群集用橙色表示,右群集用蓝色表示。我们忽略图结构使用MLP进行基本预测,我们假设在此示例中的所有节点上都得到了相同的预测。然后,通过在训练数据中传播错误来校正基本预测。最后,用标签传播对校正的预测进行平滑。

通过对这些经典思想的修改和应用,我们可以在多个节点分类任务上获得最先进的性能,胜过了大型GNN模型。在我们的框架中,图结构不用于学习参数,而是用作后处理。这种简单性导致模型的参数减少了几个数量级,从而训练所需的时间也减少了几个数量级。我们还可以将我们的想法与最新的GNN相结合,并看到性能提升。

总体而言,结合几个简单的模型就可以在转导节点分类中获得出色的性能,而参数数量和训练时间都很少。我们发现将标签更直接地整合到学习算法中是关键。我们希望我们的方法能够激发出新的想法,这些想法可以帮助完成其他图学习任务,例如归纳节点分类,链路预测和图预测。

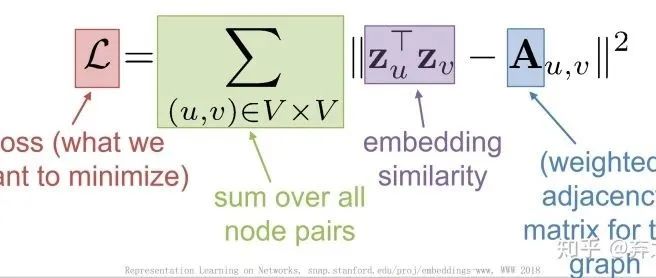

02 纠正和平滑模型

我们首先用一个不依赖于图结构的基本预测器(这里我们用线性预测或MLP即后处理来预测),得到基础预测 。之后,我们通过在训练数据上传播已知错误来估计错误 ,从而得到错误校正的预测 。最后,我们将它们视为未标记节点上的得分向量,并通过另一个LP步骤将它们与已知标记组合以生成平滑的最终预测。我们将此通用管道称为“纠正和平滑”(C&S)。

03 实验

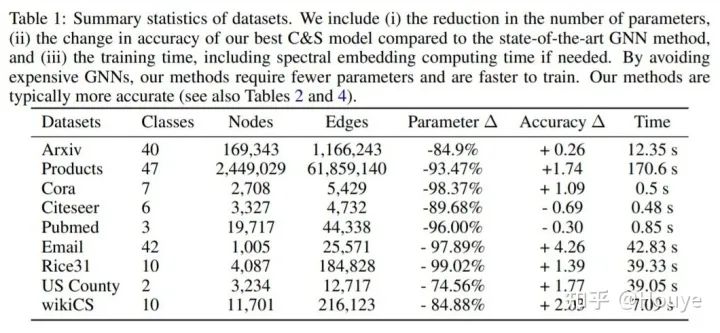

首先只在C&S框架中使用训练标签,在九个数据集上得到结果如表1所示

结果中包括(i)减少参数数量;(ii)与最新的GNN方法相比,我们最佳C&S模型的准确性变化;(iii)训练时间。可以看到我们的方法在较少的参数,较快的训练速度上得到了更准确的结果。

然后我们利用训练和确认标签一起进行训练,其中确认标签不是用来更新基本预测模型的,是用来选择超参数的。得到了表4的结果。

我们发现:

1.大而难以训练的GNN在节点分类中不是必要的。

2.将分类标签传播和简单预测器结合可以比图神经网络表现更好。

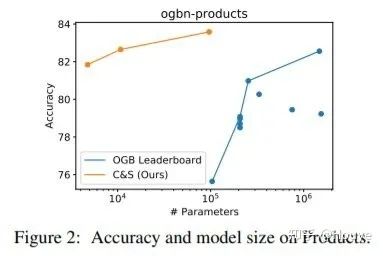

与GNN或其他最先进的解决方案相比,我们的C&S框架通常需要更少的参数。我们在图2中绘制了产品的参数与性能的关系图。虽然使用较少的参数收益很大,但真正的收益在于训练时间的缩短,而且与具有相当的准确性的模型相比,我们的训练模型通常要快几个数量级,因为我们没有将图结构用于基本预测。

04 总结

近年来,GNN模型虽然性能变得更好,但是其参数也越来越多,训练时间也越来越长。因此我们考虑用其他方法来改善其性能,比如利用标签传播和特征增强技术。特别地,标签传播及其变体是非常具有前瞻性的想法。我们已经证明,将其纳入图学习模型可以获得更好的预测,更短的训练时间。

推荐阅读

2020-12-28

2020-09-28

2020-07-02

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~