CVPR 2021 | 目标引导的人类注意力估计提升零样本学习

点击左上方蓝字关注我们

作者 | zlbuaa@知乎

链接 | https://zhuanlan.zhihu.com/p/359732073

根据经验,当人类看到一个新类别时,往往能够关注到新类别和以往所认识类别共有的区别性属性区域,通过属性描述便可以确定新的类别。来自北京航空航天大学、东京大学、格里菲斯大学的研究者们共同提出了一种基于目标引导的人类注意力估计的零样本学习方法。这项工作被CVPR 2021接收。

论文地址:https://arxiv.org/abs/2103.03433

论文代码即将开源:

https://github.com/osierboy/GEM-ZSL

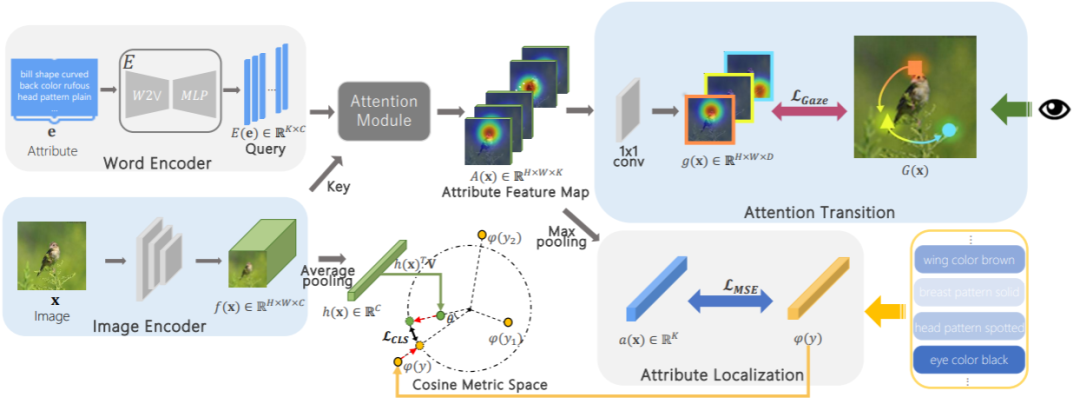

在这一成果中,研究者们希望模型可以关注到人类所关注的语义区域,因此提出一个人类注意力估计模块(Gaze Estimation Module,GEM)捕捉可区分性的语义信息来帮助属性区域的定位。结合这些局部信息以及目标的全局信息,模型可以更好的识别不可见类别。

全局视觉特征学习

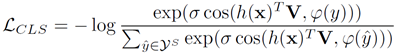

首先,模型通过由ResNet-101实现的图像编码器来提取图片的全局视觉特征,然后构建视觉特征和语义特征的映射关系。这里通过Cosine距离来衡量视觉特征和语义中心:

Cosine相似可以缓解神经元的方差,使得模型具备更好的泛化性能。

这一部分是模型的核心,用来提取人类所关注的局部特征。往往对一个新类别的识别,更重要的是能够关注到了他们具备区分性信息的局部特征, 例如斑马, 我们在知道马的先验知识后加上黑白条纹便可以识别出这类动物,这样局部的条纹特征便成为我们关注的区域。

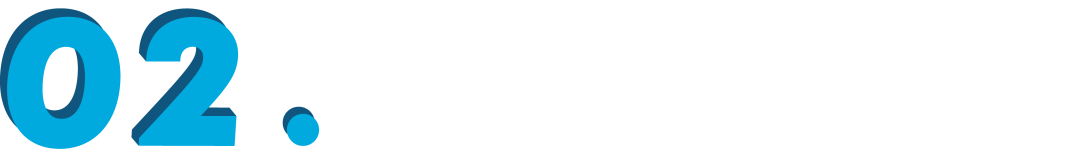

首先,模型通过属性词向量作为索引,对图片的属性区域进行检索。这由双线性池化机制实现的注意模块完成,将词向量(query)和视觉特征(key)作为模块的输入得到属性特征图,再经过注意力转移模块以及gaze loss将属性特征图转变为人类注意力(human gaze)。

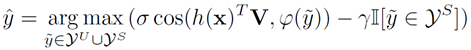

零样本学习

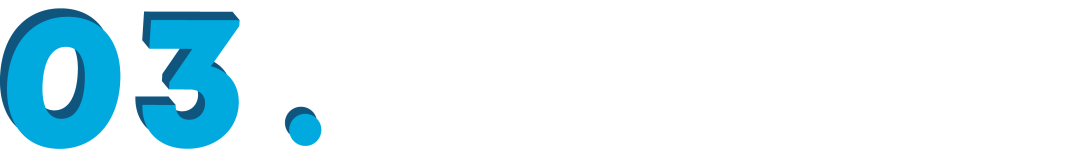

在传统零样本学习(ZSL)的设定下,在cosine空间,分类器对不可见类的样本进行分类:

在通用式零样本学习(GZSL)设定下,因为存在着对可见类由较大偏移的问题,因此通过calibrated stacking技术对其缓解:

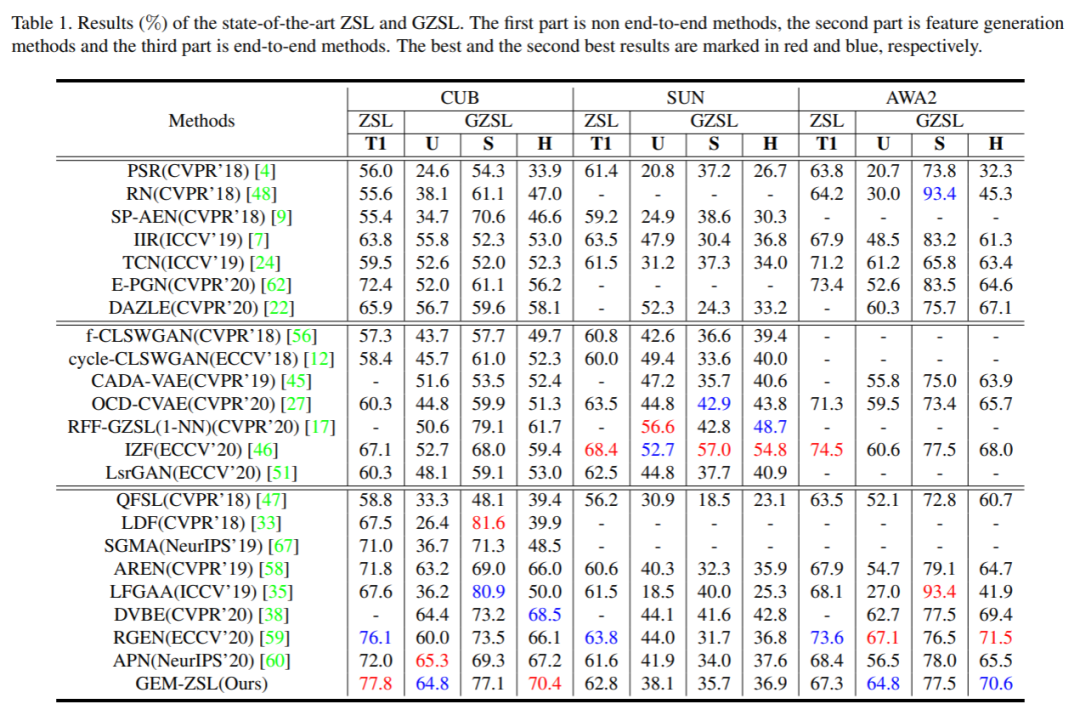

实验结果

为了对所提出方法的有效性进行验证,研究者们和近几年的state-of-the-art零样本学习方法进行对比:

在CUB上,GEM-ZSL超过了所有方法,达到最高性能。AWA2上,GEM-ZSL也表现优异,达到第二的性能。对于SUN,因为存在700多个类别,基于生成模型模型的方法在此数据集上会表现的更好一些,但是GEM-ZSL在非生成模型中也是具有竞争力的。

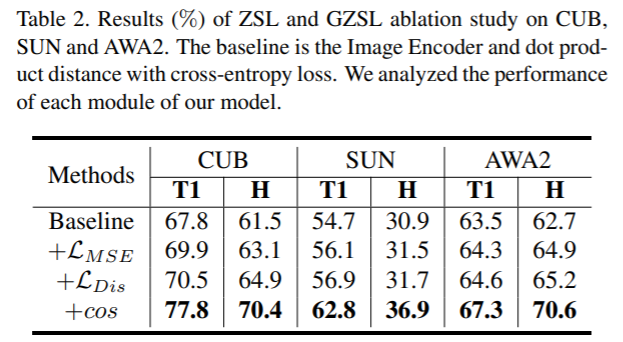

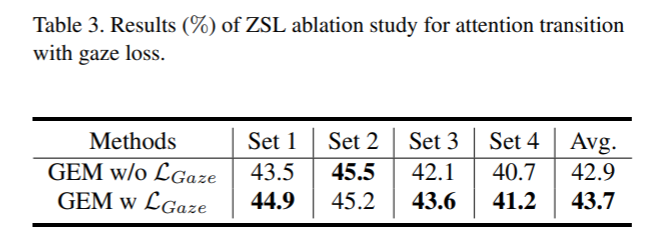

为了对所提方法的各个模块的性能进行分析,研究者们进行了大量消融实验:

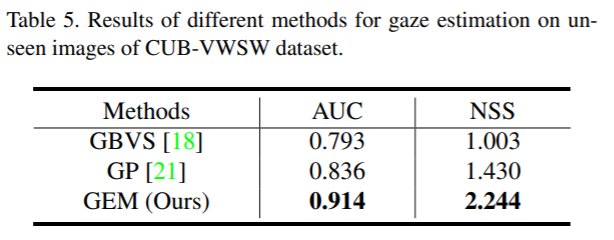

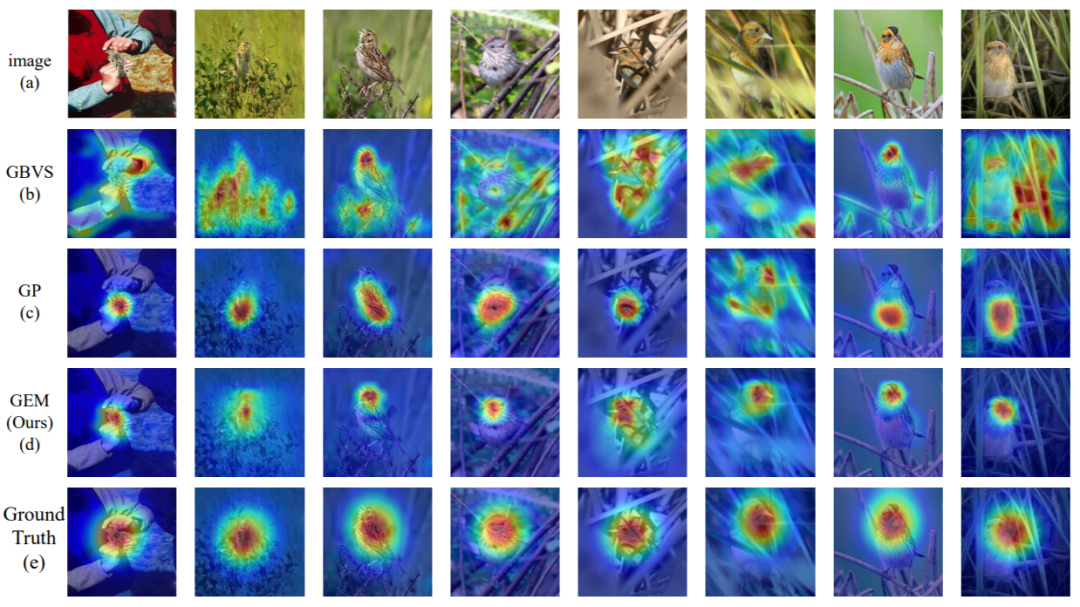

除了对零样本学习任务的验证,研究者们在Gaze Estimation任务中也进行了定量与定性的分析:

在定量结果中,GEM超过了bottom-up的GBVS和top-down的GP两个Gaze Estimation baseline方法。

在定性分析中,GEM对gaze区域的可视化结果也优于GBVS和GP:

参考文献

参考文献

Wenjia Xu, Yongqin Xian, Jiuniu Wang, Bernt Schiele, and Zeynep Akata. Attribute prototype network for zero-shot learning. NeurIPS, 2020.

Dat Huynh and Ehsan Elhamifar. Fine-grained generalized zero-shot learning via dense attribute-based attention. CVPR, 2020.

Guo-Sen Xie, Li Liu, Fan Zhu, Fang Zhao, Zheng Zhang, Yazhou Yao, Jie Qin, and Ling Shao. Region graph embedding network for zero-shot learning. ECCV, 2020.

Nour Karessli, Zeynep Akata, Bernt Schiele, and Andreas Bulling. Gaze embeddings for zero-shot image classification. CVPR, 2017.

Yifei Huang, Minjie Cai, Zhenqiang Li, and Yoichi Sato. Predicting gaze in egocentric video by learning task-dependent attention transition. ECCV, 2018.

END

整理不易,点赞三连↓