作者:Richmond Alake 翻译:陈之炎 校对:zrx本文约3300字,建议阅读5分钟

本文旨在为数据科学家提供一些基础知识,以理解在训练神经网络时所需调用的底层函数和方法。

标签:神经网络,梯度下降,反向传播

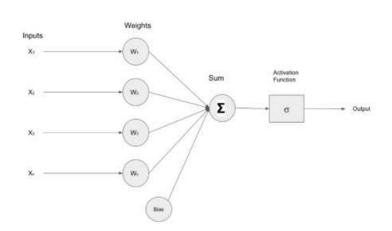

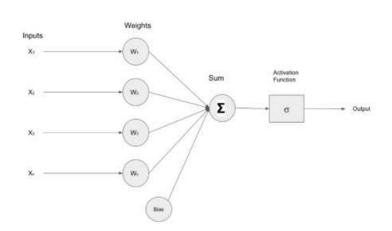

人工神经网络[ANN)是人工智能技术的基础,同时也是机器学习模型的基础。它们模拟人类大脑的学习过程,赋予机器完成特定类人任务的能力。数据科学家的目标是利用公开数据来解决商业问题。通常,利用机器学习算法来识别模式,用算法模型实现预测。如何为特定的用例选择正确的模型,并适当地调整参数?这需要对问题和底层算法有清晰的理解,即充分理解问题和算法,确保使用正确模型,并正确解释结果。本文介绍并解释了梯度下降算法和反向传播算法。人工神经网络利用这些算法学习数据集,当神经网络中数据发生变化时,应如何去修正网络参数。人类大脑的学习过程是复杂的,当前的研究工作只涉及到人类学习方式的表像。然而,已知的研究结果对构建模型非常有价值,与机器不同,在做逻辑预测时,人类无需借助大量的数据来解决问题,人们直接从经验和错误中吸取教训。人类通过突触可塑性的过程来学习,突触可塑性是一个术语,用来描述在获得新的信息后,如何形成和加强新的神经连接。当人类经历新事件时,大脑中的连接会加强,通过训练人工神经网络,计算出预测的错误率,在此基础上来决策是加强或削弱神经元之间的内部连接。梯度下降算法是一种标准的优化算法,通常,它是机器学习优化算法的首选算法。首先,来剖析一下术语“梯度下降”,以更好地理解它与机器学习算法之间的关系。梯度是直线或曲线陡峭程度的量化度量,在数学上,它表示一条直线的上升或下降的方向。下降是指向下走的行为。因此,从这个术语的定义可以得出:梯度下降算法是对向下运动程度的量化。为了训练一个机器学习算法,需要识别网络中的权重和偏差,这将有助于问题的解决。例如,在分类问题中,当查看图像时,需要确定图像是否为猫或狗。为此,必须构建模型,将需求建模为函数,更具体地说,是成本函数。成本函数又称为损失函数,利用成本函数衡量模型的出错程度。成本函数的偏导数影响模型的权重和偏差。梯度下降是一种算法,用于搜索使成本函数最小化或准确度最优的那些参数。神经网络令人印象深刻,同样令人印象深刻的是:在尚未明确告知要检测的特征的情况下,计算程序能够区分图像和图像中的对象。把神经网络看作是一个接收输入(数据)的函数,并生成一种输出预测,该函数的变量便是神经元的参数或权重。因此,神经网络的关键任务是以一种近似或最佳的方式来调整数据集的权重和偏差值。下图描述了一个简单的神经网络,它接收输入(X1、X2、X3、Xn),将这些输入推送给包含权值(W1、W2、W3、Wn)的神经元。输入和权值经过乘法运算,结果由加法器()求和,激活函数调节该层的最终输出。

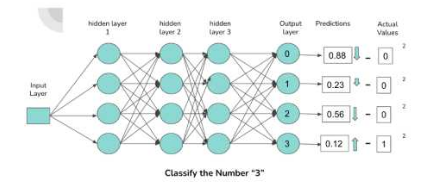

为了评估神经网络的性能,需要一种机制来量化神经网络预测值和实际数据样本值之间的差异,从而计算出影响神经网络内权重和偏差的修正因子。成本函数填补了神经网络的预测值与数据样本的实际值之间的误差距离。

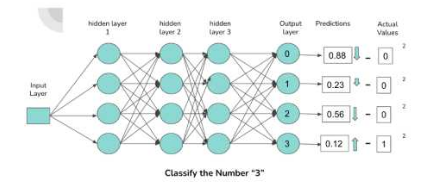

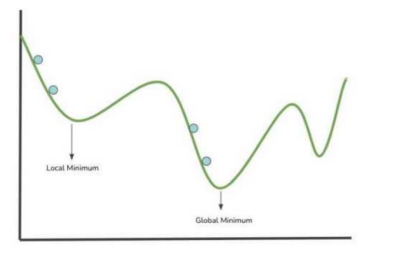

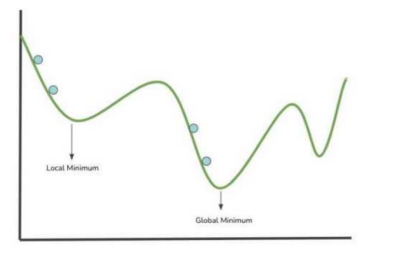

上图描述了一个简单的密集连接神经元的神经网络结构,它对包含数字0-3的图像进行分类。输出层中的每个神经元都对应一个数字,与神经元连接的激活程度越高,神经元输出的概率就越高,该概率为通过前馈网络的数字与被激活的神经元相关联的概率。当数字 “3”通过网络前馈时,将为 “3”分类的连接(由图中的箭头表示)分配更高的激活,使得输出与数字“3”神经元关联的概率更大。负责神经元的激活,即偏差、权重和前一层的激活的组件有不少,这些特定的组件经过迭代修正,使得神经网络在特定的数据集上执行最优操作。利用“均方误差”成本函数,获取神经网络的误差信息,通过网络的权值和偏差,将这些信息后向传播给神经网络进行更新。在讨论完如何通过一种网络预测技术来提高神经网络的性能之后,下文将集中讨论梯度下降、反向传播和成本函数之间的关系。图3绘制了x和y轴上的成本函数,该成本函数保存函数参数空间内的全部数值。接下来,让我们来看看神经网络是如何通过成本函数可视化来实现学习,曲线为神经网络参数空间内分布不均匀的权重/参数值。

上图中的蓝色点表示搜索局部最小值时进行的一个步骤(成本函数中求参数值)。模型成本函数的最低点对应于使成本函数最小的权重值的位置。成本函数越小,神经网络的性能越好。因此,可以根据上图中获取到的信息来修改网络的权重。梯度下降是一种引导在每个步长中选取接近最小值的算法。局部最小值:成本函数在指定范围内的最小参数值。

全局最小值:成本函数全域内的最小参数值。

梯度下降算法通过计算可微函数的梯度并沿梯度的相反方向移动,搜索使得局部/全局函数最小化的那个值。反向传播是通过对影响神经元输出的组件(偏差、权重、激活)进行迭代调整,从而使得成本函数变小的机制。在神经网络的架构中,神经元的输入,包括与前一层神经元的所有连接,决定了它的输出。反向传播所涉及的关键数学公式是导数的计算。反向传播算法计算成本函数相对于权重、偏差和前一层激活的偏导数,以确定哪些值影响成本函数的梯度。

图4:误差的向后传播 图片来源:《深度学习》,第三章,3蓝1棕通过计算梯度,最小化成本函数,得到一个局部最小值。在每次迭代或训练步长中,根据计算出的梯度对网络的权值以及学习率进行更新,它控制着权值的修改因子。在神经网络的训练阶段,每个步长都重复这个过程。理想情况下,目标是在经过一个步长之后,会更加接近局部最小值。“反向传播”这个名称来自于进程的字面意思,即“误差的反向传播”,梯度的偏导数对误差进行量化。通过网络向后传播误差,利用最后一层(最接近输出层的层)梯度的偏导数来计算第二层到最后一层的梯度。利用当前层中前一层的梯度的偏导数确定误差在各层中的传播,一直传播到网络中的第一层(与输入层最近的层)。这只是一个关于梯度下降算法的入门介绍,梯度下降算法还涉及到数学和微积分知识。虽然诸如TensorFlow、SciKit-Learn、PyTorch等软件包已经将复杂的训练和优化算法进行了抽象,然而,这并未降低数据科学家和ML从业者充分理解这些智能“黑盒子”幕后细节的要求。想要了解更多与反向传播算法相关的数学知识吗?以下资源供参考:神经网络:通过反向传播进行训练

反向传播

反向传播算法的工作原理

通过学习英伟达深度学习研究所的各种课程,深入了解深度学习的世界。作者:Richmond Alake

Richmond Alake是一名机器学习和计算机视觉工程师,他与各种初创公司合作,利用深度学习模型来解决商业应用程序中的计算机视觉任务。他在技术领域深耕五年,为大型企业集团构建应用程序,并将人工智能技术集成到移动应用程序中。他写了100多篇关于人工智能和机器学习主题的文章,浏览量超过100万次。Richmond认为:机器学习在日常问题中会有功能强大的应用。目前,他正主持多个项目,利用机器学习算法和深度学习模型来解决与人体工程学和社会网络有关的问题。

A Data Scientist's Guide to Gradient Descent and Backpropagation Algorithmshttps://developer.nvidia.com/blog/a-data-scientists-guide-to-gradient-descent-and-backpropagation-algorithms/推荐阅读

我逃到国企了

再也不接私活了

Kaggle出了一本竞赛书(500页)

机器学习基础:用 Lasso 做特征选

机器学习自动补全代(hán)码(shù)神器

整理不易,点赞三连↓