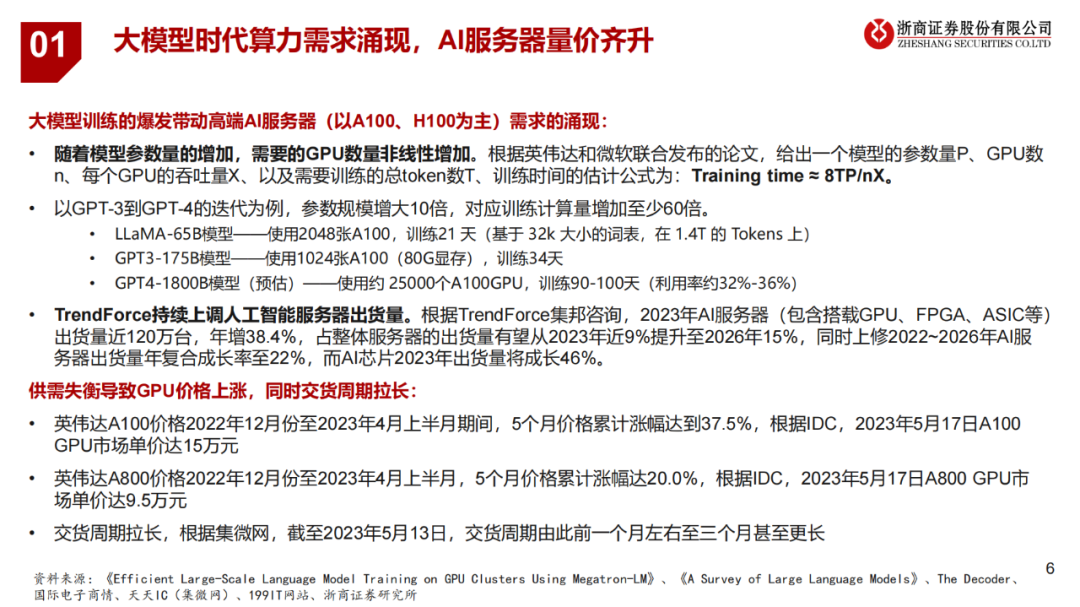

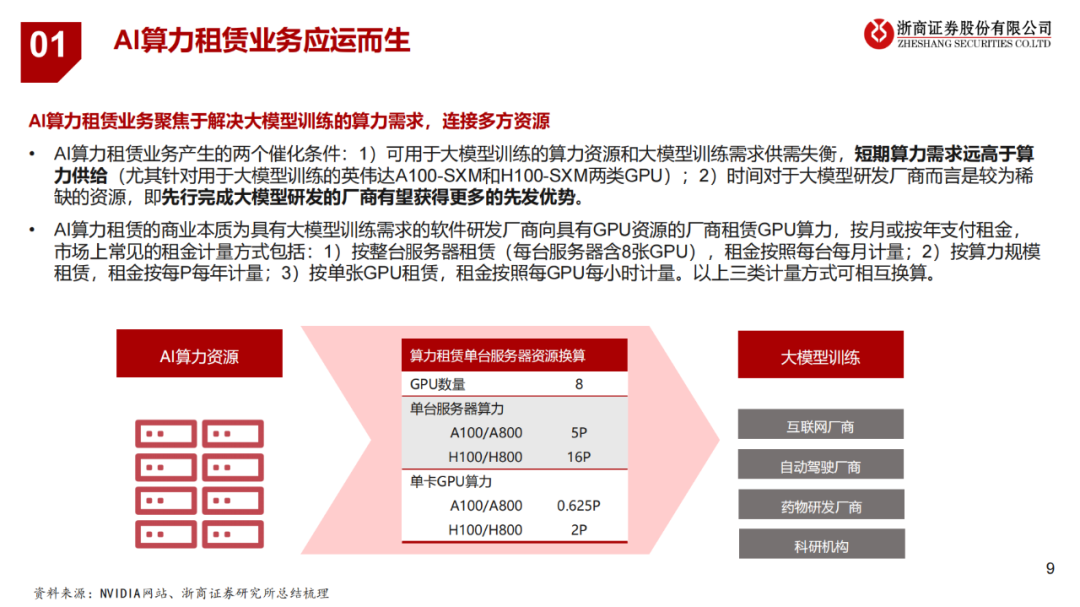

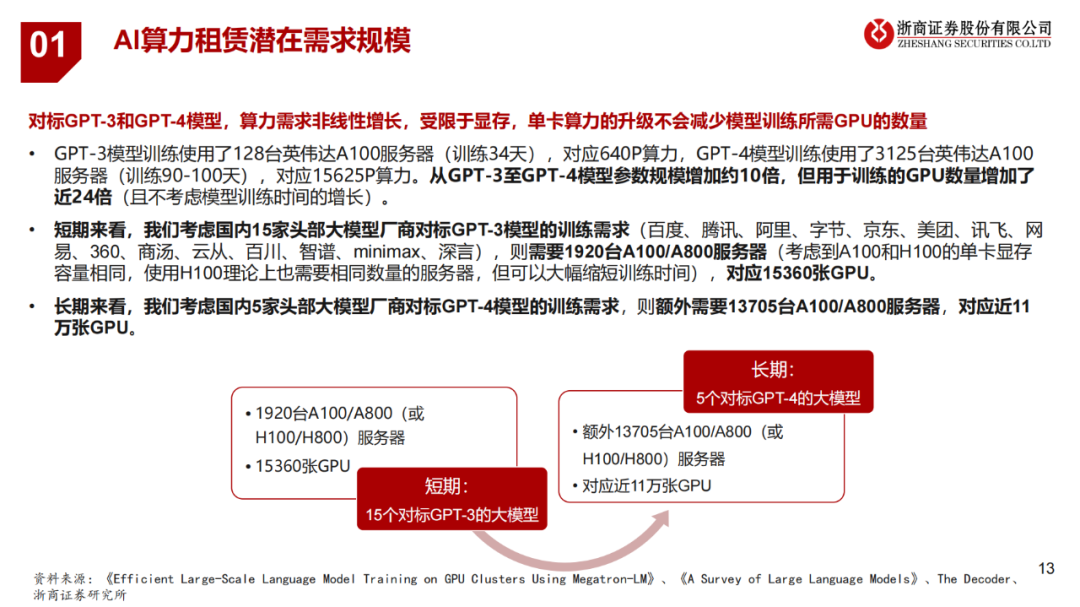

短期来看,我们考虑国内15家头部大模型厂商对标GPT-3模型的训练需求,测算需要1920台A100/A800服务器,对应15360张GPU;长期来看,我们考虑国内5家头部大模型厂商对标GPT-4模型的训练需求,测算额外需要13705台A100/A800服务器,对应近11万张GPU。

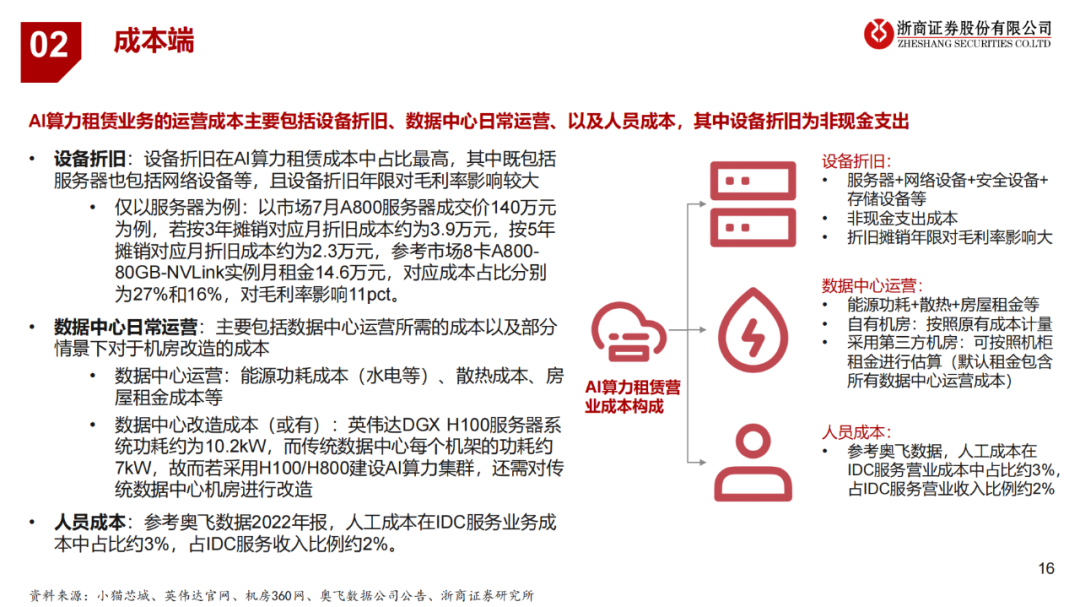

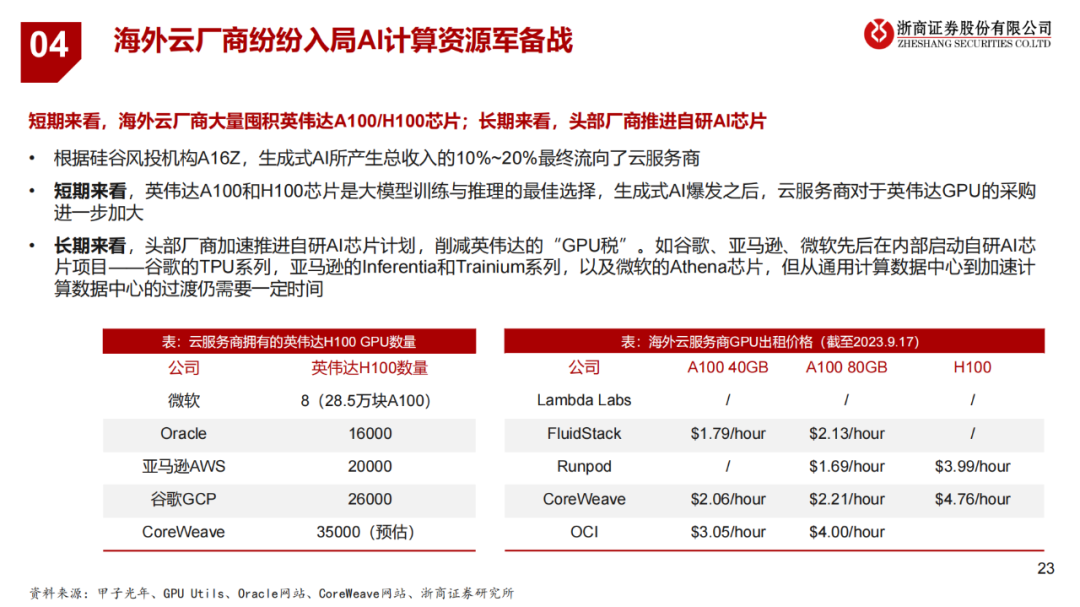

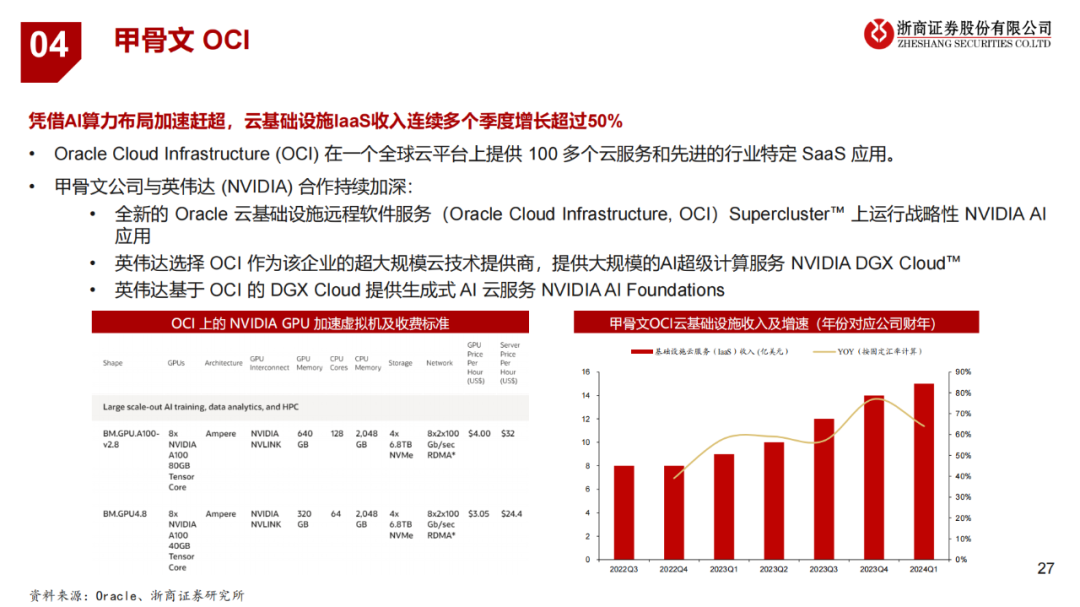

从价格来看,GPU的租金价格随着配置性能的提升呈现上升趋势(不考虑CPU、存储等其他参数的影响),其中单就A100算力而言,最高配置约为最低配置价格的1.8倍。从成本来看,AI算力租赁业务的运营成本主要包括设备折旧、数据中心日常运营、以及人员成本,其中设备折旧为非现金支出。

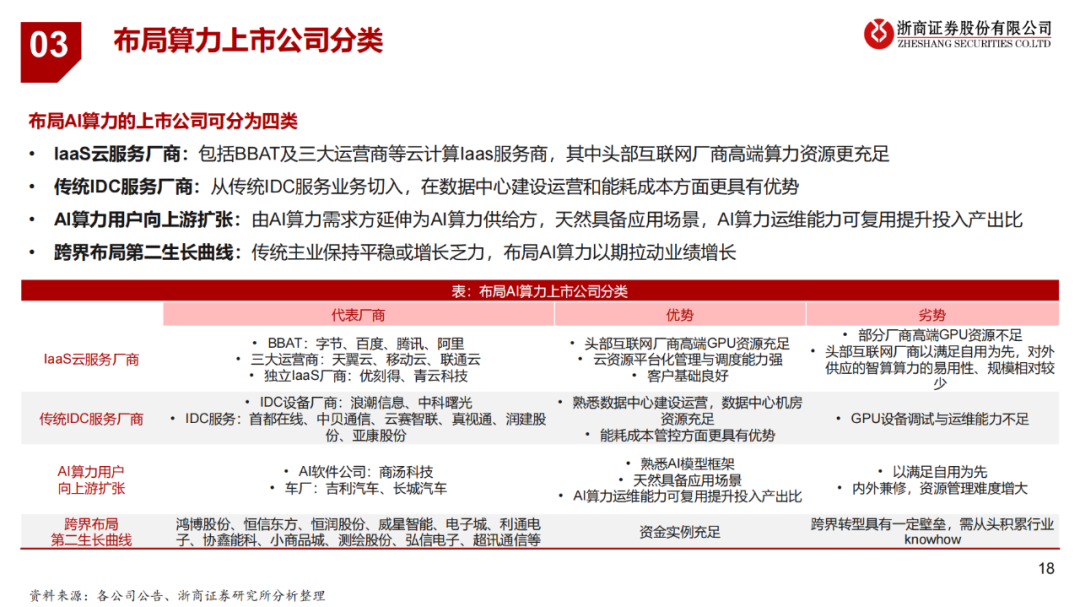

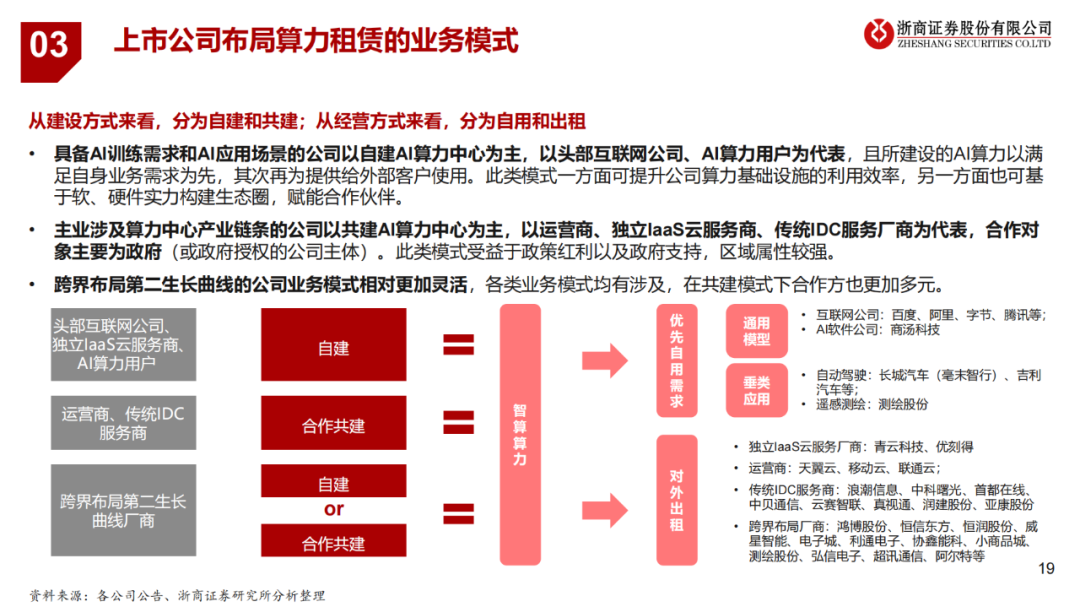

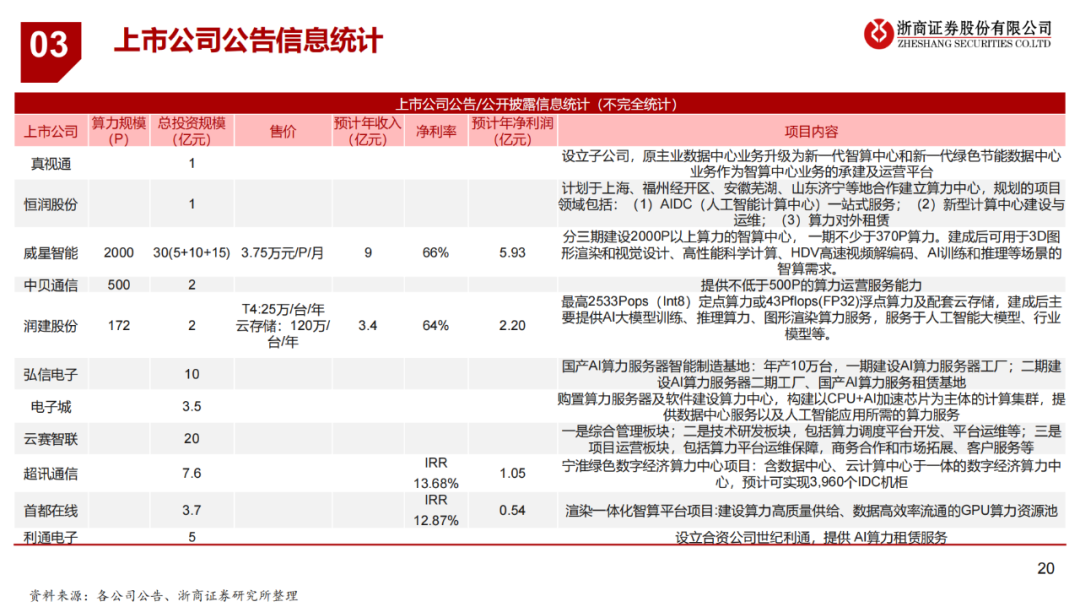

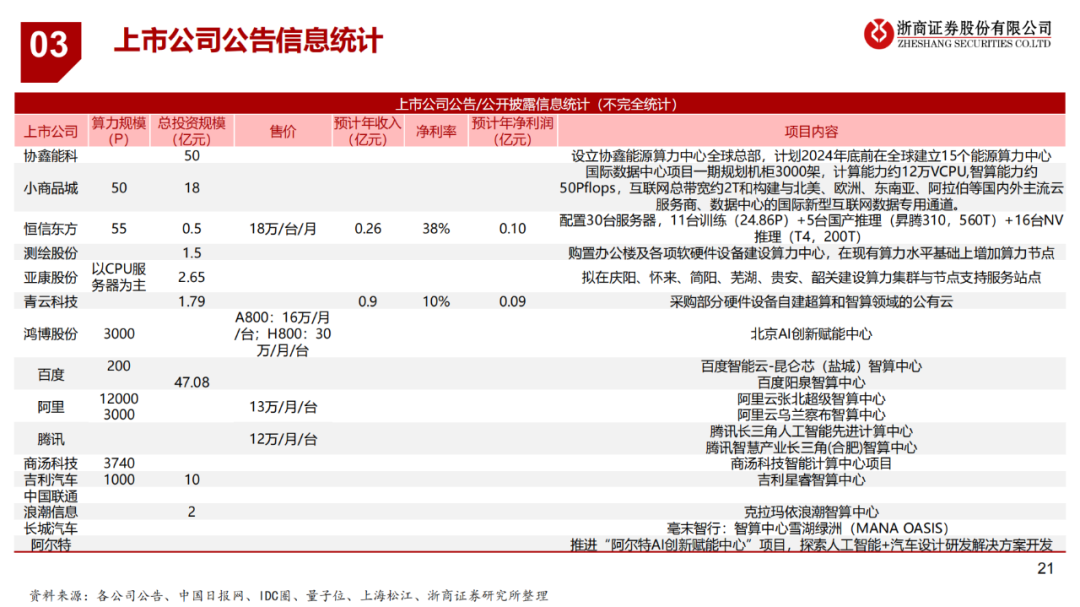

布局AI算力的上市公司可分为四类:IaaS云服务厂商、传统IDC服务厂商、 AI算力用户向上游扩张、跨界布局第二生长曲线。

从建设方式来看,分为自建和共建;从经营方式来看,分为自用和出租。

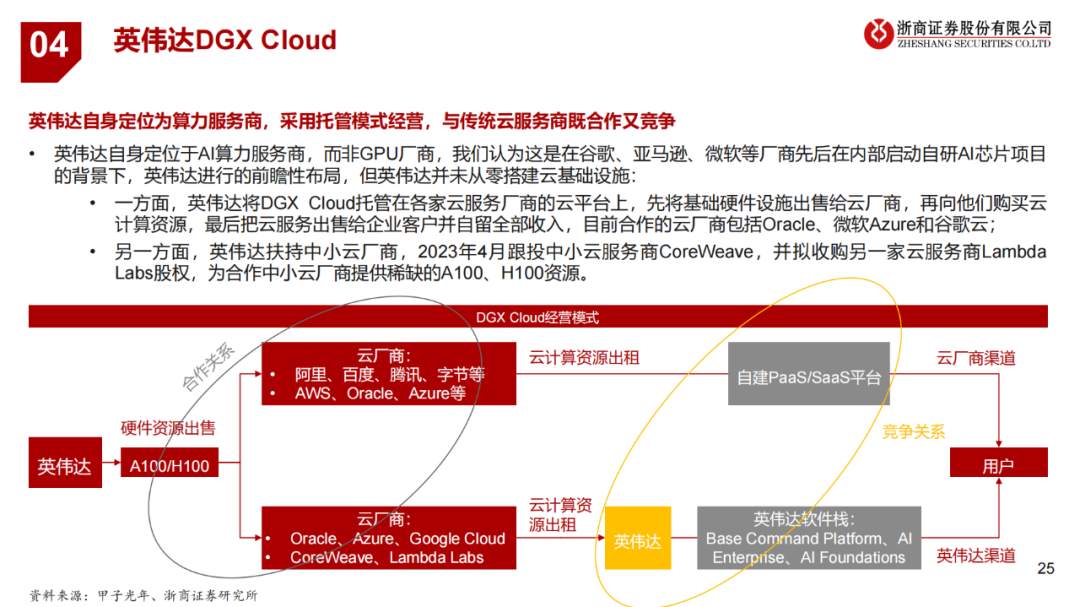

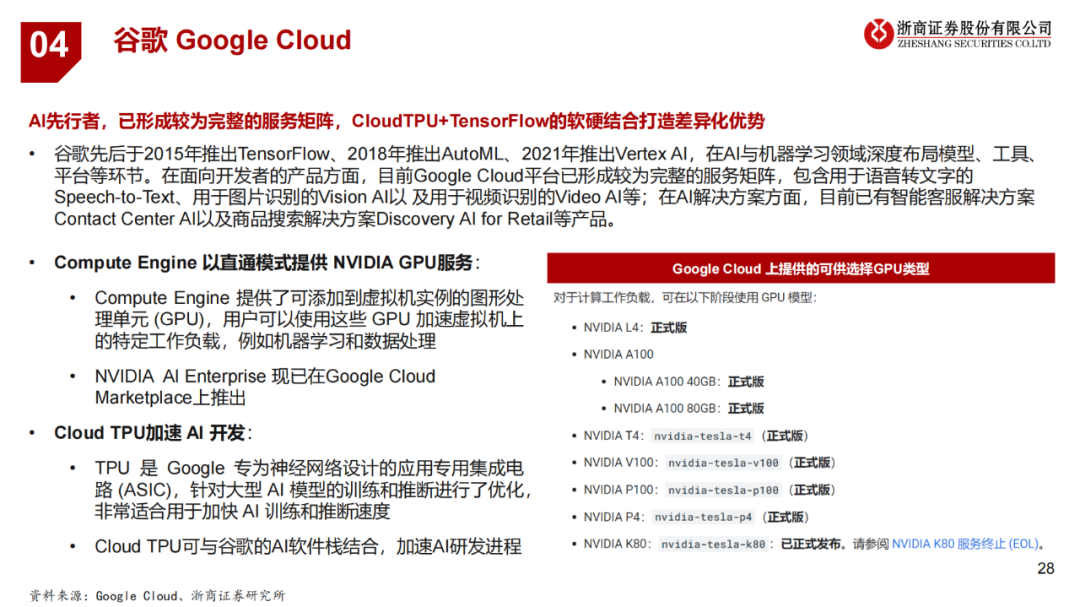

海外云厂商大量囤积英伟达A100/H100芯片;长期来看,头部厂商推进自研AI芯片。GPU云是算力租赁业务的长期进阶方向,具有更高的价值量和技术壁垒,市场想象空间更大。

400+份重磅ChatGPT专业报告(合集)

1、AI大模型落地的前景和痛点,兼谈工程师架构师所面临的机会和挑战 2、AIGC驱动下高校数字化转型 3、大模型趋势下的企业数据体系思考 4、大模型时代下数据中台该何去 5、大模型重塑软件开发以及实践案例展示 6、当GPT遇到低代码低代码平台AIGC开发落地实战

7、迈向通用人工智能时代之路——边缘与管力网络演进及思考

1、未来网络白皮书(2023):算网操作系统白皮书

2、未来网络白皮书(2023):以网络IO为中心的无服务器数据中心白皮书

3、未来网络白皮书(2023):光电融合服务定制广域网白皮书

人工智能专题报告:智算中心—赋能AI产业化、产业AI化(2023)

多样性算力:新一代计算架构超异构计算

聚力“高广深”打造先进算力网络

生成式AI:产业变革与机会(2023论坛合集)

《“东数西算”技术分析合集》

《2023年液冷技术白皮书汇总》

1、浸没式液冷数据中心热回收白皮书(2023) 2、数据中心绿色设计白皮书(2023)

世界AI大会系列:数据为核,迈向多模态AI大模型时代

2、CXL-Forum CXL-Consortium技术方案.pdf

3、CXL-Forum Elastics cloud技术方案.pdf

4、CXL-Forum Intel技术方案.pdf

5、CXL-Forum Marvell技术方案.pdf

6、CXL-Forum MemVerge技术方案.pdf

7、CXL-Forum Micron技术方案.pdf

1、芯来科技:基于RISC-V的MCU软硬件解决方案

2、芯来科技:高可靠高安全性RISC-V处理器设计与实现

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。