细腻度图像分类WS-DAN

WS-DAN(Weakly Supervised Data Augmentation Network)是一种用在细粒度分类任务中的模型, 在多个公开数据集上都达到了非常不错的效果; 该模型的创新点包括:

双线性注意力池化机制(Bilinear Attention Pooling, 下文简称BAP)

类center loss的注意力监督机制

基于注意力的数据增强策略

本文按照以下内容来介绍WS-DAN.

BAP

Attention Regularization

Attention-guided Data Augmentation

Object Localization and Refinement

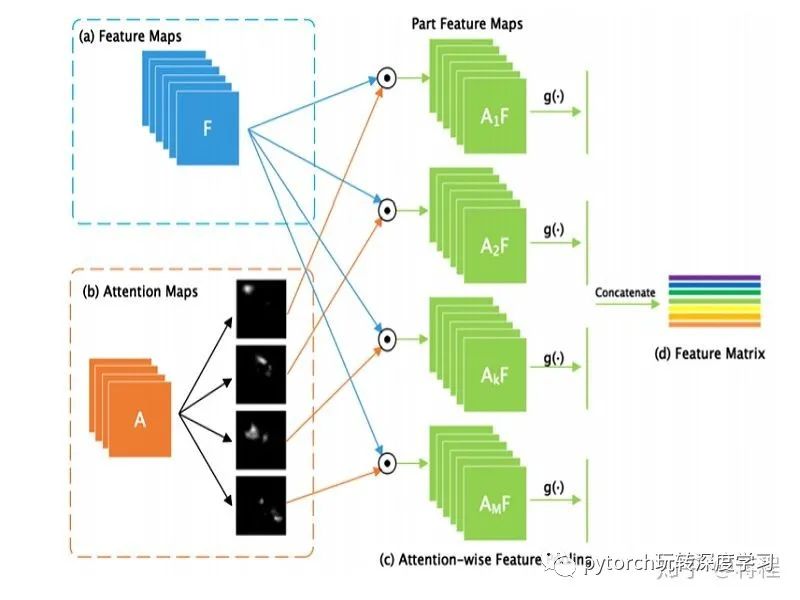

BAP(Bilinear Attention Pooling)

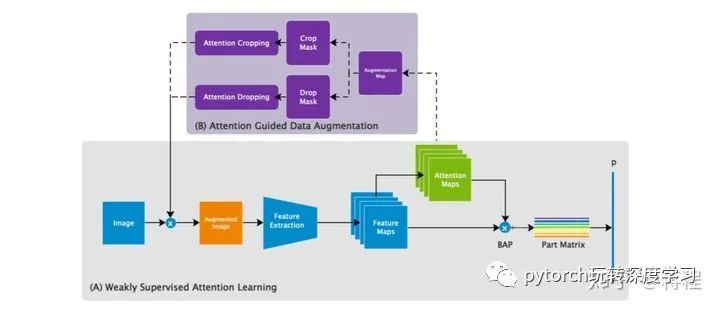

BAP是WS-DAN中最基础的模块, 是后续操作的原材料. BAP结构如图1所示

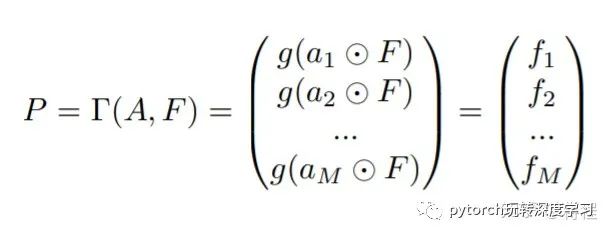

backbone网络首先产生feature maps和attention maps; 每个attention map都指向物体的特定部位; feature maps和attention maps的element-wise乘积产生局部feature maps, 并通过卷积或者池化来提取局部特征; 所得局部特征可以组成特征矩阵. 具体而言设有  个feature maps和

个feature maps和  个attention maps, 由第

个attention maps, 由第  个attention map

个attention map  和feature map

和feature map  进行element-wise乘积生成第

进行element-wise乘积生成第  个part feature map

个part feature map  , 其中

, 其中  表示element-wise乘法. 以此类推, 一个feature map和

表示element-wise乘法. 以此类推, 一个feature map和  个attention maps进行element-wise乘法, 得到

个attention maps进行element-wise乘法, 得到  个part feature maps. 这

个part feature maps. 这 个part feature maps经全局池化(GMP 或GAP), 得到

个part feature maps经全局池化(GMP 或GAP), 得到  维向量,其中第

维向量,其中第  个元素为

个元素为 , 将这些

, 将这些  维向量拼接, 生成

维向量拼接, 生成 维向量. 这些向量组成物体的特征

维向量. 这些向量组成物体的特征

Attention Regularization

为使得相同物体上同一部位的特征尽可能相似, WS-DAN采用类center loss来监督注意力的学习过程. loss函数定义如下

可初始化为0, 然后按照以下滑动平均公式来更新其值.

可初始化为0, 然后按照以下滑动平均公式来更新其值.

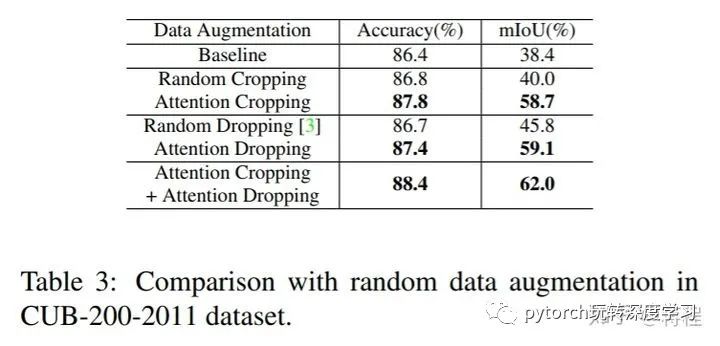

Attention-guided Data Augmentation

Attention-guided Data Augmentation

在随机数据增强方法中,背景噪声等干扰因素会影响最终效果. 本文所介绍的数据增强方法则通过BAP来生成attention maps, 这可以更好地过滤掉背景噪声. 对于训练数据,WS-DAN随机选出一张attention map  来指导数据增强过程.

来指导数据增强过程.  做归一化处理.

做归一化处理.

通过

通过 可获得crop mask. 当

可获得crop mask. 当  大于阈值

大于阈值  时,

时,  ; 反之

; 反之  ; 找出一最小的bounding box来覆盖

; 找出一最小的bounding box来覆盖  中所有的

中所有的  , 通过bounding box来crop训练数据,并放大至原图大小, 细节信息会更清晰. 该过程称为attention crop. 如果当

, 通过bounding box来crop训练数据,并放大至原图大小, 细节信息会更清晰. 该过程称为attention crop. 如果当  小于阈值

小于阈值  时,

时, , 否则

, 否则  , 该过程称为attention drop. Attention drop操作可缓解多个attention map关注物体同一部位的问题.

, 该过程称为attention drop. Attention drop操作可缓解多个attention map关注物体同一部位的问题.

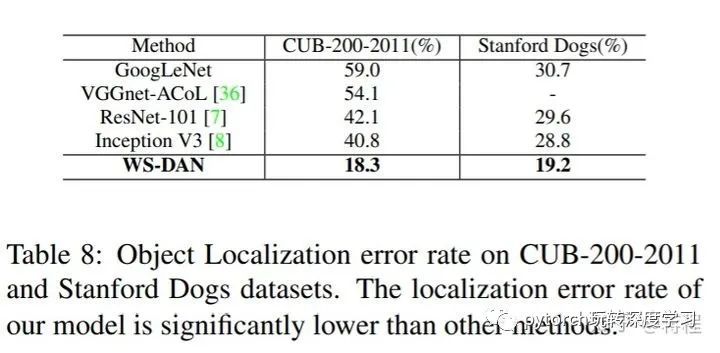

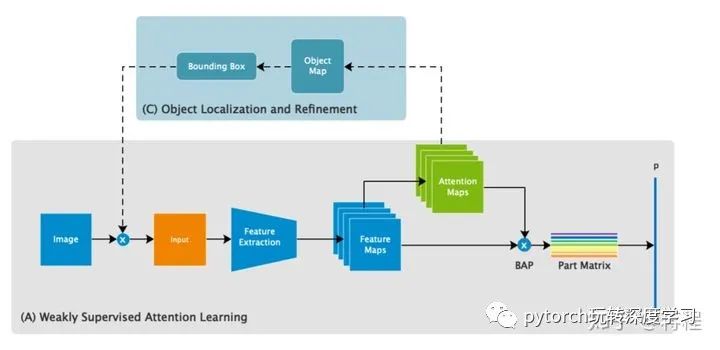

Object Localization and Refinement

前面介绍的Attention-guided Data Augmentation可以更准确地预测物体位置. 在测试阶段,backbone模型输出粗粒度识别结果以及attention maps. 在此基础上, WS-DAN可以预测整个物体的位置并且可预测细粒度识别结果. 在测试阶段使用的attention map是  个attention map的平均值

个attention map的平均值 最终的预测结果是由粗粒度识别结果和细粒度识别结果取平均所得.

最终的预测结果是由粗粒度识别结果和细粒度识别结果取平均所得.

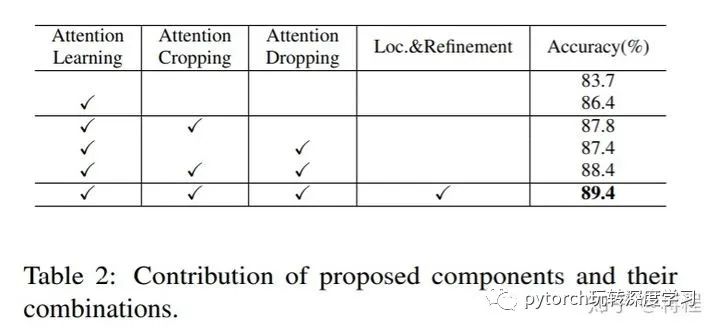

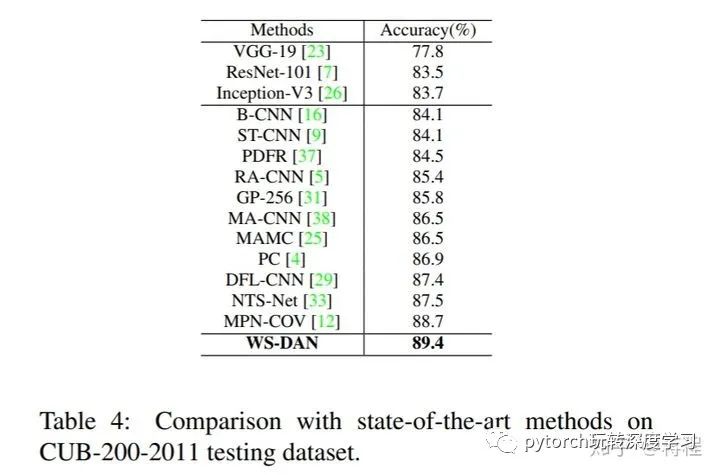

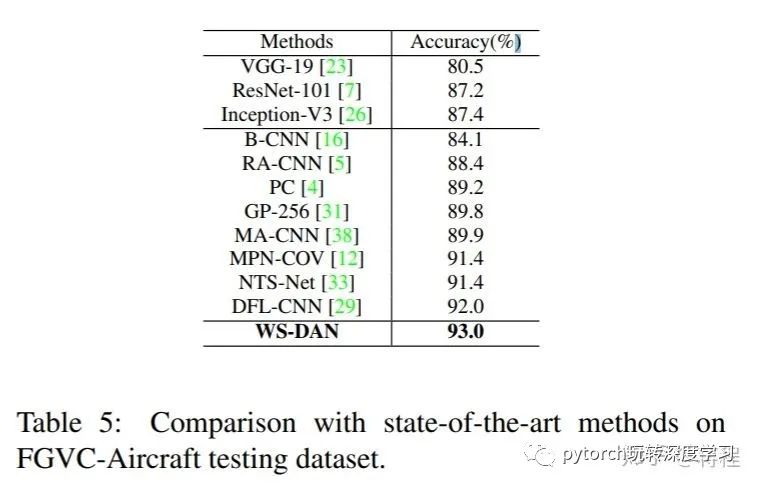

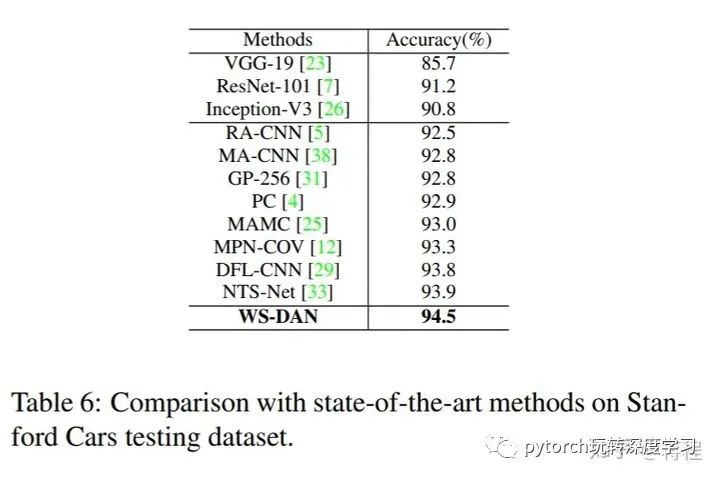

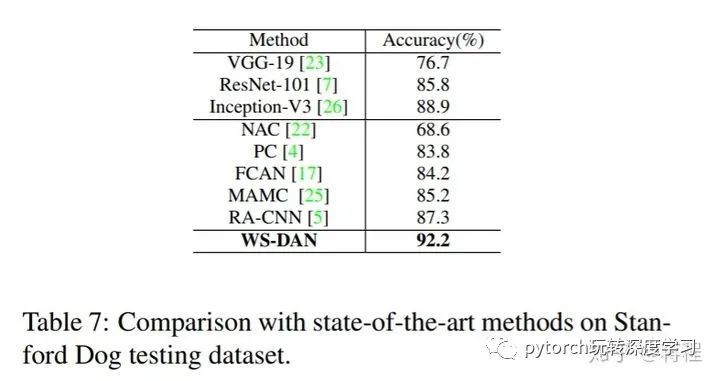

实验结果