“看墙之外” ——遮挡下的人体姿态估计

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

在过去的许多科幻电影中,能够看到墙外的东西被认为是超能力。2011年,麻省理工学院的研究人员宣布,他们开发了一种新的雷达技术,该技术可提供实心墙背后所发生情况的实时视频。

七年后,来自MIT的研究人员提出了一种“看墙之外”的新方法。就像人类和动物一样,它们通过可见光波反射,然后从物体上反射回来,然后撞击我们的视网膜,我们可以通过发送特定目标并从返回接收器的波来透过墙壁“看到”。在这种新方法中,研究人员利用WIFI频率穿越墙壁并反射到人体的能量,以及利用WiFi信号和深度学习技术,它们可以展示非常准确的墙壁和遮挡物之后人体的估计姿态。

他们提出的方法称为RF-Pose,是使用低功率无线信号(实际上比WiFi低1000倍)。它是使用无线电反射和深层神经网络,即使在遮挡物和墙后也能提供准确的姿态估计。根据定义,墙是由混凝土制成的固体物体,它们可以阻挡信号或至少削弱它们。但是,有些信号(或至少是信号频率)可以穿过墙壁,WIFI信号就是其中之一。为了能够解决检测(混凝土)墙后面的问题,必须记录穿过墙并从物体反射的信号。在RF-Pose中,研究人员使用一种众所周知的技术为FMCW(调频连续波)以及天线阵列。从本质上讲,FMCW分离RF(注:RF是此方法中使用的射频信号,根据反射物体的距离,它比WIFI低1000)。另一方面,天线阵列根据空间方向将反射分离。

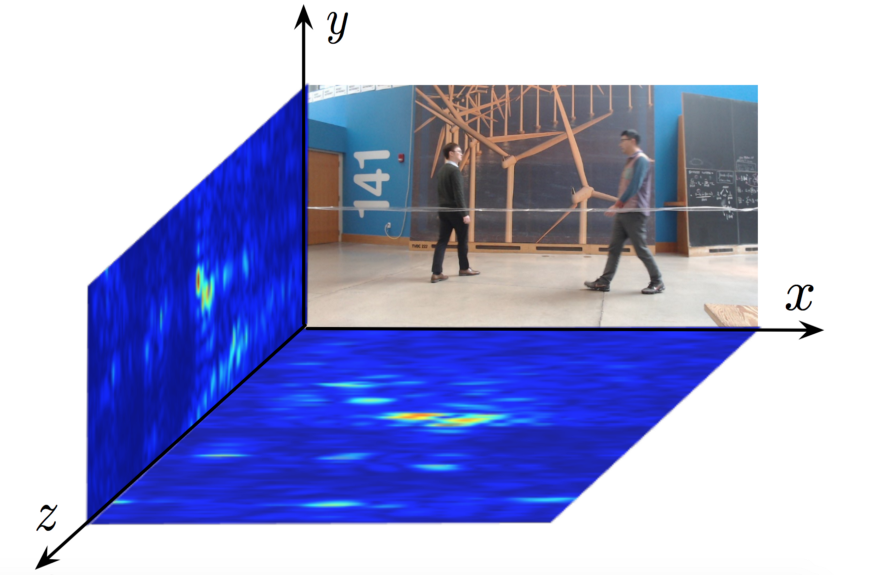

通过这种方式,RF-Pose方法的输入数据是信号反射的两个投影,分别表示为热图,由两个天线创建:垂直和水平。

热图的水平和垂直投影

热图的水平和垂直投影

为了能够利用深度学习技术,考虑到数据的所有限制和性质,定义适当的输入输出方案以及适当的架构设计至关重要。卷积神经网络已被证明非常成功,已在许多像素不是自然表示的情况下使用。在这种情况下,问题是相似的RF(射频)信号的属性与视觉数据有很大不同。

为了克服这个问题,他们解释并考虑了RF信号的局限性。主要是,他们认为RF信号,尤其是穿过墙壁的频率具有较低的空间分辨率(以几十厘米为单位),而视觉数据的分辨率却只有几毫米。

其次,他们认为波长必须与人体相对应地调整,以便人类充当反射器而不是散射器。最后,由于RF信号以复数形式给出,因此数据表示与图像(即视觉数据)有很大不同。

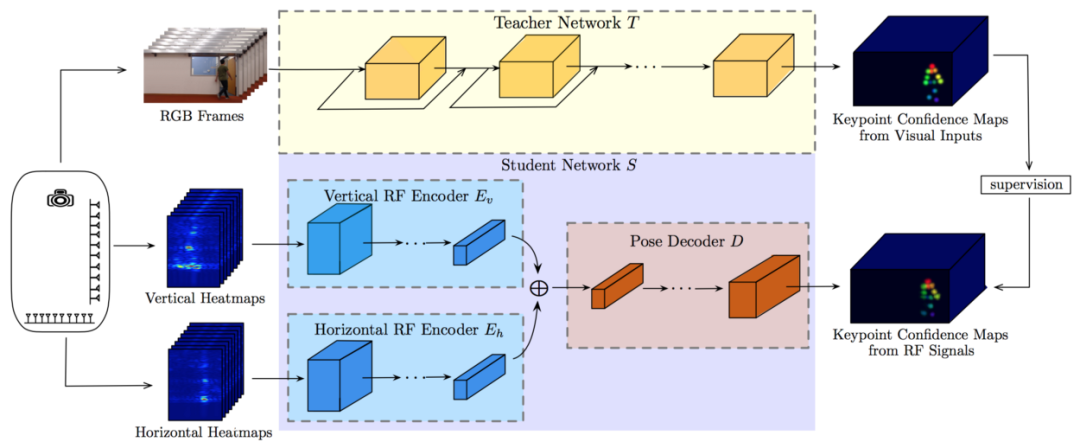

确定了特定问题的要求后,研究人员提出了一种基于交叉模式监督的方法,以解决遮挡下人体姿态估计的问题。他们建议使用同步RGB图像对和RF信号反射的热图投影的师生架构

拟议的师生网络结构

教师网络使用RGB图像进行训练,并且学会预测14个关键点,这些关键点对应于人体的解剖部位:头部,颈部,肩膀,肘部,腕部,臀部,膝盖和脚踝。这些具有教师网络关键点的预测置信度图用于学生网络的显式跨模式监督。

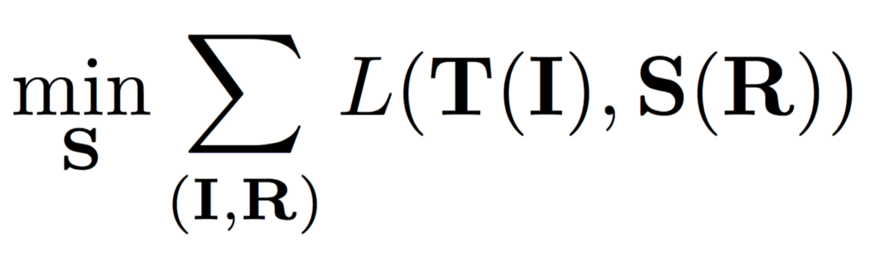

因此,训练目标是使学生网络的预测与教师网络的预测之间的误差最小。为了实现此目标,他们在与二进制交叉熵相对应的置信度映射之间定义了逐像素损失函数。

由于这种方法使用了无线电,因此每秒可以生成30对热图,因此作者可以自由地通过汇总来自多个RF热图快照的信息来训练网络。

为了克服摄像机和RF热图的视图不同的问题,他们在学生网络中采用了编码器-解码器体系结构,迫使网络学习从RF热图的视图到摄像机视图的转换。因此,他们为水平和垂直热图使用两个编码器网络(由于使用多个快照而采用复数),对信息进行编码;而一个解码器网络则通过从两个编码器网络获取通道级联编码来预测关键点置信度图作为输入。

时空卷积编码器网络使用100帧作为输入(3.3秒),每个帧具有10层9x5x5卷积。解码网络由具有3x6x6卷积的4层组成,并且两个网络都使用ReLU单元和批量归一化。实施是在PyTorch中完成的,培训使用的是24批。

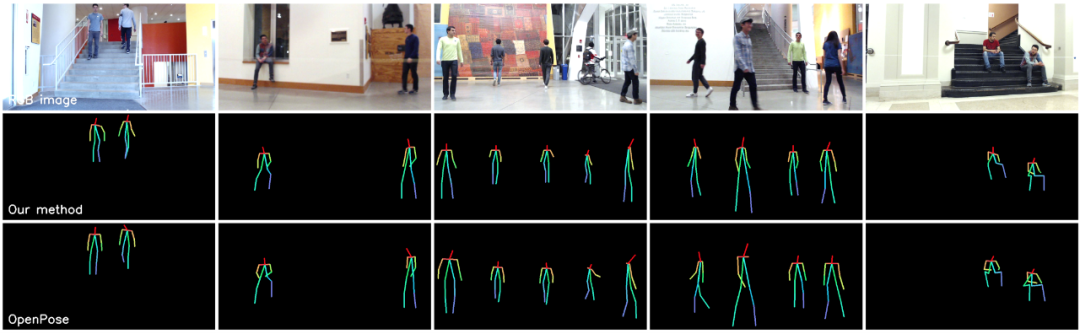

提议的方法与已经存在的称为OpenPose的方法的比较

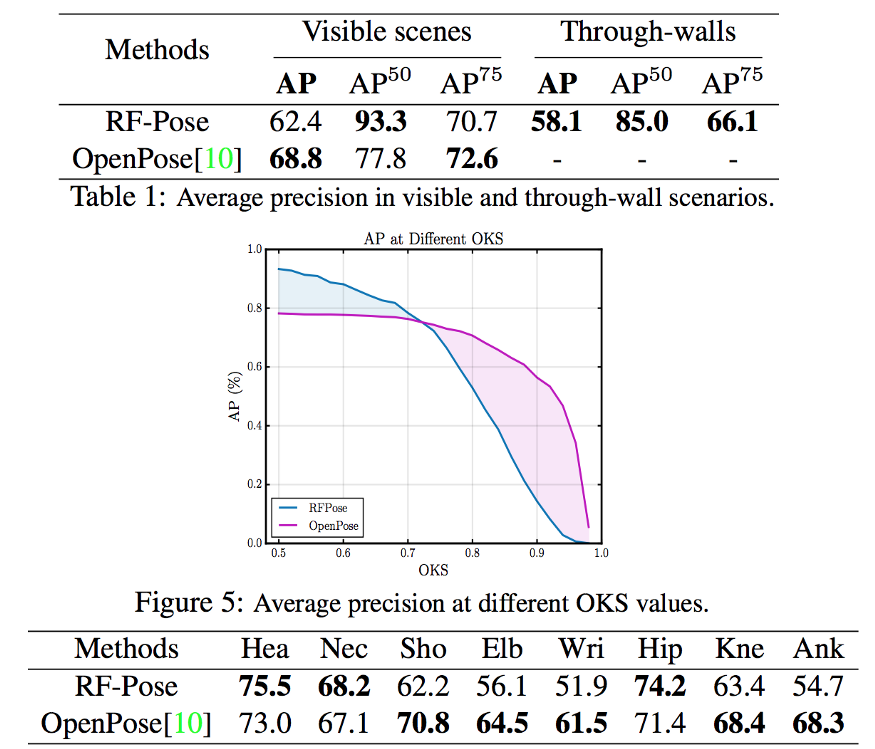

考虑到用于培训的示例数量很少,这种方法显示出非常好的结果。在AP评估指标(在10个不同的OKS阈值范围从0.5到0.95范围内的平均平均精度)上进行报告的情况下,RF-Pose的性能优于OpenPose。这两个表格之间的比较如下图所示。

RF-Pose和OpenPose之间的比较

研究人员认为遮挡是人体姿态估计中最重要的问题之一,研究人员提出了一种使用深度神经网络和RF信号来克服它并提供鲁棒且准确的人体姿态估计的新方法。我们期望看到这种方法的许多应用,因为(人体)姿态估计问题代表着一项重要任务,尤其是在监视,活动识别,游戏等领域。

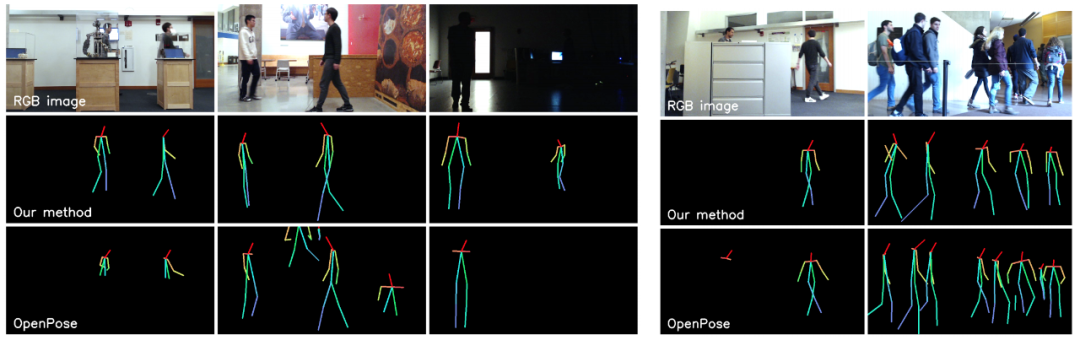

给定相机的RGB图像时RF-Pose和OpenPose的比较

- END -

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~