基于多视角融合的夜间无人车三维目标检测

点击下方卡片,关注“新机器视觉”公众号

重磅干货,第一时间送达

来源:《应用光学》,作者王宇岚等

摘 要:为了提高无人车在夜间情况下对周围环境的物体识别能力,提出一种基于多视角通道融合网络的无人车夜间三维目标检测方法。引入多传感器融合的思想,在红外图像的基础上加入激光雷达点云进行目标检测。通过对激光雷达点云进行编码变换成鸟瞰图形式和前视图形式,与红外图像组成多视角通道,各通道信息之间融合互补,从而提高夜间无人车对周围物体的识别能力。该网络将红外图像与激光雷达点云作为网络的输入,网络通过特征提取层、候选区域层和通道融合层准确地回归检测出目标的位置以及所属的类别。实验结果表明,该方法能够提高无人车在夜间的物体识别能力,在实验室的测试数据中准确率达到90%,速度0.43 s/帧,达到了实际应用要求。

关键词:红外图像;激光雷达点云;多视角通道;三维目标检测

引言

夜间无人车在道路上行驶需要感知周围环境的车辆、行人[1-2]等,基于红外摄像头的感知方案[3-5]虽然能够感知车辆前方的障碍物,但是无法准确获取障碍物的位置信息且准确率有限。激光雷达是一种主动传感器,通过发射与接收激光光束获取环境中物体的信息[6-7]。近几年陆续有研究人员利用深度学习在激光雷达点云上进行目标检测,斯坦福大学的Point Net[8]直接将激光点云作为输入,并解决了旋转问题和无序性问题。2017年苹果公司Voxel Net[9]将激光雷达分成等间距的体素,并引入新的体素特征编码表示,在KITTI[10]上取得很好的成绩。清华大学提出了MV3D[11],将彩色图像与激光雷达点云融合进行三维目标检测,该算法在KITTI 上也表现出色。

上述前人的研究工作基本都是在白天条件下的彩色图像上进行,而在夜间,无人车往往需要依赖红外图像,但红外图像的成像原理是通过红外摄像头探测物体自身的红外辐射,再通过光电变换将物体的温度分布变换成图像。红外图像具有无色彩、简纹理、低信噪比等特点。因此在红外图像上进行目标检测效果较差。考虑到各个传感器在不同方面均有利弊,本文利用多传感器融合的思想,提出了利用多视角通道融合网络的基于红外图像与激光雷达点云的夜间无人车三维目标检测方法。实验结果证明,该方法的准确率高且能基本满足实时性的要求。

1 多视角通道融合网络

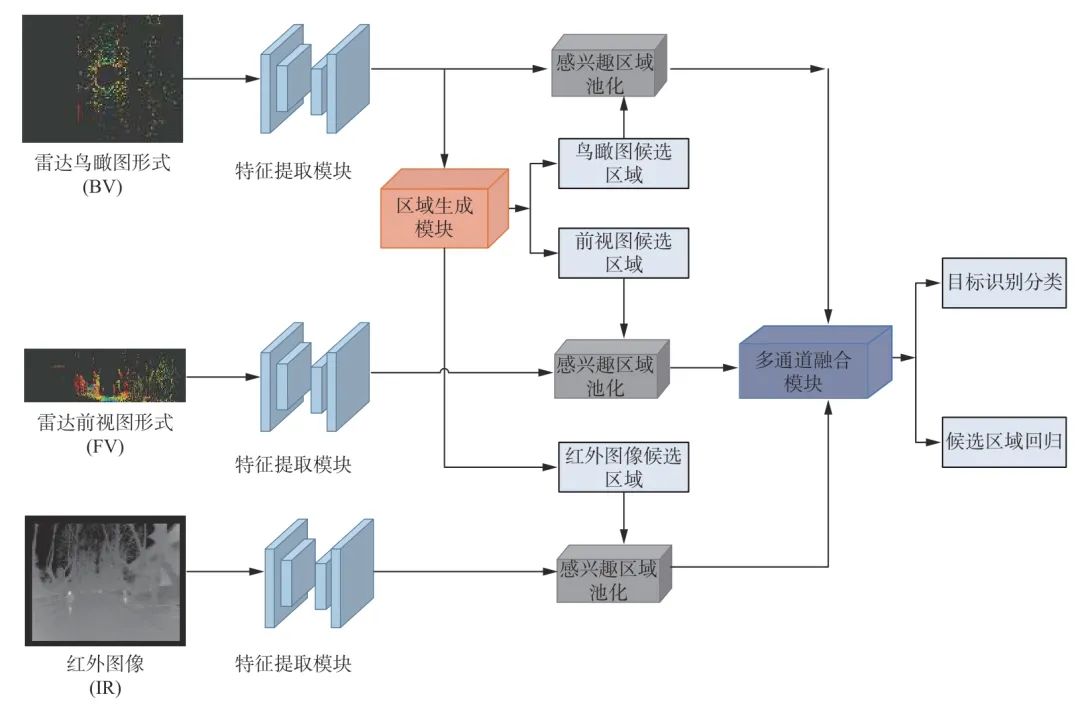

本文所采用的多视角通道融合网络由特征提取模块、候选区域生成模块和通道融合模块组成,整体结构图如图1所示。

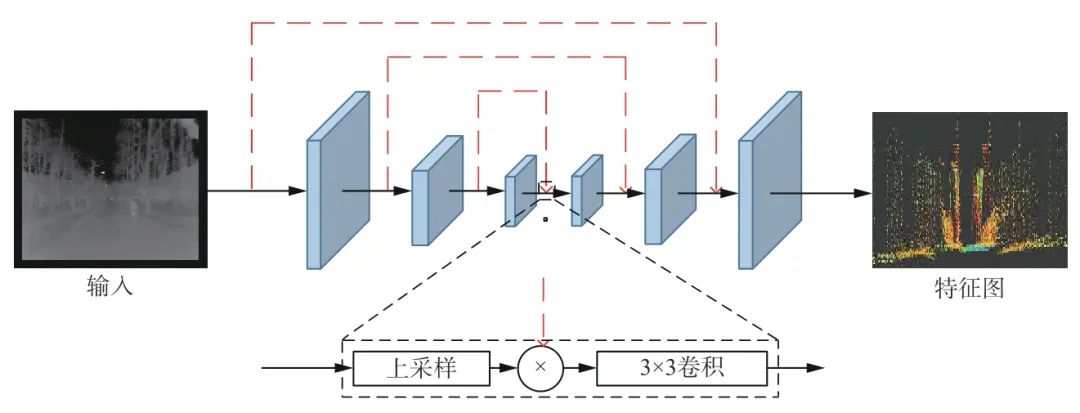

特征提取模块由特征编码网络和特征解码网络2 部分组成,结构如图2所示。

图1 多视角通道融合网络结构图

Fig.1 Structure diagram of multi-view channel fusion network

图2 特征提取模块结构图

Fig.2 Structure diagram of feature extraction module

特征编码网络采用的是改进后的VGG(visual geometry group)16 网络[12],将原VGG16 网络的通道数减少一半至50%,然后在网络中加入批标准化层,并在Conv4 删除最大池化层。特征编码网络将M×N×C的红外图像、鸟瞰图或前视图作为输入,并输出 ![]() 的特征图。式中,M表示图像的长,N表示图像的宽,C表示通道数。对于红外图像,C为1。特征解码网络采用特征金字塔网络[13]的形式,学习将特征映射上采样回原始的输入大小。特征解码网络将特征编码网络的输出作为输入,输出新的 M×N×D的特征图,如图2所示,通过转换-转置操作对输入进行上采样处理,并和来自特征编码网络的对应特征映射进行级联操作,最后通过3×3 卷积来融合二者。

的特征图。式中,M表示图像的长,N表示图像的宽,C表示通道数。对于红外图像,C为1。特征解码网络采用特征金字塔网络[13]的形式,学习将特征映射上采样回原始的输入大小。特征解码网络将特征编码网络的输出作为输入,输出新的 M×N×D的特征图,如图2所示,通过转换-转置操作对输入进行上采样处理,并和来自特征编码网络的对应特征映射进行级联操作,最后通过3×3 卷积来融合二者。

输入一幅鸟瞰图,候选区域生成模块会生成一系列的三维候选区域。每个三维候选区域有六维的参数:(x,y,z,l,w,h),分别表示三维候选区域在激光雷达坐标系中的中心坐标和长宽高尺寸。对于每个三维候选区域,对应在鸟瞰图中的参数(xbv,ybv,lbv,wbv)利 用离散的 (x,y,l,w)变换可以得到,表示三维候选区域在鸟瞰图中的坐标和长宽,其中 离散分辨率为0.1 m。

通道融合模块结合各个视角的特征,对各视角上的目标进行联合分类,并针对三维候选区域进行定向回归。由于不同的视角有不同的分辨率,对于每个视角通道所输出的不同分辨率的特征向量,通过ROI(region of interest)池化操作将每个视角通道所输出的特征向量调整到相同的长度。通过下式得到3 个视角不同的ROI。

![]()

式中:T3D→v表示从激光雷达点云坐标系到鸟瞰图形式、前视图形式,和红外图像的转换函数;P3D表示三维候选区域参数向量。对于区域候选网络所生成的三维候选区域,将其投影到经过ROI池化操作的鸟瞰图形式(BV)特征向量、前视图(FV)特征向量和红外图像(IR)特征向量中。对于从某个视角特征提取通道中输出的特征向量 x,通过ROI池化获得固定长度的特征 fv。

![]()

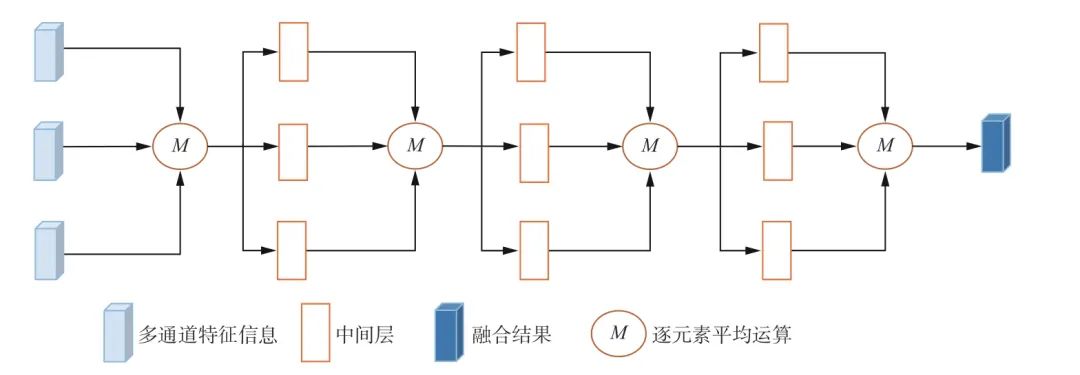

式中:R表示相应的矩阵变换。为了融合来自各个视角通道的特征信息,采用多层次融合的方法,分层融合多视角特征,使得各通道的信息可以在中间层有更多的交互。如图3所示。

图3 通道融合网络结构图

Fig.3 Structure diagram of channel fusion network

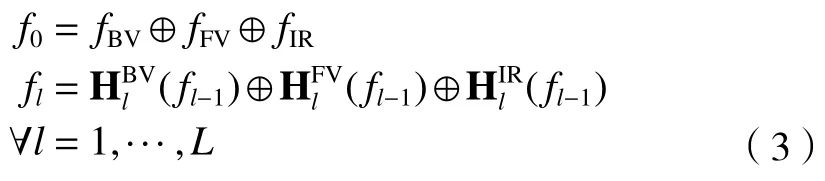

对于通道融合网络的每一层,输入为鸟瞰图形式、前视图形式以及红外图像3 个通道的特征,经过一次逐元素平均计算后,再经过各自的中间卷积层进一步提取特征。具体的融合过程如下式所示。

式中:fl表示第 l层的融合结果;fBV、fFV和 fIR分别表示鸟瞰图通道、前视图通道以及红外图像通道的输入特征;![]() 表示第l层不同通道的中间卷积层;⊕表示逐元素平均运算;经过通道融合网络融合各个视角通道的特征之后,利用融合结果对候选区域模块生成的三维候选区域进行回归校正,并将融合结果输入Softmax 分类器对三维候选区域内的物体进行分类识别。

表示第l层不同通道的中间卷积层;⊕表示逐元素平均运算;经过通道融合网络融合各个视角通道的特征之后,利用融合结果对候选区域模块生成的三维候选区域进行回归校正,并将融合结果输入Softmax 分类器对三维候选区域内的物体进行分类识别。

2 实验内容

2.1 实验配置与数据预处理

本文算法中的网络基于Tensor Flow[14]框架,实验硬件配置为处理器Intel i5-6600,内存16 GB,显卡NVIDIA GTX 1070;操作系统Ubuntu14.04。实验的所有数据由载有红外摄像头和激光雷达的车辆在南京理工大学夜晚的校园道路上拍摄所得,有车辆、行人和骑自行车的人3 种类别。其中训练集为1 500 张红外图像及其对应的由激光雷达点云数据,验证集为500 张红外图像及其对应的由激光雷达点云数据,测试集为600 张红外图像及其对应的由激光雷达数据。

对于激光雷达点云数据,其中每一个点由其三维坐标 (x,y,z)和 反射率 r组成,本文将其转化为鸟瞰图与前视图的形式。鸟瞰图形式指的是沿水平坐标系(地面)将激光雷达点云分割成700×800 的网格,再沿Z轴方向把激光雷达点云平均分成5 层。对于每一个区域,提取其中最大高度的点的高度作为高度特征;该长方体区域内点的数目作为密度特征;对于密度特征ρ,作归一化处理。

![]()

式中N是长方体区域内点的数目。最后将激光雷达点云转换成通道数为700×800×6 的鸟瞰图形式。前视图形式指的是将激光雷达点云投射到一个前方的圆柱体平面上。给定激光雷达点云中的一个点的三维坐标 p=(x,y,z),其在前视图中的坐标 pfv=(r,c)可以通过下式计算得出。

式中:Δθ是 激光的水平分辨率;Δϕ是垂直分辨率。

2.2 实验结果及分析

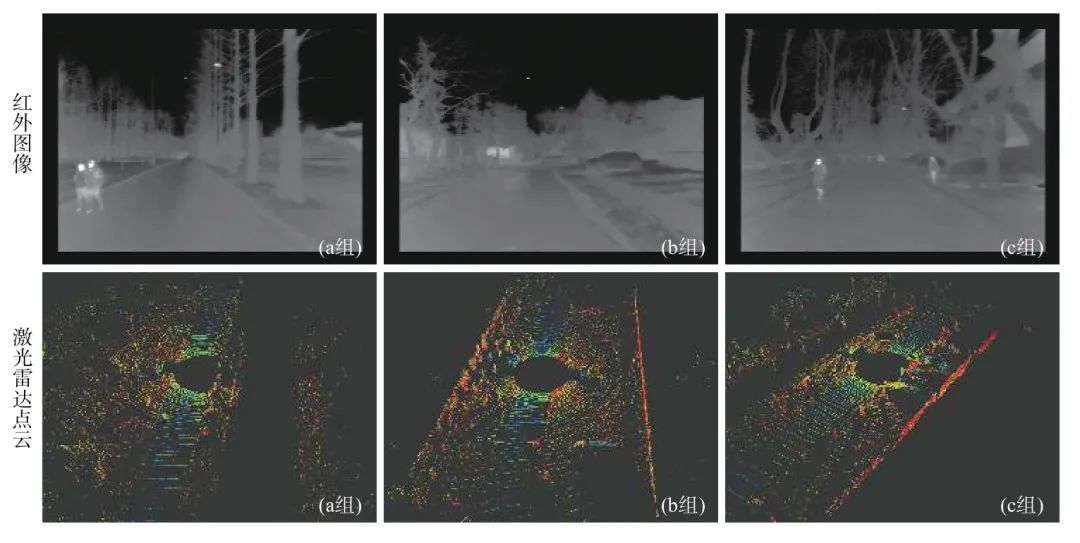

把红外图像与激光点云数据输入到多视角通道融合网络中,网络给出检测结果。由于红外摄像头与激光雷达的采集频率不一致,本文根据激光雷达帧号匹配红外图像,设定阈值为10 帧,寻找与雷达帧号小于阈值且最接近的图像作为对应图像,如图4所示。

图4 输入的红外图像与对应的激光雷达点云

Fig.4 Input infrared image and lidar point cloud

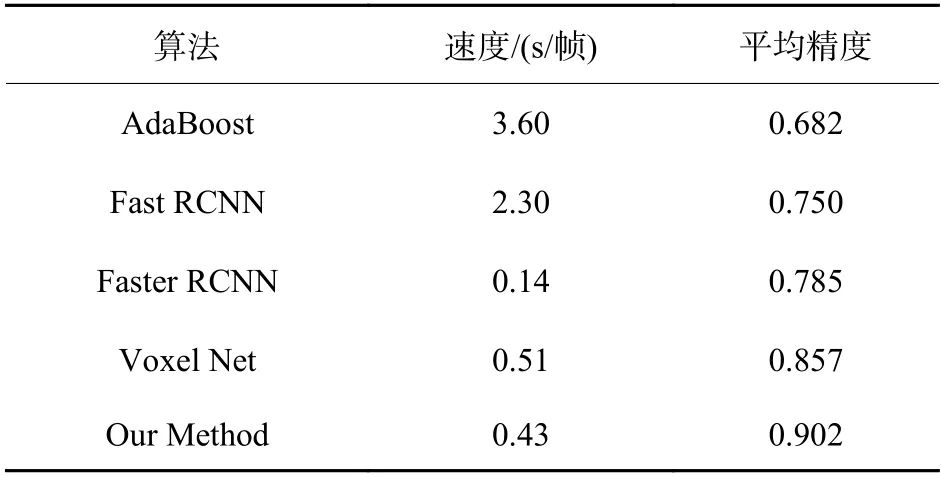

使用传统的AdaBoost[15]算法、和二维的目标检测算法Fast RCNN[16]算法、Faster RCNN[17]算法以及三维的目标检测算法Voxel Net[10]在测试集中进行测试,并与本文算法进行结果对比,结果见表1。

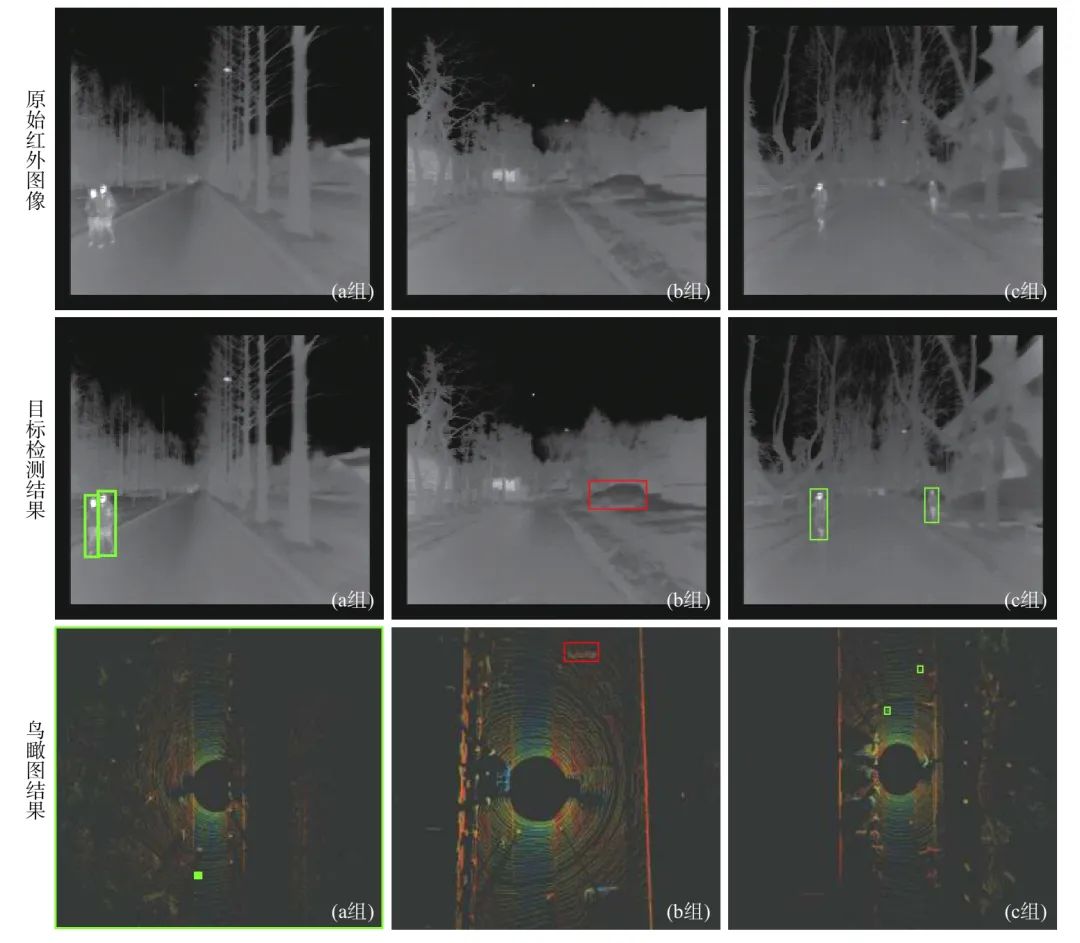

从表1的结果中可得,本文算法在牺牲部分时间的情况下提高了夜间目标检测的正确率。为了更直观地显示本文算法结果,将目标检测的结果显示在激光雷达点云的鸟瞰图形式上和红外图像上,其中绿色矩形框表示行人,红色矩形框表示车辆。如图5所示。

表1 不同算法在测试集上的结果对比

Table1 Comparison of results for different algorithms on test sets

图5 目标检测可视化结果

Fig.5 Visualized result of detection

由图5可以看出,对于图5(a 组),本文算法可以很好地定位行人的位置;对于图5(b 组),虽然红外图像分辨率较低,连人眼也不容易分辨图片中的车辆,但加入激光雷达点云信息后对于该车的定位准确;对于图5(c 组),本文算法定位结果与人工标注信息一致。

3 结论

本文采用多传感器融合的思想,在原有红外图像的基础上加入激光雷达点云,并使用多视角通道融合网络对这2 种数据进行特征融合,准确地检测出目标的位置以及类别。实验结果表明,该方法能够提高无人车在夜间的物体识别能力,在实验室的测试数据中准确率达到90%,每帧耗时0.43 s,达到实际应用要求。

本文仅做学术分享,如有侵权,请联系删文。