451页长文!Facebook科学家用马斯克坚信的「第一性原理」阐释DNN, LeCun站台

新智元报道

新智元报道

来源:FAIR

编辑:yaxin, LQ

【新智元导读】马斯克坚信,世界只是「矩阵模拟」!他用自己推崇的思维模式「第一性原理」来思考这个物理世界。近日,Facebook科学家Sho Yaida撰写的一书从「第一性原理」解释了深度神经网络。LeCun表示,这是首批致力于DL理论的书。

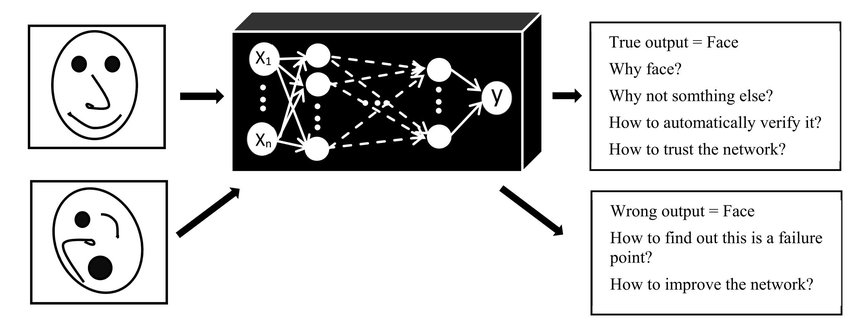

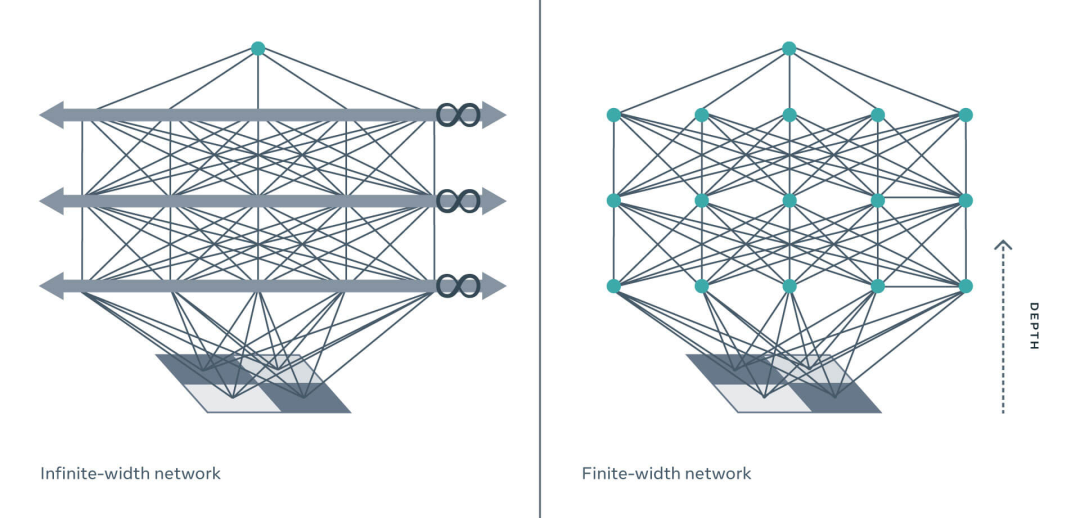

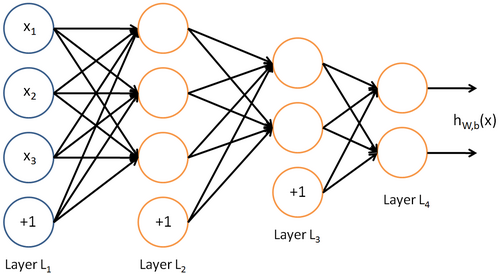

相互作用的神经元

相互作用的神经元

通过第一性原理理解DNN

通过第一性原理理解DNN

LeCun为同事站台

LeCun为同事站台

作者介绍

作者介绍

参考资料:

https://ai.facebook.com/blog/advancing-ai-theory-with-a-first-principles-understanding-of-deep-neural-networks/

评论