深度学习的第一性原理!

【专栏:研究思路】我们认为,人工智能进入了新的拐点。在一个后深度学习时代,不同的学者对未来智能发展道路的理解逐渐清晰,当然也逐渐开始分化,由此导致了开展布局完全不同的研究工作。智源社区将系统分析全球范围内知名学者对未来研究布局的「研究思路」,以帮助大家思考人工智能的未来。

01

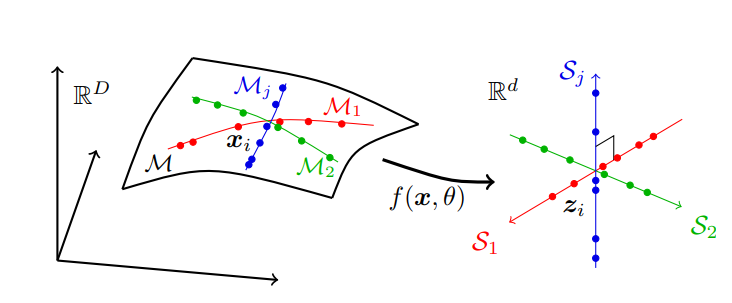

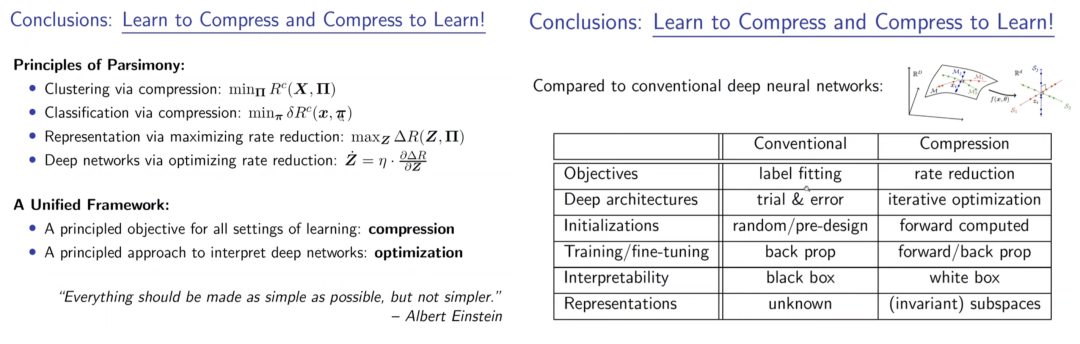

Interpolation,我们寻找样本之间的相似关系,这体现为聚类或分类任务; Extrapolation,当获得第一个阶段任务的信息后,我们就可以对新的样本进行归类,判断未知样本的结构。 Representation,我们能够了解数据的信息,并建模描述它。

02

03

04

05

06

评论