CVPR 2021 | 图像转换 今如何?几篇GAN论文

点击上方“机器学习与生成对抗网络”,关注星标

获取有趣、好玩的前沿干货!

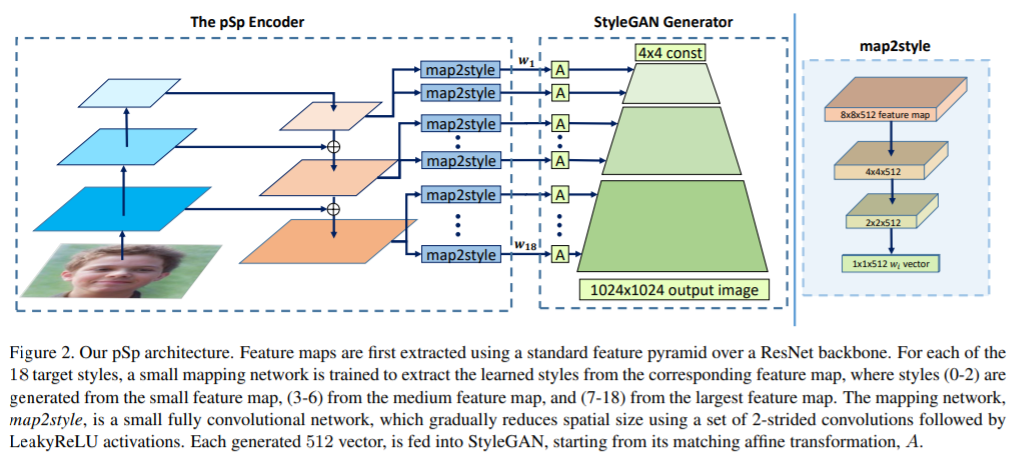

1,Encoding in Style: a StyleGAN Encoder for Image-to-Image Translation

提出一个通用的图像转换框架pixel2style2pixel(pSp)。pSp框架基于编码器网络,直接生成一系列风格向量,然后将它们输入到预训练的StyleGAN生成器中,从而扩展成“W+潜在空间”。

编码器可以直接将真实图像嵌入到W+,而无需其它优化。利用编码器直接解决图像转换任务,如此一来图像转换任务可定义为:从某些输入域到潜在域的编码问题。

此前的方法中,StyleGAN编码器一般是“先反转(图像到潜码),后编辑”。而pSp不要求输入图像在StyleGAN域中进行特征表示,也可以处理各种任务。由于不需要对抗,极大地简化了训练过程,在没有“图像对(源图像,目标图像)”的严格标签数据下提供更好的支持,并且通过风格的重采样可以支持多模式合成。

实验表明,pSp在各种图像转换任务中也表现出不俗的潜力。即使与专为某种任务而设计的最新解决方案相比,例如人脸转换任务,pSp也表现极佳。代码:https://github.com/eladrich/pixel2style2pixel

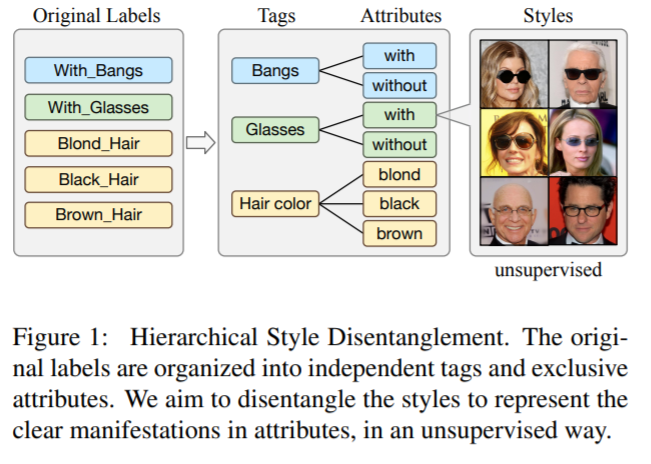

2,Image-to-image Translation via Hierarchical Style Disentanglement

近来,图像转换任务在多标签(不同标签为条件)和多风格的生成任务上都取得了不错进展。

但由于标签不具备独立性、排他性,图像转换结果b并不能完全精准可控。本文提出分层风格分离(HiSD)来解决此问题。具体来说,将标签组织成分层的树状结构,其中独立的标签,排他的属性和解耦的风格从上到下进行分配。相应地,设计一种新的转换过程以适应上述结构,确定可控转换的风格。在CelebA-HQ数据集上的定性和定量实验都证明HiSD的能力。代码:https://github.com/imlixinyang/HiSD

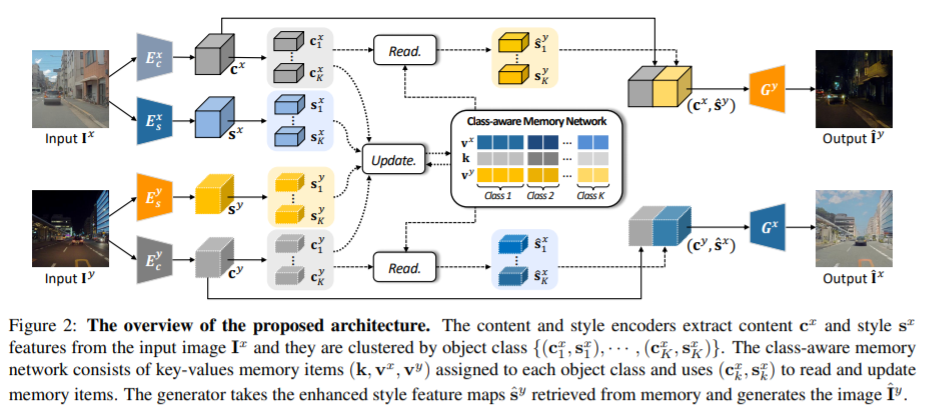

3,Memory-guided Unsupervised Image-to-image Translation

为实例级别的图像转换问题提供了一种新的无监督框架。尽管近期一些方法通过融进额外的物体标签可以取得进一步的效果,但通常无法处理多个不同对象的的情形。主要原因是,在推理过程中,这些算法将全局整体的风格应用于整幅图像,而没有考虑实例个体与背景之间或个体内部间的风格差异。

为此,提出一个类别感知的内存网络,可以显示地明确说明局部风格变化。引入一组具有读/更新操作的键值存储结构,以记录类别的风格变化,且在测试阶段无需目标检测器就可以访问它们。

“键”存储的是与域无关的内容表征,用于分配内存,而“值”则编码了域特定的风格表征。还提出一种特征对比损失,以增强内存的判别能力。实验表明,通过合并内存,可以跨域迁移类别感知的、准确的风格表征。

4,ReMix: Towards Image-to-Image Translation with Limited Data

当可用的训练数据是有限的时候,基于生成对抗网络(GAN)的图像到图像(I2I)转换方法通常有过拟合的现象发生。

这项工作提出一种数据增强方法(ReMix)来解决此问题:在特征级别上对训练样本进行插值,并根据样本之间的感知关系提出一种新的内容损失。生成器学习转换中间样本,而不是记住训练集,从而迫使判别器有更好的泛化能力。

只需稍作修改,即可轻松将ReMix方法合并到现有GAN模型中。在众多任务上的实验结果表明,配备ReMix方法的GAN模型效果更佳。

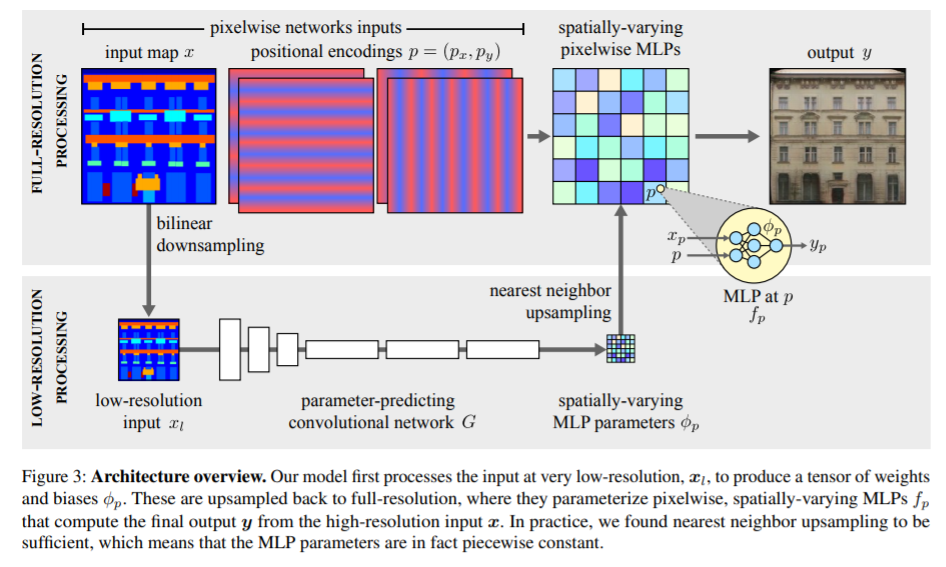

5,Spatially-Adaptive Pixelwise Networks for Fast Image Translation

介绍了一种新的生成器网络结构,通过将其设计为全分辨率图像的极轻量级网络,以实现快速高效的高分辨率图像转换。

通过简单的仿射变换和非线性组合的操作,将每个像素都独立于其它像素去进行处理。主要采取三个关键步骤,使这种方法看似简单但极具表现力。

首先,逐像素网络的参数在空间上是变化的,因此与简单的1×1卷积相比,它们可以表示更广泛的函数类。其次,这些参数是由快速卷积网络预测的,该网络处理输入的低分辨率表示。第三,通过拼接空间坐标的正弦编码来增强输入图像,为生成高质量的图像内容提供了有效的归纳偏置(inductive bias)。

实验表明模型比此前的方法快达18倍,同时在不同的图像分辨率和转换中也有着极具竞争力的视觉质量。

附下载 |《TensorFlow 2.0 深度学习算法实战》