用于RGB-D语义分割的全局-局部传播网络

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

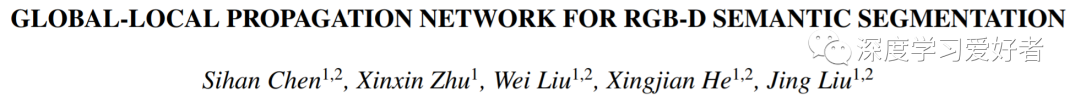

深度信息在RGB-D语义分割任务中很重要,它为彩色图像提供了额外的几何信息。现有的方法大多采用多级融合策略将深度特征传播到RGB分支。然而,在非常深的阶段,以简单的元素相加方式传播并不能充分利用深度信息。为了解决这一问题,作者提出了全局-局部传播网络(GLPNet)。引入局部上下文融合模块(L-CFM)在元素融合前对两种模式进行动态对齐,引入全局上下文融合模块(G-CFM)对多模态全局上下文特征进行联合建模,将深度信息传播到RGB分支。大量的实验证明了该融合模块的有效性和互补性。作者的GLPNet将两个融合模块嵌入到一个双流编码器-解码器结构中,从而在两个具有挑战性的室内场景分割数据集(即ny - depth v2和SUN-RGBD数据集)上实现了最先进的性能。

提出了利用深度特征和RGB特征互补模式的全局-局部传播网络(global - local Propagation Network, GLPNet),设计了一个局部上下文融合模块(local context fusion module, L-CFM)和一个全局上下文融合模块(global context fusion module, G-CFM),分别解决了特征融合中的空间失调和语义传播问题。L-CFM不是直接向RGB分支添加深度特征,而是在模式融合之前动态地对两种模式的特征进行对齐。其中,对齐过程是根据卷积层预测的偏移量,同时扭曲两种模式的特征映射。卷积层的设计灵感来自于视频处理领域的光流和语义流[4]。此外,提出了通过联合多模态上下文建模将深度特征传播到RGB分支的G-CFM算法。具体来说,作者从两种模式中提取全局上下文特征,并使用注意机制将其聚合到每个RGB像素。与L-CFM精确对齐两种模式的局部特征相比,G-CFM旨在从全局语境的角度利用深度信息。考虑到本文提出的两个融合模块从全局和局部的正交角度帮助深度特征传播,将它们并行结合进一步提高了深度阶段的传播效率。

本文提出的GLPNet在两个具有挑战性的RGB-D语义分割数据集上实现了最新的性能,即NYU-Depth v2 和 SUN-RGBD数据集。

作者的GLPNet概述。在最后阶段作者使用扩张策略,整体步幅为16。

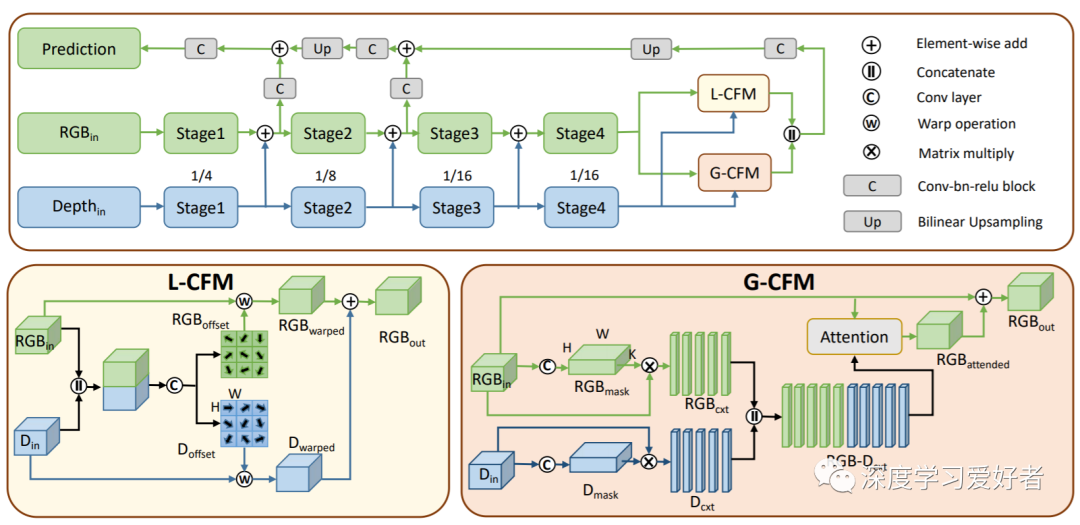

G-CFM对NYU-Depth v2测试集的两个示例gbd对预测的池掩码的可视化。为了节省空间,作者为每个模式提供了5个具有高度代表性的掩码(15个)。

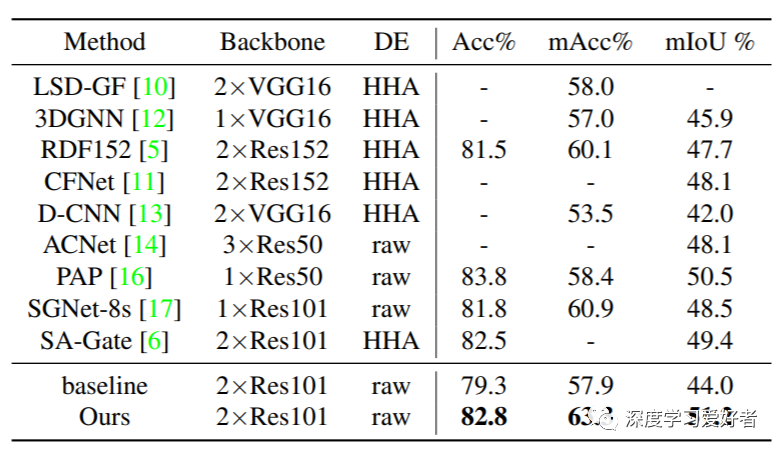

SUN-RGBD测试集对比结果

作者提出了用于RGB-D语义分割的GLPNet。GLPNet帮助信息在深度阶段从深度支路传播到RGB支路。局部上下文融合模块在融合前对两种模式进行动态对齐,全局上下文融合模块通过联合多模态上下文建模进行深度信息传播。大量的消融实验验证了本文方法的有效性,GLPNet在两个室内场景分割数据集上取得了最新的性能,即NYU-Depth v2和SUN-RGBD数据集。

论文链接:https://arxiv.org/pdf/2101.10801.pdf

每日坚持论文分享不易,如果喜欢我们的内容,希望可以推荐或者转发给周围的同学。

- END -

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~