用于语义分割的特征共享协作网络

点击上方“AI算法与图像处理”,选择加"星标"或“置顶”

重磅干货,第一时间送达

近年来,深度神经网络在图像识别领域取得了较高的精度。在借鉴人类学习方法的基础上,提出了一种基于协作学习的语义分割方法。我们使用两个相同的网络和路径在两个网络之间发送特征映射。同时训练两个网络。通过共享特征映射,两个网络中的一个可以获得单个网络无法获得的信息。此外,为了提高合作程度,我们提出了只连接同一层和多层的两种方法。我们在两种网络上评估了我们提出的想法。一个是双注意网络(DANet),另一个是DeepLabv3+。与传统的单一网络和集成网络相比,该方法具有更好的分割精度。

我们准备两个网络,并引入两个网络之间的连接,从顶部网络获得的特征映射可以发送到底部网络,并将两个特征映射连接起来。由于这两个网络都训练来解决分割问题,为任务寻址好的信息被发送到底层网络。因此,底层网络可以利用从顶层网络获得的好的特征映射来解决任务,而底层网络则专注于顶层网络无法解决的问题。由于底层网络将上层网络获得的特征图进行拼接,拼接后的特征图中滤波器的数量比原网络多出两倍。这就是我们在本文中提出的合作学习。

在我们的方法中,我们采用了以下损失,因为我们的方法同时分别训练两个cnn。我们使用Softmax交叉熵来计算损失(Loss = Loss1 + Loss2)其中Loss1为CNN1的Loss, Loss2为CNN2的Loss。两种损耗同时得到优化。在这种网络结构中,我们可以训练两个网络,同时共享单个网络无法获得的特征映射。合作学习有几个优点。首先,我们可以通过使用两个网络之间的特征映射来增加有用信息的数量。由于第一个网络解决了分割任务,因此已经获得了解决该任务的特征。因此,第二网络可以学习任务使用信息从第一个网络作为参考。基于以上原因,我们认为合作学习对于提高准确性是有效的。

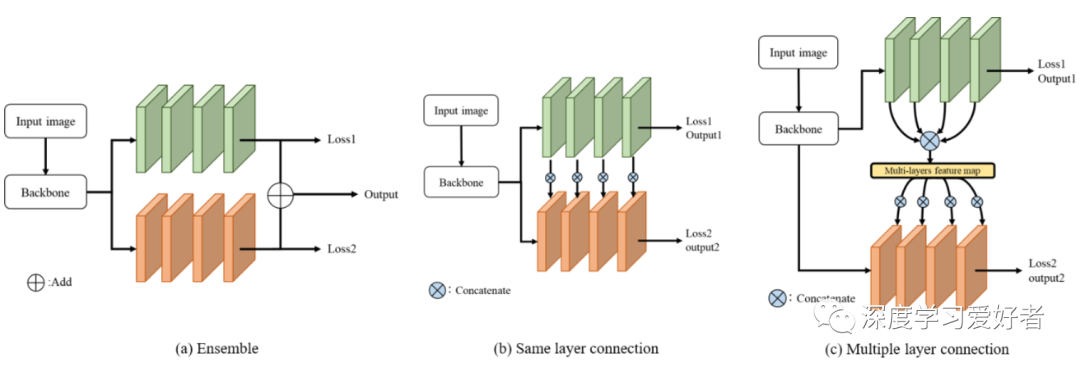

在本文中,我们提出了两种合作学习的连接方法。第一种连接方法是在相同的层之间。第二种连接方法是多层之间的连接。下面的小节将解释这两种方法。通过与集成网络的比较,验证了协同连接的有效性。集成网络使用两个相同的cnn。集成网络与我们方法的区别如图2 (a)所示。

图1合作网络的结构

图2集成网络(a)和提出的协作网络(b)(c)结构

城市景观数据集上的分割结果(val)。baseline是DANet。

城市景观数据集上的分割结果(val)。baseline为Deeplabv3+

通过以上实验,我们证实了无论使用哪种基线网络,合作学习都能提高准确率。对于DANet而言,采用同一层连接的合作学习比采用不同层连接的合作学习具有更高的准确率。另一方面,DeepLabv3+的多层连接精度更高。从这些结果来看,最优的连接方法依赖于基线CNN。DANet使用注意模块对feature map进行增强。因此,同一层连接可以使用对应层的重要特征。另一方面,不同的层连接不能在不同的层上很好地使用这些特性。

在DeepLabv3+的情况下,使用一种编码解码器结构来聚合多尺度信息。多层连接可以从多层中提供有效的信息。因此,DeepLabv3+结构的多层连接获得了较高的精度,因为来自不同层次的许多信息可以帮助DeepLabv3+结构获得有效的信息。我们认为采用一种简单的编译码结构网络是有效的不同层连接。如果我们在图4中使用注意模块。城市景观数据集上的分割结果(val)。基线是由Deeplabv3+增强特征映射,同层连接的合作学习是有效的。

在实验中,我们将图2(a)所示的网络集成与提出的协作网络进行了比较。所提出的两种连接方法比两种网络集成的方法更精确。通过两种实验验证了该协作网络的有效性。

论文链接:https://arxiv.org/pdf/2101.07905.pdf

每日坚持论文分享不易,如果喜欢我们的内容,希望可以推荐或者转发给周围的同学。

- END -