【论文解读】CVPR 2021 | 旷视提出GID:用于目标检测的通用实例蒸馏

本文提出一种用于目标检测的知识蒸馏新方法:General Instance Distillation,GID,可应用于各种检测框架中,使得学生模型显著提高AP的性能,甚至优于Teacher模型!

作者单位:旷视科技, 北航

论文:https://arxiv.org/pdf/2103.02340.pdf

近年来,知识蒸馏已被证明是模型压缩的有效解决方案。这种方法可以使轻量级的学生模型获得从繁琐的教师模型中提取的知识。但是,以前的蒸馏检测方法对于不同的检测框架具有较弱的泛化性,并且严重依赖ground truth(GT),而忽略了实例之间的宝贵关系信息。

因此,我们提出了一种新的基于鉴别性实例的检测任务的蒸馏方法,该方法不考虑GT区分出的积极或消极,这称为通用实例蒸馏(GID)。

我们的方法包含一个通用实例选择模块(GISM),以充分利用基于特征的,基于关系的和基于响应的知识进行蒸馏。

General Instance Distillation

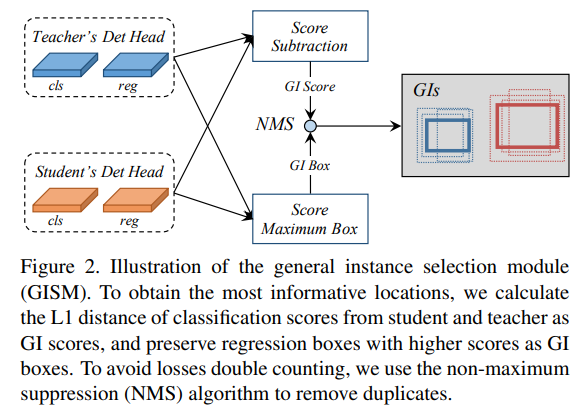

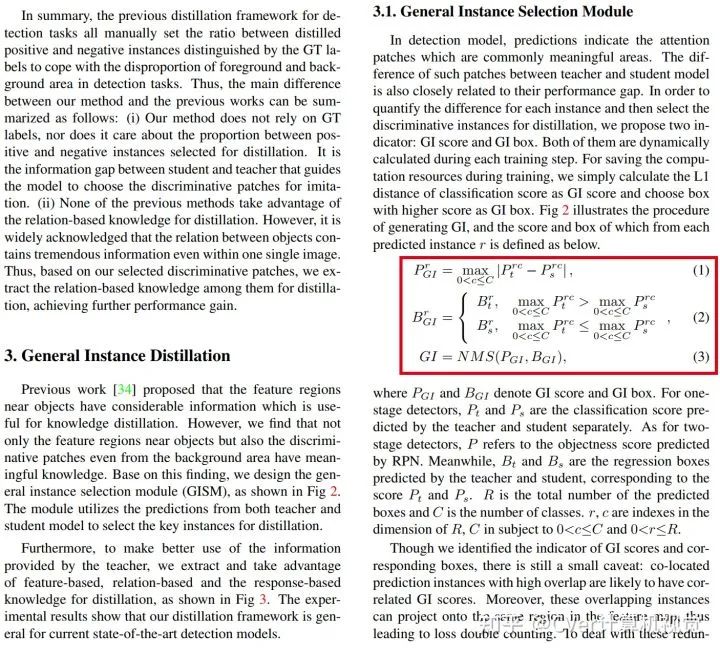

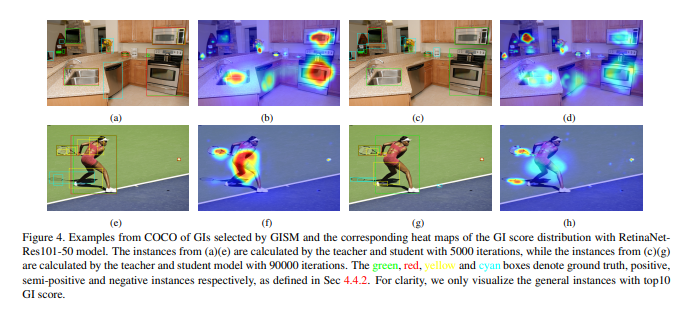

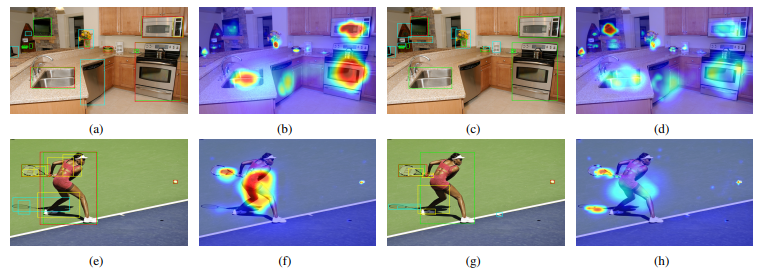

先前的工作[34]提出对象附近的特征区域具有相当多的信息,这对于知识的提炼是有用的。然而,我们发现,不仅对象附近的特征区域,而且甚至来自背景区域的区分斑块都具有有意义的知识。基于此发现,我们设计了通用实例选择模块(GISM),如图2所示。该模块利用教师模型和学生模型的预测来选择要蒸馏的关键实例。

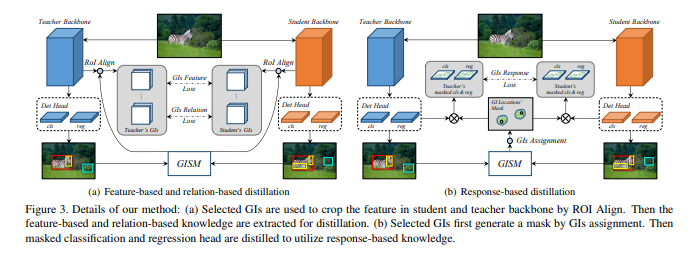

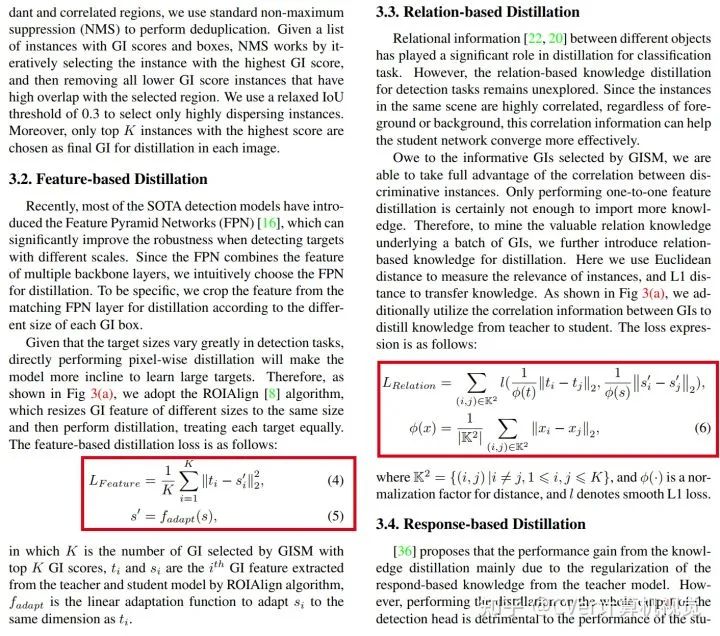

此外,为了更好地利用老师提供的信息,我们提取并利用了基于特征,基于关系和基于响应的知识进行蒸馏,如图3所示。实验结果表明,我们的蒸馏框架 对于当前最新的检测模型来说是通用的。

算法细节(建议去看原文):

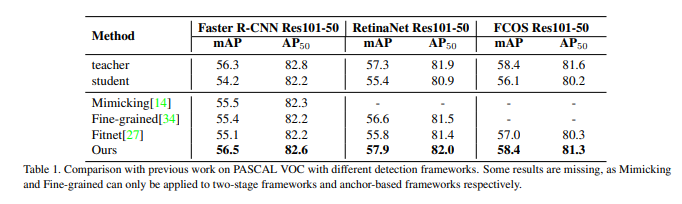

实验结果

广泛的结果表明,在各种检测框架下,学生模型可显著提高AP的表现,甚至优于老师。具体来说,在Reconet上使用ResNet-50的RetinaNet在COCO数据集上具有GID的mAP达到了39.1%,比基线的36.2%超出了2.9%,甚至比具有38.1%的AP的基于ResNet-101的教师模型更好。

往期精彩回顾

本站qq群851320808,加入微信群请扫码: