CVPR 2020 SLAM挑战赛冠军方案解读,搞定超难数据集TartanAir

极市导读

在CVPR 2020 SLAM挑战赛上,旷视研究院参赛团队获得了两个赛道的冠军。本文分享了他们采用的技术方案,并介绍了旷视SLAM机器人研究进展。

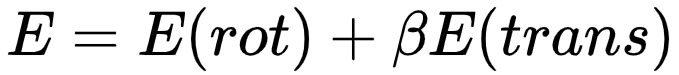

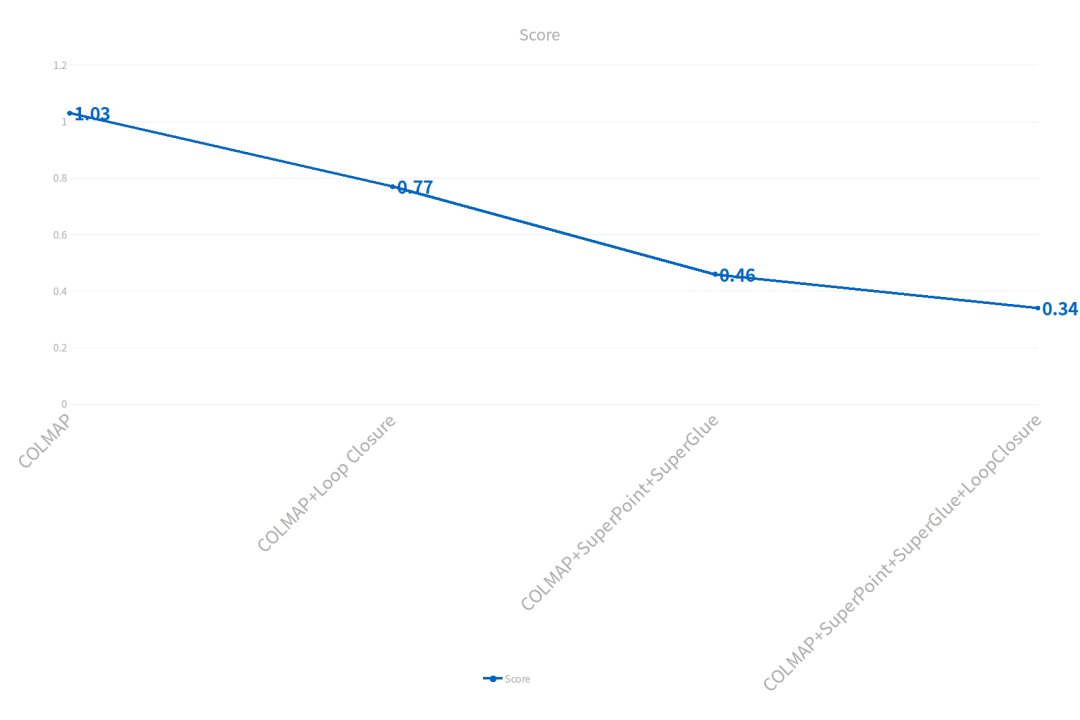

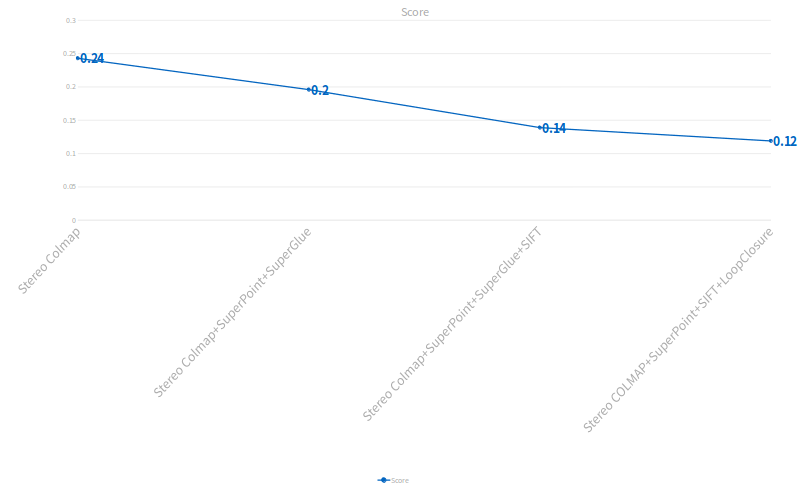

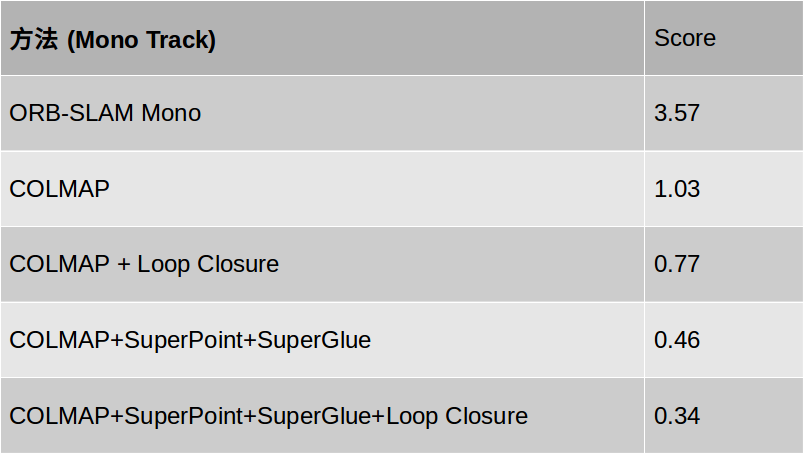

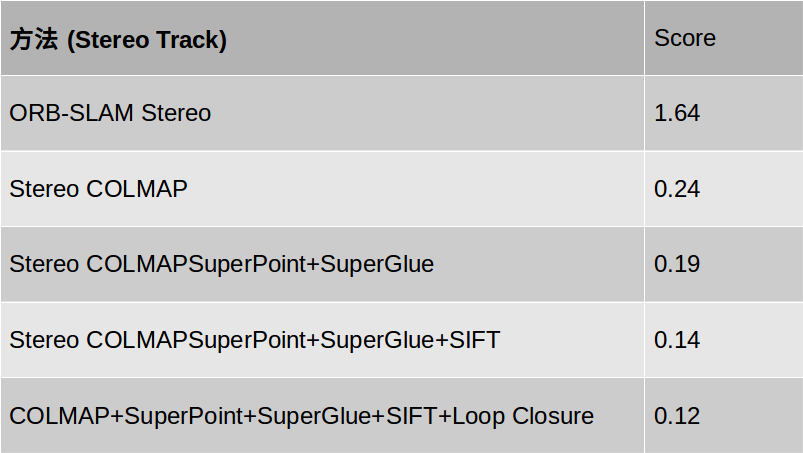

,Score越小越好。其中取

,Score越小越好。其中取 来平衡平移和旋转的误差,因为在该数据集上平均角速度(角度为单位)是平均线速度的7倍。

来平衡平移和旋转的误差,因为在该数据集上平均角速度(角度为单位)是平均线速度的7倍。

技术方案

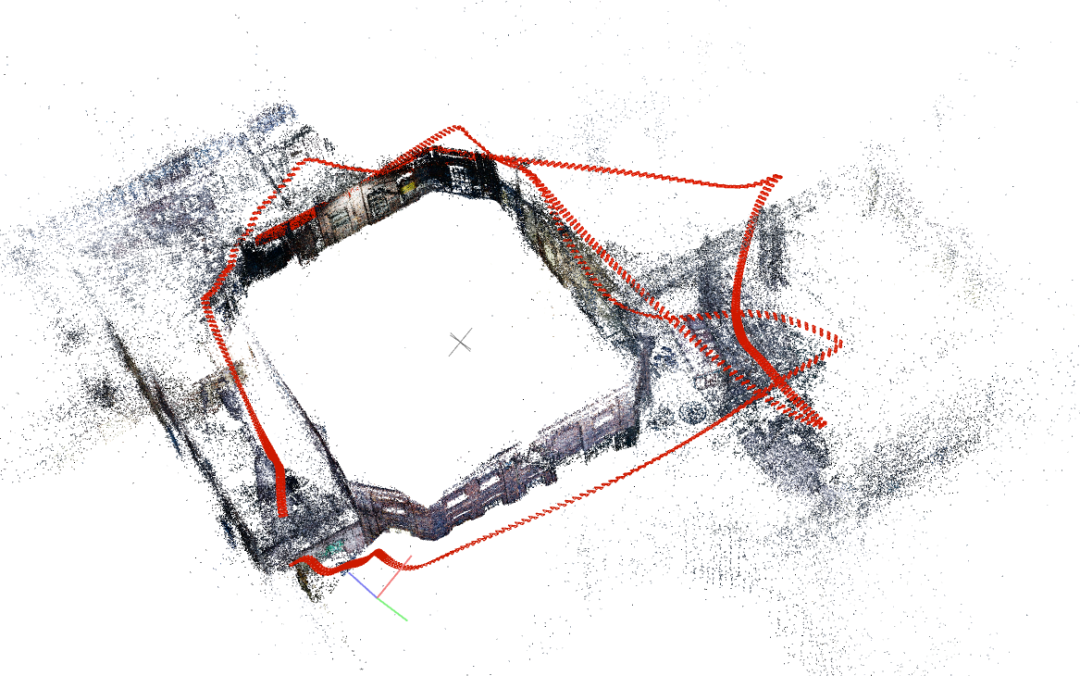

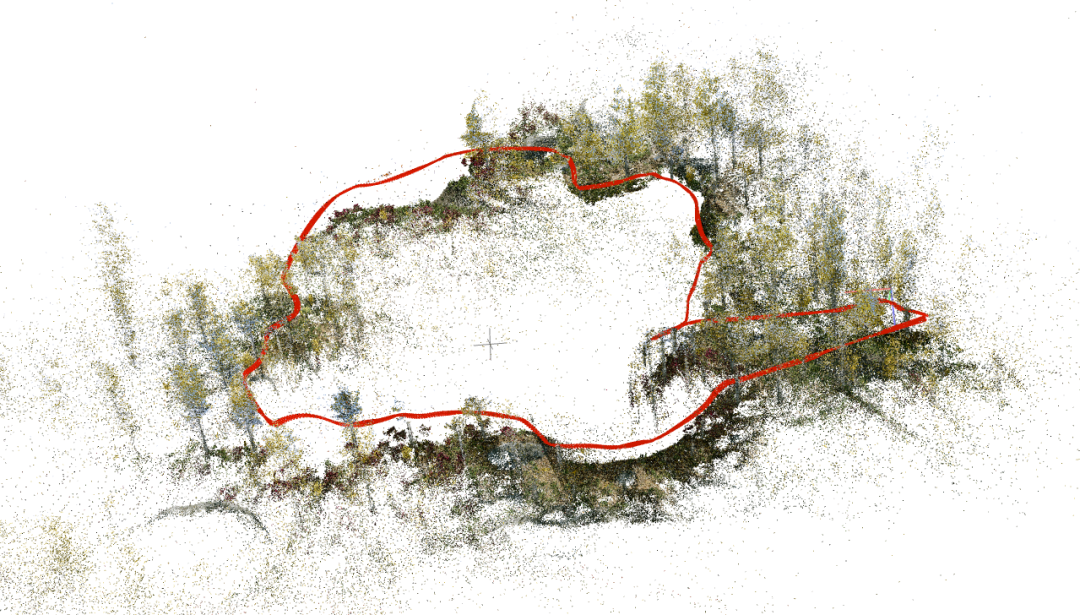

1.Mono Track

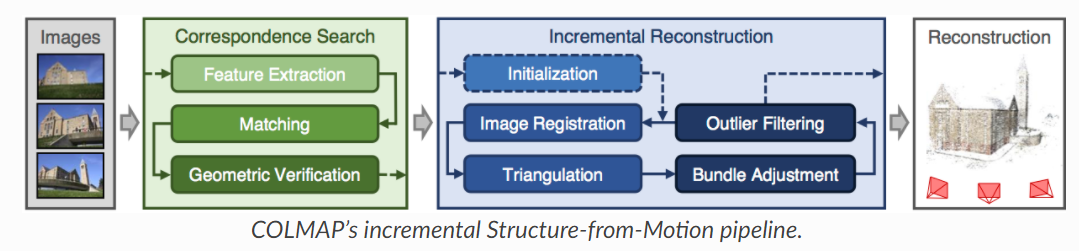

用 COLMAP 作为 baseline 方法

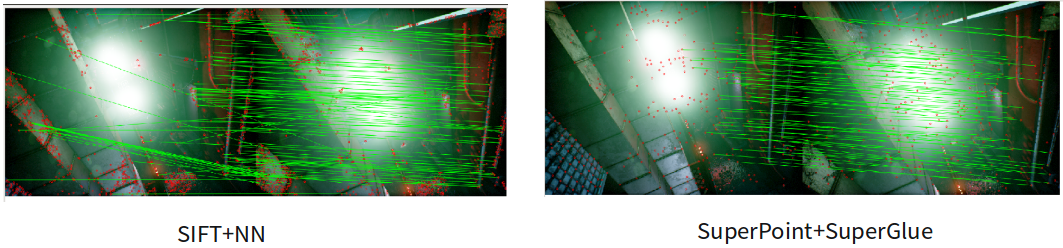

用 SuperPoint 和 SuperGlue 进行特征提取和匹配

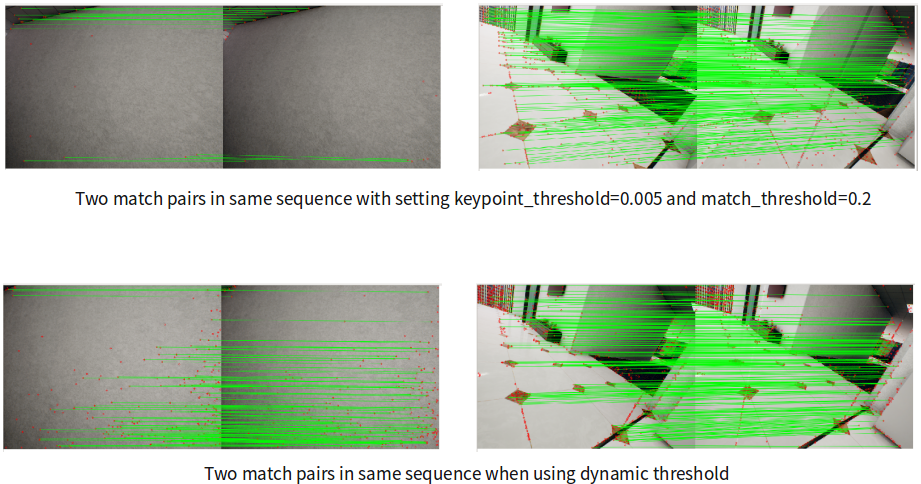

根据环境进行动态阈值调整

Loop detection via BoW and geometric validation

2.Stereo Track

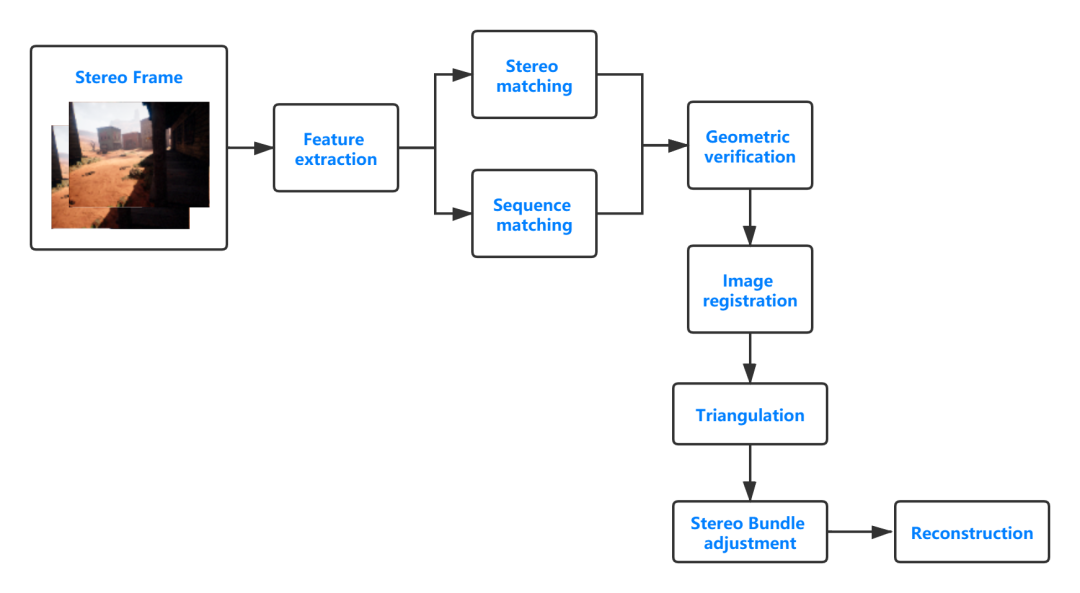

由于 COLMAP 不支持双目,首先将 COLMAP 改成双目的 COLMAP,主要添加了COLMAP 中双目的初始化,双目匹配,以及适配于双目的 BA。流程图如下:

跟单目的做法一样用 SuperPoint 和 SuperGlue 进行特征提取和匹配 同时使用 SIFT 特征点和 SuperPoint 特征点进行 Mapping

其他做法跟单目相同。

总结

延伸阅读:旷视SLAM机器人

MegBot-S800 AMR

推荐阅读

评论