1750亿参数,GPT-3却并不「智能」

新智元报道

新智元报道

来源:leogao.dev

编辑:白峰

【新智元导读】拥有1750亿参数的GPT-3取得了惊人的进步,但它并不是通用人工智能。GPT-3让我们看到了语言模型的能力,能否利用这种能力构建出一个模型,更好地理解周围的世界?

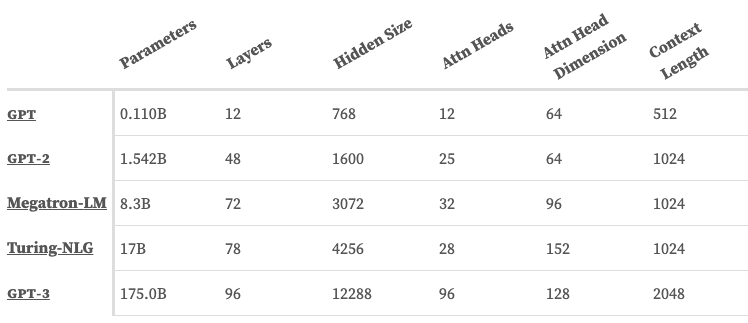

GPT-3解决的问题变多了,但只是堆了更多参数

马尔科夫链

马尔科夫链

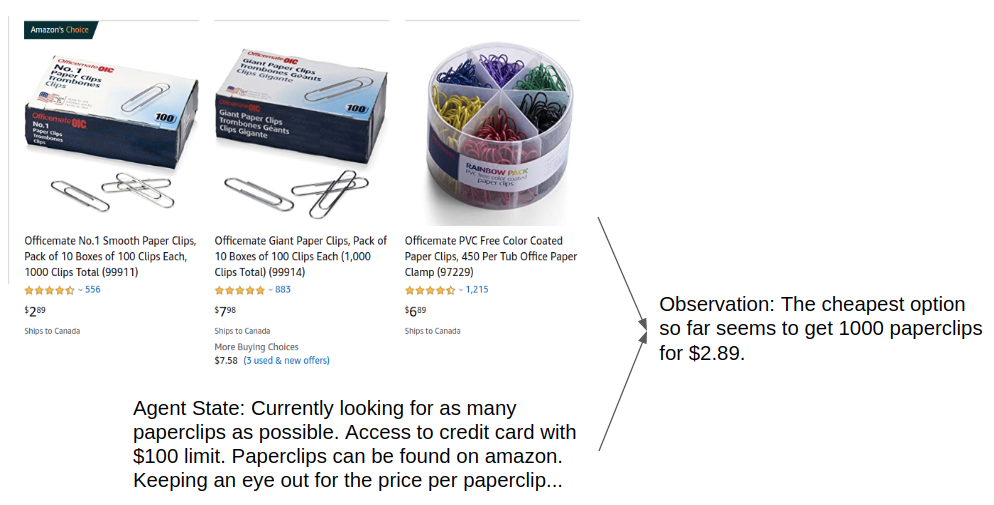

语言模型如何找到「亚马逊上最便宜的曲别针」

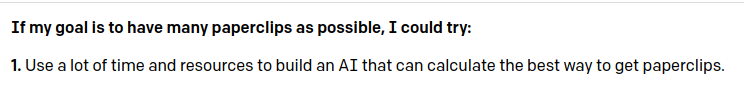

GPT-3告诉你获取更多曲别针的方法(来源: OpenAI API)

GPT-3告诉你获取更多曲别针的方法(来源: OpenAI API)

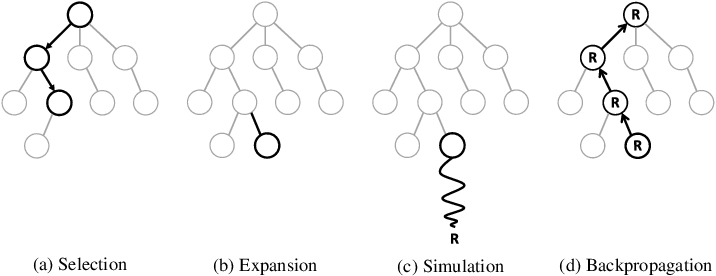

蒙特卡洛树搜索

每一个动作都可能是非常高级的,比如「找出买曲别针最便宜的方式」 ,但得益于语言的灵活性,我们可以用简短的token序列来描述非常复杂的想法。

一旦智能体决定了一个行动,为了实际执行这些抽象行动,这个行动可以使用语言模型分解成更小的子目标,比如「找出亚马逊上最便宜的曲别针」 ,类似于层次强化学习。

根据模型的能力和动作的抽象程度,甚至可以将动作分解成一个详细的指令列表。我们也可以将智能体的状态表示为自然语言。

由于智能体状态只是观测值的压缩表示,因此我们可以让语言模型对任何观测值的重要信息进行汇总,以表示其自身的内部世界状态。语言模型也可以用来周期性地删除(即忘记)状态中的信息,以便为更多的观测留出空间。

这样我们就能得到一个系统,它可以从外部世界传递观测信息,花一些时间思考该做什么,并用自然语言输出一个动作。

打头的是一个输入模块,可以将各种观测转换为与当前智能体状态相关的摘要文本。例如,网页、声音、图像都可以想办法转换为文本并映射到智能体的状态。

最后,为了让模型在现实世界真正发挥作用,可以再次使用语言模型将自然语言翻译成代码、 shell 命令、按键序列等许多可能的方式。

像输入一样,有无数种不同的方法来解决输出问题,哪一种方法是最好要看你的具体使用场景了,最重要的是,可以从纯文本智能体中获得各种形式的输入和输出。

一个输入模块的示例,该模块采用截图输入与当前智能体状态相结合的方式,将图片信息转换为智能体的观测。

当然,这更像一个思想实验

当然,这更像一个思想实验

上文所描述的,更像是一个思想实验,而不是明天将要发生的事情。

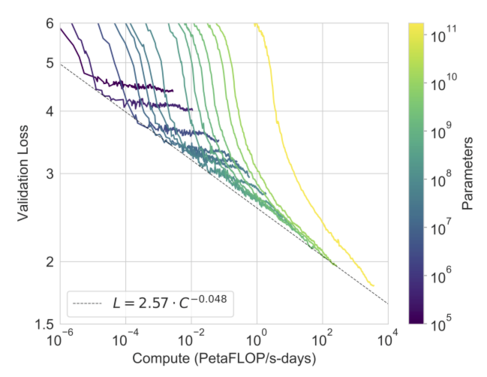

这种方法在很大程度上依赖于一个主要假设——更大的未来模型将具有更好的世界建模能力。然而,这可能是我们有史以来最接近AGI的机会:现在有了一条通往 AGI 的具体路径。

这个路径听上去不那么「扯淡」,未来能否实现让我们拭目以待。

参考:

https://leogao.dev/2019/10/27/The-Difficulties-of-Text-Generation-with-Autoregressive-Language-Models/