四两拨千斤!2020深度主动学习综述

极市导读

本文是一篇关于深度主动学习的综述,填补了该领域研究尚缺梳理的缺憾。此外,作者从应用的角度出发,对DAL的发展进行了总结和展望。>>加入极市CV技术交流群,走在计算机视觉的最前沿

A Survey of Deep Active Learning

论文地址:

https://arxiv.org/pdf/2009.00236.pdf

Abstract

主动学习试图通过标记最少量的样本使得模型的性能收益最大化。而深度学习则对数据比较贪婪,需要大量的数据供给来优化海量的参数,从而使得模型学会如何提取高质量的特征。近年来,由于互联网技术的快速发展,使得我们处在一个信息洪流的时代,我们拥有海量的未标记数据。借此,深度学习引起了研究人员的强烈兴趣,并且得到了快速的发展。和深度学习相比,研究人员对于主动学习的研究兴趣相对较低。这主要是由于在深度学习兴起之前,传统的机器学习所需要的标注样本相对较少。因此,早期的主动学习很难体现出应有的价值。尽管深度学习已经在各个领域取得了突破性进展,但是这绝大部分的成功都要归功于现有的大量标注数据集的公开。然而,大量高质量的标注数据集的获取需要消耗大量的人力,在一些需要很高专业知识的领域这是不被允许的,尤其是在语音识别、信息提取、医学图像等领域。因此,主动学习逐渐受到了应有的重视。

一种很自然的想法是能否使用主动学习来减少样本标注的成本,同时保留深度学习强大的学习能力。因此,深度主动学习出现了。尽管相关的研究已经相当的丰富,但是缺乏一个对深度主动学习全面的survey。本文正是要填补这项空白,我们为现有的工作提供了一个形式上统一的分类方法,并进行一个全面系统的概述。此外,我们还从应用的角度对DAL的发展进行了分析和总结。最后,我们对DAL中存在的困惑、问题进行了讨论,并给出了一些DAL可能的发展方向。

Introduction

在机器学习社区中深度学习和主动学习都有着重要的应用。他们凭借着各自优异的特性吸引了大量研究人员的兴趣。具体来说,DL已经在各种具有挑战性的任务上取得了前所未有的突破,但这很大程度上归功于海量标注数据集的公开。因此,DL在一些需要丰富知识的专业领域受限于高昂的样本标注代价。另一方面,从理论上讲,有效的AL算法可以实现在标注工作效率方面的指数级加速。这种巨大的标注代价节省潜力令人着迷。此外,经典的AL算法也存在难以处理高维数据的困境。因此,这种明显互补的优势使得DL与AL的结合DAL被研究人员给予厚望。深度主动学习已经被广泛的应用在了各个领域,例如图像识别,目标检测等。尽管相关的工作已经相当的丰富,但是深度主动学习仍然缺乏一个统一的分类框架。为了填补这项空白,在本文中我们将对现有的深度主动学习的相关工作做一个全面的概述,并提供一个形式化的分类方法。接下来,我们将首先简要的回顾深度学习与主动学习在各自领域中的发展现状。然后,在Section 3中进一步给出DL与AL结合必要性和所面临的挑战。

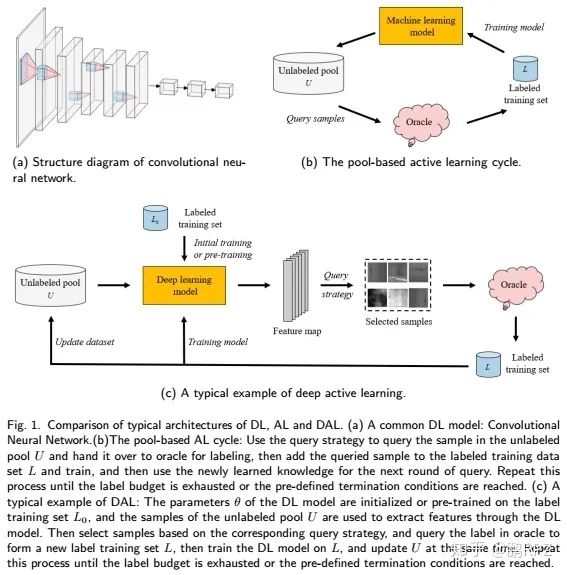

(a)基于池的主动学习周期:使用查询策略在无标记池中查询样本交给oracle进行标注,然后将查询的样本添加到标记训练数据集中并训练,接着使用新学习的知识进行下一轮查询。重复这个过程,直到标注预算被耗尽或者达到预先设定的终止条件。 (b)一个常见的深度学习model:卷积神经网络 (c)深度主动学习的典型例子: 深度学习model的参数在初始化标签训练集上进行初始化或者预训练,无标记池的样本通过深度学习model提取特征。然后基于相应的查询策略挑选样本,并在oracle中查询标签,形成新的标签训练集,接着在上训练深度学习model,同时更新。重复这个过程,直到标注预算被耗尽或者达到预先设定的终止条件。

Deep Learning

深度学习试图通过模拟人类大脑的结构来构建相应的model。1943年,A提出的McCulloch-Pitts (MCP) model被认为是现代深度学习的开端。随后,1986年B将反向传播引入到神经网络的优化中,这为深度学习后来的蓬勃发展奠定了基础。同年,递归神经网络被提出。1990年,LeNet网络出现,它是最早使用深度神经网络(DNN)的工作之一。然而,早期的这些开创性工作受限于当时的计算资源并未得到应有的广泛的重视与应用。2006年,深度信念网络(DBNs)被提出,并以此探究了比以往更深的网络,这促使将神经网络被命名为深度学习。在2012年,在ImageNet大赛上,深度学习模型AlexNet一举夺冠。它使用ReLU激活函数有效的抑制了梯度消失的问题,同时使用多GPU极大的提高了模型的训练速度。随后,深度学习开始在各个大赛中斩获冠军并且在各种任务中不断刷新着记录。从自动化的角度来看,深度学习的出现使得原本机器学习中特征的手动设计转变为自动提取。正是由于深度学习强大的自动特征提取能力才使得它在众多的领域表现出前所未有的优势。深度学习经过数十年的发展,相关的研究工作已经相当的丰富。在Fig.1a,我们显示了一个标准的深度学习模型示例:卷积神经网络。以此为基础类似的卷积神经网络被应用于各种图像处理任务。此外被广泛应用的还有循环神经网络、生产对抗性网络等。从2017年开始,深度学习从最初的特征提取自动化逐渐转变为模型架构设计的自动化。但是,这还需要很长的一段路要走。

得益于现有的大量标注数据集的公开, 近年来,深度学习在机器翻译,语音识别,图像分类等各个领域中都取得了突破性进展。然而,这是以大量人工标注数据集为代价的,并且深度学习对数据有着很强的贪婪属性。在现实世界中,大量未标注的数据集的获取是相对较为简单的,但是数据集的人工标注面临着高昂的代价。尤其是那些需要很高专业知识的领域,例如对COVID-19患者的肺部病变图像的标注以及描述工作就需要经验丰富的临床医生才能完成,显然要求他们完成大量医学图像标注工作是不可能的。类似的领域还包括语音识别、信息提取,卫星遥感等领域。因此,我们急需一种方法可以在注释少量样本的情况下使得模型获得最大的性能增益。

Active Learning

主动学习正是这样一种方法,它试图从未标记数据集中选择最有用的样本交给 oracle进行标注,从而在保持性能的情况下尽可能降低标注成本。主动学习从应用场景上来可以划分为membership query synthesis,stream-based selective sampling和pool-based active learning. Membership query synthesis是指学习者可以请求查询输入空间中任何未标记样本的标签,包括学习者生成的样本。而stream-based selective sampling和pool-based的区别主要在于前者是对数据流中的每个样本独立作出判断是否需要查询未标记样本的标签,而后者则可以基于对整个数据集的评估和排名来选择最佳查询样本。相比之下,pool-based的场景似乎在论文应用中更加常见,但很显然stream-based selective sampling的应用场景则更适合于要求时效性的小型的移动终端设备。在fig.1(a)中,我们展示了基于池的主动学习周期的框架图。初始状态下,我们可以从未标记池中随机挑选一个或多个样本并交给oracle查询标签得到标注数据集,然后在上以监督学习的方式训练model。接着,利用新知识选择下一个要查询的样本,并将新查询的样本添加到中并训练。重复这个过程,直到标注预算被耗尽或者达到预先设定的终止条件。

与深度学习通过使用手工或者自动的方法千方百计的设计具有高性能特征提取能力的模型不同。主动学习则从数据集入手,主要通过设计精妙的查询规则从未标记的数据集中选择最佳的样本并查询其标签,试图尽可能的降低标注代价。因此,查询规则的设计对主动学习的性能是至关重要的。相关的研究也相当的丰富,例如,在给定的一组未标记数据集中,主要的查询策略有基于不确定性的方法,基于多样性的方法和预期的模型更改。除此之外,还有很多的工作研究了混合查询策略,同时考虑查询样本的不确定性和多样性,并试图在这两种策略中找到平衡点。因为单独的基于不确定性的采样往往会造成采样偏差:即当前选择的样本在未标记数据集的分布中不具有代表性。另一方面,仅考虑多样性策略则可能会导致标记成本增加:即可能有相当一部分信息量较低的样本会被选择。更多经典的查询策略可以在A中进行查询。虽然AL相关的研究已经相当丰富,但AL仍然面临着向高维数据(例如,图像、文本、视频等)拓展的难题,因此大多数主动学习的工作都主要集中在低维问题上。此外,AL往往基于事先提取好的特征来查询高价值的样本,其本身并不具有特征提取的能力。

The necessity and challenge of combining DL and AL

DL在高维数据处理以及自动特征提取方面有着强大的学习能力,AL在有效降低标注成本方面也有着巨大的潜力。因此,一种显而易见的想法是将DL与AL进行结合,这将极大的拓展它们的应用潜力。DAL正是考虑结合二者优势互补的特性而被提出的,相关的研究也被研究人员寄予厚望。尽管AL关于查询策略的研究已经相当丰富,但是想要直接将这种策略应用到深度学习中仍然是相当困难的。这主要是由于:

标签样本的数据不足。主动学习往往只依赖于少量的标记样本数据就可以实现学习和更新模型,而DL往往对数据有很强的贪婪性,经典AL方法所提供的标记训练样本不足以支持传统DL的训练。此外,在主动学习中常用的one by one样本查询方式在深度学习中也是不适用的。 模型不确定性问题。基于不确定性的查询策略是主动学习的一个重要方向。在分类任务当中,尽管深度学习可以使用softmax layer来获得标签上的概率分布,然而事实表明它们过于自信。最终输出的softmax 分数作为置信度度量方法是不可靠的,这种方法的性能甚至会比随机采样的效果更差。 处理管道不一致。AL和DL的处理管道是不一致的。大多数AL算法主要关注于分类器的训练,各种查询策略的很大程度上都是基于固定的特征表示。而在DL中,特征学习和分类器的训练是共同优化的。仅在AL框架中对DL模型进行微调或者将它们视作两个独立的问题可能会引起分歧问题。

针对第一个问题,研究者考虑使用生成网络来进行数据增强或者为高置信度样本分配伪标签等方式来扩充标记训练集。也有研究者考虑在跨AL周期上同时使用标记数据和未标记数据集进行监督训练与半监督训练的结合。此外,基于启发式的AL查询策略已经被证明在应用于CNN时是无效的。因此,针对经典AL中one-by-one的查询策略,许多研究者聚焦于batch样本的查询策略的改进, 在批量的样本中同时考虑样本的信息量以及多样性。

为了解决深度学习对模型不确定性的忽视,一些研究者借助贝叶斯深度学习来处理主动学习语境下高维但查询数量较少的mini-batch样本,从而有效的缓解了DL模型对输出结果过于自信的问题。

对于处理管道不一致的问题,研究者考虑修改AL和DL的结合框架,使提出的DAL模型尽可能通用,方便可以拓展到各个应用领域。这对DAL的推广有着重要的意义。例如,A将主动学习的思想嵌入深度学习提出了一个与任务无关的架构设计。

我们将在下一节中集中对deep active learning中使用到的各种策略进行详细的讨论和总结。

Deep Active Learning

在本节中,我们将对DAL的相关工作进行全面系统的概述。Fig.1c显示了一个典型的深度主动学习的模型架构示例。深度主动学习的典型例子: 深度学习model的参数在初始化标签训练集上进行初始化或者预训练,无标记池的样本通过深度学习model提取特征。然后基于相应的查询策略挑选样本,并在oracle中查询标签,形成新的标签训练集,接着在上训练深度学习model,同时更新。重复这个过程,直到标注预算被耗尽或者达到预先设定的终止条件。从Fig.1c中的DAL框架示例中我们可以粗略的将DAL的框架分成两大部分:在未标注数据集上的主动学习查询策略以及deep learning model的训练方法。为此,我们将在接下来的3.1和3.2中分别对他们进行讨论和总结。最后,我们将在3.3中讨论deep active learning 在模型的泛化通用性上所做的努力。

Query Policy Optimization in DAL

在基于池的方法中,我们定义为有个样本的未标记数据集,其中,为样本空间,为标签空间(最初是未知的),为一个潜在的分布,其中。为有个样本的当前标记训练集。在DAL的标准监督环境下的,我们的主要目标是设计一个查询策略,,使用深度模型,监督环境下的DAL的优化问题可以被表述为

其中为给定的损失方程,并且期待。我们的目标是在保证一定精度的前提下,使得尽可能的小。因此,在DAL中查询策略对标注代价的减少是至关重要的。

Batch Mode Deep Active Learning (BMDAL)

DAL与经典AL的主要区别在于DAL采用的是基于batch的样本查询方式。在传统的AL中大部分算法采用 one by one 的方式进行查询,这导致学习模型被频繁训练,而训练数据却几乎没有变化。这种查询方式得到的训练集在DL模型的训练中不仅低效且极易引起过拟合。因此,BMDAL的研究是必要的。在BMDAL的语境中,在每一个获取步骤,我们依据所使用的获取函数以及在上训练过的深度模型对候选的未标记数据样本的batch进行评分, 从而选择一批新的数据样本$\mathcal{B}^={x_1^,x_2^,...,x_b^}$,这个问题可以被表述为:

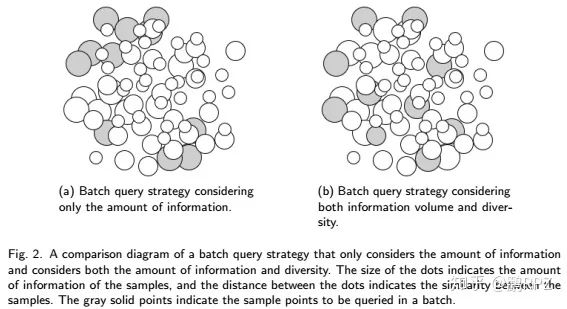

一个天真的想法是基于one-by-one的策略,连续查询一个批次的样本。例如,A采用批量获取的方法,选择查询BALD获取分数最高的前个样本。显然,这种方法是不可行的,因为这极有可能选择一组信息丰富但却相似的样本。类似的样本为模型提供的信息基本上是相同的,这不仅浪费标注资源,模型也很难真正学到有用的信息。因此,BMDAL的核心在于查询一组信息丰富且多样的样本。Fig.2展示了这种想法的一个示意图。

基于batch查询策略构成了AL与DL相结合的基础,相关的研究也非常的丰富。我们将在下面几个小节中对BMDAL上的查询策略进行详细的概述与讨论。

Uncertainty and hybrid query strategy

由于基于不确定性的方法形式简单且较低的计算复杂度,它是AL中是非常受欢迎的一种查询策略。这种查询策略主要用在一些浅层的模型(如,SVM或KNN)当中,这主要是由于这种模型的不确定性可以通过传统的不确定性采样方法(Margin Sampling, Least Confidence and Entropy )进行准确测量。

有很多DAL方法直接采用了这种基于不确定性的采样策略,但是,正如3.1.1所分析的那样这很容易导致批查询样本的多样性不足(没有充分利用数据分布的相关知识),进而导致DL模型训练性能低下甚至失效。一种可行的策略是在一个批查询中采用混合查询策略,以显式或者隐式的方式同时考虑样本的信息量、多样性或者表示形式。

早期的Batch Mode Active Learning (BMAL)算法性能往往过于依赖样本之间相似性的度量。此外,这些算法往往仅善于利用(学习者倾向于仅关注当前决策边界附近的样本,对应于高信息量的查询策略),导致查询到的批量样本集中的样本无法代表特征空间的真实数据分布(批量样本集的多样性不足)。基于这个观察,A使用深度神经网络来学习样本的特征表示,并显式的计算样本之间的相似性。同时平衡利用和探索(在模型训练初期学习者采用随机采样的策略来进行探索)进程,从而更为准确的测量样本之间的相似度。

另一方面, DBAL通过将信息量以权重的方式添加到K-means的优化目标中,深入研究了在mini-batch的样本查询设置下同时考虑样本信息量与多样性的混合查询策略。DBAL可以方便的完成从广义线性模型到DL的拓展,不仅增加了DBAL的可拓展性且增加了小批量主动查询样本的多样性。这种混合查询策略是相当流行的,例如,WI-DL 主要考虑深度信念网络(DBN)的两个阶段,在无监督特征学习阶段主要考虑数据的代表性,而在监督微调阶段来兼顾数据的不确定性,然后将两个指标进行整合,最后使用提出的weighted incremental dictionary learning (WI-DL)算法进行优化。

尽管上述改进已经取得了不错的性能,但是仍然存在一个待解的隐患。事实上,基于多样性的策略并非对于任何数据集都是合适的。数据集的类别内容越丰富批处理的大小越大,基于多样性的方法效果就越好。反之,使用基于不确定性的查询策略表现效果则相对更好。这些特性取决于数据集的统计特性,而在BMAL中数据往往是不熟悉的且可能是无组织的。因此,无法知道具体哪种AL查询策略更加合适。基于此,Batch Active learning by Diverse Gradient Embeddings (BADGE)对在幻觉梯度空间中表示时不同且大小的点组进行采样,从而在一个批次中同时考虑模型的预测不确定性和样本的多样性。最重要的是,BADGE可以实现在预测不确定性和样本多样性之间的自动平衡,而不需要手动的超参数调整。不同于BADGE以一种隐式的方式来考虑这种混合查询策略,Wasserstein Adversarial Active Learning (WAAL) 提出了一种在不确定性和多样性之间显式的折中的混合查询策略。此外,WAAL通过采用Wasserstein距离,将AL中的交互过程建模为分布匹配,并从中得出损失,进而将WAAL分解为两个阶段:DNN参数优化与查询批次选择。

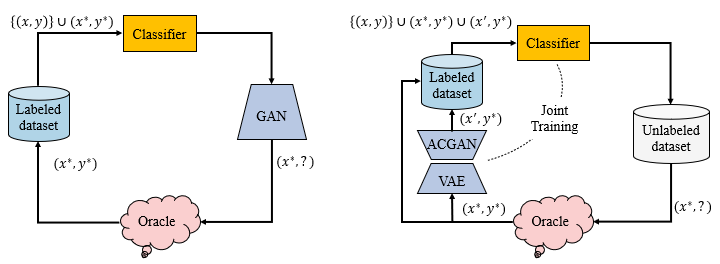

TA-VAAL(2020)也探索这种混合查询策略的平衡。TA-VAAL认为基于不确定性的方法没有很好的利用整体的数据分布,而基于数据分布的方法往往忽视了任务中的结构。因此,TA-VAAL提出将损失预测模块和RankCGAN概念整合到变分对抗主动学习(VAAL)中,以便同时考虑数据分布和模型的不确定性。TA-VAAL在各种平衡和不平衡的基准数据集上都取得了很好的性能。TA-VAAL与VAAL的结构图被展示在fig6.

实际上,尽管混合查询策略表现出更为优异的性能。但相比之下由于基于不确定性的AL查询策略与DL的softmax层的输出结合更为方便,因此,基于不确定性的查询策略仍然被广泛使用。

Deep Bayesian Active Learning (DBAL)

正如2.3中的DL与AL相结合的挑战分析所述,基于不确定性的采集功能是许多经典的AL算法一个重要研究方向,而传统的DL方法很少代表这种模型不确定性。

为此,Deep Bayesian Active Learning 出现了。在给定的输入集合和属于 类的输出,概率神经网络模型可以被定义为。是在参数空间 (通常是高斯)上的先验 ,并且似然通常由给出。我们的目标是获得在 上的后验分布:

对于给定的新的数据点, 通过以下方式进行预测:

DBAL将贝叶斯卷积神经网络同AL方法进行结合,使BALD适应了深度学习环境,从而为高维数据开发了一个新的AL框架。它正是采用上述方法首先对CNN权重将进行了高斯先验建模,然后使用变分推断来获得网络预测的后验分布。此外,在实践当中,研究人员往往也使用一种功能强大成本低廉的Monte随机正则化技术来获得后验样本,并在真实数据集上有着很好的表现。并且,这种正则化技术已被证明等价于变分推理。

但是,A core-set approach 指出DBAL由于需要批量采样的存在,并不适合大型数据集。需要指出的是,DBAL为了获得更好的置信度估计允许在测试时使用dropout,但在Discriminative Active Learning的分析认为该方法的性能与使用神经网络的softmax分数作为不确定性采样的性能相似。这需要引起警惕。

此外,A指出基于不确定性的DBAL方法可能会受到对抗性示例的愚弄,一个微小的扰动可能会导致不可接受的性能损失。DEBAL认为在变分推断方法中的模式崩溃现象导致了DBAL方法的过度自信的预测。为此,DEBAL通过将集成方法的表达能力与MC-dropout相结合在没有交易代表性的情况下获得更好的不确定性。

另一方面,BatchBALD则选择拓展BALD到批量查询,不再计算单个样本与模型参数之间的互信息,而是重新计算了批量样本与模型参数之间的互信息来共同对批量的样本进行评分。因此BatchBALD可以更为准确的评估共同互信息。

受到有关贝叶斯核心集最新研究的启发,ACS-FW重新构建了批处理结构,以优化对整个数据集引起的对数后验的稀疏子集近似。ACS-FW通过使用这种相似性,同时使用Frank-Wolfe算法大规模启用有效的贝叶斯AL,并且使用随机投影使得ACS-FW得到了进一步的推广。ACS-FW和其他查询策略相比查询的样本在整个数据流行上拥有更好的覆盖。

DPEs则引入了一种可拓展的深度概率集合技术,它使用正则化的集合来逼近深度BNN,并在一系列大规模的视觉AL实验来评估DPEs的分类效果。

ActiveLink也是受到贝叶斯深度学习最新进展的启发。它对现有的神经链接预测因子采取贝叶斯的观点,通过利用知识图的基础结构拓展了不确定性采样的方法,从而实现了一个新颖的深度主动学习方法。并且ActiveLink注意到尽管AL可以采样高效的样本,但在AL的过程中每次迭代都需要从头开始重新训练模型,这对DL模型的训练是不可接受的。一个直接的解决方案是使用新选择的数据增量地训练模型,或者将它与现有的训练数据[29]结合起来。但这会导致模型要么偏向少量新选择的数据,要么偏向于过程早期选择的数据。为了解决这种偏差问题,ActiveLink采用了一种基于元学习的有原则的无偏差增量训练方法。即,在每次AL迭代中,ActiveLink使用新选择的样本更新模型参数,并通过基于前一次迭代中选择的样本对模型进行泛化来逼近模型的未来预测的元目标。这使得ActiveLink可以在新选择的数据和之前选择的数据的重要性之间取得平衡,从而实现对模型参数的无偏估计。

除了上述DBAL工作外,由于BNN较少的参数量以及与传统AL相似的不确定性采样策略,使得DBAL的研究相当的广泛,相关的DBAL工作还有很多。

Density-based Methods

基于密度的方法主要是指从集合(核心集)的角度来考察样本的选择。核心集的构建正是这样一种具有代表性的查询策略。这种想法主要受到核心集数据集压缩思想的启发,试图使用核心集来代表整个原始数据集的特征空间的分布,从而降低AL的标注成本。Farthest First Active Learning (FF-Active) 正是基于这种想法使用表示层上神经激活空间中的最远优先遍历从池中查询连续点。值得一提的是,FF-Active与Exploration-P 类似在AL的早期阶段使用随机查询的方法增强AL的探索能力,从而避免AL陷入batch样本多样性不足的陷阱。

类似的为了解决批量查询中的采样偏差问题,增加批量查询样本的多样性。Core-set approach 尝试采用构建核心子集的方法来解决此问题。并进一步通过解决K中心问题来构建核心子集,使得在已选的核心集上学习的模型与其余数据相比更有竞争力。但由于Core-set approach需要在未标记的数据集上构建一个较大的距离矩阵,因此这个搜索过程在计算上相当的昂贵。并且这种劣势在大规模的未标记数据集上将变得更加明显。\cite{Du2019BuildinganActivePalmprintRecognitionSystem}将DAL应用于高维且复杂的掌纹识别数据上。与核心集的思想类似,将AL视为一个二分类任务,期待标注样本集与未标注样本集拥有相同的数据分布并使得二者难以区分,即试图找到与原始数据集具有相同分布的核心标记子集。具体来说,由于启发式的生成模型模拟数据分布难以训练且不适合掌纹这种高维复杂的数据。因此作者考虑判断样本是否能被高度肯定的区分来自于未标注数据集还是标注数据集。那些可以被明确区分的样本明显与核心标注子集的数据分布有着显著的差异,这些样本将被的添加到标注数据集中,进行下一轮的训练。

先前的基于核心集的方法往往只是尝试查询的数据点尽可能的覆盖所有点的数据流行而没有考虑密度,导致查询到的数据点过度代表来自流行稀疏区域的样本点。与类似\cite{Du2019BuildinganActivePalmprintRecognitionSystem} ,Discriminative Active Learning (DAL) 也将主动学习是一个二元分类任务,试图使查询的标记数据集与未标记数据集无法区分。DAL突出的是它可以按照密度成比例的从未标记数据集中进行采样,而不会偏向位于稀疏流行域的样本点。并且DAL提出的方法并不局限于分类任务在概念上易于转移到其他新的任务上。

除了相应的查询策略外,一些研究者也考虑了批量查询大小对查询性能的影响,例如,\cite{BatchBALD2019,Zhdanov2019Diverseminibatch,Ash2019DeepBatchActive,Pinsler2019Bayesian}主要研究了较小批量下查询策略的优化,而\cite{Chitta2019Training}建议扩大AL的查询规模进行大规模采样(一次采样10k或500k)。并通过集成了数百个模型并重用中间检查点方式用较小的计算代价高效的实现了在大规模标记数据集上的训练数据分布式搜索。\cite{Chitta2019Training}也证明了使用整个数据集进行训练的性能并不是性能的上限,基于子集的AL可能有更好的性能。

基于密度的方法主要从数据分布的角度来考虑核心子集的选择,相关的研究方法相对较少,它为样本的查询提供了一种新的可能。

Other methods

还有一些研究不像以上查询方法那样如此集中,我们将它们总结在下面。

A将启发式的AL算法重新定义为强化学习问题,通过明确的选择策略来引入一个新的描述。

与先前的大多数基于不确定性的方法不同,DFAL \cite{Ducoffe2018Adversarial} 认为这些方法容易受到对抗性示例的愚弄,因此DFAL将重点放在决策边界附近示例的研究。并主动利用这些对抗性示例在输入空间分布上提供的信息来近似它们到决策边界的距离,这种对抗性查询策略可以有效提高训练CNN的收敛速度。

另一方面,AL旨在利用数据的相对重要性标注尽可能少的的数据高效的训练一个性能符合要求的模型。因此,数据集本身的属性对DAL的性能也有着重要的影响。为此,GA研究了常见数据集中图像数据的相对重要性,提出了一种通用的数据分析工具,可以帮助我们更好的了解数据集中训练示例的多样性。GA发现并非所有的数据集都可以在一个小的子样本集上完成训练,因为一些数据集中的样本重要性的相对差异几乎可以被忽略。因此,在AL中盲目的使用较小的子数据集也是不可取的。

\cite{Beluch2018PowerEnsemblesActive}发现与MC-dropout和基于密度的方法相比,基于集合的AL可以在获取过程中有效的抵消数据集中的类别不平衡,导致更多的校准预测不确定性,从而获得更好的性能。

一些研究者也注意到在传统的AL工作流程中往往将获取函数视为固定的已知的先验,而这种获取函数是否合适,只有等标记预算被消耗殆尽才能进行观察。这导致无法对获取函数进行灵活快速的调优。因此使用强化学习对获取函数进行动态调优或许是一个不错的选择。

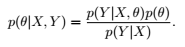

RAL提出选择将BNN作为获取函数的学习预测器。然后,BNN预测器提供的所有概率信息会被合并从而得到一个全面的概率分布,接着概率分布被送到一个BNN概率策略网络,该网络在每个标记回合中基于oracle的反馈进行强化学习。这种反馈会对采集函数进行微调从而不断改善获取函数的质量。在Fig4中展示了传统AL与RAL的管道对比。

标准的AL,RAL and DRAL的管道对比。(a)标准的AL管道通常由三个部分组成。Oracle提供一组标记数据,预测器(此处为BNN)用来学习这些数据,并为指南提供了可预测的不确定性,该指南通常是固定的,硬编码的获取函数,它为Oracle挑选下一个样本从而重新开始循环。(b)RAL用策略BNN代替固定获取函数,该策略BNN以概率状态进行学习,并从oracle获得反馈,以强化学习的方式学习如何选择下一个最优的样本点(红色的新部分)。因此,RAL可以更加灵活地调整获取函数以适应现有的数据集。(c)DRAL为person Re-ID任务设计了一个深度强化主动学习框架。对于每个查询锚点(探针),代理(增强型主动学习者)将在主动学习过程中从图库池中选择实例交给oracle以获得带有二进制反馈(正/负)的人工注释。状态评估所有实例之间的相似关系,根据oracle的反馈计算奖励从而调整代理的查询。

DRAL采用了类似的想法,为person Re-ID任务设计了一个深度强化主动学习框架。DRAL使用强化学习的思想对获取函数进行动态的调整,从而获得高质量的查询样本。

另一方面,Active-iNAS注意到先前的大多数DAL方法都假定已经为当前的任务设计合适的DL模型,从而主要集中在研究如何设计有效的查询机制上。而事实上已有的DL模型对当前的DAL任务并不一定是最优的。为此Active-iNAS对这一假设发起挑战,在进行主动学习的同时使用神经架构搜索技术(NAS)动态地搜索有效的模型架构。

还有一些工作致力于为DAL提供一个方便性能对比的平台。\cite{Munjal2020Towards}对DAL方法的鲁棒性和可复现性进行了详细的探讨和研究,并给出了许多有用的建议。

总的来说,这些查询策略并非相互独立,而是相互联系的。基于Batch的BMDAL为AL查询的样本在DL模型上的更新训练提供了基础。尽管DAL中的查询策略丰富且复杂,但它们大都是为了在BMDAL中兼顾查询批次的多样性与不确定性。而先前基于不确定性的方法往往忽视batch中的多样性,因此,这些方法大致可以被归为两类。它们要么在输入或学习表示空间中设计明确鼓励批次多样性的机制,要么直接测量整个批次的互信息(MI)。

Insufficient Data in DAL

AL往往只需要少量的标记样本数据就可以实现学习和更新模型,而DL需要大量的标记数据才能进行有效的训练。因此,AL与DL的结合需要尽可能多的利用无需耗费过多人力资源的数据策略来实现对DAL 的模型训练。先前的大多数DAL方法往往只在通过查询策略所采样的标记样本集上进行训练。而忽视了已有的未标记数据集的存在,并且相应的一些数据扩充和训练策略也没有得到充分的利用。这些策略有助于改善在DAL训练中标签数据不足的问题,且不会增加额外的人工标注代价。因此,这些策略的研究也是相当有意义的。

例如,CEAL(2017)除了使用通过查询策略采样的标记数据集外,还通过为具有高的模型预测置信度的样本分配伪标签的方式丰富训练集。使用扩充过的训练集一同训练DL模型。这种策略被展示在Fig.CEAL。

另一种非常流行的策略是在标记数据集和未标记数据集上进行无监督训练并结合其他策略来训练整个网络结构。

例如,WI-DL(2017)注意到对DBN进行完全训练需要大量的训练样本,将DBN应用于AL语境下有限的训练集上是不切实际的。于是为了提高DBN的训练效率,WI-DL采用在所有数据集上进行无监督特征学习与在标记数据集上进行有监督微调相结合的方式来训练DBN。

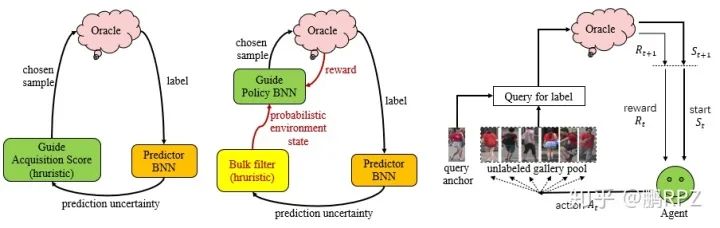

与此同时,也有研究者考虑借助生成对抗网络(GAN)来进行数据增强。例如,GAAL(2017)首次将生成对抗网络(GAN)引入到了AL的查询方法中。GAAL旨在希望使用生成学习生成比原始数据集中拥有更多信息量的样本。

然而,随意的数据增强并不能保证生成的样本比原始数据拥有更多的信息量,这反而会浪费计算资源。因此,BGADL(2019)拓展了GAAL的想法,提出了一种贝叶斯生成式主动深度学习的方法。具体的,BGADL结合了Generative Adversarial Active Learning ,Bayesian data augmentation (Tran et al., 2017), auxiliary-classifier generative adversarial networks (ACGAN) (Odena et al., 2017) and variational autoencoder (VAE) (Kingma & Welling, 2013)方法,旨在生成属于不同类别的分歧区域样本 。GAAL与BGADL的结构对比被展示在fig.GAAL_BGADL。

GAAL与BGADL的结构对比图。更多细节可以查看BGADL。

随后,VAAL(2019),ARAL(2019)借鉴了先前的方法不仅使用标记数据集与未标记数据集一同训练网络,而且将生成对抗学习引入到了网络架构中进行数据增强,以便进一步的提升网络的学习能力。

VAAL与TA-VAAL的结构对比图。

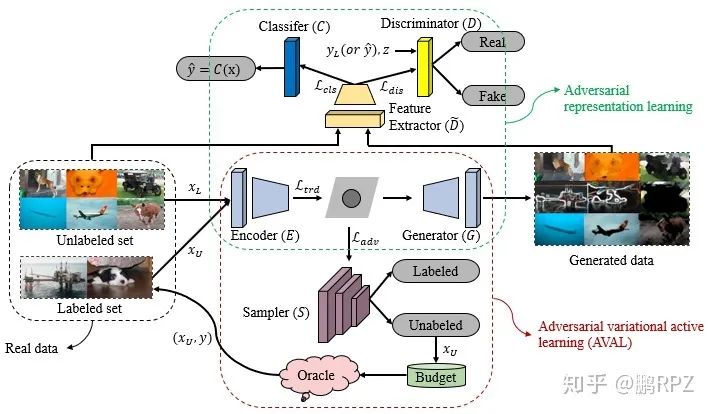

VAAL,ARAL和TA-VAAL的结构对比。1)VAAL使用标记数据和未标记数据采用半监督的方式来学习数据的潜在的表示空间,根据潜在空间选择信息量最大的未标记数据进行标注。2)TA-VAAL拓展了VAAL,将损失预测模块和RankCGAN整合到变分对抗主动学习(VAAL)中,以便同时考虑数据分布和模型不确定性。3)ARAL也拓展了VAAL,ARAL不仅使用了真实数据集(由标注数据集和未标注数据集组成)和还使用了生成数据集来共同训练网络。整个网络由编码器、生成器、鉴别器、分类器和采样器构成,模型的所有部分被共同训练。更多的细节可以查看ARAL。

具体的,VAAL注意到基于不确定性的batch查询策略除了容易导致样本多样性不足的问题,实际上还非常容易受到异常值的干扰。此外,对于高维数据基于密度的方法容易受到p-范数的限制,导致计算的距离过于集中。为此,VAAL提出使用对抗学习表示的方法来区分标记数据与未标记数据的潜在空间的编码特征,从而削弱异常值的干扰。并且VAAL使用标记数据和未标记数据以半监督的方式来共同训练 variational autoencoder (VAE) 试图欺骗对抗网络预测所有的数据点均来自标记池,以此来解决距离集中的问题。VAAL在大规模的数据集上可以学习有效的低维潜在表示,并通过共同学习表示形式和不确定性提供了一种有效的主动学习采样方法。

接着,ARAL拓展了VAAL,旨在使用尽可能少的人工标注样本但充分利用已有的或生成的数据信息来提升模型的学习能力。除了使用标记数据集与未标记数据集,ARAL还使用了深度生产网络生产的样本来共同训练整个模型。ARAL由VAAL与对抗表示学习两部分组成,通过VAAL学习标记和未标记数据潜在的特征表示空间,并据此选择信息量最大的未标记样本,同时使用真实数据与生成数据通过对抗表示学习来增强模型的学习能力。类似的TA-VAAL也拓展了VAAL,TA-VAAL将来自VAAL的全局数据结构和来自学习损失的局部任务相关信息用于样本的查询。我们将ARAL,VAAL和TA-VAAL的框架展示在Fig6.

与ARAL和VAAL利用标记数据集与未标记数据集进行对抗表示学习不同,SSAL尝试了一种新的训练方式。SSAL跨AL周期的使用无监督、监督和半监督学习的方式,在尽可能不增加标注成本的情况下充分利用已有的信息进行训练。具体来说,在主动学习开始前,首先利用标记数据和未标记数据进行无监督预训练,在每个AL学习周期首先在标记数据集上进行监督训练,然后在所有数据集上进行半监督训练。这在训练方法上是一种新的尝试,并且作者发现与采样策略之间的差异相比,这种模型训练方式在性能提升上有着令人惊讶的提升。

正如上面说分析的那样,这种在训练方式和数据利用技巧上的探索也是非常有必要的,它在性能上的增益甚至可能超过改变查询策略所代来的性能增益。这实际上是在不增加标注代价的情况下对已有数据信息的充分利用,有助于缓解AL查询样本数量不足以支撑DL模型更新的问题。

通用框架DAL

如2.3中所述的,由于AL和DL在处理管道上的不一致,仅在AL框架中对DL模型进行微调或者简单的组合AL与DL将它们视为两个分割独立的问题可能会引起分歧。例如,A 首先将DL模型在两个不同类型的会话数据集上进行离线的监督训练以使骨干网络拥有基本的对话能力,然后启用在线AL阶段与人类用户进行互动,根据用户的反馈来以一种开放式的方法来改进模型。AL-DL为有DBNs的DL模型提出了一个主动标记方法。ADN为情感分类提出了一种主动深度网络架构。[23]为CAPTCHA的识别提出了一种使用CNN进行的主动学习算法 。然而,上述方法往往首先在标记数据集上对深度模型进行常规的监督训练,然后基于深度模型的输出进行主动采样。类似的相关工作还有很多,这种将AL和深度模型的训练视为两个独立问题的割裂化处理方式增加了两个问题产生分歧的可能。尽管这种方法在当时也取得了一定的成功,但一个将DL和AL两个任务紧密结合的通用框架对DAL的性能提升与推广都有着至关重要的作用。

CEAL将来自未标注数据集中的样本逐步送入到初始化后的CNN,由CNN分类器输出两种类别的样本:少量不确定性的样本和大量高预测置信度样本。通过orcal为少量不确定性样本进行标注,同时使用CNN分类器为大量的高预测置信度样本自动分配伪标签。然后,使用这两种类型的样本对CNN进行微调,并重复这个更新过程。

CEAL\cite{Wang2017CostEffectiveActive}是第一个结合AL与DL解决深度图像分类问题的工作之一。CEAL将深度卷积神经网络合并到AL中,提出了一个新颖的DAL框架。它通过将来自未标注数据集中的样本逐步送入CNN,由CNN分类器输出两种类别的样本:少量不确定性的样本和大量高预测置信度样本。通过orcal为少量不确定性样本进行标注,同时使用CNN分类器为大量的高预测置信度样本自动分配伪标签。然后,使用这两种类型的样本对CNN进行微调,并重复这个更新过程。在Fig2中,我们展示了CEAL的总体框架图。类似的,HDAL也采用了类似的框架用于人脸识别任务中,它将AL与深度CNN模型进行结合从而一体化的同时考虑特征学习和AL查询模型的训练。

此外,Fig1(c)中展示了一个非常常见的DAL任务的通用框架,相关的工作包括\cite{Yang2017Suggestive, Du2019BuildinganActivePalmprintRecognitionSystem,He2019Towards, Zhao2020Deeply, Lv2020Deep}等。具体的来讲,\cite{Yang2017Suggestive}提出使用全卷积网络和AL进行结合的框架来解决使用少量标注进行医学图像分割的问题。它首先将FCN在少量的标注数据集上进行训练,然后将未标注数据集中的样本通过FCN进行特征提取,并使用这些特征来对未标注样本进行不确定性和相似度估计。这种类似于2.1.2中的策略有助于选择具有高度不确定性和多样化的样本被添加到标注数据集中,从而开始下一阶段的训练。

\cite{Du2019BuildinganActivePalmprintRecognitionSystem}为掌纹识别任务提出了一个类似的DAL框架。不同的是,受到域适应的启发,\cite{Du2019BuildinganActivePalmprintRecognitionSystem}将AL视为一个二分类任务,期待标注样本集与未标注样本集拥有相同的数据分布并使得二者难以区分,这样就可以直接在少量的标注数据集上进行监督训练了,从而减轻标注负担。

\cite{Lv2020Deep}为缺陷检测提出了一个DAL框架。它根据检测模型输出的特征进行不确定性抽样以产生用于注释的候选样本列表。为了进一步兼顾采样样本中缺陷类别的多样性,\cite{Lv2020Deep}设计了平均边距的方法来控制每个缺陷类别的采样比例。以采样训练和选择样本的迭代模式来有效的训练检测模型。

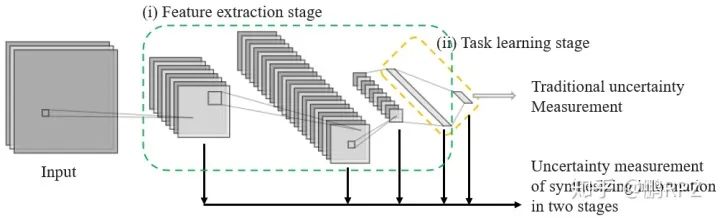

不同于以上方法往往只利用DL模型的最后输出的作为样本不确定性或多样性的判别依据(Active Palmprint Recognition\cite{Du2019BuildinganActivePalmprintRecognitionSystem}使用了第一个全连接层的输出),\cite{He2019Towards,Yoo2019LearningLossActive,Zhao2020Deeply}他们还使用了DL模型的中间隐藏层的输出。正如Section 3.1.3和Section 2.3中所分析的那样,由于深度模型与浅层模型之间学习范式的差异导致了传统的基于不确定性的查询策略无法直接应用于DL模型。此外,与浅层模型不同,深层模型可以被视为由特征提取阶段与任务学习阶段两部分组成。而仅仅使用DL模型最后一层的输出作为样本预测不确定性的评估依据是不准确的。因为DL模型的不确定性实际上是由特征提取和任务学习两个阶段的不确定性共同组成。这种思想的示意图被展示在Fig.4。

以常见的CNN为例,展示了传统不确定性测量方法与综合两个阶段(即,特征提取阶段与任务学习阶段)信息的不确定性测量方法的对比。

为此,AL-MV \cite{He2019Towards}将来自CNN中间不同隐藏层的特征视为多视图数据,同时考虑两个阶段的不确定性,并设计了AL-MV算法来实现对各层的不确定性进行自适应加权,从而更加准确的测量样本的不确定性。

LLAL也是用了类似的想法,LLAF设计了一个损耗预测模块的小型参数模块附加到目标网络,使用目标网络的多个隐藏层的输出作为损耗预测模块的输入。通过学习损耗预测模块来预测未标记数据集的目标损耗,并以top-k的策略选择查询样本。LLAL以较小的参数代价实现了与任务无关的AL框架设计,并在多种主流的视觉任务(即,图像分类、目标检测和人体姿态估计)上都取得了有竞争力的性能表现。

类似的\cite{Zhao2020Deeply}采用了相似的策略实现了一个手指骨骼分割任务的DAL框架。\cite{Zhao2020Deeply}将Deeply Supervised U-Net作为分割网络,然后将多级分割隐藏层的输出以及最后一层的输出作为AL的输入,综合这些输入信息作为样本信息量大小的评估依据。我们以LLAL为例在Fig6中展示这种想法的总体网络结构。

LLAL的总体框架图。黑色的线表示训练模型参数的阶段,优化由目标损失和损失预测损失构成的总体损失。红色的线表示AL的样本查询阶段。将DL模型的多个隐藏层的输出作为loss预测模块的输入,根据预测损失挑选top-K个未标记数据点通过oracle赋予标签。

通用框架的研究对DAL的发展和推广是非常有益处的,这种任务无关的框架可以更加方便的被移植到其他领域。当前的DL与AL之间融合还主要集中在DL主要负责特征提取,AL主要负责样本查询,因此更加深度紧密的融合有助于DAL取得更加优异的性能,当然这还需要研究人员更多的探索和努力。

DAL 的各种应用

如今,DAL已经被应用包括但不限于视觉数据处理(例如目标检测,语义分割等),NLP(例如情感分析,问答等),语音和音频处理 ,社交网络分析,医学图像处理,野生动物保护,工业机器人和灾害分析等领域。本节我们从应用的角度对DAL的相关工作进行一个系统详尽的概述。

Visual Data Processing

如同DL在计算机视觉领域被广泛应用一样,DAL的提出第一个被期待发挥潜力的领域就是计算机视觉。本节我们主要讨论DAL在视觉数据处理领域的研究。

图像分类与识别

与DL的研究类似,在DAL中图像的分类与识别是其他视觉任务研究的一个基础。如何在传统AL并不擅长的高维数据上高效的查询样本,并在尽可能小的标注代价下获得满足要求的性能是DAL在图像视觉任务领域所面临的一个重要的问题。

为了解决这个问题,CEAL为具有高置信度的样本分配伪标签,并将其添加到使用基于不确定性的AL方法查询到的高度不确定性的样本集中,使用扩充后的训练集一起训练DAL模型图像分类器。

\cite{Ranganathan2017Deep}首次将AL的准则集成到深度信念网络中,并对各种单模态和多模态的真实数据集上的分类任务进行了广泛的研究。

WI-DL使用DAL的方法在高光谱图像(HSI)数据集上同时考虑最大化代表性和不确定性两个选择标准来进行遥感分类。

类似的\cite{Lin2018Active,Deng2019Active}也研究了高光谱图像的分类问题。\cite{Lin2018Active}引入AL来初始化HSI,稍后进行转移学习,同时建议对源和目标HSI数据构造和连接更高级别的特征来进一步克服跨域差异问题。\cite{Deng2019Active}提出了一个统一的深度网络并结合主动转移学习,仅使用了较少的标签训练数据对HSI分类进行了良好的训练。

此外,医学图像分析也是一类重要的应用。例如,

\cite{Folmsbee2018Active}探索使用AL代替随机学习来训练卷积神经网络进行组织分类任务。

\cite{Budd2019Survey}在医学图像分析领域对相关的DAL方法进行了全面的回顾。

出于相似的原因,由于医学图像的标注需要很强的专业性知识,而训练有素的专家的时间通常很昂贵且非常的稀缺。此外,DL已经在各种图像特征任务上取得了令人印象深刻的表现,因此,集中于结合DL与AL将DAL应用于医学图像分析领域的工作仍然还有很多。

DAL方法也被用来进行浮游生物的分类任务\cite{Bochinski2018Deep},细胞的自动计数\cite{Alahmari2019Automatic}。

除此之外,DAL在我们的日常的生活场景中也有着广泛的应用。例如,\cite{Stark2015Captcha}提出了一种使用CNN进行验证码识别的AL算法。它可以利用免费获取标记数据的能力,来避免人为干预,在使用较少标记数据的情况化极大的提升识别精度。

HDAL \cite{Li2017Face}结合深度卷积神经网络优秀的特征提取能力与AL标记代价的节约为人脸识别任务设计了一个启发式的深度主动学习框架。

Object Detection and Semantic Segmentation

目标检测和语义分割在自动驾驶、医学图像处理、野生动物保护等各个领域都有着重要的应用价值。然而,这些领域都同样受限于较高的样本标注代价,DAL较小的标注代价有望加速相应DL模型的在一些标注较为困难现实领域的应用。

例如,\cite{Roy2018Deep}为目标检测设计了一个DAL框架,它将目标检测中使用的分层架构作为“委员会查询”的范例来选择要查询的图像集,同时引入了与A类似的勘探/开采权衡策略。

DAL也被广泛应用于自然生物领域和工业应用中,例如,

\cite{Norouzzadeh2019deep}利用深度神经网络来快速,可转移,自动地提取信息,同时结合转移学习和AL为相机陷阱图像中的物种识别和计数设计了一个DAL框架。

\cite{Feng2019Deep}为自动驾驶的深层对象检测提出了一个DAL框架来训练LiDAR 3D目标检测器。

\cite{Kellenberger2019Half}使用无人机(UAV)获取图像进行野生动物的检测。为了能到够重复使用这种动物检测器,\cite{Kellenberger2019Half}使用AL并引入转移抽样(TS)来找到源和目标数据集之间的对应区域,以便实现向目标域数据的转移。

\cite{Lv2020Deep}为真实工业的缺陷检测提出了一个非常常见的DAL框架,并提出了一种不确定性抽样的方法来生成候选标注类别。它使用平均裕度法来设置每个缺陷类别的抽样尺度,在使用较少标注数据的情况下就能获得了所需的性能。

此外,DAL在医学图像分割上也有着重要的应用。例如,

\cite{Gaur2016Membrane}为医学图像分割提出了一种基于AL的转移学习机制,使得该方法可以在有限的标记数据集上有效的提高图像的分割性能。

\cite{Yang2017Suggestive}将完全卷积网络(FCN)与AL相结合为生物图像分割提出了一种DAL框架。它利用FCN提供的不确定性和相似性信息给出了最大集合覆盖问题的一个拓展,通过指出最有效的标注区域来显著减少标注工作量。

DASL \cite{Wang2018Deepa}为肺结节分割任务提出了基于深层区域的网络结节R-CNN来为实例生成分割掩码,同时结合AL和自定步长学习(SPL)提出了一种新的深度主动自定步长(DASL)策略来减少标注工作量。

\cite{Wang2019Nodule}为三维胸部CT图像中的肺结节检测与分割提出了一个基于区域的网络Nodule-plus Region-based CNN。Nodule-plus Region-based CNN将AL和自定进度学习(SPL)策略相结合,提出了一种新的深度自定步长主动学习(DSAL)策略从而减小了注释工作量且有效的利用了未标注数据。

\cite{Zhao2020Deeply}为手指骨骼分割任务提出了一种新的深度监督主动学习方法,该方法可以以一种迭代和增量学习的方式进行微调,并且使用了中间隐藏层的输出作为AL样本挑选的依据。与完整的额标注相比,\cite{Zhao2020Deeply}仅使用了较少的样本就获得了与之相当的分割结果。

Video processing

相对于图像,视频任务除了要处理空间特征,还需要处理时间特征,因此视频任务的标注工作代价更昂贵,引入AL的期待也更为迫切。DAL在该领域也有着更加广阔的应用场景。

例如,\cite{Hussein2016Deep}提出使用模仿学习的方法执行导航任务。教师在第一人称视角下的可视化环境和所采取的动作被作为训练集。通过训练,希望学生能够根据所处的环境预测执行相应的动作。当执行任务时,学生使用深度卷积神经网络进行特征提取,学习模仿策略,并使用AL的方法选择信心不足的样本添加到训练集中,来更新行动策略。\cite{Hussein2016Deep}使用了较少的样本显著改善了初始策略。

DeActive \cite{Hossain2018DeActive}提出了一种DAL的活动识别模型,DeActive与用于活动识别的传统DL模型相比需要更少的标注样本,消耗更少的资源,且具有高的识别精度。

\cite{Wang2018Deep}通过将AL集成到DL框架中来最大限度的降低基于视频的person-Re-ID数据集的标注代价。类似的,\cite{Liu2019Deep}为person Re-ID任务提出一种深度强化主动学习方法,以过oracle的反馈来指导代理(强化学习过程中的模型)进行下一步的不确定性样本的选择,通过交替细化的强化学习策略来不断优化代理的选择机制。

\cite{Aghdam2019Active}为视频和静态图像的行人目标检测提出了一种基于卷积神经网络的主动检测目标检测器的方法。

Natural Language Processing

NLP一直以来都是一个非常具有挑战性的任务。NLP旨在使计算机理解复杂的人类语言,帮助人类处理各种与自然语言相关的任务。数据标签不足也是NLP任务所面临的一个关键性的挑战。下面我们介绍一些NLP领域最著名的DAL方法。

Sentiment Analysis

Active Deep Networks for Semi-Supervised Sentiment Classification | 2015

它是NLP中的一个 典型任务,旨在使得计算机理解一段自然语言描述,并对其中的涵义信息进行提取分析。

相关的应用场景非常的丰富,包括但不限于情感分类、新闻鉴别、命名实体识别(NER)等。

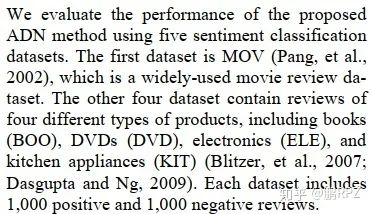

更为具体的,例如,\cite{Zhou2010Active}使用Restricted Boltzmann Machines (RBM) 构造了一个主动深度网络(ADN),并在标记数据集与无标记数据集上进行无监督训练。ADN使用大量的未标记数据集提升模型的泛化能力,并在半监督学习框架中使用AL,将标记数据的选择与分类器统一在了一个半监督分类框架中,在情感分类任务上获得了有竞争力的结果。

\cite{Bhattacharjee2017Active}在只有有限数量的注释样本的情况下为新闻准确性检测任务(即识别新闻中的误导和虚假信息)提出了一个人机协同学习系统。该系统是基于AL的深度模型,使用了比完全监督学习少1-2个数量级的注释样本,大大加快了模型的收敛速度,且在检测性能上实现了惊人的25%的平均性能增益。

\cite{Shen2017DeepActiveLearning,Shardlow2019text}使用DL与AL进行结合研究了在较小训练集的情况下如何提高命名实体识别(NER)的技术水平。

\cite{Priya2019Identifying}使用来自受灾地区的相关推文来提取信息以便进行地震期间基础设施损坏的识别,为此,\cite{Priya2019Identifying}将基于RNN和GRU的模型与AL相结合,使用基于AL的方法预训练模型来检索来自不同地区基础设施损坏的推文,从而显著减少手动标注的工作量。

实体解析(ER)是跨数据库识别具有不同表示形式相同真实实体的任务,是知识库创建和文本挖掘的关键步骤。\cite{Kasai2019Low}为ER开发了一个基于DL的方法,它结合了转移学习和AL设计了一个体系结构,它允许学习一个从高资源环境到低资源环境的可移植模型。

数据集

问答、摘要

问答系统、自动摘要也是NLP中常见的处理任务。DL已经在这些领域取得了令人印象深刻的结果。然而,这些应用的性能仍然依赖于海量的标记数据集,AL有望为这个挑战带来新的希望。

自动问答系统在工业界有着非常广泛的应用,DAL在该领域也有着重要的研究价值。例如,\cite{Asghar2016Deep}使用在线的AL策略结合DL模型,通过与真实用户进行交互,在每一轮对话中以一种增量的方式从用户的反馈中进行学习来实现开放式的对话。

\cite{Jedoui2019Deep}发现为特定任务(例如,分类)设计的AL策略往往只有一个正确答案,这些基于不确定性的测量往往根据模型的输出计算。而许多现实世界的视觉任务往往有多个正确答案,导致不确定性测量被高估,有时的表现甚至比随机抽样基线更差。为此,\cite{Jedoui2019Deep}在可视化问题答案生成(VQA)中提出估计模型内部隐含空间中的不确定性,而不是模型输出空间中的不确定性,从而克服了语言的释义性质。

自动摘要旨在从大文本中提取有用的最为重要的信息。\cite{Maldonado2019Active}为识别大型脑电波图(EEG)报告中的概念和关系提出了一种新颖的主动学习策略神经网络(ALPNN),可以帮助人类从大量的EEG报告中提取可用的临床知识。

在语音和音频领域的标签注释成本也相对较高。\cite{Abdelwahab2019Active}发现在由少量演讲者收集的数千个录音所构成的语料库上训练的模型无法推广到新的域。因此\cite{Abdelwahab2019Active}研究了利用AL在标记资源有限的情况下训练深度神经网络进行语音情感识别任务实用方案。

其他应用

深度主动学习的出现是令人兴奋的,有望在保持性能的情况下,成数量级的减少标注代价。为此,DAL也被广泛的应用于其他领域。

这些应用包括但不限于基因表达、机器人、可穿戴设备数据分析、社交网络和心电信号分析等。

更为具体的,例如,MLFS \cite{Ibrahim2014Multi} 将DL和AL进行结合为基于表达谱的选择基因/miRNA提出了一个新颖的多层次特征选择方法。MLFS还考虑了miRNA与基因之间的生物学关系,将该方法应用于miRNA的拓展任务上。

真实世界的机器人的故障风险是昂贵的。为此,\cite{Andersson2017Deep}提出了一种风险感知重采样技术。将AL与现有的求解器和DL一起使用来对机器人的运行轨迹进行优化以便有效应对移动障碍物场景下的碰撞问题,并在真正的纳米四轴飞行器上验证了该DAL方法的有效性。

\cite{Zhou2019Active}为机器人控制算法逆动力学模型提出了一个主动轨迹生成框架,这允许\cite{Zhou2019Active}系统地设计用于训练DNN逆动力学模块的信息轨迹。

\cite{Hossain2019Active, Gudur2019Activeharnet}利用可穿戴设备或移动终端上的传感器来收集用户的运动信息,来进行人类活动识别。\cite{Hossain2019Active}提出了一种有上下文感知注释器选择的活动识别DAL框架。ActiveHARNet \cite{Gudur2019Activeharnet}提出了一种资源高效的深度集成模型ActiveHARNet,它支持设备上的增量学习和推理,使用BNN中的近似来表示模型的不确定性能力,并在两个公开数据集上证明了ActiveHARNet部署和增量学习的可行性。

DALAUP \cite{Cheng2019Deep}为社交网络中的锚点用户预测设计一个DAL框架来减少锚点用户的标注成本,同时提高预测准确性。

DAL也被应用于心电信号的分类。例如, \cite{Rahhal2016Deep} 提出了一种基于深度学习的心电信号主动分类方法。\cite{Hanbay2019Deep} 提出了一种使用特征值和DL基于AL的ECG分类方法。通过使用AL方法来有效的减少医学专家标记ECG信号的代价。

总的来说,DAL目前的应用主要集中在视觉图像处理任务中,对NLP和其他领域也有着相对零散的应用。和DL与AL相比,DAL目前仍然处于研究的初级阶段,相应经典作品还相对较少,但仍然有着和DL一样广阔的应用场景和实用价值。

讨论与未来方向

Towards Robust and Reproducible Active Learning Using Neural Networks,对DAL的工作提出了大量的建议。

DAL结合了DL和AL的共同优势,不仅继承了DL善于处理高维图像数据和自动特征提取的能力,而且继承了AL有效降低标注代价的潜力。因此,DAL尤其是在标签需要很高专业知识难以获得领域有着令人着迷的潜力。

最近的大多数工作显示DAL已经在许多常见的任务上获得了成功。DAL凭借降低标注代价以及继承DL强大的特征提取能力引了大量研究人员的兴趣,正如\cite{Munjal2020Towards}所发现的那样,在不同的研究中关于随机采样基线(RSB)的报告结果有着很大不同。例如,在相同设置下,使用CIFAR 10的20%的标签数据,\cite{Yoo2019LearningLossActive}所报告的RSB性能比\cite{Tran2019BayesianGenerativeActive}高13%。其次,同一DAL方法在不同的研究中报告的结果可能有所不同。例如,使用CIFAR 100的40%的标签数据和VGG16作为提取网络,\cite{Sener2018ActiveLearningConvolutional}和\cite{sinha2019variational}的报告结果相差8%。此外,最新的DAL研究也存在彼此不一致的情况。例如,\cite{Sener2018ActiveLearningConvolutional}和\cite{Ducoffe2018Adversarial}指出基于多样性的方法一直优于基于不确定性的方法,而基于不确定性的方法比RSB更差。但是,\cite{Yoo2019LearningLossActive}的最新研究表明并非如此。

与AL有策略的选择高价值的样本相比,RSB已经被是一个强有力的基线。以上问题说明,我们首先急需为DAL的工作设计一个通用的性能评估平台,并确定一个统一的高性能的RSB。其次,不同的DAL的方法的可复现性也是一个重要的问题,高度可复现的DAL方法有助于对不同DAL进行性能评估,应在一致的设置下使用通用的评估平台进行实验,并共享实验设置快照。别外,相同实验条件下的不同初始化的多次重复性实验是被要求的,这可以有效避免因实验设置问题所引起的误导性结论。那些互相不一致的研究需要引起研究人员足够的重视,以便弄清其中原理。另一方面,充足的消融实验和转移实验也是必须的,前者可以让我们更容易看清是哪些改进带来了性能增益,后者可以确保我们的AL选择策略的确可以对数据集无差别的选择高质量样本。

目前的DAL方法的研究方向主要集中在AL选择策略的改进,训练方法的优化以及任务无关的模型改进。

正如Section2所分析的那样,AL选择策略的改进目前主要集中在以显式或者隐式的方式将基于不确定性和多样性的查询策略考虑在内。并且混合型的选择策略越来越受到研究人员的青睐。

训练方法的优化主要集中在对未标记数据集,标记数据集或者使用GAN等方法扩充数据,然后跨AL周期的进行无监督学习、半监督学习、监督学习的混合型训练方法。这种训练方法甚至表现出比选择策略改进更有前途的性能提升,实际上这弥补了DL模型需要大量标注训练样本而AL选择标注样本的数量有限的问题。此外,对无标记数据集或者生成数据集的使用也有利于充分利用已有的信息,而并不增加额外的标注代价。此外,增量训练的方式也是一个重要的研究方向,在每次循环中从头开始训练深度模型在计算资源上是不可接受的。而简单的增量训练又会导致模型参数的偏差问题,但是在资源节省上的巨大诱惑是相当吸引人的。然而,相关的研究仍然是相当匮乏的,但这仍然是一个非常有前景的研究方向。

任务无关也是一个重要的研究方向,这有助于使得DAL的模型可以更加直接广泛的被推广到其他任务。然而相关的研究还是不足的,并且相应的DAL方法往往只关注了基于不确定性的选择方法。由于DL自身更加容易与基于不确定性的AL选择策略相融合,因此我们相信在与任务无关的研究方向上未来基于不确定性的方法还将继续占据主导地位。另一方面,明确显式的将基于多样性的选择策略考虑在内或许也是一个不错的选择,当然,这也面临着很大的挑战。

此外,需要指出的是一味的追求在更小的子集上训练模型的想法是不可取的,因为在一些内容丰富类别多样拥有海量样本的数据集中样本重要性的相对差异几乎可以被忽略。

显然上述的这些改进方向之间并不冲突,因此一种混合的改进策略是未来一个重要的发展方向。

总的来说,DAL的研究在标注代价和应用场景上都有着巨大的实际应用价值,但当前的DAL的研究仍然处于初级阶段,未来还有很长一段路要走。

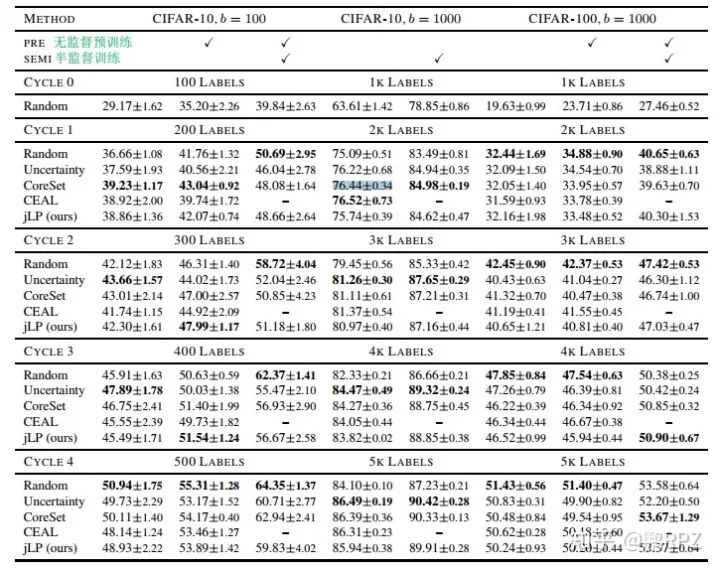

Performance Comparison

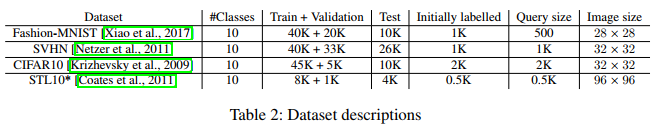

在本节,我们将对DAL相关算法的性能做一个全面系统的评估与讨论。

Deep Active Learning: Unified and Principled Method for Query and Training

Rethinking deep active learning: Using unlabeled data at model training

Training Data Distribution Search with Ensemble Active Learning

TOWARDS BETTER UNCERTAINTY SAMPLING: ACTIVE LEARNING WITH MULTIPLE

Bayesian Generative Active Deep Learning

推荐阅读