刷新视频超分新记录28.41dB!同时利用过去和未来隐状态的全局视频超分方案OVSR

极市导读

本文是武汉大学&哈尔滨工业大学&武汉理工在视频超分领域的一次突破性的成果。在深入分析多帧超分、递归超分以及混合框架超分存在的问题之后,本文创造性的提出了同时利用过去和未来隐状态的全局视频超分方案OVSR。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

paper:https://arxiv.org/abs/2103.15683

本文是武汉大学&哈尔滨工业大学&武汉理工在视频超分领域的一次突破性的成果。在深入分析多帧超分、递归超分以及混合框架超分存在的问题之后,本文创造性的提出了同时利用过去和未来隐状态的全局视频超分方案OVSR。受益于OVSR的全局信息特性,所提方法在几个公开数据集上取得了超越以往模型的性能,刷新了Vid4、UDM100的指标,达到了前所未有的28.41dB的性能。

Abstract

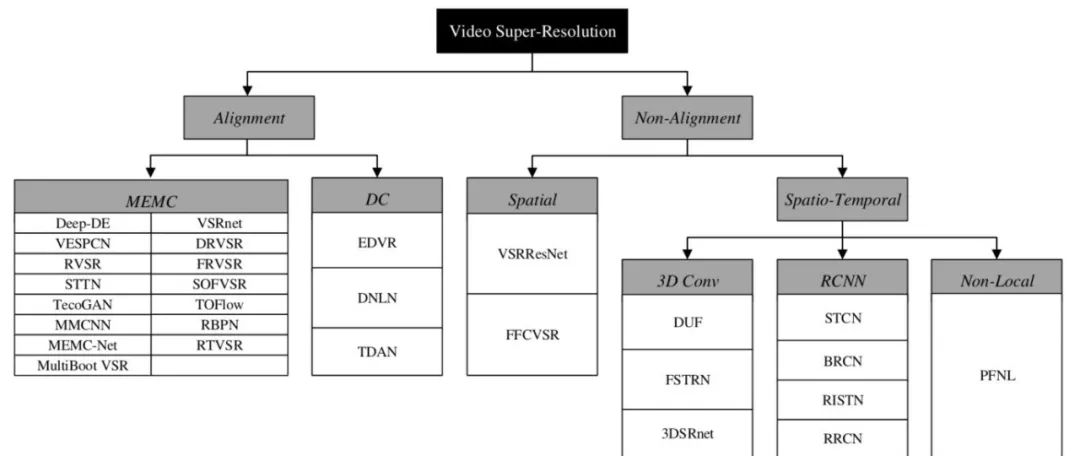

现有视频超分主要有这样两种流派:(1) 采用滑动窗口+多帧方式对低分辨率图像进行超分,这其中当以EDVR为其中佼佼者;(2) 采用递归方式,即利用前一帧超分结果辅助当前帧的超分重建,这其中代表性的工作有FRVSR、RRN、RSDN等。也有一些工作尝试将两者进行组合构建一个混合框架,但未能充分发挥两者各自的优势,这方面的工作有FFCVSR、BasicVSR(但作者并未提到这个工作)。

本文提出一种全能(Omniscient)框架,它不仅利用了前一帧的超分结果,同时利用了当前帧与后一帧的超分结果。该框架是一种更广义的框架,像多帧超分、递归超分以及混合框架均为其特例,所提框架具有更好的表现性能。

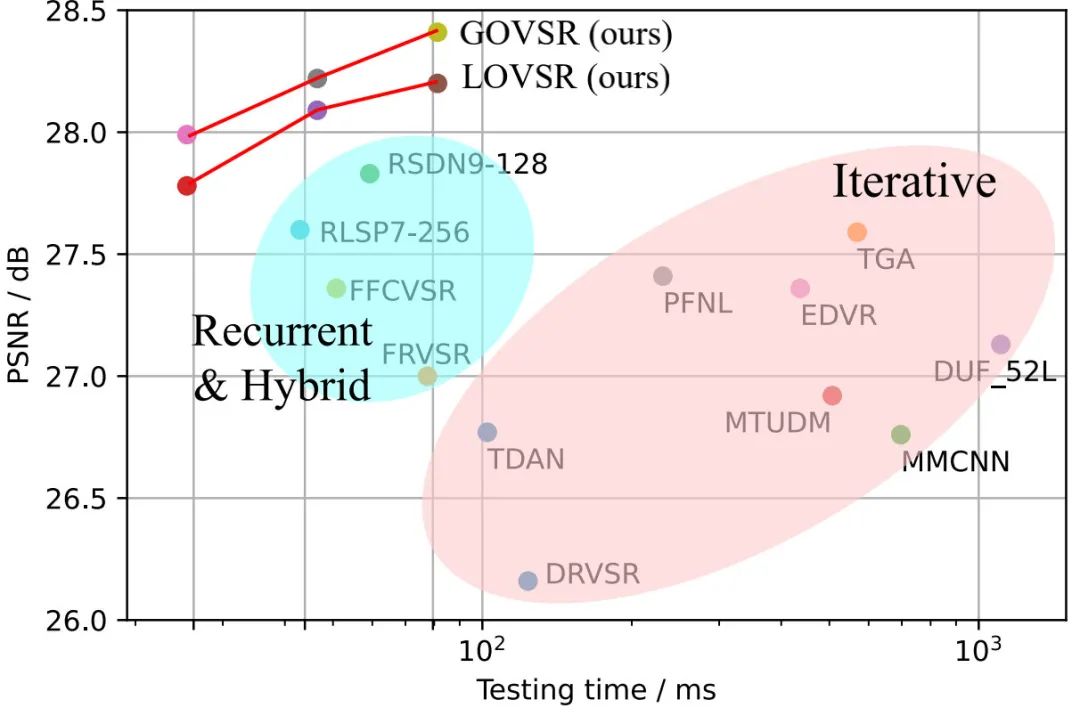

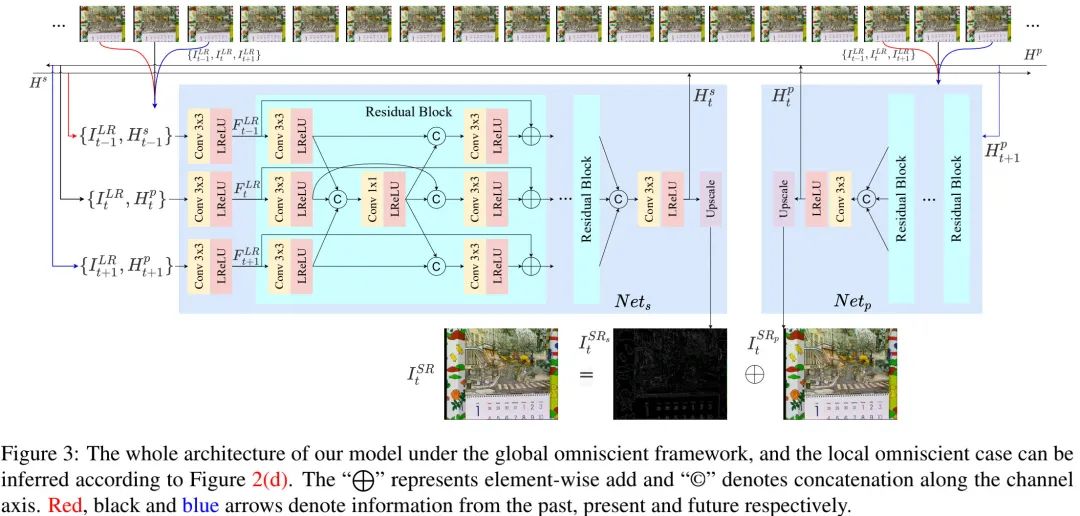

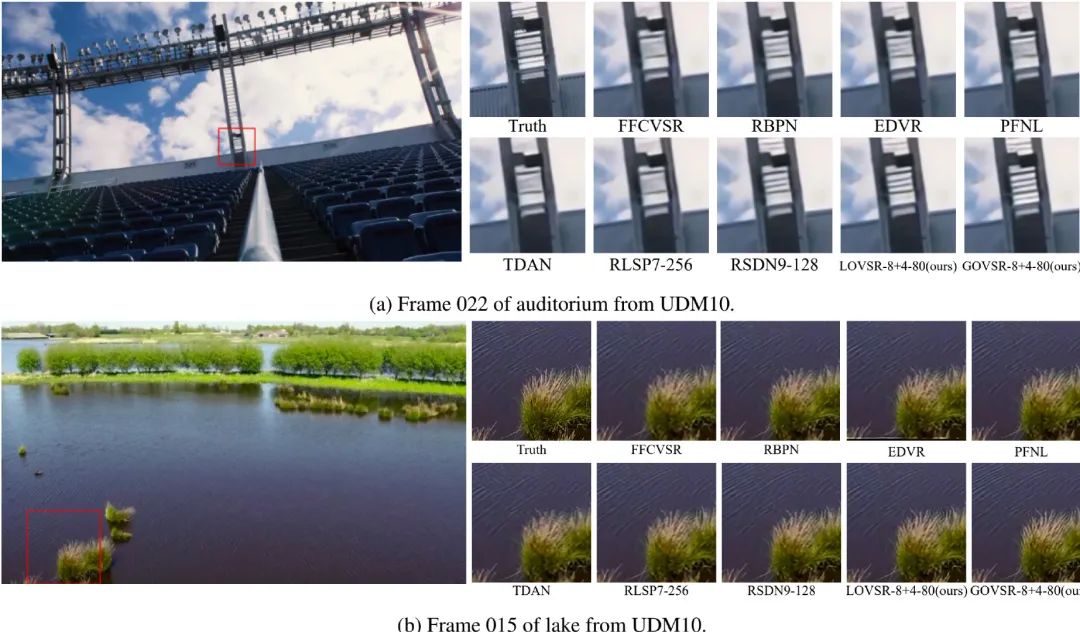

最后,我们在公开数据集上进行了对比分析:从客观与主观评价以及计算复杂度等方面,所提方法均取得了优于其他SOTA方法的性能,Vid4上的性能对比见上图。

Introduction

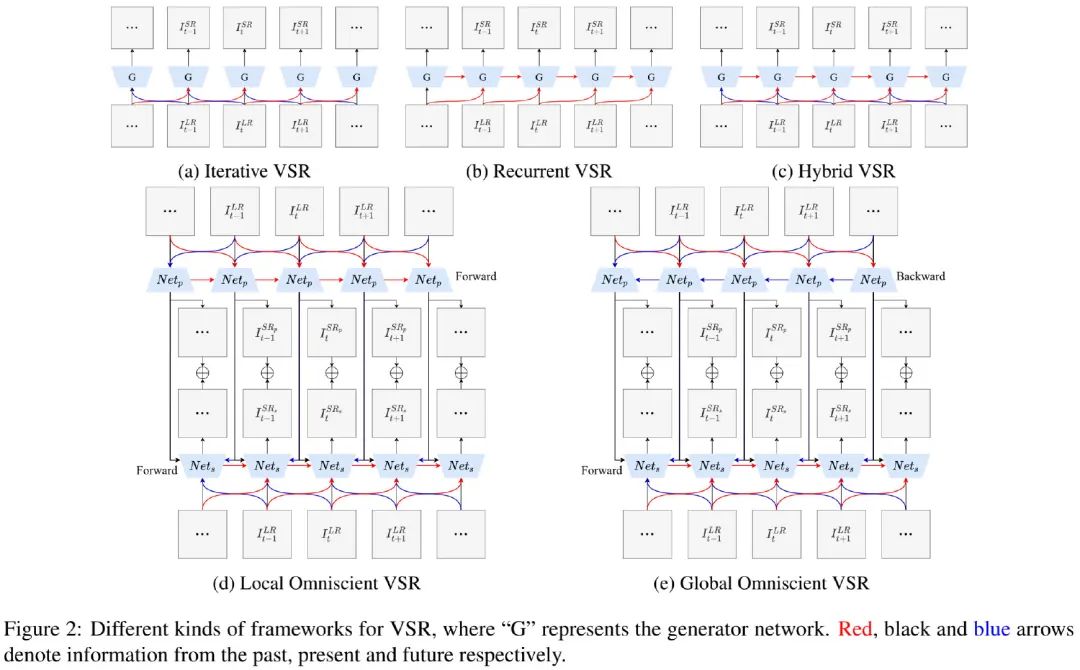

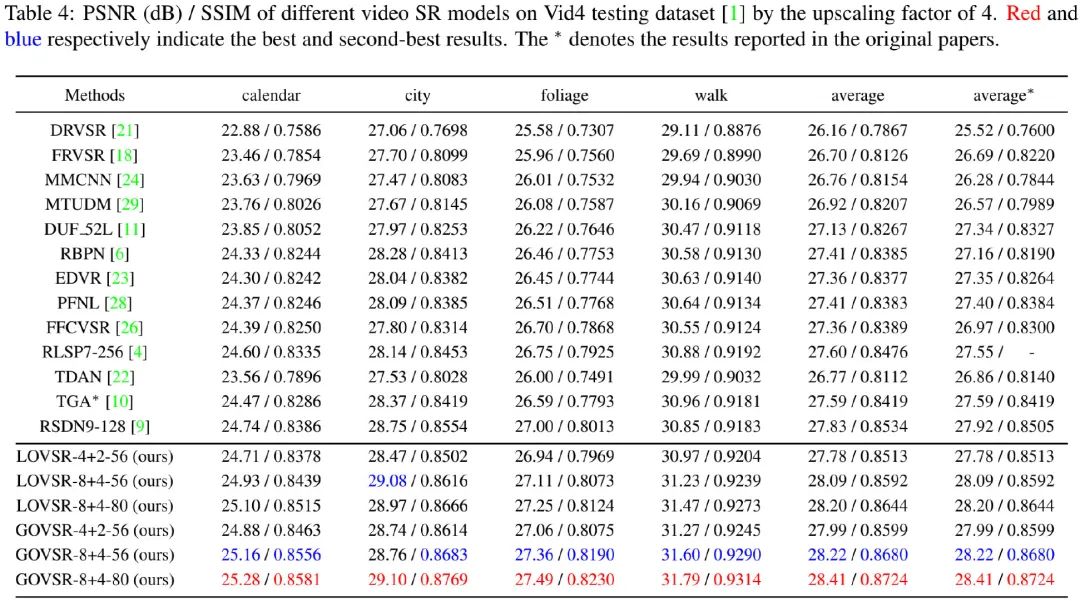

上图给出了滑动窗口+多帧超分(见上图a)、递归超分(见上图b)、混合框架超分(见上图c)以及本文所提LOVSR(见上图d)与GOVSR(见上图e)的示意图。在正式介绍本文所提OVSR之前,我们先来看一下已有方法的弊端所在。

滑动窗口+多帧超分:这其中知名的方法有VSR-DUF、VSR-TGA、TDAN、EDVR、TOFlow、MMCNN、PFNL等,这些方法采用动态卷积、形变卷积、光流、非局部等思想进行时序对齐。理论上,这些方法打破了时序相关性,可以同时采用多个线程进行图像重建。然而,受限于多帧输入(比如3帧、5帧、7帧等),这种方法仅仅能利用近邻帧信息,而忽视了前一超分结果,阻碍了这类方法的性能进一步提升。 递归超分:这其中知名的方法有FRVSR、RRN、RSDN等。它们采用递归的方式从前往后依次处理,在处理当前帧时会利用前一帧的超分结果进行辅助。受限于先天机制,它无法利用后续的帧信息,阻碍了其性能提升。 混合框架:这方面的方法有RLSP、FFCVSR等。它仅仅利用了历史信息的隐状态,并未取得令人满意的效果。

基于上述分析,我们尝试“同时利用历史与未来隐状态信息进行当前帧超分重建”,即前面图中的d和e。接下来,我们将针对所提方案进行更详细的介绍。

Method

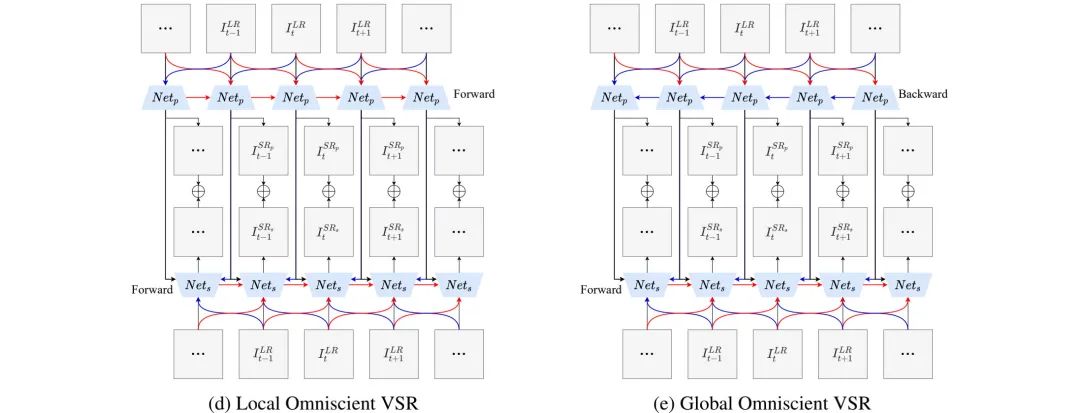

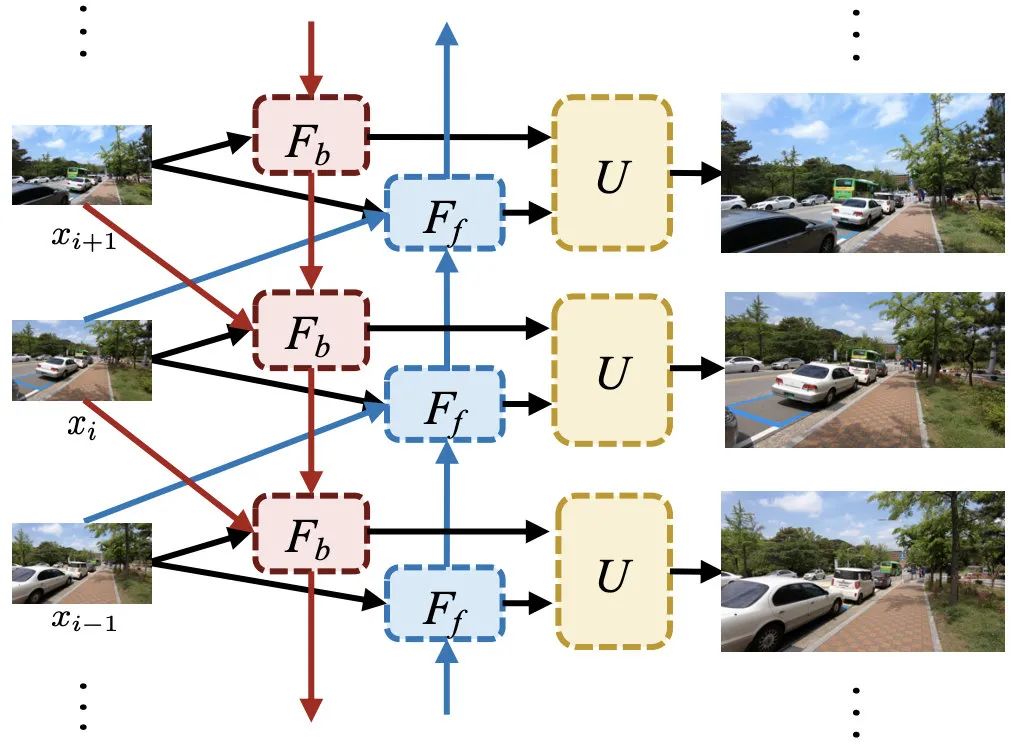

上图给出了本文所设计的OVSR示意图,它同时借鉴了多帧超分与递归超分的思想。理论上,近邻帧可以提供LR空间最基本的空时信息,而估计的SR输出可以在HR空间提供更多的时序相关性。很自然的一种想法就是组合两者以充分探索空时相关性。

这就促使我们提出了上图的OVSR,我们设计了两个子网络:前置网络与后置网络。首先,前置网络对所有LR图像进行处理以输出SR结果和隐状态;然后,后置网络在前述信息的辅助下对所有LR进行超分重建。更进一步,我们将两者生成的SR结果相加得到最终的SR结果。

按照前置网络与后置网络的处理方向,OVSR可以进一步划分为LOVSR(Local Omniscient VSR)与GOVSR(Global Omniscient VSR)。当与的处理方向相同时,这意味OVSR仅能利用当前隐历史信息,以及非常有限的未来信息(比如1-2帧),我们将这种方案定义为LOVSR;我们通过逆转的处理方向定义GOVSR,也就是说GOVSR可以同时利用序列中的所有LR图像进行超分重建。一句话概括:LOVSR适合于在线视频超分,而GOVSR适合于离线视频超分。

值得一提的是:上述所提OVSR并不依赖于特定生成器架构,任意类型的生成器均可嵌入到上述结构中。

Network Design

接下来,我们将OVSR进行具象化:将PFNL嵌入到上述框架中,见上图。上图为GOVSR示意图,LOVSR类似可以推断出来。由于前置网络与后置网络具有相似的结构,故而我们仅仅对后置网络进行相似介绍。

我们对PFNL中的PFRB进行调整,使得具有三个分支以覆盖过去、现在和将来(想到了小崔的小品了,哈哈)。处理流程如下:

首先,我们采用一个卷积层对LR图像与隐状态进行融合得到; 然后,三个分支信息采用残差分支分别处理后再进行合并,通过这种方法对空间相关性、时序相关性进行充分探索; 其次,三个分支的特征拼接后并由一个卷积处理得到隐状态; 最后,隐状态上采样得到并与前置网络的输出相加得到超分结果。

前置网络与后置网络可以定义为如下形式:

最终的SR结果由两者的SR结果相加得到:

由于是对的继承,我们自然的约束用于进行低频结构的重建,而用于高频细节重建。故而损失函数定义如下:

最后用一句话来总结:OVSR对过去、现在以及未来的LR图像、隐状态等所包含的空时相关性进行了充分探索。

Experiments

在训练数据方面,我们采用了MM522进行训练,验证集为Vid4和UDM100;同时还采用Vimeo90K进行了训练,但仅在Vimeo90K-T上进行了验证。数据的退化方式为高斯模糊。

上表给出了Vid4数据集上的性能对比,所提方案GOVSR-8+4-80取得了前所未有的28.41dB;GOVSR最轻量版仍取得了优于其他方案的性能27.99dB;LOVSR取得了比GOVSR稍差的性能,但仍比其他方案更优。

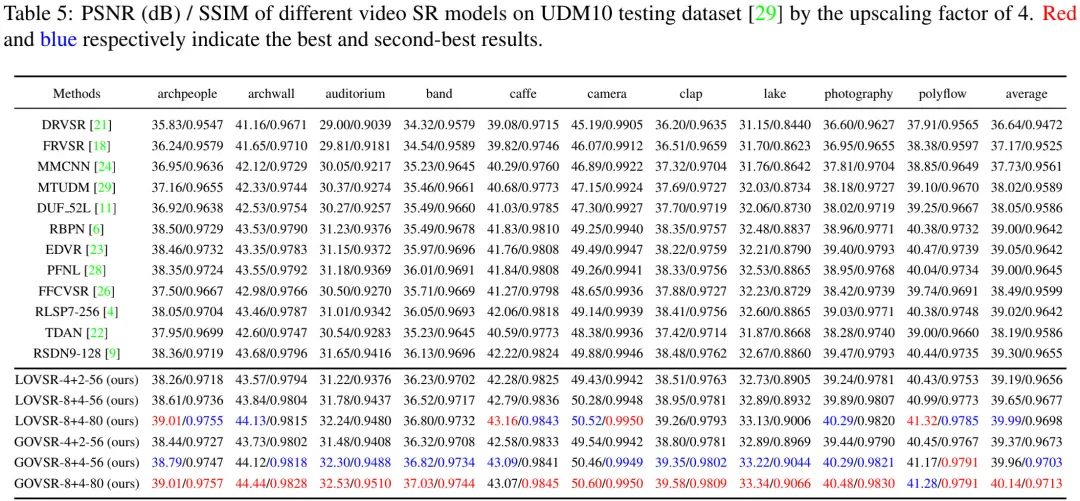

上表给出了UDM100数据集上的性能对比,GOVSR-8+4-80取得了前所未有的40.14dB指标;LOVSR同样取得了非常优异且超出其他方案的指标39.99dB。

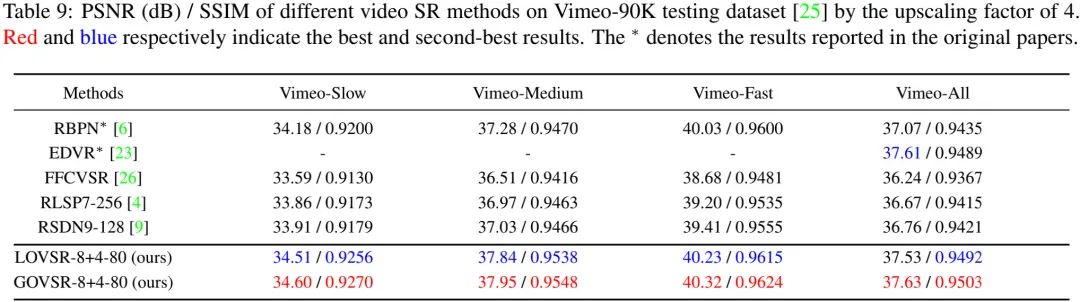

上表给出了Vimeo90K数据集上的性能对比,GOVSR-8+4-80取得了37.63dB(低于BasicVSR的38.84dB),相比RSDN,指标提升近0.9dB。

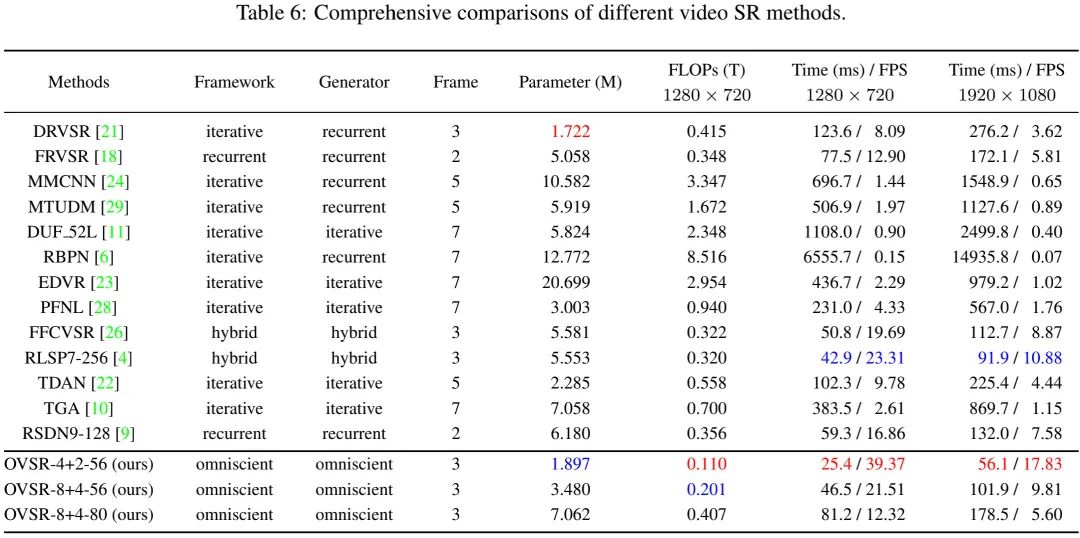

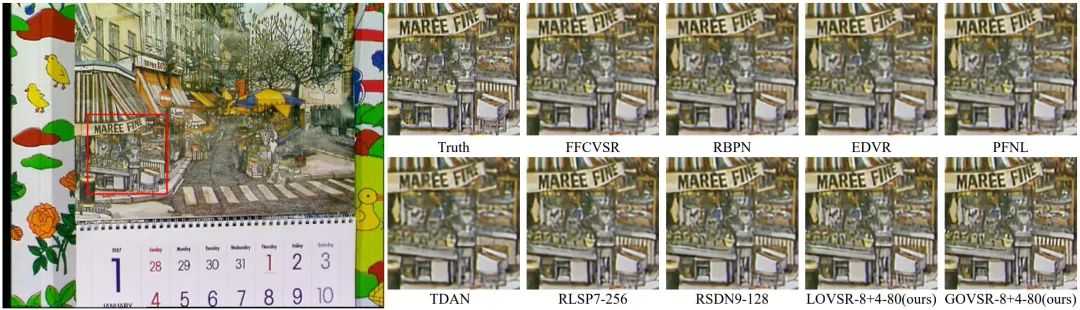

上表从方案类型、帧数、参数量、计算量、推理耗时等各个维度进行了对比分析。本文所提轻量型OVSR-8+2-56取得了最快的推理速度:720p实时;中等模型OVSR-8+4-56在指标上超越其他方案的同时具有更快的推理速度;重度模型OVSR-8+4-80牺牲了推理速度得到了最佳的指标,视觉效果可参见下图。

题外话

美中不足之处,本文并未与BasicVSR一文进行对比与分析。因为两者在处理思路上真的是非常的相似。下图给出了BasicVSR的示意图,两者在大方向上是相似的:利用过去、现在以及未来的信息对当前帧进行重建;两者都采用两个子网络按照两个方向进行处理。在更具体的实现上,两者采用了完全不同的思路:OVSR采用非局部思想+多帧思路进行处理;而BasicVSR则采用了光流对齐进行时序相关性建模。两者在性能上均取得了大幅超越以往模型的性能。两者还有一个共同之处:都尚未开源,哈哈。

推荐阅读

2021-01-04

2021-03-11

# 极市原创作者激励计划 #