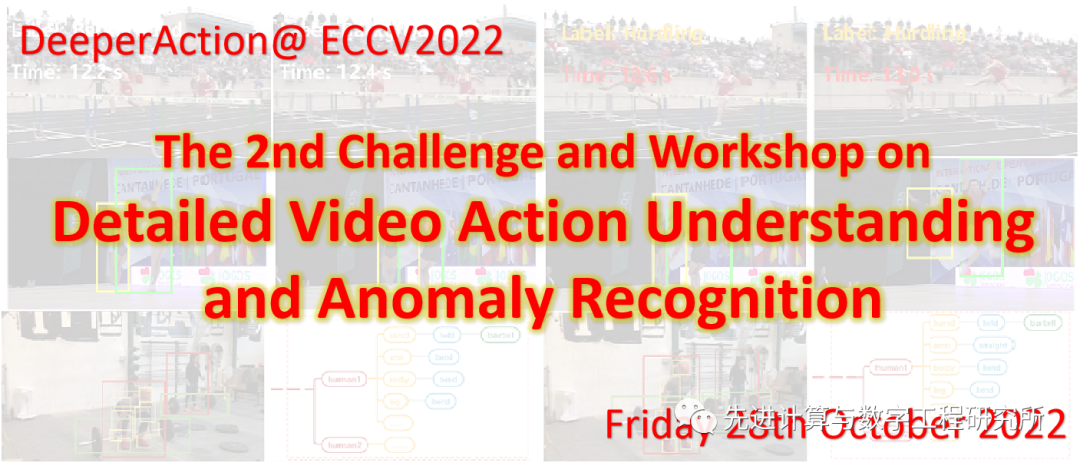

第二届精细视频理解挑战赛(DeeperAction):聚焦行为识别和异常检测

由南京大学、中国科学院深圳先进技术研究院、商汤科技、上海人工智能实验室联合举办的第二届精细视频理解挑战赛(DeeperAction)明日开启,快来挑战吧!

由南京大学、中国科学院深圳先进技术研究院、商汤科技、上海人工智能实验室联合举办的第二届精细视频理解挑战赛(DeeperAction)明日开启,快来挑战吧!

本次ECCV 2022的DeeperAction挑战赛旨在推动人类动作理解领域研究从传统的动作识别转向更深入的动作理解任务,本次挑战赛任务关注视频动作的详细理解和真实视频的异常识别。

具体来说,组织者提出了五个基于不同任务下的具有高质量标注的视频数据集,并在此基础上组织了针对动作理解和异常识别任务的五个赛道的挑战赛,欢迎大家踊跃参赛!

挑战赛主页:https://deeperaction.github.io/

重要日程

组织单位

Track 1:FineAction挑战赛:时序动作定位

FineAction数据集视频样例

论文链接:https://arxiv.org/abs/2105.11107

数据集主页:https://deeperaction.github.io/datasets/fineaction.html

赛道简介:https://codalab.lisn.upsaclay.fr/competitions/4386

当前,大部分动作定位数据集仅对行为进行粗略定义,如ActivityNet中的篮球训练(Layup drill in basketball)并未被拆分成扣篮或投篮这样更为精细的动作类别。

然而,粗糙的动作类别往往与上下文背景高度相似,造成标注动作的时序界限不清晰。

为了填补这一空缺,组织者提出了FineAction这一新基准,包含近 17K 个未修剪视频,139K个精细动作时序标注,为 106 个动作类别进行了更明确的动作类别定义和更精确的时序标注。该数据集的构建,为精细化时序动作定位的研究带来新的挑战与机遇。

Track 2:MultiSports挑战赛:时空动作检测

MultiSports数据集视频样例

论文链接:https://arxiv.org/abs/2105.07404

数据集主页:https://deeperaction.github.io/datasets/multisports.html

赛道简介:https://codalab.lisn.upsaclay.fr/competitions/3736

当前时空动作检测基准主要分为两类:一类是以J-HMBD和UCF101-24为代表的稠密标注的高度抽象动作数据集,这些数据集中往往是单人重复一些简单动作;

另一类是以AVA和DALY为代表的稀疏标注的数据集,这些数据集中的动作缺少明确的边界,对于建模快速动作来说不太合适。

为了推动时空动作检测研究,组织者提出了MultiSports这一新基准。这一数据集有着25fps稠密标注,且数据集规模大,有大量多人同时运动场景和明确的动作界限,部分动作(如足球的“pass”和“long ball”)需要较长的时序背景才能进行区分,这也对时空动作检测模型提出了更高的要求。

Track 3:SportsMOT挑战赛:运动场景中的多目标跟踪

SportsMOT数据集视频样例

数据集主页:https://deeperaction.github.io/datasets/sportsmot.html

赛道简介:https://codalab.lisn.upsaclay.fr/competitions/4433

多目标跟踪(MOT)是计算机视觉中的一项基本任务,目的是估计视频序列中的目标(如行人和车辆)边界框和身份。

目前的人体跟踪MOT数据集主要关注拥挤街道场景中的行人(如MOT17/20)或静态场景中的舞者(DanceTrack)。而真实的运动场景中往往存在背景图像复杂、运动员运动迅速、相机镜头快速移动等情况,现有的MOT数据集缺少这类数据,无法应对日益剧增的运动分析要求。

为此,我们提出了一个大规模多目标跟踪数据集SportsMOT,它由3个类别(即篮球、足球和排球)的240个视频片段组成。目标是在各种运动场景中跟踪场上的球员(不跟踪观众、裁判和教练等)。我们希望SportsMOT能鼓励社区更多地关注复杂的体育场景。

Track 4:Kinetics-TPS挑战赛:基于人体部位中层语义的视频行为解析

Kinetics-TPS数据集视频样例

数据集主页:https://deeperaction.github.io/datasets/kineticstps.html

赛道简介:https://codalab.lisn.upsaclay.fr/competitions/4392

传统的动作识别往往被视为高层语义的视频分类任务(例如:Kinetics400,ActivityNet等),然而这些视频数据集忽视了对人类行为动作的细节以及中层语义信息的理解。

为了填补这一空缺,我们提出了Kinetics-TPS这一全新数据集。

与现有数据集不同,本数据集(共24 个人类行为类别)提供了视频帧级别的身体部位标注,包括身体10个部位的7.9M个标注,7.9M个部位状态(即身体部位如何移动),以及0.5M个交互物体,这为更为细致的视频行为理解提供可能。

Track 5:UrbanPipe挑战赛:细粒度管道视频异常识别

UrbanPipe数据集视频样例

数据集主页:https://deeperaction.github.io/datasets/urbanpipe.html

赛道简介:https://codalab.lisn.upsaclay.fr/competitions/4439

视频异常分析在工业应用中有广泛需求,尤其在城市管道系统中。城市管道作为城市的重要基础设施之一,为保证其正常运行,我们需要对管道缺陷进行智能检测和定位。

在本次挑战赛中,我们重点关注面向复杂城市管道视频的细粒度和多标签缺陷识别。我们收集了UrbanPipe这一新数据集,其数据来自真实城市管道系统中的QV管道检测视频,并由专业的工程师标注。

本数据集包括9600个视频,管道类别包括1个正常类和16个缺陷类。所有视频的总时长超过55小时。每个视频的时长从0.7秒到177.4秒不等,标注的缺陷类别个数从1到5个不等,平均每个视频时长20.7秒、有1.4个缺陷类别。视频按2:1的比例分为训练集和测试集。我们的目标是给定一个QV视频,预测出这个视频中的多个缺陷类别。

公众号后台回复“CVPR 2022”获取论文合集打包下载~

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~