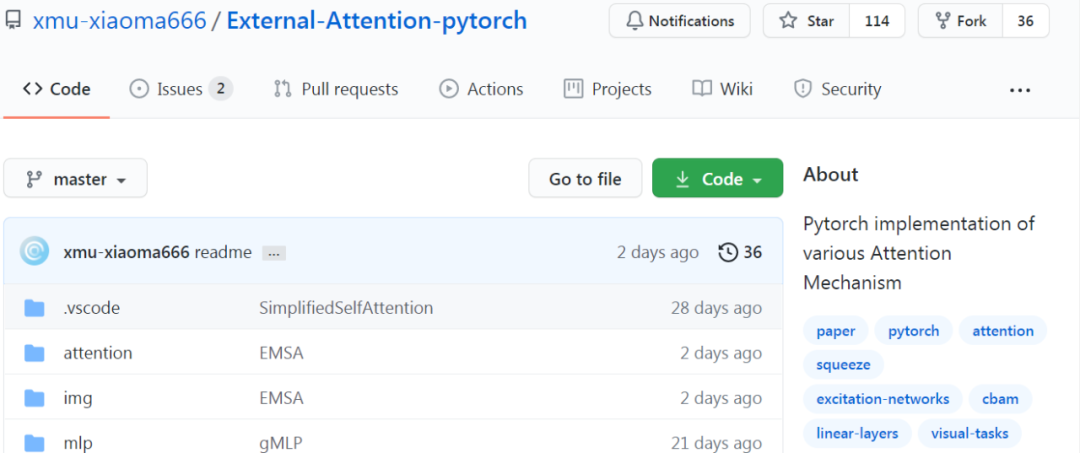

17 篇注意力机制 PyTorch 实现!

PyTorch实现各种注意力机制。

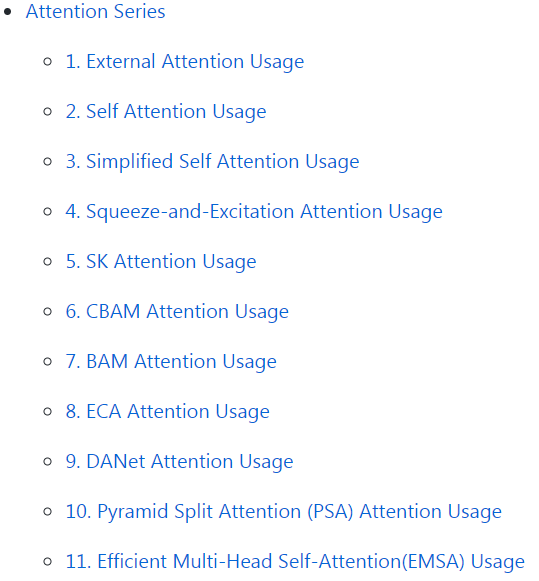

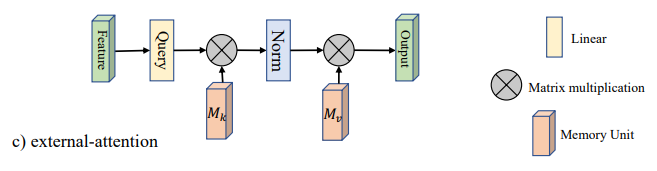

Pytorch 实现论文「Beyond Self-attention: External Attention using Two Linear Layers for Visual Tasks---arXiv 2020.05.05」

Pytorch 实现论文「Attention Is All You Need---NIPS2017」

Pytorch 实现论文「Simplified Self Attention Usage」

Pytorch 实现论文 「Squeeze-and-Excitation Networks---CVPR2018」

Pytorch 实现论文「Selective Kernel Networks---CVPR2019」

Pytorch 实现论文「CBAM: Convolutional Block Attention Module---ECCV2018」

Pytorch 实现论文「BAM: Bottleneck Attention Module---BMCV2018」

Pytorch 实现论文「ECA-Net: Efficient Channel Attention for Deep Convolutional Neural Networks---CVPR2020」

Pytorch 实现论文「Dual Attention Network for Scene Segmentation---CVPR2019」

Pytorch 实现论文「EPSANet: An Efficient Pyramid Split Attention Block on Convolutional Neural Network---arXiv 2020.05.30」

Pytorch 实现论文 「ResT: An Efficient Transformer for Visual Recognition---arXiv 2020.05.28」

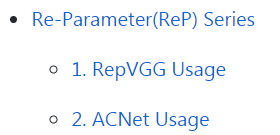

Pytorch 实现论文「RepMLP: Re-parameterizing Convolutions into Fully-connected Layers for Image Recognition---arXiv 2020.05.05」

Pytorch 实现论文「MLP-Mixer: An all-MLP Architecture for Vision---arXiv 2020.05.17」

Pytorch 实现论文「ResMLP: Feedforward networks for image classification with data-efficient training---arXiv 2020.05.07」

Pytorch 实现论文「Pay Attention to MLPs---arXiv 2020.05.17」

Pytorch 实现论文「RepVGG: Making VGG-style ConvNets Great Again---CVPR2021」

Pytorch 实现论文「ACNet: Strengthening the Kernel Skeletons for Powerful CNN via Asymmetric Convolution Blocks---ICCV2019」

from attention.ExternalAttention *import* ExternalAttentionimport torchinput=torch.randn(50,49,512)ea = ExternalAttention(d_model=512,S=8)output=ea(input)print(output.shape)

来源:机器之心

读者,你好!我们建了微信群方便大家学习交流,欢迎扫码进群讨论。

微商、广告请绕道!谢谢合作!