综述 | 注意力机制

点击上方“程序员大白”,选择“星标”公众号

重磅干货,第一时间送达

来源:人工智能前沿讲习

地址:https://zhuanlan.zhihu.com/p/364819787、https://zhuanlan.zhihu.com/p/365550383

01

3. 注意力机制如何实现,以及注意力机制的分类

简单来说就是对于模型的每一个输入项,可能是图片中的不同部分,或者是语句中的某个单词分配一个权重,这个权重的大小就代表了我们希望模型对该部分一个关注程度。这样一来,通过权重大小来模拟人在处理信息的注意力的侧重,有效的提高了模型的性能,并且一定程度上降低了计算量。

References:

02

1. 自注意力机制概述

2. 文字处理中单词向量编码的方式

3. 自注意力机制如何实现

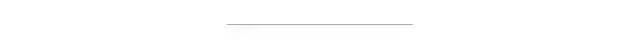

对于每一个输入向量a,在本例中也就是每一个词向量,经过self-attention之后都输出一个向量b,这个向量b是考虑了所有的输入向量才得到的,这里有四个词向量a对应就会输出四个向量b

,

,  ,

, 得到q,k,v三个值:

得到q,k,v三个值: 写成向量形式:

写成向量形式:

写成向量形式:

写成向量形式:

写成向量形式:

写成向量形式:

写成向量形式:

写成向量形式:

,写成向量形式

,写成向量形式

先通过三个W矩阵生成q,k,v;然后利用q,k计算attention的值α,再把所有的α经过softmax得到α';最后对所有的v进行加权求和,权重是α',得到a1对应的self-attention输出的b1

4. 自注意力机制的问题

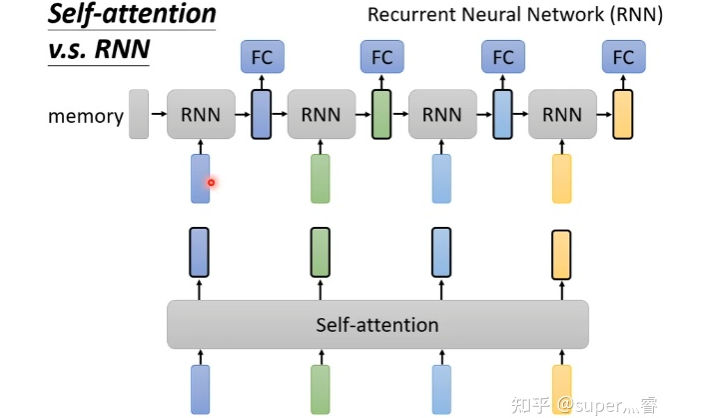

5. 自注意力机制&CNN、RNN

评论