【深度学习】深度学习的发展方向: 深度强化学习!

一、深度学习的反思

二、强化学习原理

2.3 深入浅出强化学习

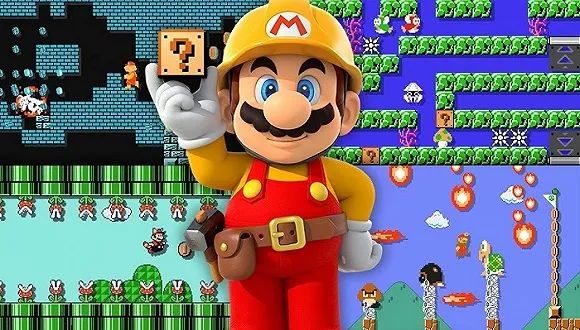

掌握了状态信息,游戏里的马里奥开始跃跃欲试,准备做出反应了。强化学习也一样,我们将s(t)作为智能体的输入,智能体会略加思索,接着就能做出“动作”。这里的动作,就是前面介绍的第四个重要概念。智能体能做出哪些动作呢?这和具体的场景有关,譬如在马里奥游戏中,动作就是指“顶蘑菇”或者“踩乌龟”,一般记为a(t)。

2.4 强化学习方向分类

当然,除了这两大方向,强化学习还有其它的脑洞方向,譬如基于模型(Model-Based)的强化学习,不过由于成本和难度较高,用得比较少。而这两大方向都各自包含了大量的具体实现算法,即使方向相同,各个算法在细节上仍然有很大差异。

三、深度学习与强化学习的结合

本文参考北京理工大学刘驰教授的《深度强化学习:学术前沿与实战应用》,本书详解了深度强化学习领域近年来重要进展及其典型应用场景,涵盖新的理论算法、工程实现和领域应用。紧跟学术前沿,联合工程实践,值得学习。

往期精彩回顾

获取一折本站知识星球优惠券,复制链接直接打开:

https://t.zsxq.com/662nyZF

本站qq群1003271085。

加入微信群请扫码进群:

评论