点击下方“AI算法与图像处理”,一起进步!

重磅干货,第一时间送达

来源:Reddit、新智元

【导读】近日,有网友扒出一篇ICCV与ICML的论文如出一辙,列出了10个「抄袭实锤」。据了解,ICCV论文一作李铎是香港科技大学准博士生,本科就读于清华大学,曾发表12篇顶会论文。还有网友指出去年CVPR的论文也是「照搬」的。

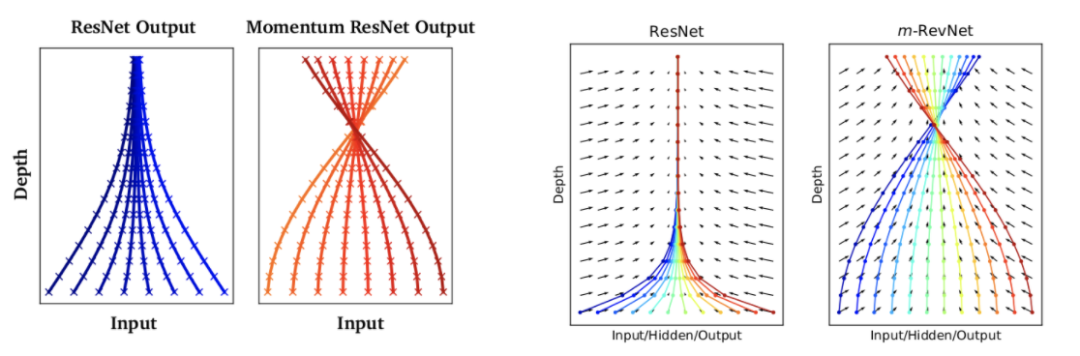

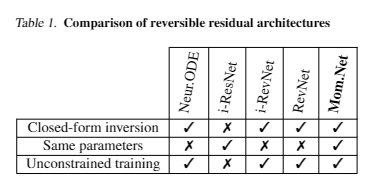

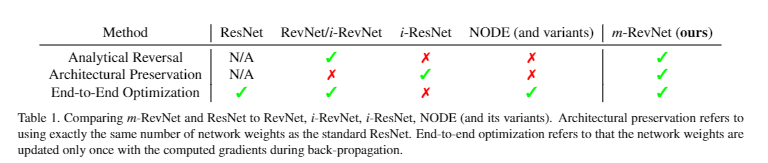

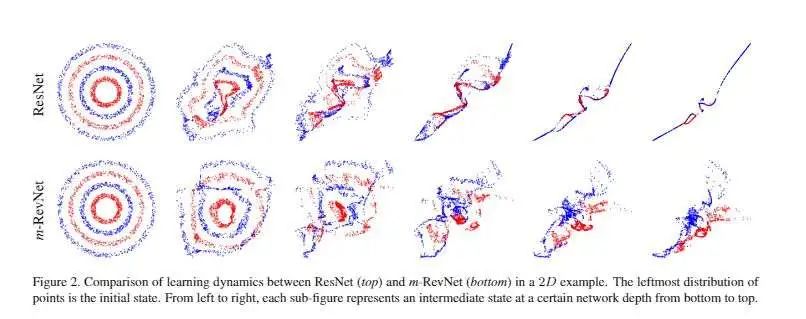

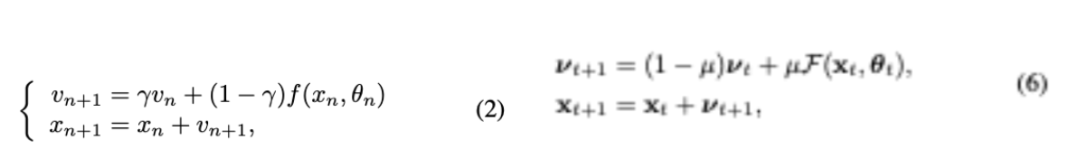

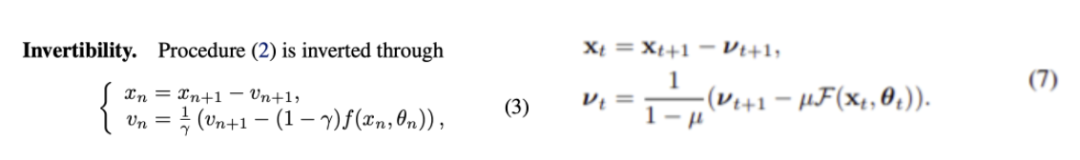

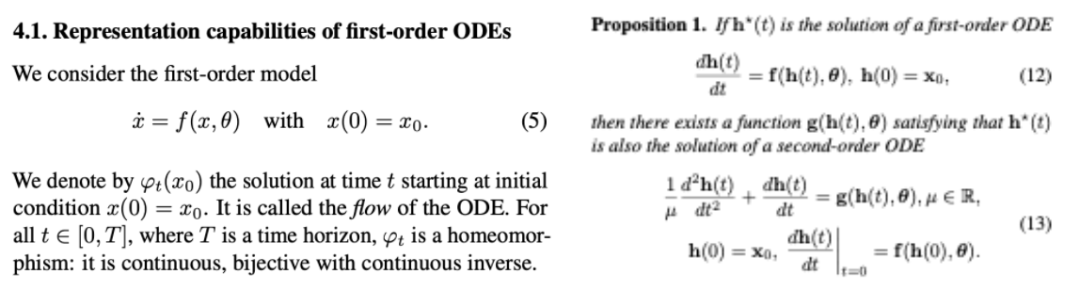

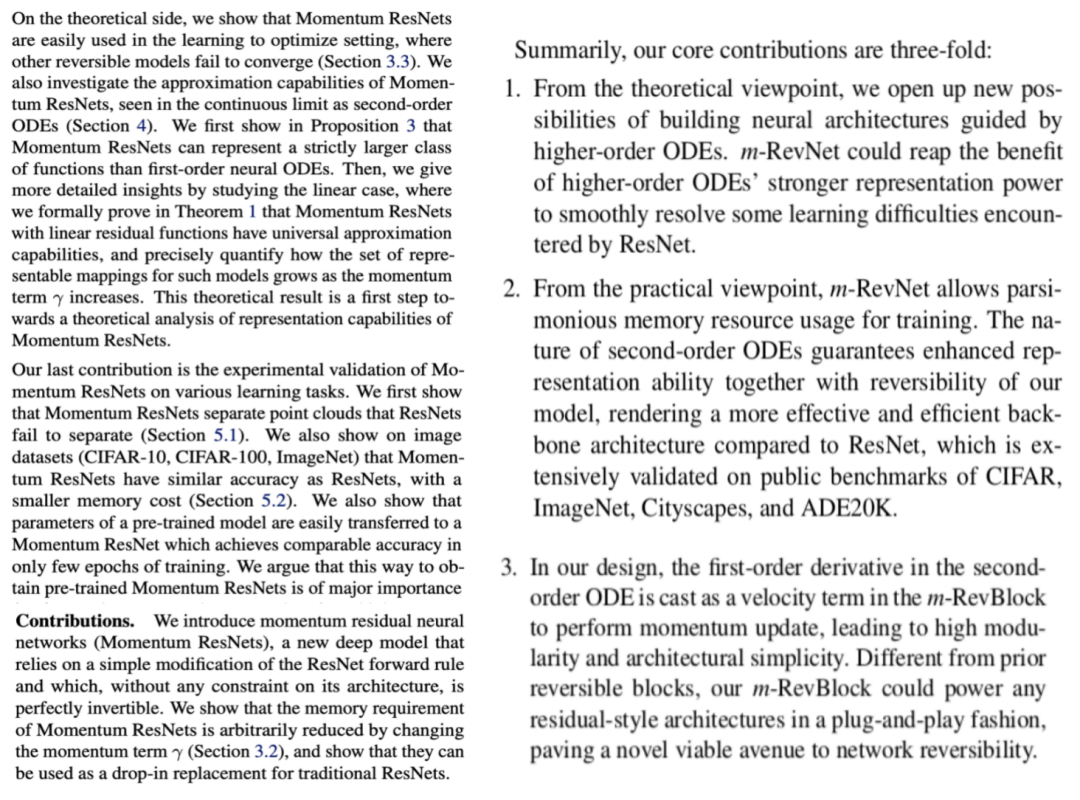

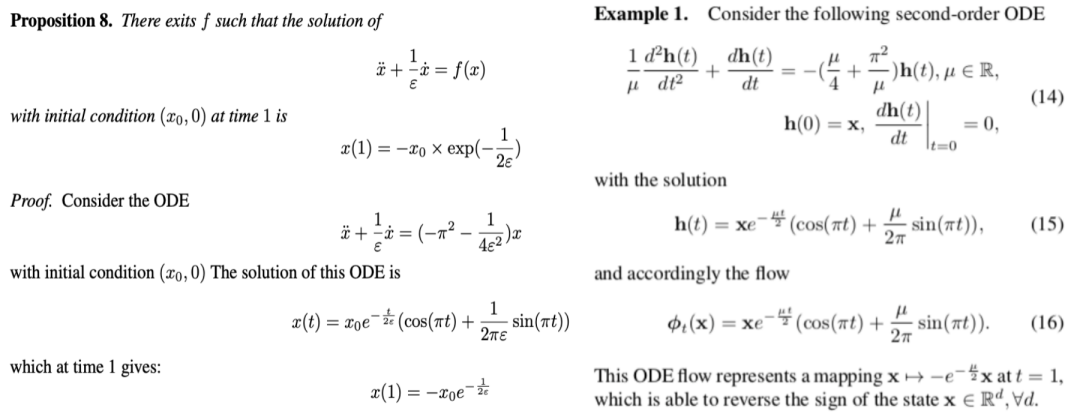

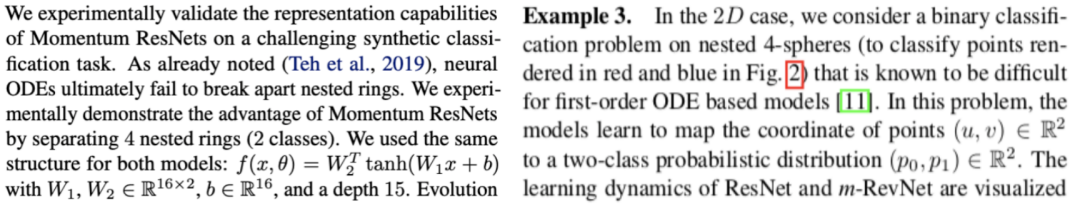

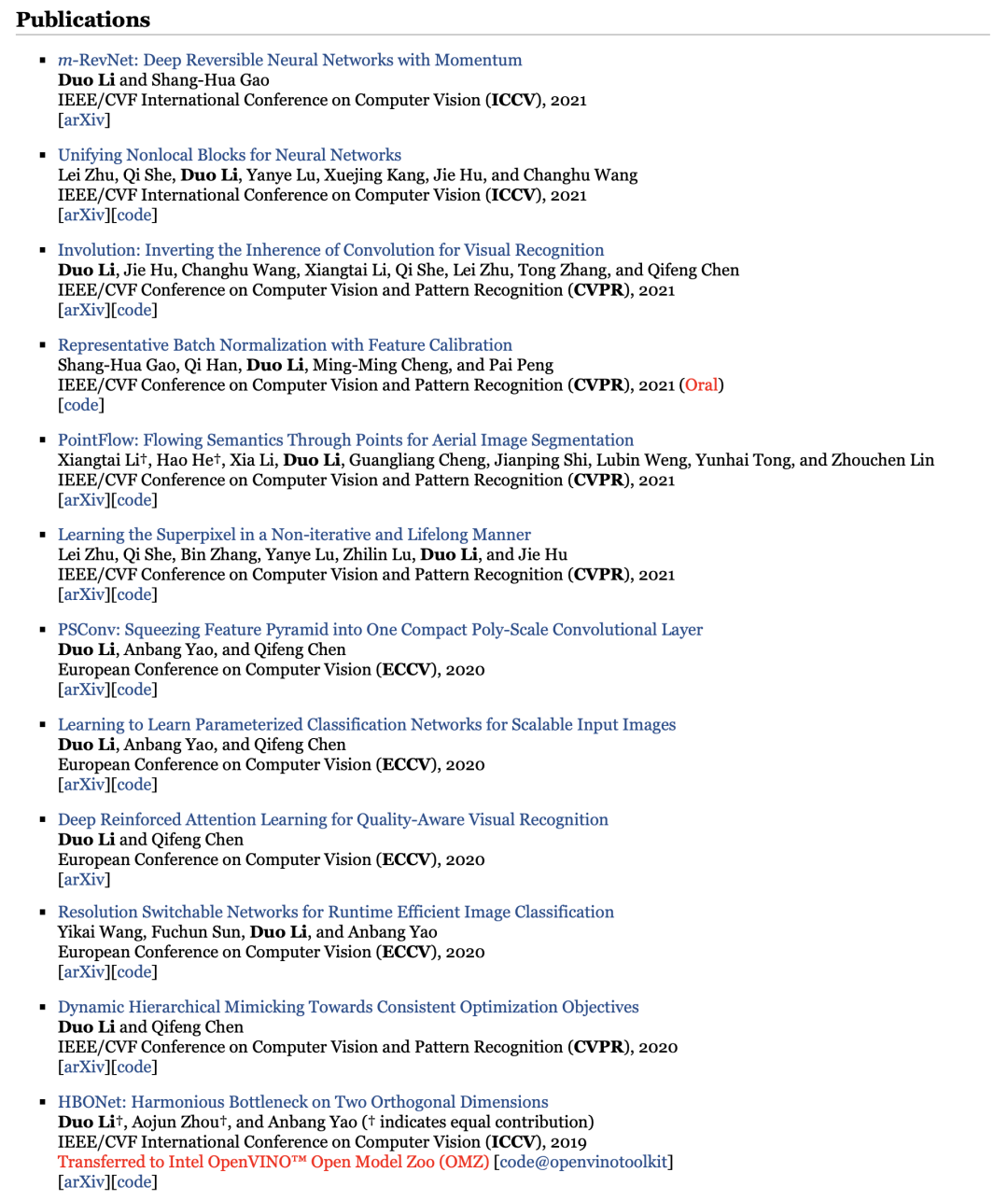

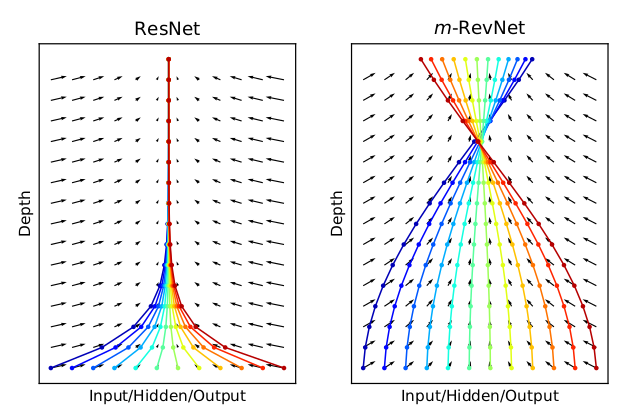

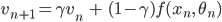

近日,眼尖的网友发现两篇分别发表在ICML 2021和ICCV 2021两大顶会的论文有着惊人的相似之处!Reddit上有网友跑去了「抄袭者」的网站上看了作者的资料,发现这位作者已经发表过12篇顶会论文,而且还是准博士生,不禁怀疑是不是一直都有这样的操作……推特上一位眼尖的网友发现了两篇顶会论文几乎如出一辙,网友非常细心地对比了两篇论文。「正主」ICML论文题为Momentum residual neural networks,作者是Michael Sander, Pierre Ablin, Mathieu Blondel and Gabriel Peyré。今年2月15日首次上传至Arxiv,2月17日开源代码,7月22日发布论文最新版。论文地址:https://arxiv.org/abs/2102.07870开源代码:https://github.com/michaelsdr/momentumnet/「山寨」ICCV论文题为m-RevNet: Deep Reversible Neural Networks with Momentum,作者是Duo Li(李铎)和Shang-Hua Gao(高尚华)。今年8月12日上传至Arxiv,而ICCV 2021论文收录的截止时间为3月17日。论文地址:https://arxiv.org/abs/2108.05862(文章现已被删除)抄袭还是一项十分严重的指控,我们先来仔细对比一下两篇论文。两篇文章都提出了替换残差网络的前向方程方法,也同样讨论了这种方法的好处:由于ODE机制中的动量,可逆性和更大的表征容量减少了内存负载。closed form inversion = analytical reversal,same parameters = architecture preservationunconstrained training = end-to-en optimization. 两篇论文都引用了一篇前人的研究(https://arxiv.org/abs/1904.01681) ,在这篇引文中,作者使用了2个嵌套环。ICCV只是把ICML中的临界参数「gamma」换成了「1-mu」。左图为ICML论文,右图为ICCV论文

两篇文章同样以Maclaurin等人的算法作为关键的应用。只不过符号略有变化,ICCV将时间导数表示为  ,而ICML中为

,而ICML中为  。两篇论文的贡献列表都是大同小异,但很明显能够感觉到ICCV论文是「洗稿」的。ICCV中的例1基本上就是修改了一下符号,微积分方程本质上完全相同。这两篇论文说一样吧,又不是完全一样;要说是偶然,这得多巧合才能「偶然」出十个雷同点。

。两篇论文的贡献列表都是大同小异,但很明显能够感觉到ICCV论文是「洗稿」的。ICCV中的例1基本上就是修改了一下符号,微积分方程本质上完全相同。这两篇论文说一样吧,又不是完全一样;要说是偶然,这得多巧合才能「偶然」出十个雷同点。

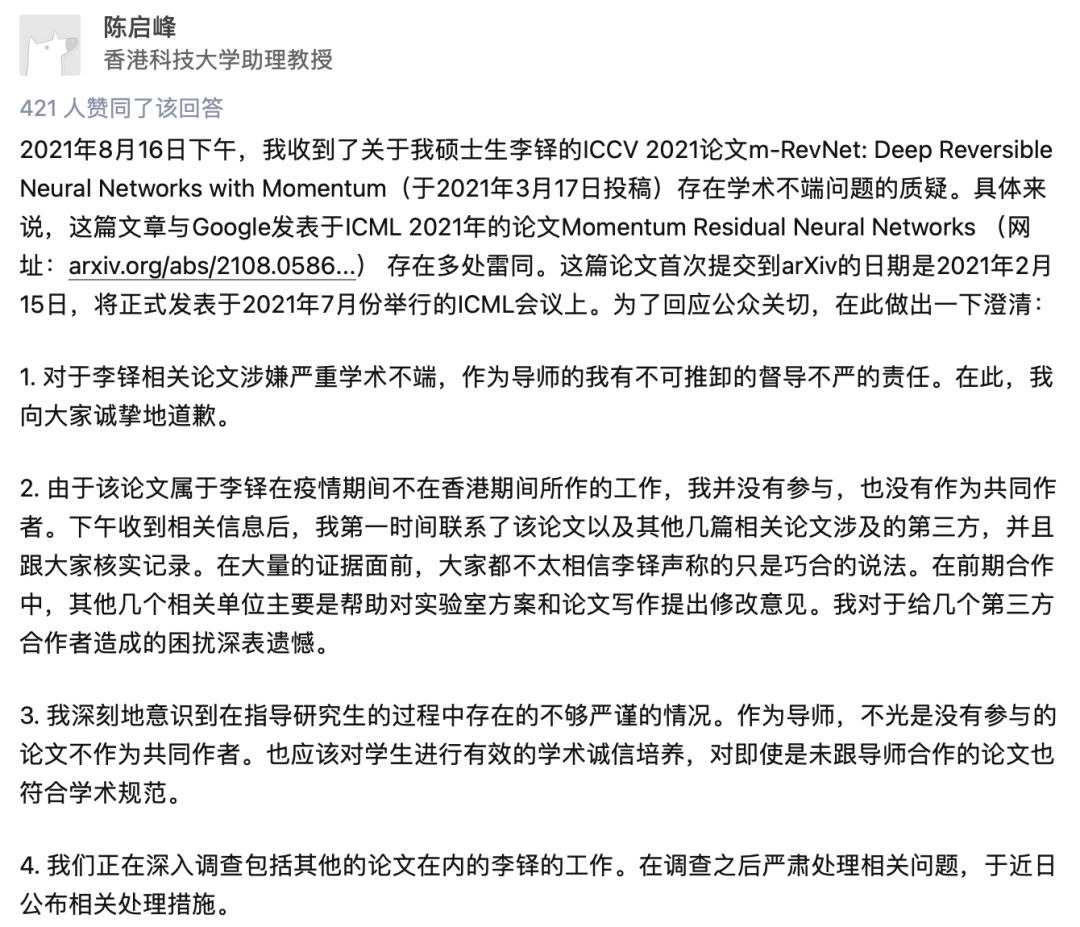

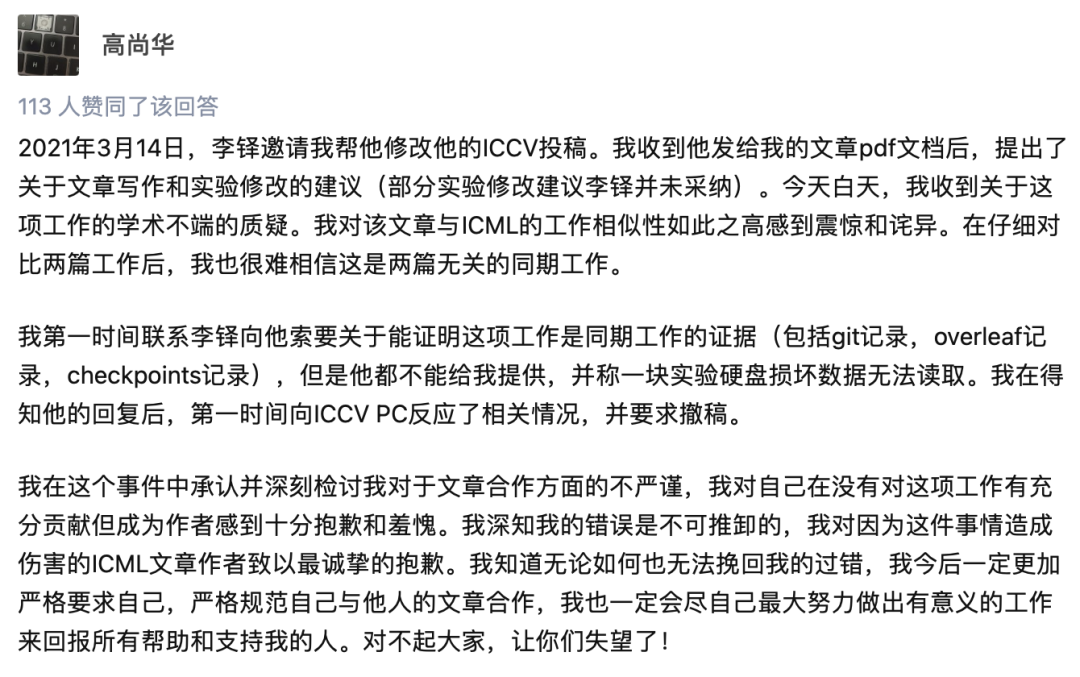

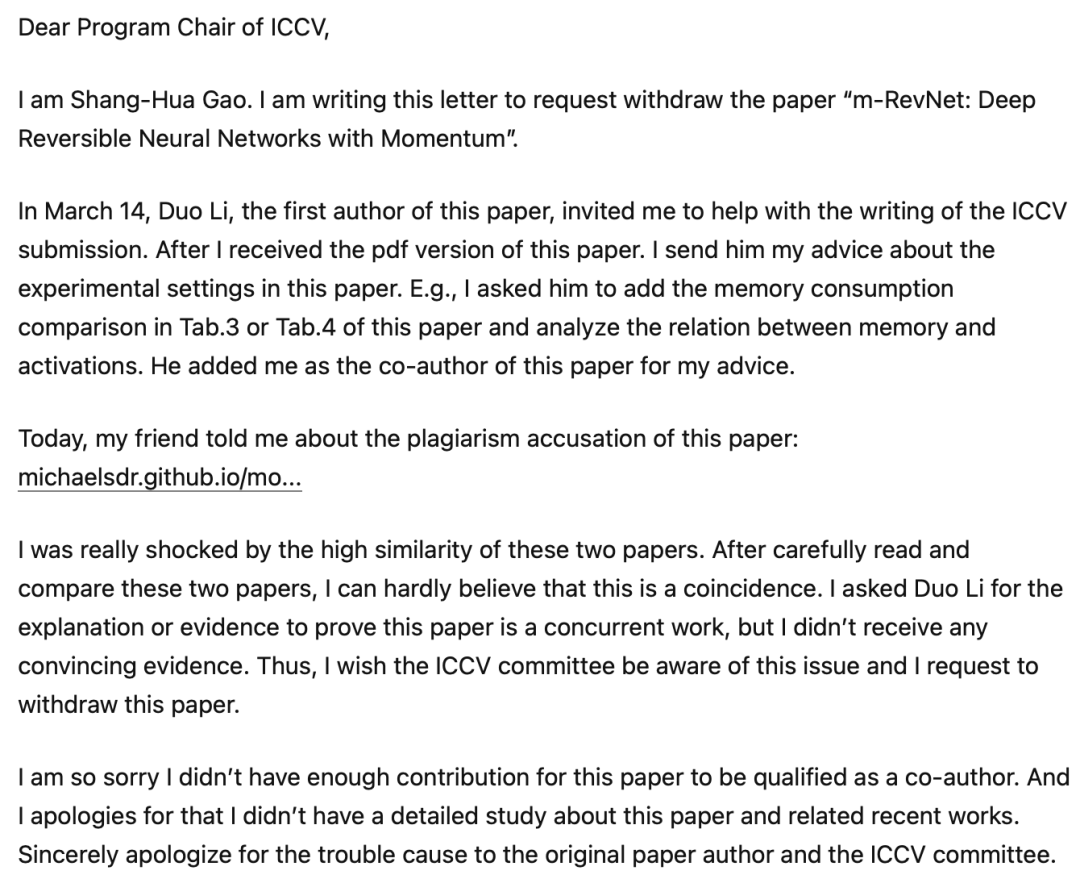

论文抄袭事件在Reddit上已经有330个赞,而知乎上的相关话题也已经有100多万次浏览。兹事体大,不仅ICCV作者撤回了Arxiv上的论文,他的导师也在知乎上发文致歉,表示自己有「不可推卸的督导不严的责任」。此外,ICCV论文二作高尚华同样也在知乎上澄清,对涉事文章与ICML论文极高相似度「感到震惊和诧异」。二作作为涉事论文的改稿人,第一时间要求一作提供相关工作证据,但一作却声称数据已损坏。面对这么可疑的解释,二作决定向ICCV反映相关情况,并要求撤稿。

凡事都讲证据,面对「抄袭」这一指控,网友们也是非常小心谨慎,避免误伤。李铎现就读于香港科技大学计算机科学与工程系,硕士二年级,2019年获得清华大学自动化系工学学士学位。个人主页:https://web.archive.org/web/20210816025239/http://duoli.org/

然而没想到的是,这两篇论文的作者学术背景也成为了这个指控的证据。知乎上有匿名网友深扒了两篇文章的作者学术背景,对比了两人的研究内容。

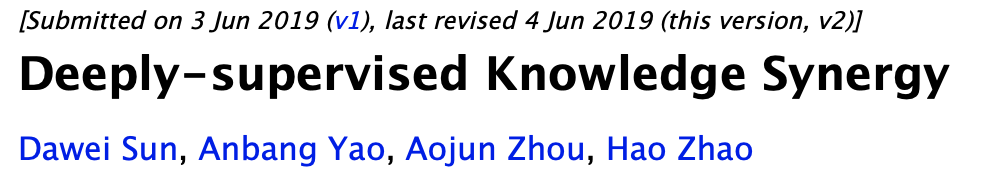

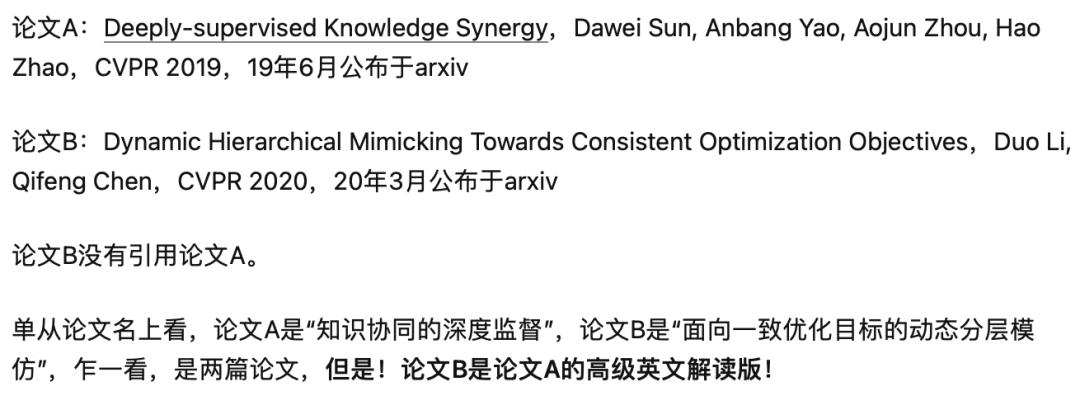

我们的这位一作在2020年就给CVPR投稿了一篇「照搬」2019年CVPR的文章。论文地址:https://arxiv.org/abs/1906.00675论文地址:https://arxiv.org/abs/2003.10739「其通篇向人们展示了如何包装出一篇顶会论文!实在是触目惊心,看得我头皮发麻。」知乎回答:https://www.zhihu.com/question/480075870/answer/2064933570李铎导师同时也在知乎上表明,他们正在深入调查李铎过去发表的论文,后续会根据调查结果严肃处理,并于近日公布相关处理措施。参考资料:

https://www.reddit.com/r/MachineLearning/comments/p59pzp/d_imitation_is_the_sincerest_form_of_flattery/

https://michaelsdr.github.io/momentumnet/plagiarism/

https://twitter.com/PierreAblin/status/1426899071495819265

https://www.zhihu.com/question/480075870

https://web.archive.org/web/20210816025239/http://duoli.org/

ICML 2021 Momentum residual neural networks:https://arxiv.org/abs/2102.07870ICCV 2021 m-RevNet: Deep Reversible Neural Networks with Momentum:https://arxiv.org/abs/2108.05862CVPR 2019 Deeply-supervised Knowledge Synergy:https://arxiv.org/abs/1906.00675CVPR 2020 Dynamic Hierarchical Mimicking Towards Consistent Optimization Objectives:https://arxiv.org/abs/2003.10739

和

和 的动量方程取代残差网络的前向方程

的动量方程取代残差网络的前向方程 。

。