清华本科、港科大准博士被指论文抄袭,网友:这是有技巧的“洗稿”

点击上方“视学算法”,选择加"星标"或“置顶”

重磅干货,第一时间送达

本文来源:整理自新智元、Reddit、知乎等

不是吧?清华自动化本科,香港科技大学硕士生发表的顶会论文竟然是抄的?

而且抄袭对象还是另一篇顶会论文?

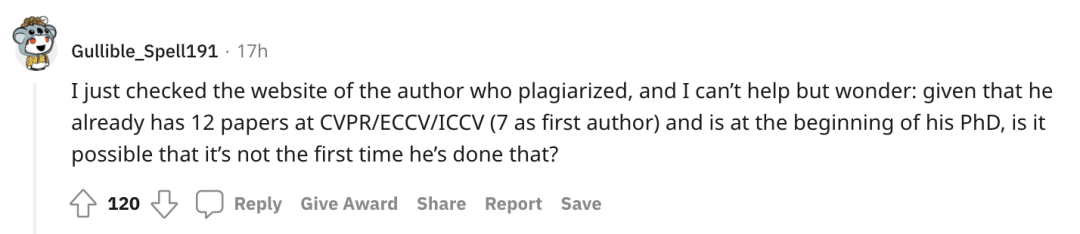

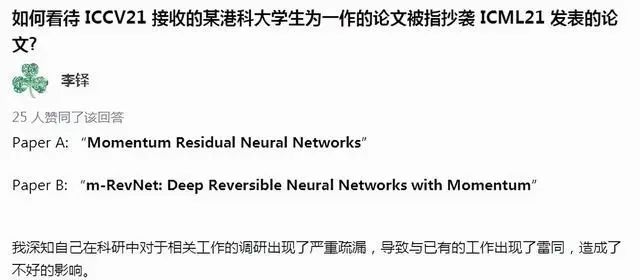

近日,眼尖的网友发现两篇分别发表在 ICML 2021 和 ICCV 2021 两大顶会的论文有着惊人的相似之处!

PS:ICCV、ICML均为中国计算机学会在人工智能方向推荐的A类国际学术会议,为世界顶级的学术会议。

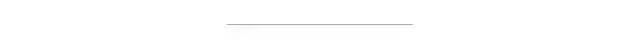

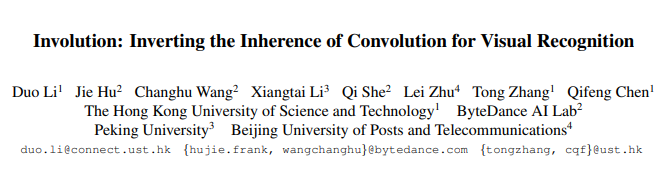

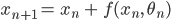

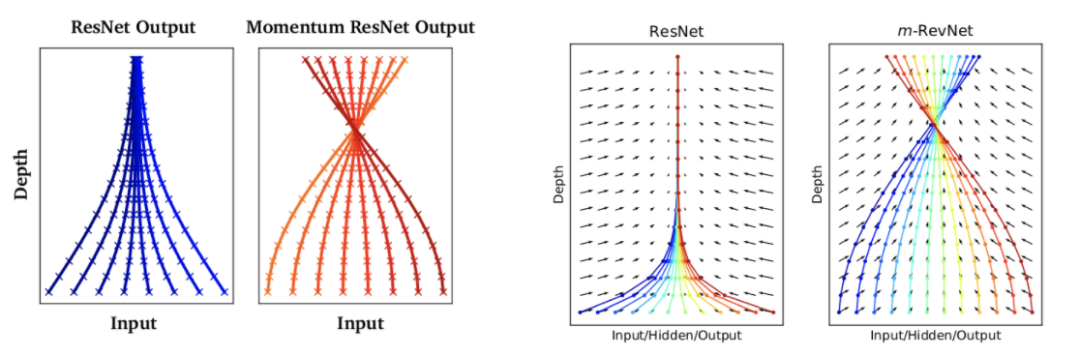

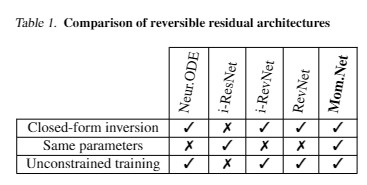

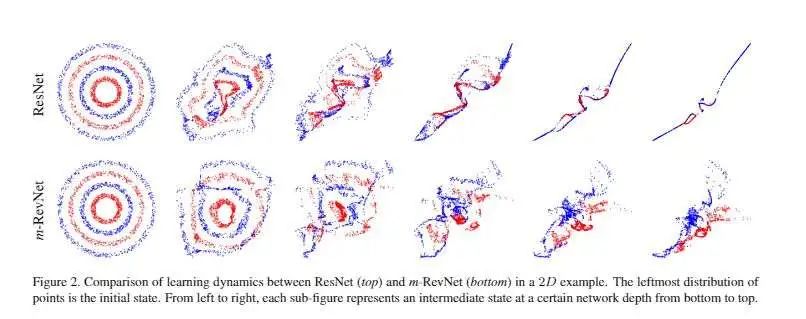

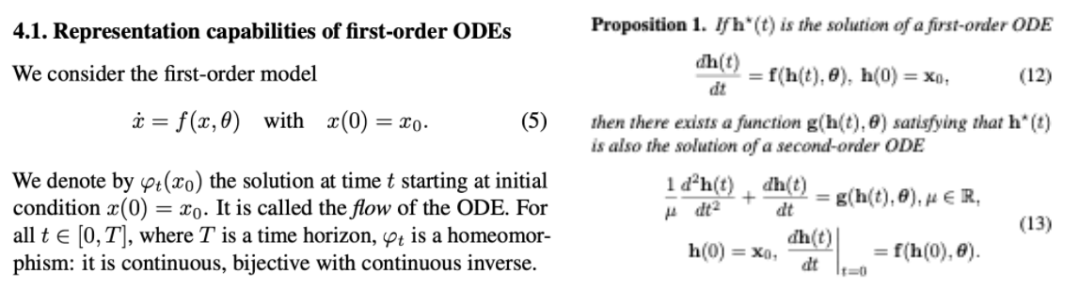

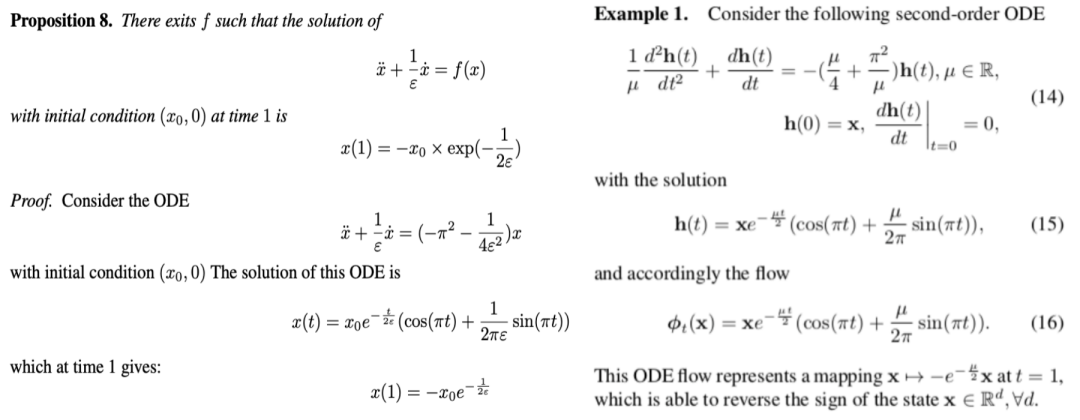

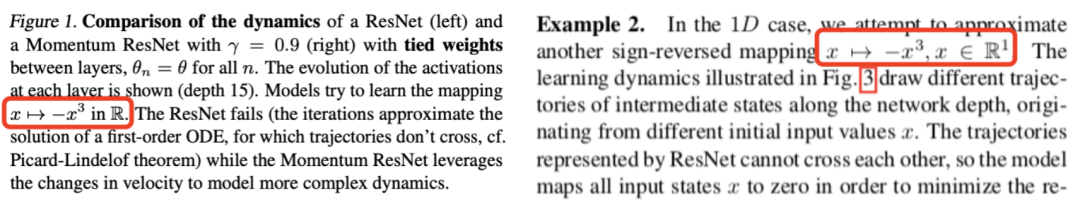

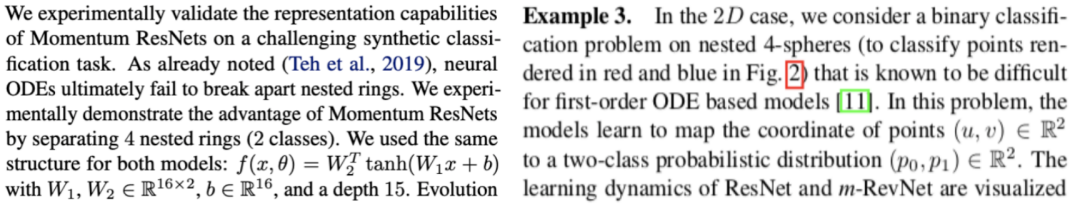

ICML 2021上发表的论文

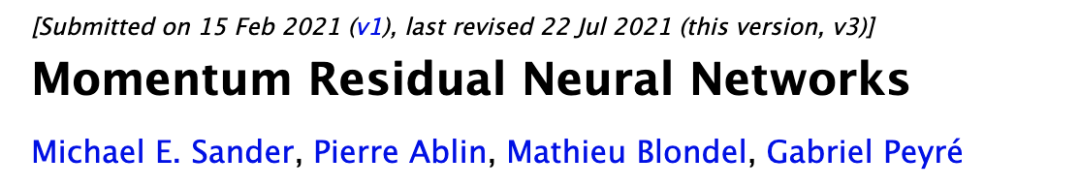

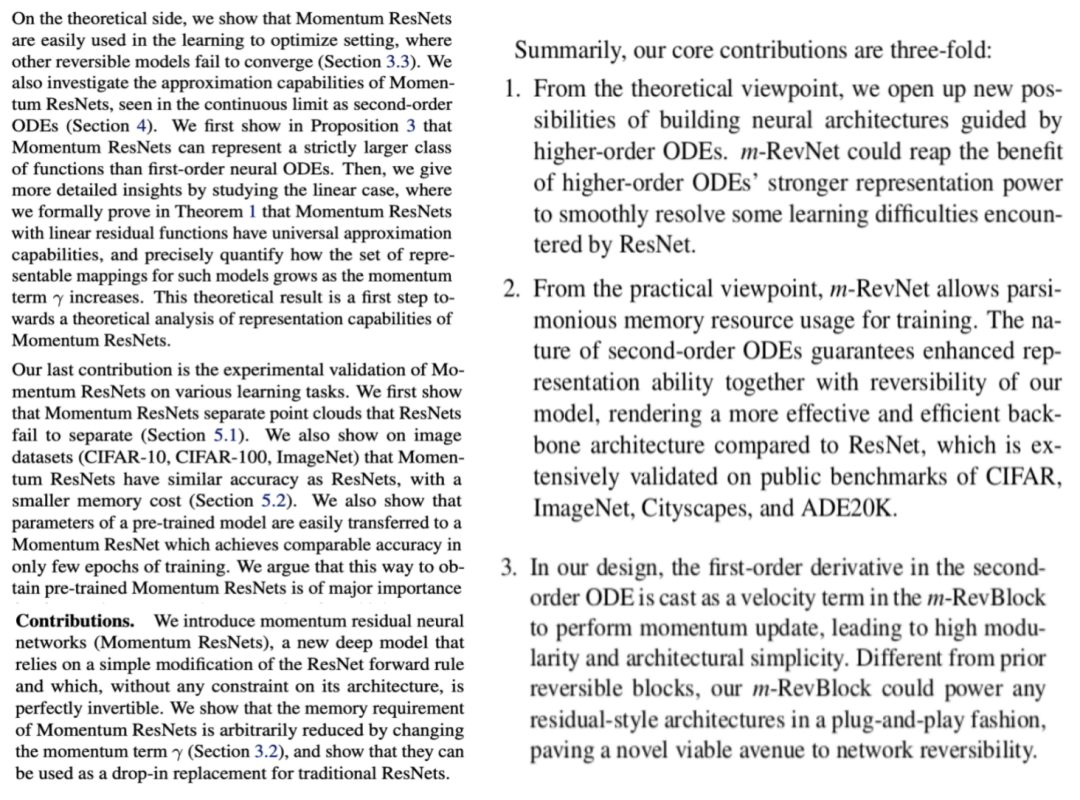

ICCV 2021上发表的论文

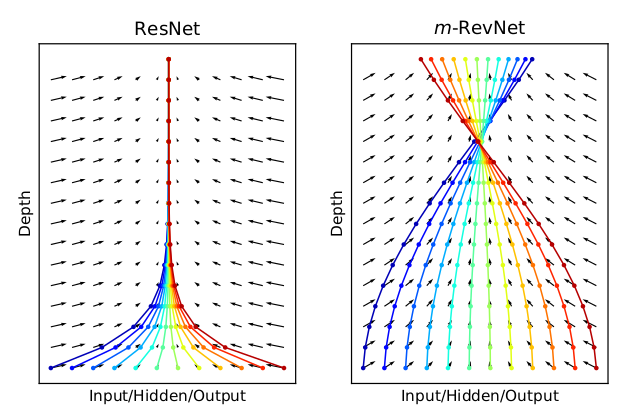

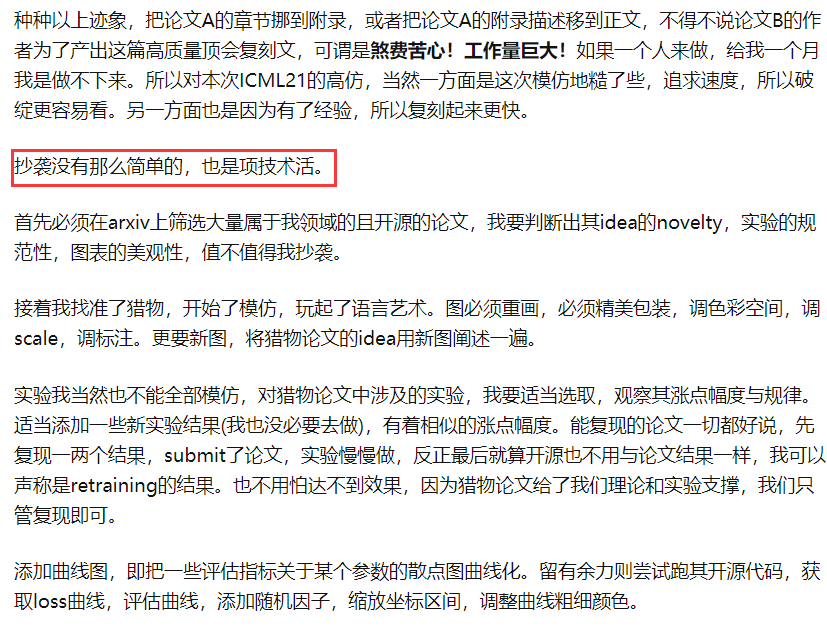

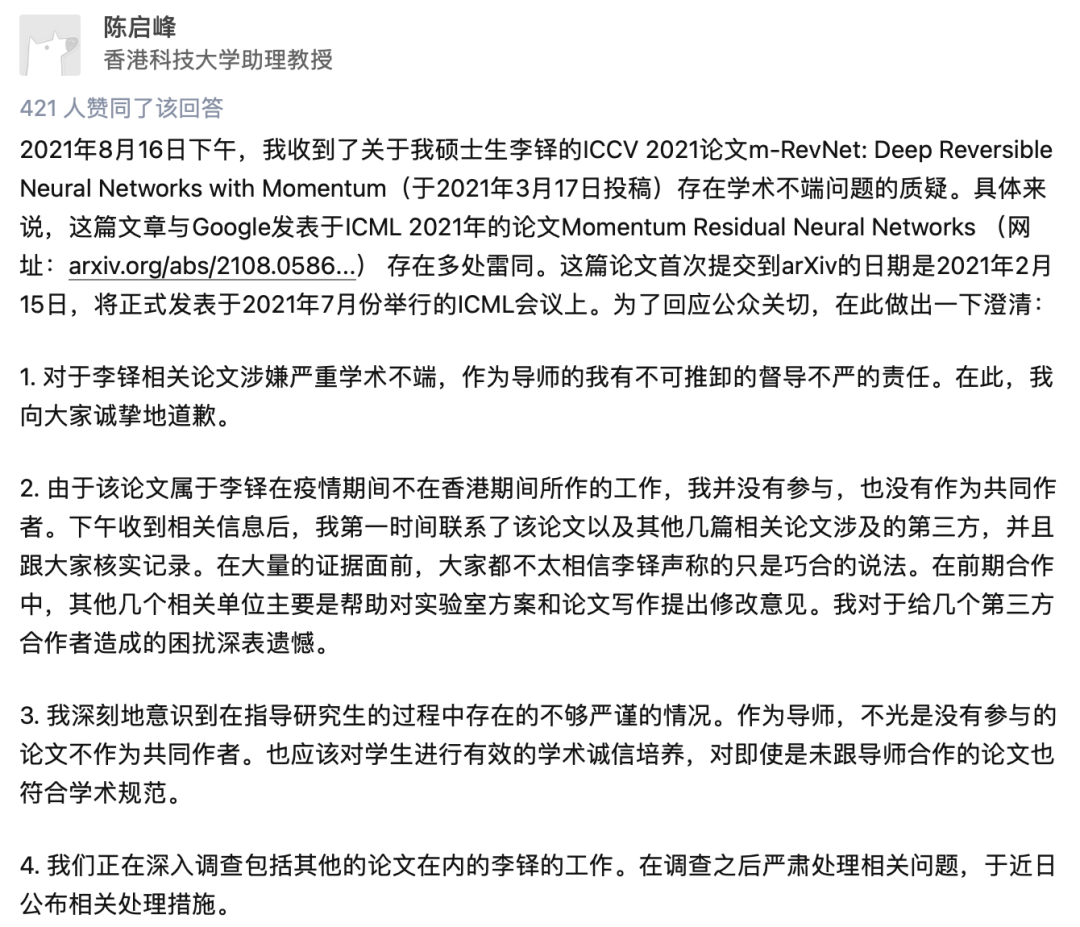

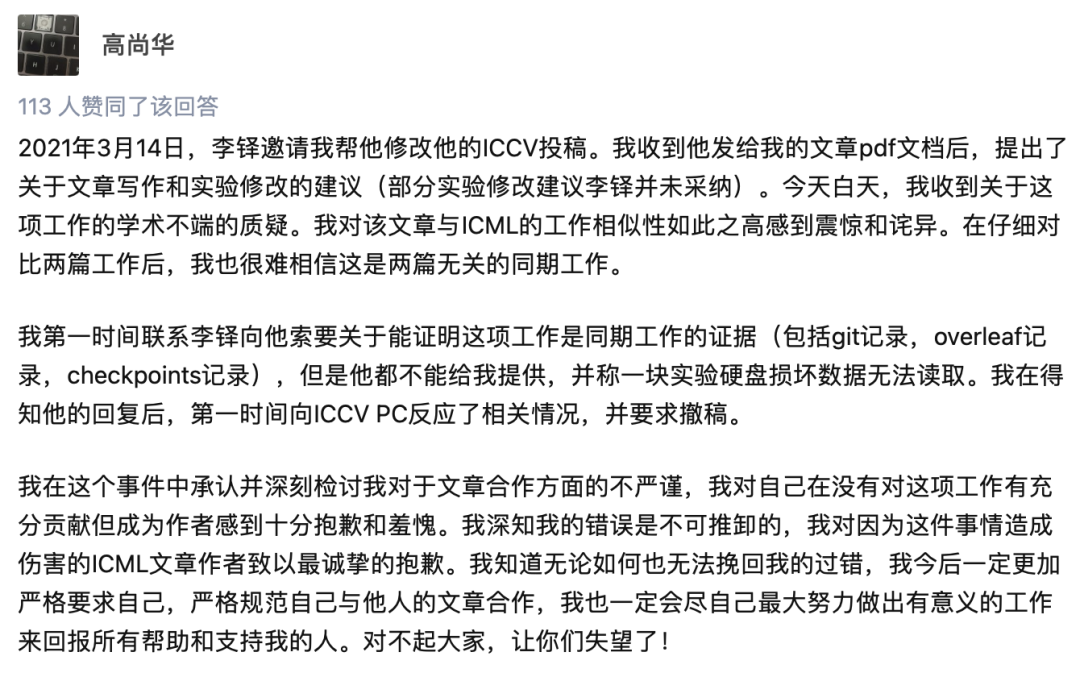

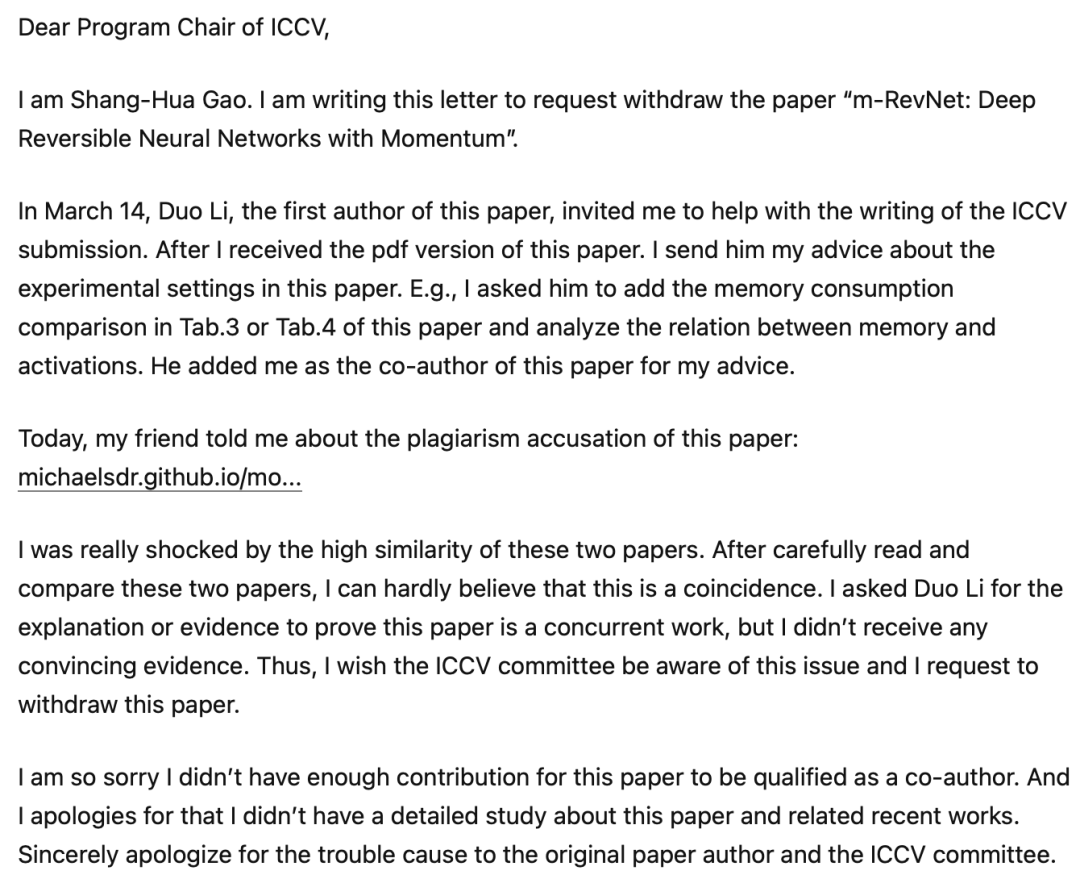

而随着更多网友对论文的分析,有人指出这是一种很高明的“洗稿”技巧,Reddit上还有网友跑去了「抄袭者」的网站上看了作者的资料,发现这位作者已经发表过12篇顶会论文,而且还是准博士生,也不禁怀疑是不是一直都有这样的操作……

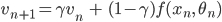

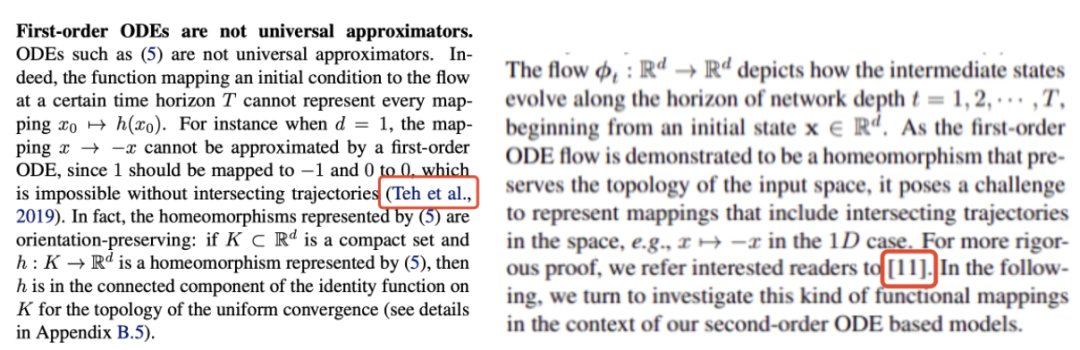

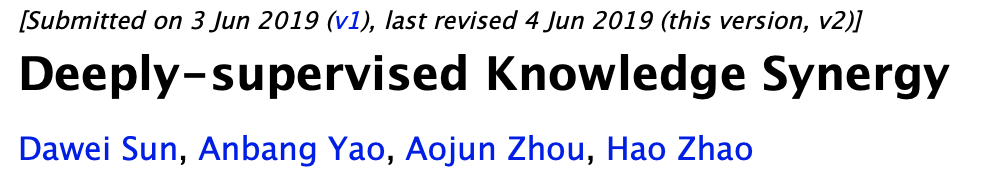

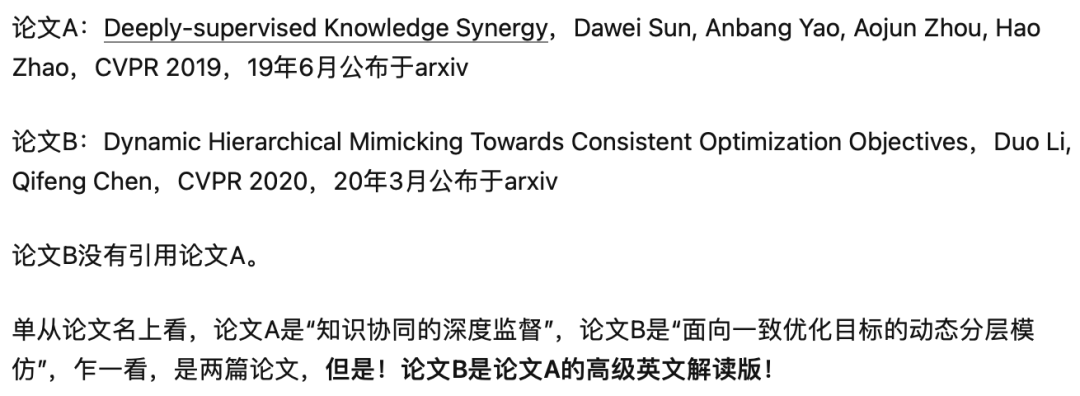

和

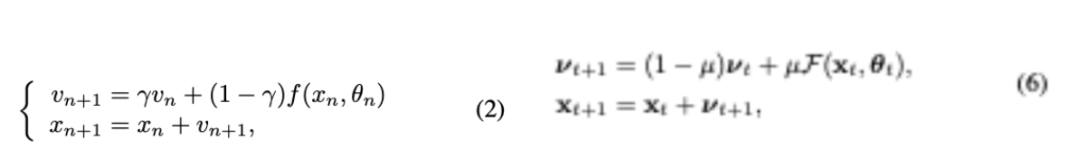

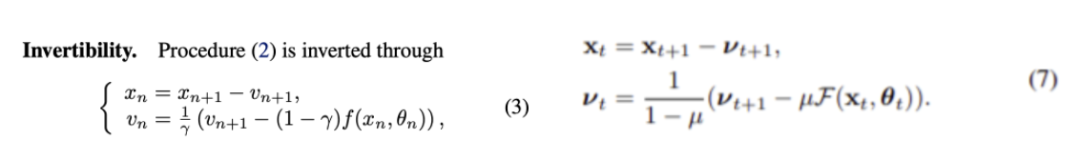

和 的动量方程取代残差网络的前向方程

的动量方程取代残差网络的前向方程 。

。

作者和导师火速回应

点个在看 paper不断!

评论