收藏 | 深度学习到深度推理

↑↑↑点击上方蓝字,回复资料,10个G的惊喜

仅做学术分享,如有侵权,联系删除 转载于 :专知

【导读】ACM SIGKDD(国际数据挖掘与知识发现大会,简称 KDD)是世界数据挖掘领域的最高级别的学术会议,由 ACM 的数据挖掘及知识发现专委会(SIGKDD)主办,被中国计算机协会推荐为 A 类会议。自 1995 年以来,KDD 已经连续举办了26届,今年将于2021年8月14日至18日举办,今年的会议主办地在新加坡。

来自deakin大学的研究人员在KDD2021上将给出关于深度学习推理的教程,非常值得关注!

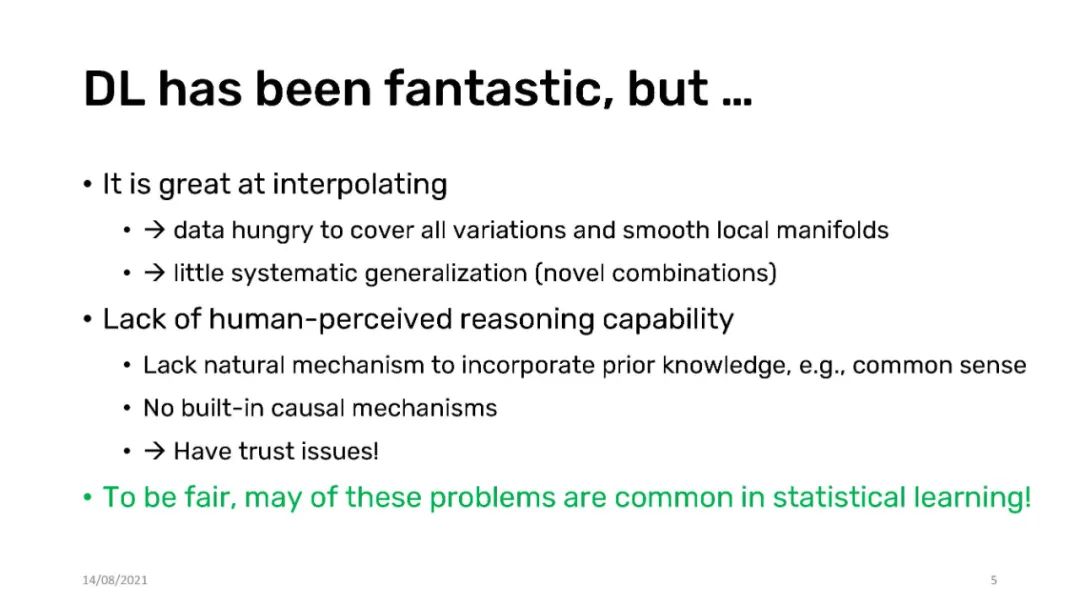

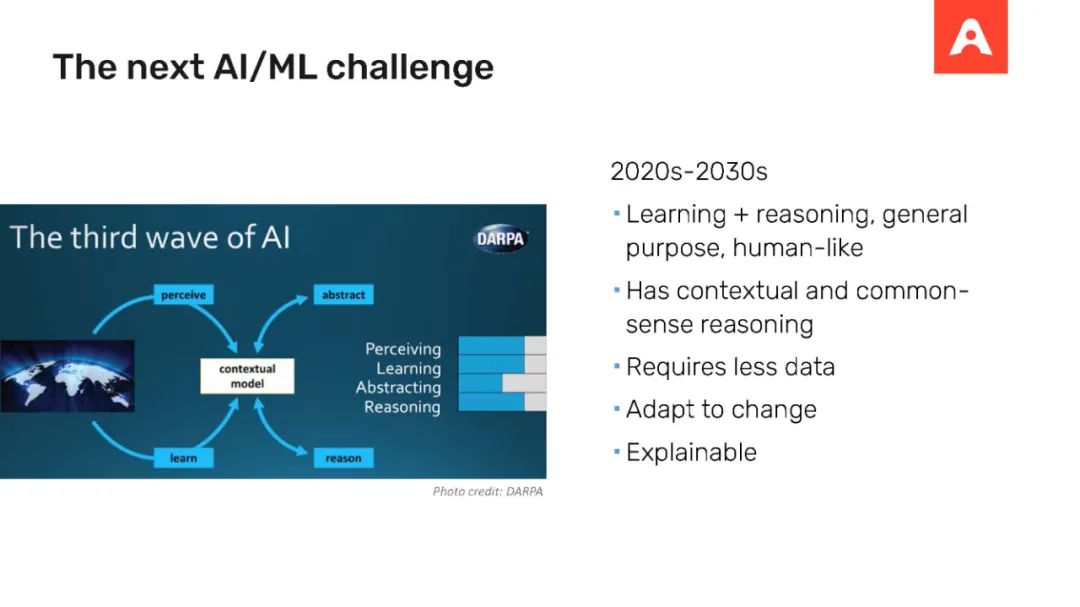

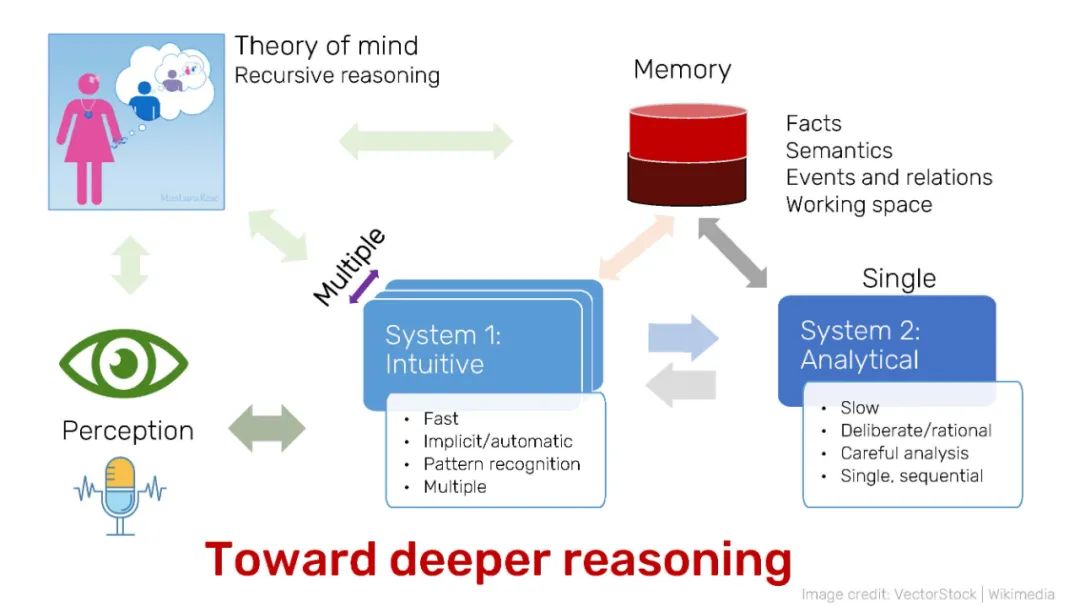

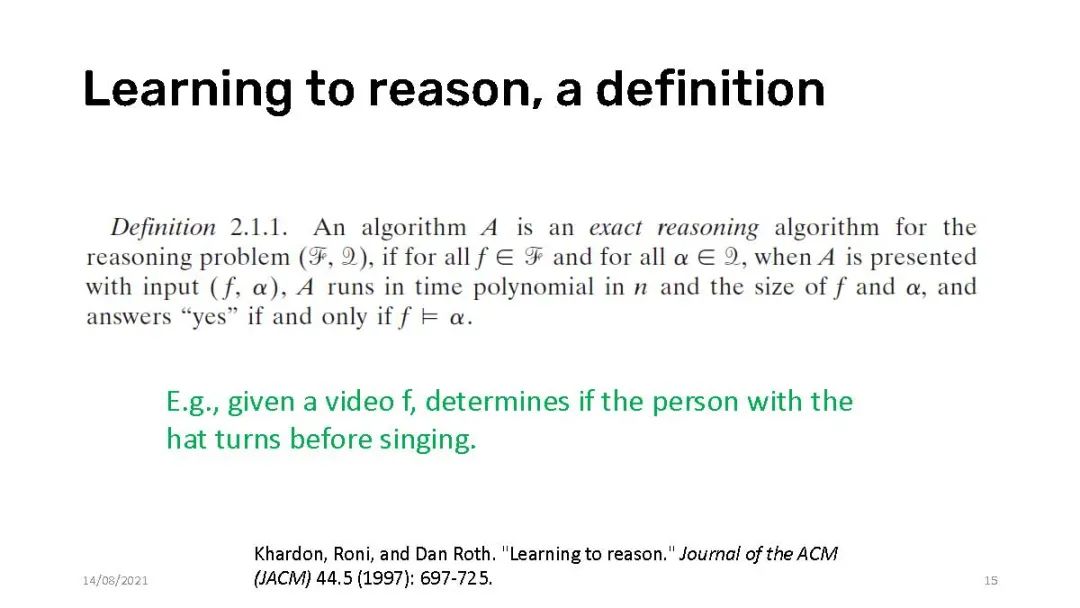

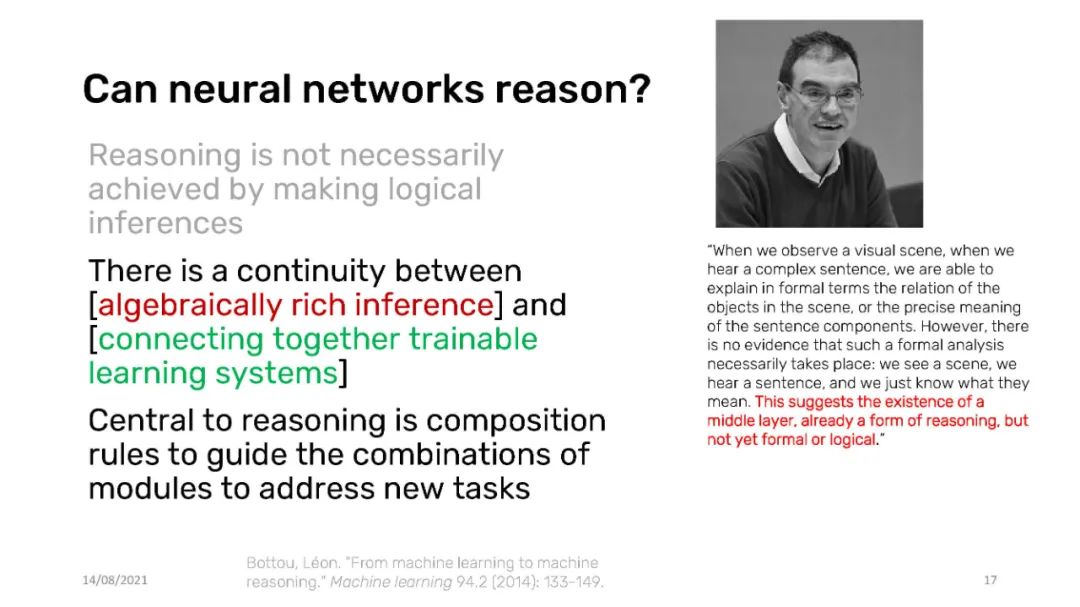

大数据和大计算的兴起给数字生活的许多领域带来了现代神经网络,这要归功于构建与现实世界相适应的大型模型相对容易。Transformers的成功和对海量数据的自监督预训练让一些人相信,只要我们有数据和计算资源,深度神经网络几乎可以做任何事情。然而,情况可能并非如此。虽然神经网络可以快速地利用表面统计,但它们在泛化到新的任务上却失败得很糟糕。目前的神经网络并不执行刻意推理——即从上下文数据中有意地推导出新知识的能力。本教程回顾了最近的发展,将神经网络的能力扩展到从数据“学习推理”,其中的任务是确定数据是否包含一个结论。这种能力开辟了新的途径,通过使用自然语言进行任意查询,从数据中生成见解,而不需要预先定义一组狭义的任务。

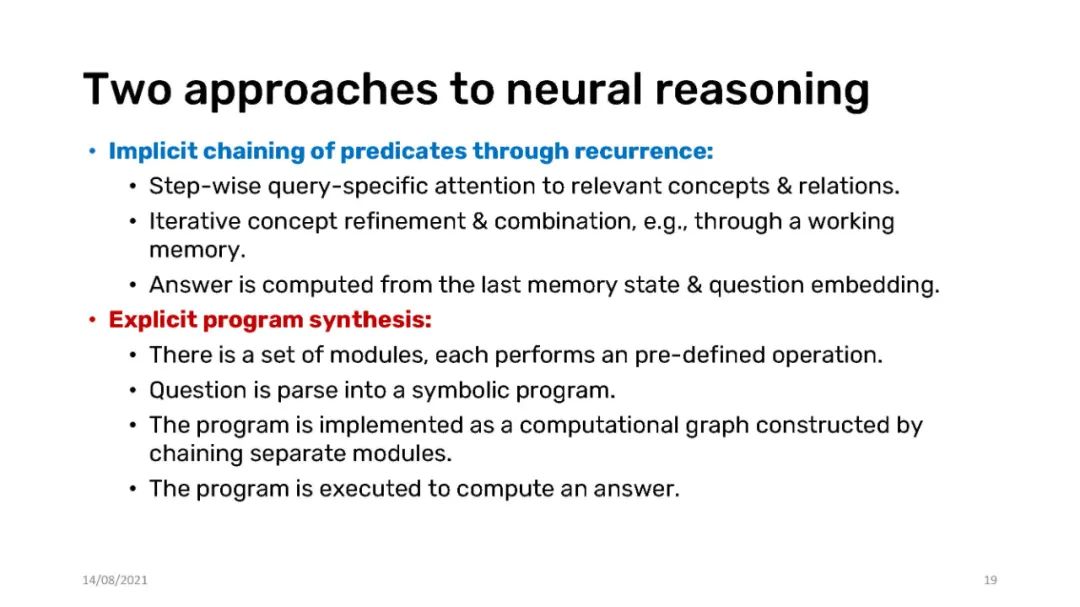

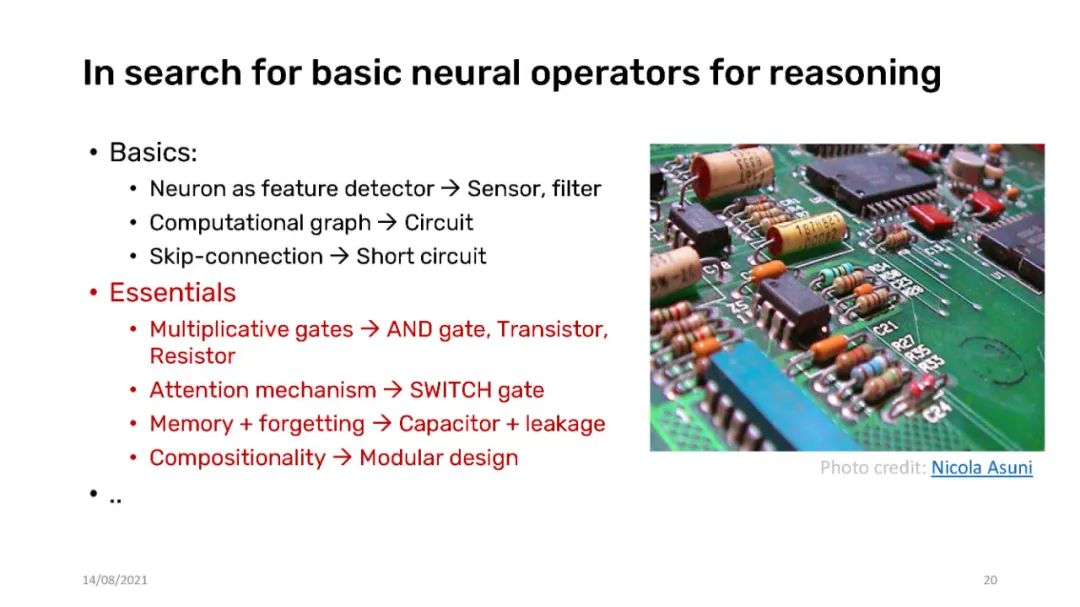

本教程由三个主要部分组成。A部分涵盖了学习-推理框架,解释了神经网络如何通过绑定、注意力和动态计算图等自然操作作为推理的强大支柱。我们还将展示神经网络如何学习执行组合算法。第二部分将更详细地介绍神经网络如何在非结构化和结构化数据上进行推理,以及跨多种模态。将解释集合、关系、图和时间的推理。C部分回顾了更高级的主题,包括带有外部记忆的神经网络,学习用有限的标签进行推理,以及用心智理论进行递归推理。我们将特别关注神经记忆作为支持实体、关系甚至神经程序推理的基本机制。如有可能,将提供文本理解和视觉问答方面的个案研究。

https://truyentran.github.io/kdd2021-tute.html

目录:

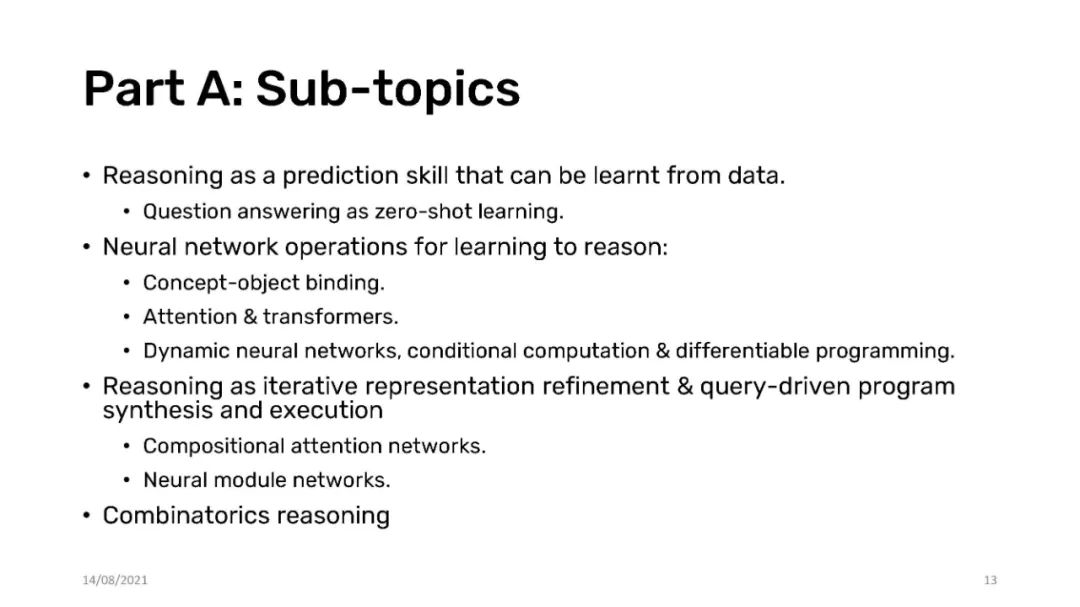

Part A: 推理学习框架 Learning to reason framework (60 mins)

Reasoning as a prediction skill that can be learnt from data.

Question answering as zero-shot learning.

Neural network operations for learning to reason:

Concept-object binding.

Attention & transformers.

Dynamic neural networks, conditional computation & differentiable programming.

Reasoning as iterative representation refinement & query-driven program synthesis and execution.

Compositional attention networks.

Neural module networks.

Combinatorics reasoning.

Part B: 结构化与非结构化数据推理 Reasoning over unstructured and structured data (60 mins)

Cross-modality reasoning, the case of vision-language integration.

Reasoning as set-set interaction.

Query processing.

Context processing.

Dual-attention.

Conditional set functions.

Relational reasoning

Query-conditioned dynamic graph constructions

Reasoning over knowledge graphs.

Graph embedding.

Graph convolutional networks.

Graph attention.

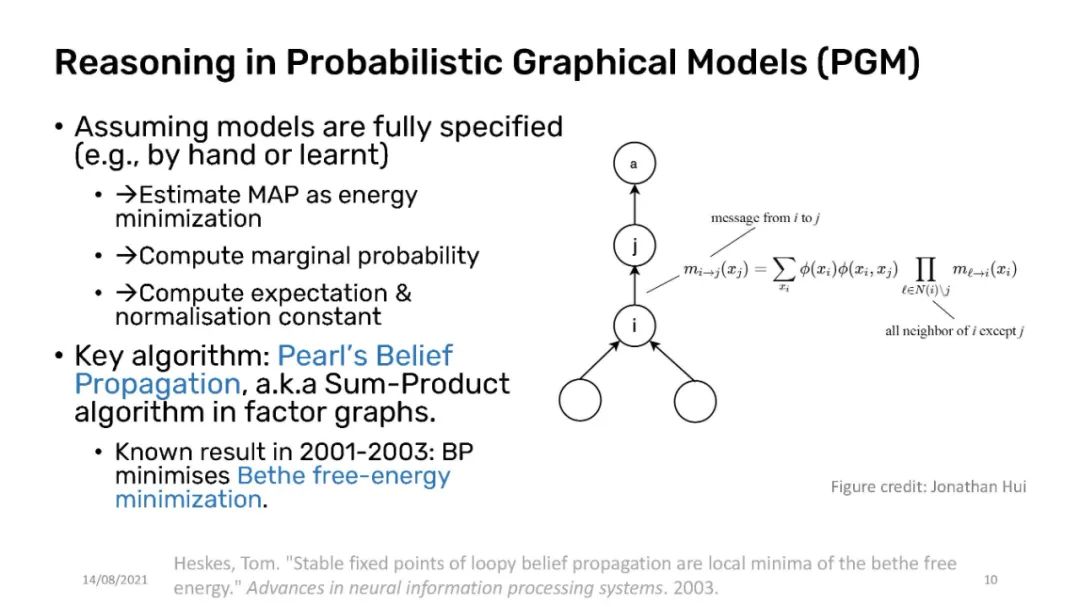

Message passing.

Relation networks

Graph neural networks

Temporal reasoning

Video question answering.

Part C: 高级主题 Advanced topics (60 mins)

Reasoning with external memories

Memory of entities – memory-augmented neural networks

Memory of relations with tensors and graphs

Memory of programs & neural program construction.

Learning to reason with less labels:

Data augmentation with analogical and counterfactual examples

Question generation

Self-supervised learning for question answering

Learning with external knowledge graphs

Recursive reasoning with neural theory of mind.

讲者

参考文献

Jacob Andreas, Marcus Rohrbach, Trevor Darrell, and Dan Klein. “Neural module networks”. In CVPR, pages 39–48, 2016.

Dzmitry Bahdanau, Shikhar Murty, Michael Noukhovitch, Thien Huu Nguyen, Harm de Vries, and Aaron Courville. “Systematic generalization: what is required and can it be learned?”, In ICLR, 2019.

Bottou, Léon. “From machine learning to machine reasoning”. Machine learning 94.2 (2014): 133-149.

---------♥---------

推荐阅读

(点击标题可跳转阅读)

老铁,三连支持一下,好吗?↓↓