替代离线RL?Transformer进军决策领域,「序列建模」成关键

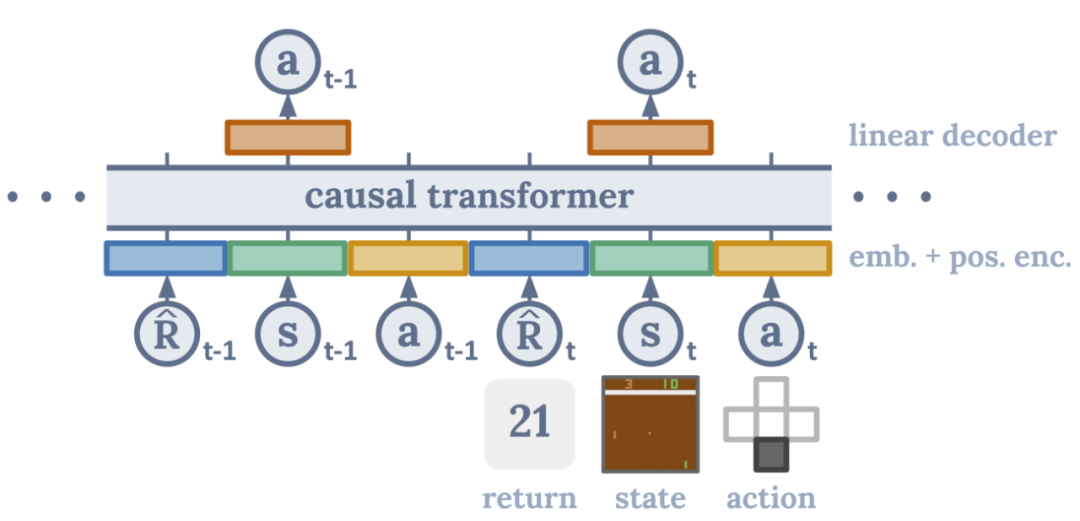

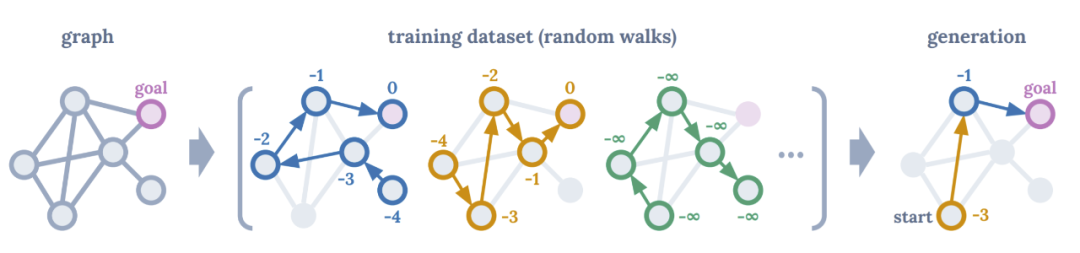

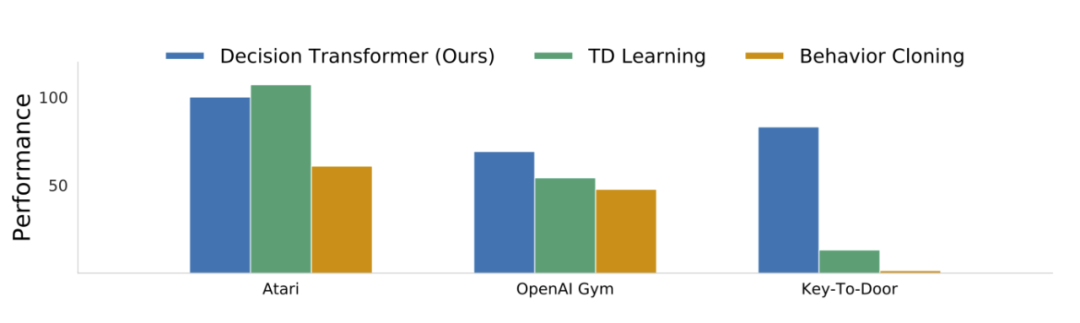

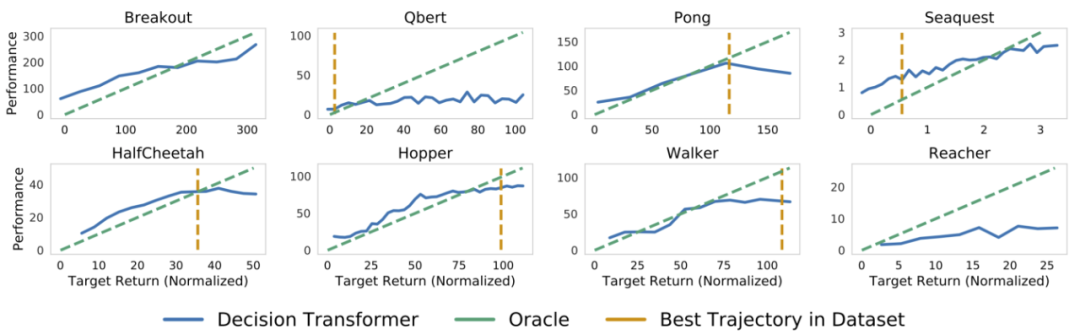

Transformer 开始进军决策领域了,它能否替代离线强化学习呢?近日,UC 伯克利、FAIR 和谷歌大脑的研究者提出了一种通过序列建模进行强化学习的 Transformer 架构,并在 Atari、OpenAI Gym 等强化学习实验平台上媲美甚至超越 SOTA 离线 RL 基线方法。

TD 学习:这些方法中的大多数使用动作空间约束或价值悲观主义,并且将是与 Decision Transformer 最忠实的比较,代表标准的强化学习方法。最先进的无模型方法是 Conservative Q-Learning (CQL),它作为主要的比较方法。此外,研究者还与其他的无模型强化学习算法(如 BEAR 和 BRAC )进行了比较;

模仿学习:这种机制类似地使用监督损失进行训练(而不是 Bellman 备份),并在这里使用行为克隆。

NVIDIA对话式AI开发工具NeMo的应用

8月12日开始,英伟达专家将带来三期直播分享,通过理论解读和实战演示,展示如何使用 NeMo 快速完成文本分类任务、快速构建智能问答系统、构建智能对话机器人。

直播链接:https://jmq.h5.xeknow.com/s/how4w(点击阅读原文直达)

报名方式:进入直播间——移动端点击底部「观看直播」、PC端点击「立即学习」——填写报名表单后即可进入直播间观看。

交流答疑群:直播间详情页扫码即可加入。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

评论