北大数院校友斩获首届SIAM数据科学青年奖,主攻隐私数据保护等

新智元报道

新智元报道

编辑:好困

【新智元导读】SIAM首届数据科学青年奖于近日开奖!苏炜杰凭借着在机器学习算法优化、数据隐私保护、深度学习理论基础和高维统计的突出贡献,成为本次唯一获奖者。

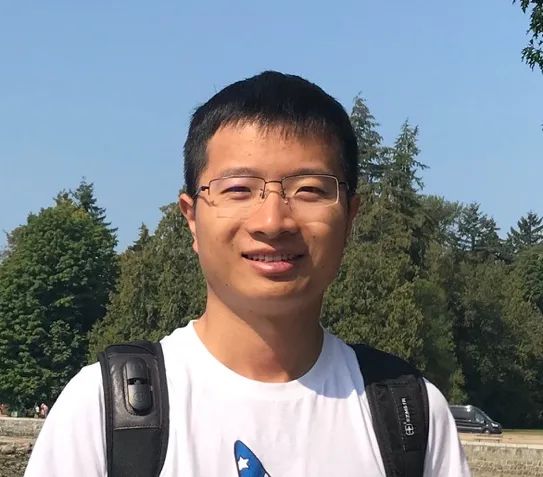

近日,SIAM公布了首届2022年数据科学青年奖得主,北京大学数学科学学院2011届校友、斯坦福大学博士苏炜杰为唯一获奖人。

https://www.siam.org/prizes-recognition/activity-group-prizes/detail/siag-data-early-career-prize

SIAM数据科学青年奖由SIAM(美国工业与应用数学学会)每两年在全世界范围颁发一次,旨在奖励一名在数据科学领域做出杰出贡献的青年学者。

今年评奖委员会包括了德国、美国、比利时和中国香港等多位在应用数学、机器学习和优化领域的国际著名学者。颁奖仪式将在今年9月份在美国圣地亚哥的SIAM数据科学会议上举行。届时苏炜杰将在SIAM大会上作全体特邀报告。

苏炜杰现为宾夕法尼亚大学沃顿商学院统计与数据科学系和工学院计算机系助理教授,以及Facebook访问科学家。苏炜杰教授同时还兼任宾大机器学习研究中心联合主任,以及任职于应用数学和计算数学项目执行委员会。此外还供职于宾大沃顿智能商务中心,Warren网络数据科学中心,和北京智源人工智能研究院青源会。他曾在2019年和2020年分别获得NSF CAREER Award和斯隆研究奖。

苏炜杰的求学经历亦颇为精彩。

他高中两度代表浙江省参加中国数学奥林匹克竞赛,高一即获得清华大学预录取资格,高三获得全国第二名的成绩。2007年至2011年就读于北京大学数学科学学院基础数学方向,期间连续三年获得最高奖学金,专业成绩在基础数学专业中排名年级第一。

在北京大学求学期间,苏炜杰获得了首届丘成桐大学生数学竞赛全能金牌和应用数学金牌,以及代数和分析方向的两枚铜牌。2010年苏炜杰及队友在美国大学生数学建模竞赛中,获得选做B题方向的中国大陆第一名。之后获得斯坦福大学最高等级的博士奖学金,在2016年获得博士学位,其毕业论文获得首届斯坦福Theodore Anderson奖。之后跳过博士后阶段直接执教于宾夕法尼亚大学。

获奖工作简介

苏炜杰教授获得SIAM数据科学青年奖是基于他在机器学习的优化算法、数据隐私保护、深度学习理论基础和高维统计做出的重要贡献。

添加动量(momentum)是优化机器学习模型时常用的一个技巧,比如深度学习三巨头之一、ACM图灵奖获得者Yoshua Bengio一个重要工作指出添加动量可以显著地加快优化深度神经网络。

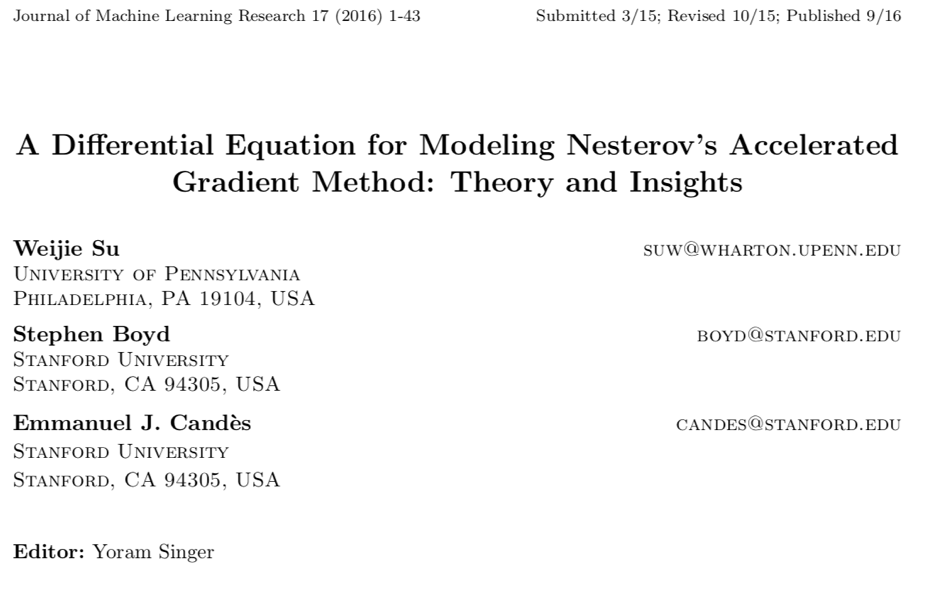

凸优化中著名的Nesterov加速算法,就是在普通梯度下降算法基础上增加了一个动量项,效果提升显著,但其背后的机制一直有待阐明。

论文链接:https://jmlr.org/papers/volume17/15-084/15-084.pdf

苏炜杰的一个代表性工作是对一类添加动量的优化算法提供了一个分析和设计的框架,特别是对Nesterov加速算法提供了一个非常直观的解释[1]。这个框架的核心是用动力系统的连续观点看离散的算法,充分利用「连续数学」的分析优势。

苏炜杰和美国工程院院士Stephen Boyd的美国科学院院士Emmanuel Candes

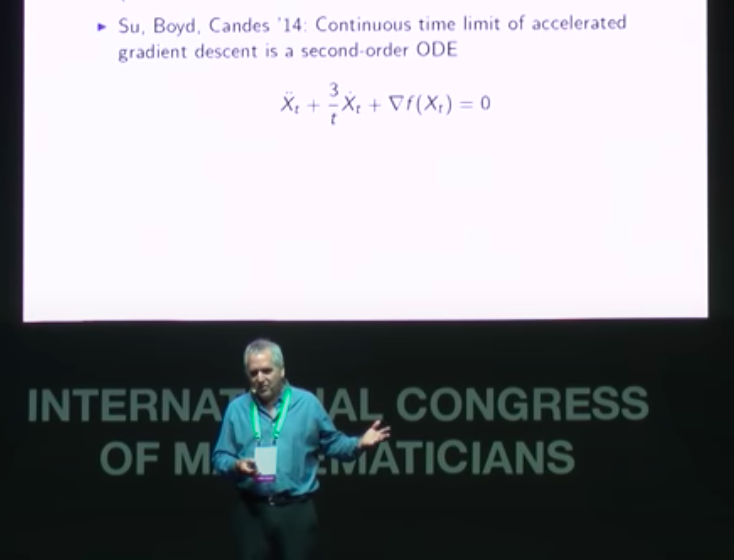

这个工作被众多机器学习理论研究者使用和推广。机器学习泰斗Michael Jordan在2018年里约国际数学家大会1小时报告中,以很大的篇幅介绍了其团队推广苏炜杰教授工作的最新成果。

Michael Jordan在2018年国际数学家大会上介绍如何推广苏炜杰在机器学习优化算法上的工作

苏炜杰的另一个获奖工作是其团队开发的高斯差分隐私(Gaussian Differential Privacy)框架[2]。

论文链接:https://rss.org.uk/RSS/media/Training-and-events/Events/2020/Dong-et-al-jrssb-final.pdf

人工智能中的隐私问题已经被公认为是一个重要并且严肃的问题,2006年美国科学院和工程院两院院士Cynthia Dwork等提出的差分隐私奠定了隐私数据分析的基础。

苏炜杰早年在Mountain View的微软研究院师从Cynthia Dwork时,意识到这个框架在分析一些基本的隐私算法时效率低下,在应用到深度学习时有很大局限性。

高斯差分隐私在英国皇家统计学会的特邀报告

高斯差分隐私创新性地用假设检验的角度来精准地刻画隐私算法,从理论上严格证明了这个新框架具有多个最优性质,该论文作为Discussion Paper受邀在英国皇家统计学会上研读。

苏炜杰团队还成功将高斯差分隐私应用到深度神经网络的训练,在同等隐私保护程度的条件下取得了比Google Brain更高的预测精度。这个新的隐私数据分析框架已经纳入TensorFlow,受到业界关注,并有望应用到某硅谷旗舰大厂的产品中。

苏炜杰近期在深度学习理论上的贡献也是其获奖原因。深层神经网络已经在诸多科学与工程问题上取得了优良的表现,但关于其良好的泛化性能却一直缺乏令人满意的理论解释。

苏炜杰提出了深度神经网络的局域弹性(local elasticity)理论,给神经网络泛化、优化等性质提供了一个简单的唯象理论[3]。

此外,苏炜杰团队提出了一种层间「剥离」的分析模型,对上述问题给出了另一种新思路[4]。

论文链接:https://www.pnas.org/content/118/43/e2103091118

基于神经网络强大的表达能力,这个新模型将网络的部分层看作一个整体,将其输出特征看作一个可以适应网络训练过程的优化变量,着重研究了特征与后继层参数在网络训练中的相互作用。

苏炜杰团队用这个模型深入分析了深度神经网络在训练数据不平衡时的表现,发现了一个新颖且具有重要实际意义的现象。该成果已于近期发表在顶级期刊《美国国家科学院院刊》上。

这个新模型还解释了美国科学院院士David Donoho团队发现的神经坍缩(neural collapse)现象。这个现象表明神经网络的优异性能很大程度来自于几何对称性。

层间「剥离」的分析模型表明神经坍缩来自于在一定约束条件下目标函数最小化的对称性,这个数学上严谨的解释获得了Donoho院士的高度评价。

参考资料:

[1] W. Su, S. Boyd, and E. Candes. A differential equation for modeling Nesterov’s accelerated gradient method: Theory and insights. Journal of Machine Learning Research, 17(1):5312–5354, 2016.

[2] J. Dong, A. Roth, and W. Su. Gaussian differential privacy. Journal of the Royal Statistical Society: Series B (with discussion), 2022.

[3] H. He and W. Su. The local elasticity of neural networks. In International Conference on Learning Representa tions, 2020.

[4] C. Fang, H. He, Q. Long, and W. Su. Exploring deep neural networks via layer-peeled model: Minority collapse in imbalanced training. Proceedings of the National Academy of Sciences, 118(43), 2021.