从OpenAI VPT,看视频预训练

大数据文摘授权转载自李rumor

视频预训练一直是我很期待的方向,毕竟文本的表达是有限的,如果让大模型建立起对世界的多模态认知,可能很多常识知识问题、world model就迎刃而解了。另外互联网的文本数据也逐渐无法跟上Scaling law,下一步必然会走向多模态。

然而直到现在好像也没看到能很好利用视频数据来做Foundation模型的方法,恰好最近又看了OpenAI去年发布的VPT[1]这篇工作,没想到隔一年再回看,跟第一次调研EmbodiedAI时看到的感觉完全不一样。

视频预训练如何做

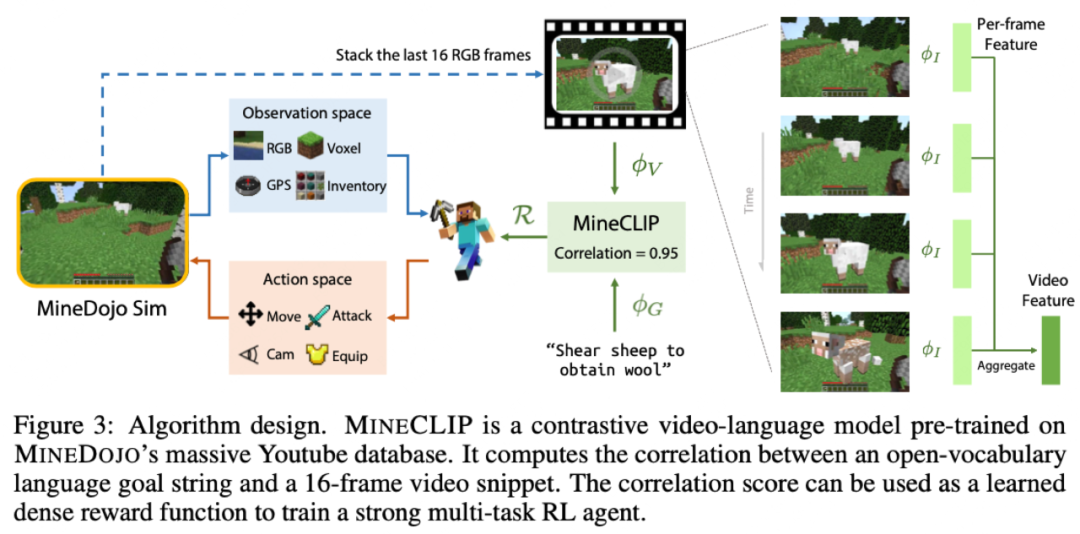

在介绍VPT之前,我们先看一下英伟达同期的工作MineDojo[2]是如何做的。这两篇工作都是以Minecraft游戏为背景,希望利用视频数据训练出一个能完成各种任务的agent,输入是图像(+文本),输出agent要执行的动作。

MineDojo采取了传统RL的思路,先定义任务的reward,再用RL算法一把梭,就学会了。但作者一盘发现,其实有两类任务:

程序化任务,比如存活多少天、打败多少敌人,这种目标模拟器里很好计算结果,直接作为奖励即可。

创造性任务,比如骑着猪跑,这类就很不容易了,没法一个个用规则去写奖励函数。

于是难点就来了,如何找到合适的reward呢?作者灵机一动,利用Youtube上的各种视频,抽出其中的图像和字幕,训练一个类似CLIP的模型MINECLIP。在RL训练阶段,直接用MINECLIP计算当前游戏界面和prompt的相似度,作为奖励。

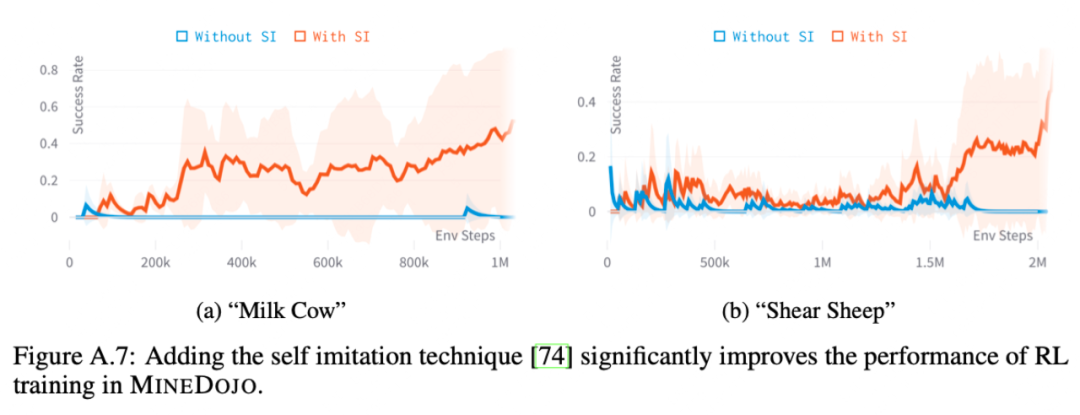

由于RL收敛比较慢,作者也采用了不少方法加速训练,其中很重要的一点是Self-Imitation Learning,直接把拿到高奖励的动作序列保存下来去学习,就像SFT一样去学习,效果提升很明显(红色线):

看了MineDojo利用视频预训练改进传统RL之后,再看OpenAI的VPT就很不一样,两者完全是不同的思路,可以说MineDojo是用RL的范式,而VPT是用LLM的范式,即Pretrain+SFT+RL。另外值得注意的一点是,VPT发表于22年6月,同时文中还注明这个工作已经进行了一年之久。也就是说OpenAI从21年中就已经开始研究agent、视频预训练这些topic了。

我特意查了一下VPT作者,并没有人参与InstructGPT,不知道两个项目是否有交流,但不少VPT的作者在简介里都说了自己正在参与语言大模型的工作。

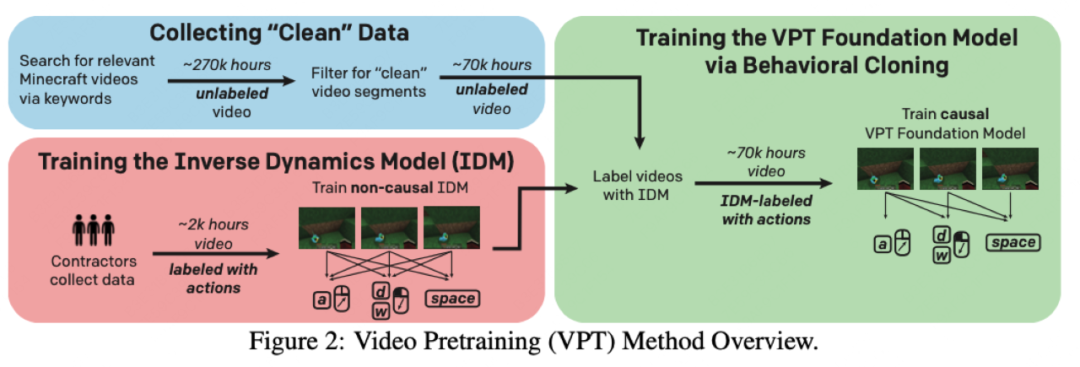

只能说OpenAI把这套范式玩明白了,训什么都用这个思路。但其中有个难点,就是预训练的时候视频数据没有自监督信号,因为模型要输出的是动作,而不是下一个画面。

于是他们想了一个简单粗暴的解决办法,就是先让标注人员去玩游戏,记录他们的游戏画面和对应的动作(键盘、鼠标),再用这批数据训练一个模型(Inverse Dynamics Model),去给所有的视频数据预测出标签。这样就可以进行自回归视频预训练了。预训练的数据量是70k小时的视频,大概5B的token,模型参数量在0.5B。

得到视频预训练模型之后,对于特定的任务,可以直接利用人工标注数据进行精调,同时可以再进行RL,作者发现Pretrain+SFT+RL三步之后效果奇佳,模型可以完成非常复杂的任务(人类需要20分钟才能完成)。

同时,VPT也尝试了加入字幕、音频转文字后的数据进行多模态训练,但由于数据太少,只展现了微弱的可控性,不过当下再来看文本可控并不是难点,已经有很多成功的工作了。

看完VPT,再来对比一下MineDojo,可以发现LLM范式一个明显的优点,即提升了训练效率和效果天花板,因为纯RL要靠自己探索,其实收敛的很慢,而且有些复杂的任务需要很长的链路,纯RL可能根本探索不到。

通用视频预训练?

虽然VPT证明了LLM的范式在视频预训练同样可行,但个人认为还有两个比较关键的问题:

图像与文本的预训练数据不兼容:目前互联网的语料都是图像或者文字一方占主导,所以后续大概率是和现在一样,两种模态分别预训练,再通过少量数据融合。

VPT的方法不够通用:像NLP一样进行通用领域的视频预训练还有很长的路要走。首先VPT在准备训练语料时,需要定义标签的动作空间,目前只局限在鼠标和键盘,但真实世界中的动作太多了;另外很多领域的监督数据也不一定好获取,比如需要真人出镜的视频成本会很高。

VPT这篇工作在去年推出时并没有引起太大火花,如今想一想,虽然存在上述问题,但在一些垂类场景上已经有落地的可能了,比如在excel上做数据分析、做PPT、操作photoshop等。

再一想,OpenAI居然前年就开始做这些事儿了,真可怕。

参考资料

[1]Video-Pre-Training: https://cdn.openai.com/vpt/Paper.pdf

[2]MineDojo: https://minedojo.org/

点「在看」的人都变好看了哦!

评论