DeepMind AI 科学家:2020年NLP和ML领域十大研究进展

来源 | AI科技评论 编译 | bluemin

DeepMind NLP科学家Sebastian Ruder在这篇文章中概述了2020年机器学习和自然语言处理领域在10个振奋人心和影响深远的研究方向上的进展。

注:领域和方法的选择在很大程度上取决于作者自己的兴趣;所选的主题偏向于表征和迁移学习以及自然语言处理(NLP)。

作者试图囊括知晓的全部论文,但未必会面面俱到,请读者随时在下方的评论区中补充相关要点。

总之,作者将讨论以下研究亮点:

1.大型高效的模型

2.检索增强

3.小少本样学习

4.对比学习

5.准确率不是模型评估的唯一指标

6.大型语言模型的实际应用问题

7.多语种

8.图像处理与Transformer模型

9.自然科学与机器学习

10.强化学习

1

大型高效的模型

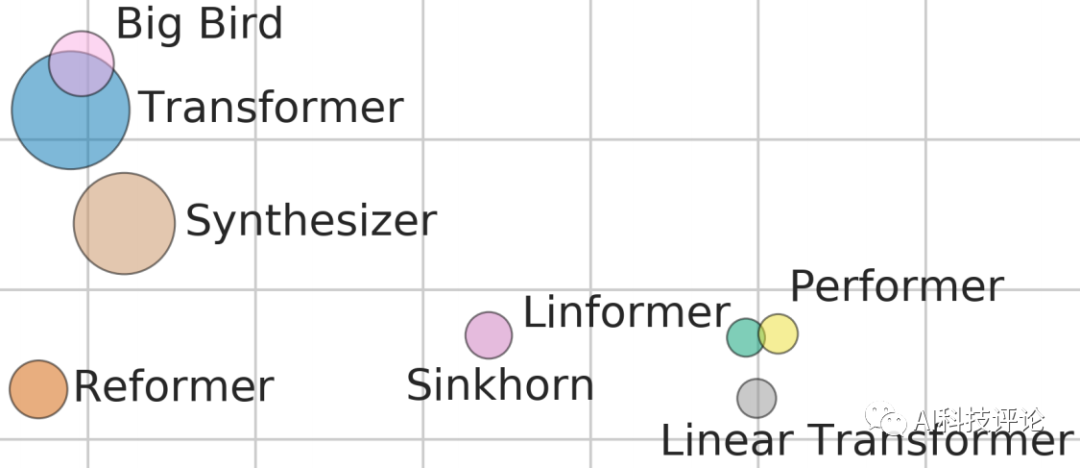

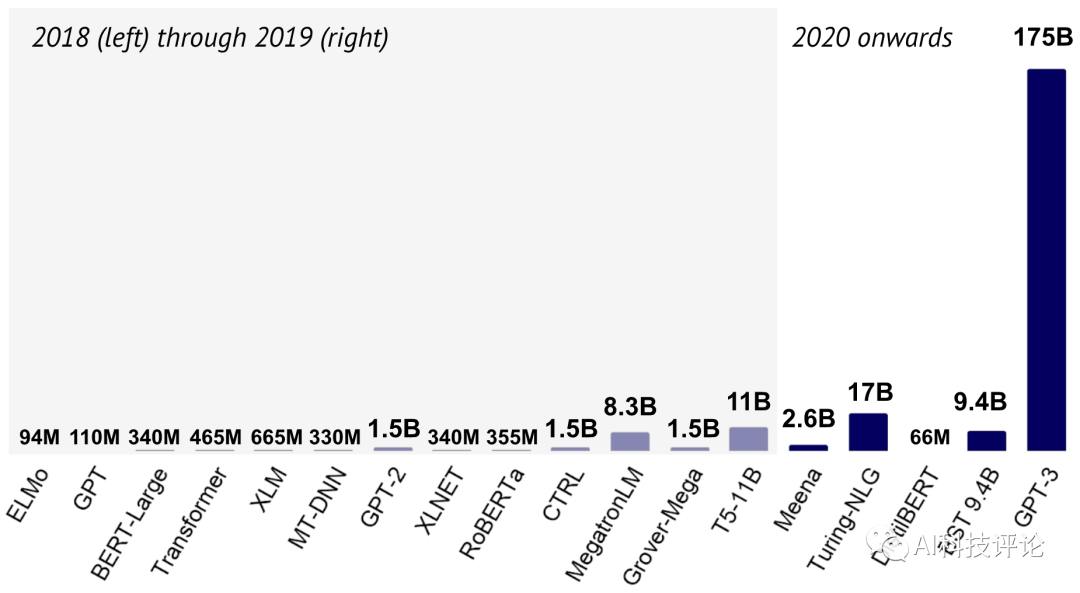

2018-2020年语言模型的规模发展图(图片来源:2020人工智能发展报告)

2018-2020年语言模型的规模发展图(图片来源:2020人工智能发展报告)

2020年发生了什么?

2020年见证了语言与对话模型的规模日益宏大,比如聊天机器人Meena 、图灵-自然语言生成模型、BST模型和GPT-3模型。

与此同时,研究人员也逐渐意识到这些模型存在成本高和能源消耗大的问题,从而专注于设计规模更小的模型并取得了一定的进展:最新的方法依赖于剪枝、量化、蒸馏和压缩。其他方法侧重于提高Transformer架构本身的效率。这一系列的模型包括Performer和Big Bird,如上方的封面图片所示。封面图中显示了在Long Range Arena基准下不同模型的性能(y轴)、速度(x轴)和内存占用(圆圈大小)情况。

实验冲击跟踪器等工具的应用令模型的能源效率追踪变得轻而易举。这些工具的应用也促进了主要基于效率评估模型的竞赛和基准环境的发展,如EMNLP 2020的SustaiNLP研讨会、NeurIPS 2020的高效问答竞赛和HULK基准平台。

为何如此重要?

扩大模型规模使我们能够不断突破现有模型的极限。然而,为了在真实场景中实现部署和应用,这些模型必须高效。最终,这两个方向相得益彰:压缩大型模型催生出具有强大性能的高效模型,而更有效的方法可能会推动性能更强、规模更大的模型的发展。

未来趋势如何?

作者希望,随着人们对效率和工具可用性的日益关注,研究重点将不仅仅局限于模型的性能和参数数量,对能源效率的关注会更加普遍。这有助于人们进行更全面的评估,进一步弥合机器学习研究与实际应用之间的差距。

2

检索增强

利用REALM进行无监督预训练;检索器和编码器实行联合预训练

2020年发生了什么?

大型模型从预训练数据中学到了惊人数量的全局知识,这使其可以重现事实,甚至在没有外部上下文语境的情况下也可以回答问题。

但是,将这些知识隐式存储在模型的参数中效率很低,并且需要越来越大的模型来保留更多信息。取而代之的是,最新的方法联合训练了检索模型和大型语言模型,这在知识密集型自然语言处理任务(如开放域问答和语言建模)上成果卓著。

这些方法的主要优点是将检索直接集成到语言模型的预训练中,从而使语言模型能够更有效地减少事实记忆,专注于学习自然语言理解中更具挑战性的概念。因此,NeurIPS 2020高效问答竞赛中的最佳系统全依赖于检索。

为何如此重要?

检索是许多生成任务的标准,例如文本摘要或对话,并且在很大程度上已被抽象生成所取代。检索增强生成能够将两个方面的优点结合起来:检索片段的事实正确性和可靠性以及所生成文本的相关性和构成性。

未来趋势如何?

检索增强生成对于处理过去困扰生成神经模型的失败案例行之有效,例如处理幻觉。通过直接为系统的预测提供证据,从而可能有助于提高系统的可解释性。

少样本学习

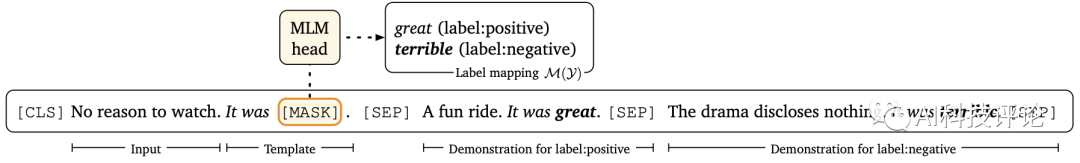

基于提示的微调使用模板化提示和演示

基于提示的微调使用模板化提示和演示

2020年发生了什么?

在过去的几年中,由于预训练的进步,执行给定任务的训练示例的数量逐渐减少。我们现在处于可以使用数十个示例来演示给定任务的阶段。

少样本学习的一个非常自然的范例是将任务重构为语言建模。这方面最突出的实例是GPT-3的上下文学习方法,它基于模型上下文中输入-输出对的一些演示数据以及没有任何梯度更新的提示来进行预测。但是,此设置存在一些局限性:上下文学习方法需要一个规模庞大的模型(在没有任何更新的情况下,模型需要依赖现有的知识),该模型可以使用的知识量受到其上下文窗口的限制,并且提示需要手工设计。

最近的研究试图通过利用更小的模型、集成微调和自动生成自然语言提示使这种小样本学习更有效。这项工作与可控神经文本生成的更广泛领域密切相关,该领域寻求广泛地利用强大的预训练模型的生成能力。获取精彩概述,请查阅Lilian Weng的博客文章。

少样本学习可以使模型快速适应许多任务。更新每个任务的全部模型参数是一种浪费。取而代之的是,最好进行局部更新,对一小部分参数进行集中更改。有几种方法使这种有效的微调更加实用,包括使用adapter、添加稀疏参数向量和仅修改偏差值。

为何如此重要?

仅仅根据几个范例教会模型完成一项任务,大大降低了在实践中应用ML和NLP模型的门槛。这使模型能够快速适应新的领域,在数据收集成本非常高的情况下为应用的可能性开辟了道路。

未来趋势如何?

对于许多实际场景,可以收集成千上万的训练示例。

因此,模型应该能够在小样本学习和大规模样本学习间无缝切换,并且不应受到如上下文长度的限制。鉴于在整个训练数据集上进行微调后,模型已经在许多热门任务(例如SuperGLUE)上实现了超越人类的性能,因此提高其小样本学习的性能是一个自然而然地需要改进的领域。

4

对比学习

实例判别将同一图像的不同变换之间的特征相互比较

2020年发生了什么?

对比学习——学习区分正样本和负样本(通常是噪声分布)——例如,使用负采样或噪声对比估计是表征学习和自监督学习的主要内容,也是word2vec等经典方法的重要组成部分。近期,对比学习在计算机视觉和语音的自监督表征学习中占流行趋势。新一代日益强大的用于视觉表征学习的自监督方法,依赖于使用实例辨别任务的对比学习:不同的图像被视为负样本对,同一图像的视图被视为正样本对。最新的方法进一步完善了这一总体框架:SimCLR定义了增强示例的对比损失,动量对比度旨在确保有大量且一致的样本对,SwAV利用在线聚类,BYOL仅采用正样本对。Chen and He (2020)进一步提出了一种与先前方法有关的更简单的表述。

最近,Zhao et al. (2020) 发现数据增强对于对比学习至关重要。这可能解释了在数据增强不太普遍的NLP中,使用大型预训练模型进行无监督的对比学习失败的原因。他们还假设,在计算机视觉中,实例判别比有监督的预训练效果更好的原因是,实例判别不会尝试使一个类中的所有实例的特征相似,而是保留每个实例的信息。这在NLP中不成问题,因为无监督的预训练涉及对成千上万个单词类型进行分类。在NLP中,Gunel et al. (2020) 最近采用对比学习进行监督微调。

为何如此重要?

语言模型中常用的独热标签和模型输出对数之间的交叉熵目标存在一些局限性,例如对不平衡类的泛化能力很差。对比学习是一种替代性的补充范式,可以帮助缓解其中的某些不足。

未来趋势如何?

对比学习与掩码语言建模相结合可以使我们学习到更丰富、更鲁棒的表征。它可以帮助对异常值和罕见的句法和语义现象进行建模,这是当前NLP模型的一个挑战。

5

准确率不是模型评估的唯一指标

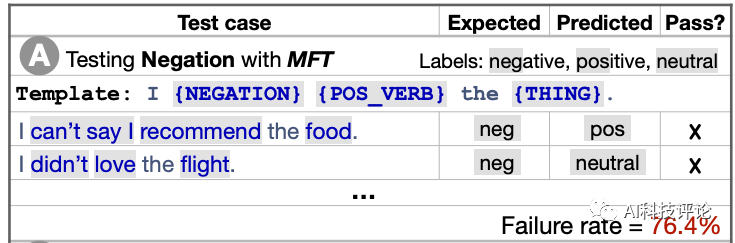

情感分析中否定理解的检查表模板与测试

情感分析中否定理解的检查表模板与测试

2020年发生了什么?

NLP中的SOTA模型已在许多任务上实现了超越人类的性能。

无论我们是否相信这样的模型能够实现真正的自然语言理解,我们知道当前的模型对此目标仍是望尘莫及。但是,我们任务的简单性能指标无法捕获现有模型的局限性。

该领域有两个关键主题:

a)策划当前模型难以实现的示例;

b)不只选择诸如准确率之类的简单指标,而要进行更细粒度的评估。

对于前者,常用的方法是在数据集创建过程中使用对抗性过滤,以过滤出当前模型正确预测的示例。最近的工作提出了更有效的对抗性过滤方法和迭代数据集创建过程,其中对示例进行了过滤并且模型经过多轮训练。Dynabench平台提供了此类不断发展的基准测试的子环境。

关于第二点的方法在本质上是相似的。但是,不是创建针对特定模型的示例,而是使用示例来探索感兴趣的任务所共有的现象。通常,创建最小对立体(也称为反事实示例或对比集),以最小化的方式干扰示例,并经常更改重要的标签。Ribeiro等人(2020) 在其CheckList框架中将一些基本的直觉信息公式化,这使得这种测试用例的半自动创建成为可能。或者,可以基于不同的属性来刻画示例,从而可以对模型的优缺点进行更细粒度的分析。

为何如此重要?

为了在建立更有效的机器学习模型方面取得有意义的进展,我们不仅需要了解一个模型是否优于先前的系统,还需要了解它会产生什么样的错误以及它无法捕捉到哪些现象。

未来趋势如何?

通过对模型行为进行细粒度诊断,将更容易识别模型的缺陷并提出相应的解决方案。同样,细粒度的评估可以更细致地比较不同方法的优缺点。

6

大型语言模型的实际应用问题

模型根据看似无害的提示产生有害内容

模型根据看似无害的提示产生有害内容

2020年发生了什么?

与2019年相比,语言模型(LMs)的分析主要集中在此类模型所捕获的句法、语义和全局知识方面(请参见 (Rogers et al., 2020) 了解详细概述),最近的分析揭示了一些实际问题。研究发现,预训练的语言模型容易生成有害语言和泄漏信息,微调后容易受到后门攻击,从而使攻击者操纵模型的预测结果,并且易受模型和数据提取攻击的侵害。此外,众所周知,经过预训练的模型可能捕获有关受保护属性(例如性别)的偏见,请参见 (Sun et al., 2019) 关于缓解性别偏见的优秀调查。

为何如此重要?

大型的预训练模型受到许多研究机构的训练,并在实际场景中得到积极部署。因此,我们不仅要意识到模型存在的偏见问题,知道哪种行为可能会产生实际有害的后果更是重中之重。

未来趋势如何?

随着规模更大、效力更强的模型的开发,从一开始就将这些实际忧思以及与偏见和公平相关的问题纳入开发环节非同小可。

7

多语种

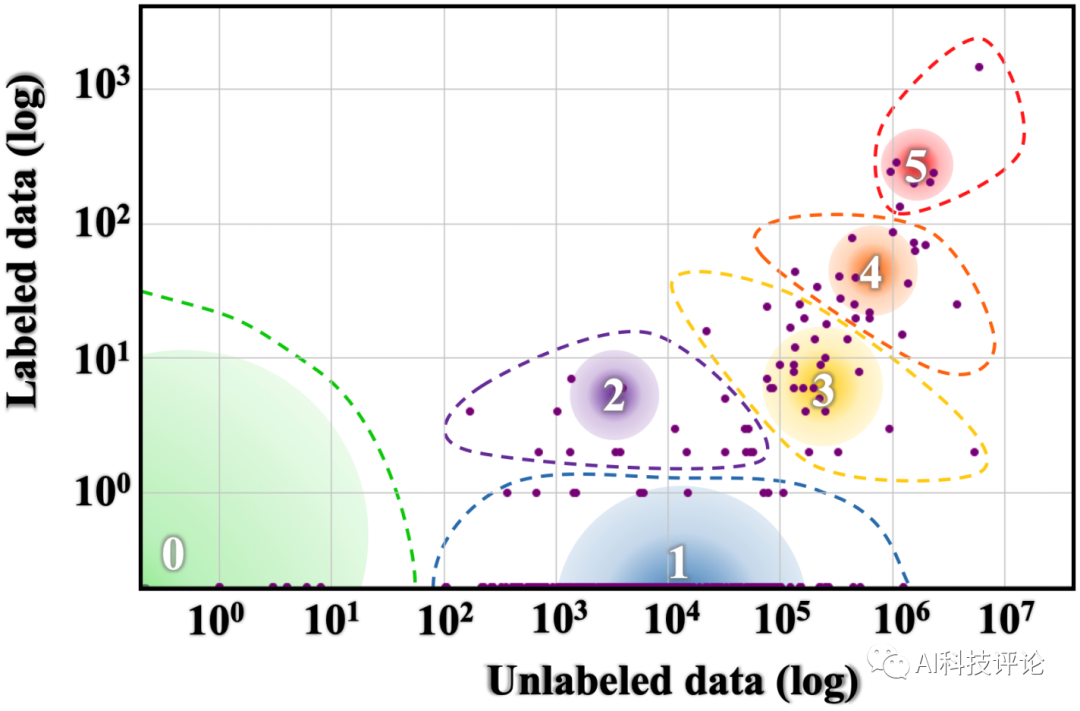

世界各地标注和未标注语言数据的不平等分布图。

世界各地标注和未标注语言数据的不平等分布图。

2020年发生了什么?

2020年在多语种NLP领域有许多研究亮点。Masakhane组织的使命是推动非洲语种的NLP研究,该组织在第五届机器翻译会议(WMT20)上发表了主题演讲,这是去年最鼓舞人心的演讲之一。其他语言的新通用基准相继涌现,包括XTREME、XGLUE、IndoNLU和IndicGLUE 。以其他语言复制的现有数据集以及它们的非英语变体包括:

SQuAD数据集:跨语言问答数据集XQuAD、多方向对齐提取问答数据集MLQA 和法语问答数据集FQuAD;

自然问题:类型多样化语言问答系统TyDiQA,多语种知识问答系统MKQA;

多体裁自然语言推理:原始中文自然语言推理数据集OCNLI,针对波斯语言的自然语言推理数据集FarsTail;

计算自然语言学习-09数据集:X-SRL数据集;

美国有线电视新闻网/每日邮报数据集:多语种概要数据集MLSUM。

通过Hugging Face数据集可以轻松访问上面列举的许多数据集以及许多其他语种的数据集。涵盖了约100种语言的强大的多语言模型应运而生,包括XML-R、RemBERT 和 InfoXLM等等(有关概述,请参阅XTREME排行榜)。已经针对英语以外的语言训练了大量特定于语言的BERT模型,如AraBERT和IndoBERT ;有关概述,请参阅 (Nozza et al., 2020; Rust et al., 2020)。借助AdapterHub,Stanza和Trankit等高效的多语种框架,世界上许多语言的建模和应用将轻而易举。

最后,今年激发作者在这一领域思考的两篇立场论文是:《The State and Fate of Linguistic Diversity and Inclusion in the NLP World》和《Decolonising Speech and Language Technology 》。第一篇强调了研究英语以外的语言的紧迫重要性,第二篇则告诫人们不要把语言社区及其数据当作一种商品。

为何如此重要?

从事英语以外的NLP研究受益匪浅:不仅给ML和NLP领域带来了有趣的挑战,尤其是在其他方面也对社会产生了巨大的影响。

未来趋势如何?

鉴于不同语种的数据和模型的可用性,这一阶段将在英语以外的语言方面取得有意义的进展。最振奋人心的是开发出能够应对最具挑战性的环境的模型,并确定在哪些情况下,我们当前模型所依据的假设会失败。

图像处理与Transformer模型

视觉Transformer模型将Transformer 编码器应用于扁平化的图像块。

视觉Transformer模型将Transformer 编码器应用于扁平化的图像块。

2020年发生了什么?

尽管Transformer模型在NLP中取得了巨大的成功,但直到最近,它们在计算机视觉领域的成就仍然不高,而卷积神经网络(CNN)仍然占据着主导地位。虽然早期的模型如DETR采用CNN计算图像特征,但后来的模型完全没有应用卷积。图像GPT模型将GPT-2方法直接应用于像素的预训练,其性能优于有监督的Wide ResNet。后来的模型都将图像重塑为图像块,这些图像块被视为“token”。

Vision Transformer模型在数百万个标记图像上进行了预训练,每个图像均由此类图像块组成,其性能优于最新的CNN模型。Image Processing Transformer模型通过对比损失对受损的ImageNet示例进行预训练,并在低级图像任务上实现了SOTA性能。

Data-efficient image Transformer模型利用蒸馏方法在ImageNet数据集上进行预训练。有趣的是,他们发现CNN是更好的老师。这一发现类似于将归纳偏置蒸馏到BERT模型中。与语音相反,Transformer模型并未直接应用于音频信号领域,而是通常接收编码器(例如CNN等)的输出作为输入。

为何如此重要?

与CNN和RNN相比,Transformer模型的归纳偏置更弱。虽然理论上不如RNN强大,但给定充分的数据和庞大的规模,事实证明,Transformer模型最终超越了归纳偏置较强的“竞争对手”(请参阅 The Bitter Lesson)。

未来趋势如何?

我们可能会看到Transformer模型在计算机视觉领域方兴未艾。Transformer模型将特别适用于算力充足、数据充分的无监督预训练场景。但在规模较小的环境中,CNN可能仍将是首选方法,并且是可靠的基准。

9

自然科学与机器学习

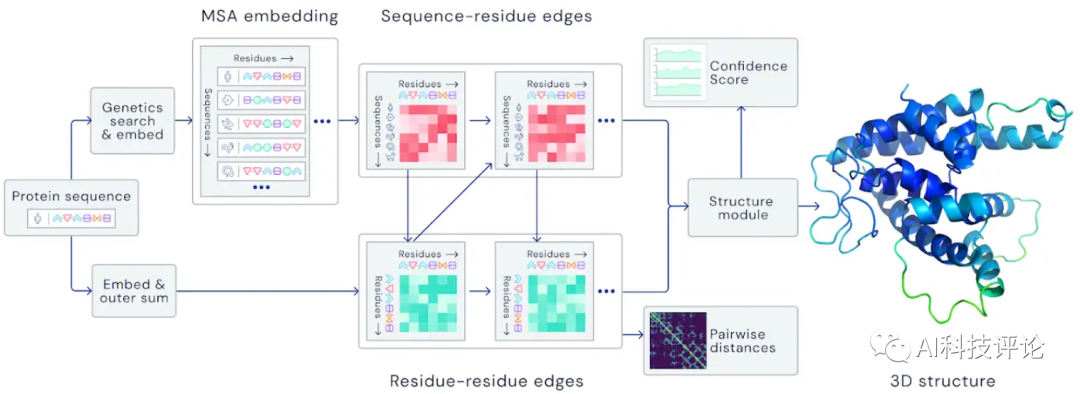

基于自注意力机制的AlphaFold体系结构(图片来源:DeepMind博客)

基于自注意力机制的AlphaFold体系结构(图片来源:DeepMind博客)

2020年发生了什么?

亮点之一是AlphaFold在一年两届的CASP蛋白质折叠挑战赛中大放异彩。除此之外,在将ML应用于自然科学中的问题方面还有其他一些值得关注的进展。MetNet在降水预报方面优于数值天气预报, Lample 和 Charton 使用神经网络求解微分方程的效果优于商业计算机代数系统,Bellemare 等人使用强化学习在平流层中导航气球。

此外,ML已被广泛用于帮助应对仍在持续的COVID-19大流行,例如预测COVID-19的传播情况,预测与COVID-19相关的结构,将相关数据翻译成35种不同的语言,以及实时回答有关COVID-19的问题。欲了解与COVID-19相关的NLP应用的概述,请查阅第一届COVID-19 NLP研讨会的论文集。

为何如此重要?

自然科学可以说是ML最有影响力的应用领域。自然科学的进步惠及生活的许多方面,并且可以对世界发展产生深远的影响。

未来趋势如何?

随着蛋白质折叠等核心领域的进步,ML在自然科学中的应用速度只会加快马加鞭。期待对世界上产生积极影响的更多基本进展不断涌现。

10

强化学习

与最先进的智能体相比,就游戏场数而言,整个训练过程中Agent57和MuZero在Atari游戏上的表现均优于人类基准。

2020年发生了什么?

单一的深度强化学习智能体——Agent57,第一次在全部57款Atari游戏中都取得了超越人类的性能,这是深度强化学习文献中的长期基准。智能体的多功能性源自神经网络,该神经网络使智能体在探索性策略和利用性策略之间自由切换。另一个里程碑是MuZero的开发,它预测了对精确规划最重要的环境方面的内容。在没有任何游戏动态知识的情况下,MuZero在Atari游戏上实现了SOTA性能,在围棋、象棋和将棋上也实现了超越人类的性能。最后,Munchausen 强化学习智能体基于朴素的、理论上成立的修改对SOTA智能体进行了改进。

为何如此重要?

强化学习算法具有许多实际意义。通过实现更好的规划、环境建模和动作预测,对该领域中基本算法的改进可能会产生很大的实际影响。

未来趋势如何?

随着经典的基准测试问题(如Atari游戏)基本得到解决,研究人员可能会寻找更具挑战性的环境来测试他们的算法,例如推广到外分布任务,提高样本效率,多任务学习等。

原文链接: https://ruder.io/research-highlights-2020/