论文介绍:Squeeze-and-Excitation Networks

SENet,斩获了ILSVRC 2017竞赛分类任务的冠军,而ILSVRC有人工智能“世界杯”之称。这么强悍的网络,有必要认识认识。

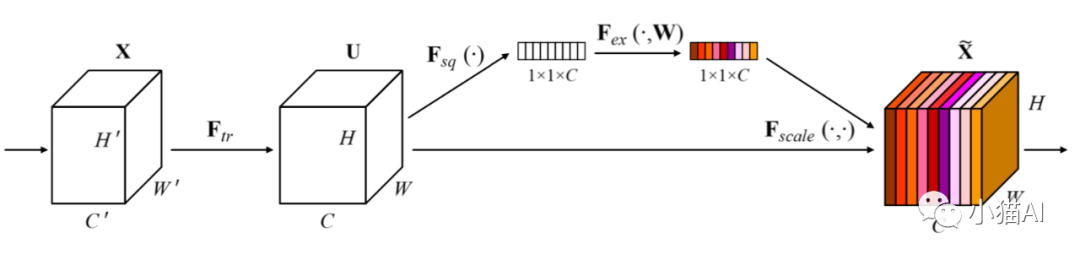

当我看了几篇关于它的博客之后,第一感觉是,就这?就一点点东西。准确地讲,SENet不是一个网络,而是一个模块,可以嵌入到任何卷积神经网络里,这个模块叫做Squeeze-and-Excitation (SE) block。SE block长这样:

- Squeeze对特征图的每个通道取平均。假设特征图尺寸为HxWxC,取平均后得到长度为C的向量(上图黑白的1x1xC长条)。

- Extract长度为C的向量经过一个全连接层,得到长度为C/r的向量,然后再经过一个全连接层,得到长度为C的向量(上图彩色的1x1xC长条),这个向量就是各个通道的权重。得到各通道的权重后,将权重与特征图相乘,得到加权后的特征图(上图彩色的HxWxC立方体)。两个全连接层把向量的长度先缩小再放大是为了减少模型参数,论文里的r取值为8。第一个全连接层的激活函数为relu,第二个全连接层的激活函数为sigmoid。为什么用sigmoid?试出来的。

评论