ORDNet:为场景分割捕获全范围依赖关系

点击上方“深度学习爱好者”,选择加"星标"或“置顶”

重磅干货,第一时间送达

学习捕捉空间位置之间的依赖关系对于许多视觉任务是至关重要的,特别是像场景解析这样的密集标记问题。现有的方法可以有效地利用自我注意机制捕获长期依赖,而通过局部卷积捕获短期依赖。然而,长期依赖与短期依赖之间仍存在很大的差距,这极大地降低了模型在复杂自然场景图像中适用于不同空间尺度和关系的灵活性。为了填补这一空白,作者开发了一个中程(MR)分支,通过将自己的注意力限制在局部补丁中来捕获中程依赖关系。此外,作者观察到,可以强调与其他区域有较大相关性的空间区域,从而更准确地利用长期依赖关系,从而提出一个重新权衡的远程(RLR)分支。在提出的MR和RLR分支的基础上,作者构建了一个能有效捕获短期、中期和长期依赖的全范围依赖网络(ornet)。作者的ORDNet能够提取更全面的上下文信息,并能很好地适应场景图像中复杂的空间方差。大量的实验表明,作者所提出的ORDNet在三个场景分析基准测试(包括PASCAL Context、COCO Stuff和ADE20K)上优于之前的最先进的方法,证明了在场景分析任务的深度模型中捕获全方位依赖关系的优越性

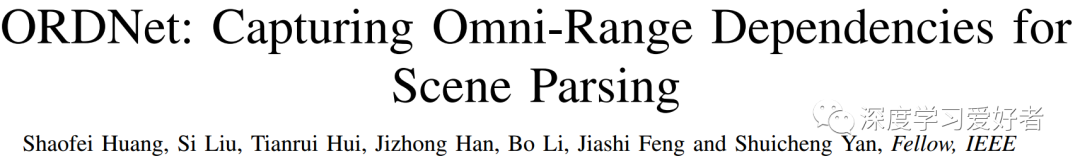

利用新提出的MR和RLR分支,作者构建了一个全方位依赖网络(ornet),其中短程依赖、中程依赖和重新评估的长期依赖无缝协作,实现了对自然场景图像中不同空间区域内容和关系的适应性。ORDNet是通用的,可以应用于任何FCN骨干,学习更多的判别特征表示。

作者的主要贡献总结如下:

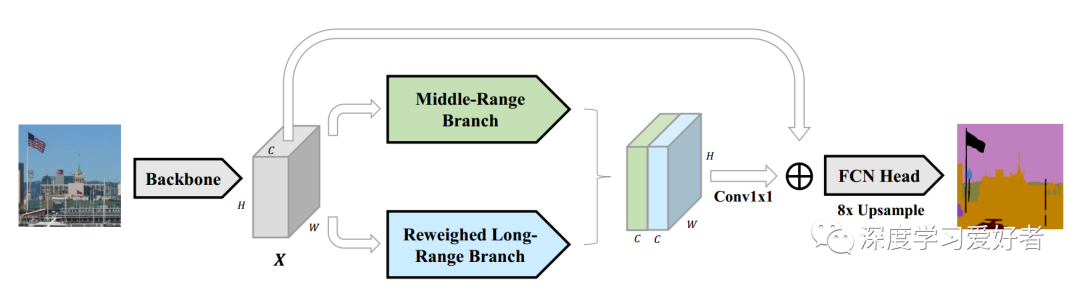

作者设计了一个中程分支来明确捕捉场景图像局部补丁中的中程依赖,填补了长期依赖和短期依赖之间的空白。

作者还提出了一个重新权衡的远程(RLR)分支,以强调编码共同模式的位置特征,从而可以捕获更准确和适应性的远程依赖关系。

利用上述两个分支,作者开发了一种新的全范围依赖网络(ornet),该网络有效地集成了近程、中程和重估的长程依赖,提取全面的上下文信息,以实现准确的场景解析。

作者的ORDNet在PASCALContext、COCO Stuff和ADE20K数据集这三个流行的场景解析基准上优于之前的最先进的方法,这很好地证明了它的有效性。

提出的全范围依赖网络(ornet)的结构。给定一幅输入图像,将提取的CNN骨干特征X输入到一个中程(MR)分支和一个重称重远程(RLR)分支中,分别捕捉中程依赖和重称重远程依赖。这两个分支的输出然后连接沿通道维数和融合一个11卷积。添加了X的标识跳过连接以简化优化。融合后的特征被送入FCN头部预测logit映射,然后更新8次得到最终的解析掩码。

拟建的中程(MR)管道分支。这个分支包含3个步骤。首先,将输入特征X2 RH W C划分为2个2个patch,即[X1, X2, X3, X4],按行排序。其次,每个patch分别通过一个自我注意模块进行增强,得到Ym 2 R4 H2 W2 C作为中间输出。第三,将Ym恢复到相同大小的输入特征,得到Zm作为最终输出。

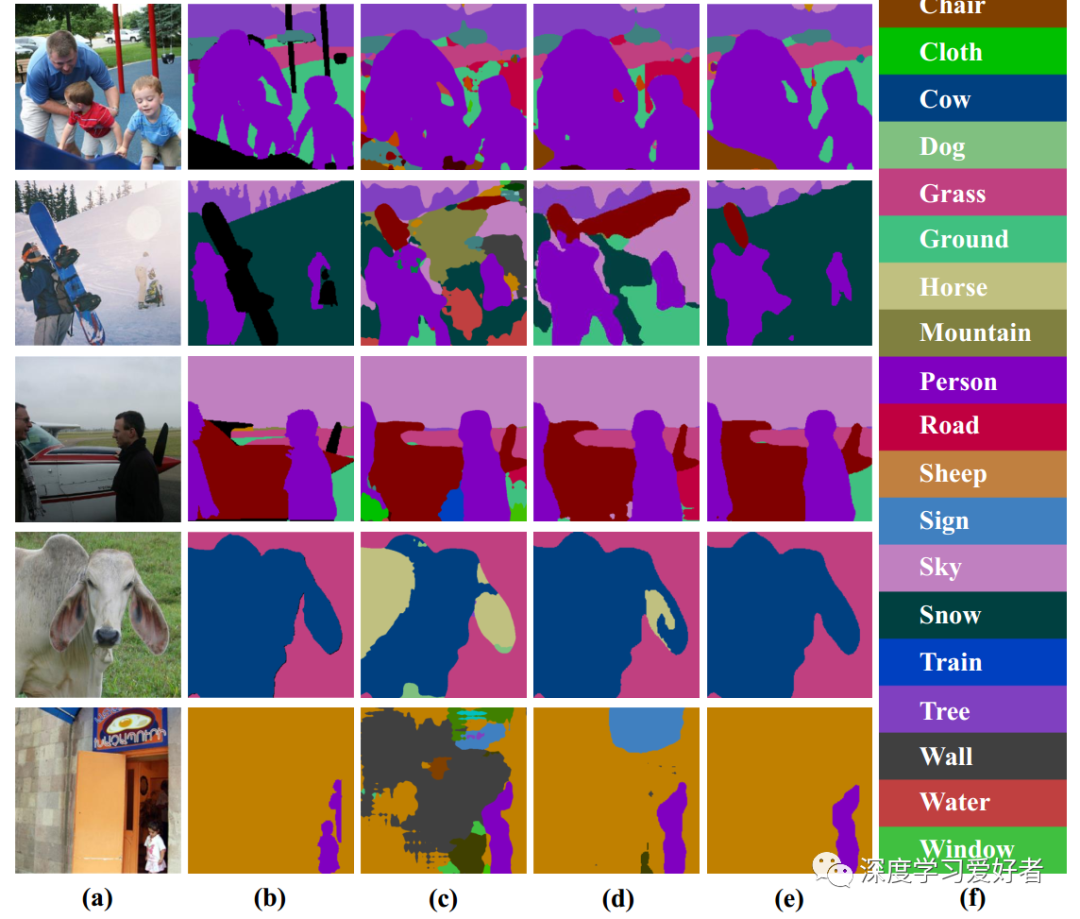

在PASCAL-Context测试集上与基线扩张FCN和基本SA定性比较。(a)原始图像。(b)真实mask。(c) FCN扩张结果。(d)基础SA结果。(e)作者订单网的结果。(f)语义范畴的联想。

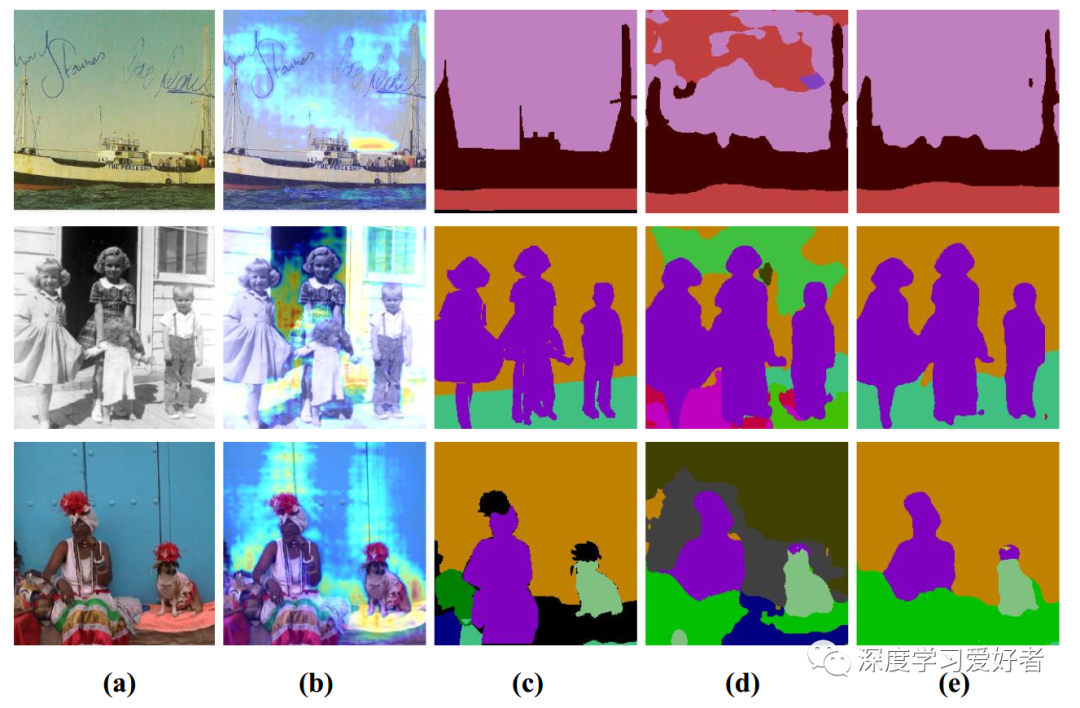

注意图的可视化与自我注意方法和RLR分支的分析结果。(一)原始图像。(b)全局注意力权重贡献图的可视化。全局注意力权重贡献图是每个位置对其他位置的注意力权重之和。(c) Groundtruth标签地图。(d)基本自我注意的解析结果。(e)解析RLR分支的结果。从(d)中可以看出,大面积连续的背景通常对其他位置的注意力权重贡献更大,例如第二排的天空,第四排的墙壁。通过强调这些区域,作者的RLR分支可以纠正基本注意的预测错误,并为这些区域分配适当的标签。以彩色观看最佳

在本文中,作者解决了需要模型分割整个场景而不是前景对象的场景解析问题。作者提出了一种新型的全域依赖网络(ornet),该网络将自我注意的范围限制在局部斑块上以捕获中程依赖,同时有选择性地强调对其他区域贡献显著注意权重的空间区域,以模拟更精确的长期依赖。通过将局部卷积捕获的中程、重新权衡的长程和近程依赖关系整合在一起,作者的ORDNet可以帮助模型适应复杂自然图像中的各种空间尺度和关系,从而加强局部和全局特征表示。在四个场景分析和分割基准上的大量实验证明了该算法的优异性能。此外,由于ORDNet的通用性和即插即用特性,作者的ORDNet可以应用于其他可视化任务,以捕获全范围依赖关系。在未来,作者希望将ORDNet应用于其他视觉任务,并研究如何进一步减少其计算预算。

论文链接:https://arxiv.org/pdf/2101.03929.pdf

每日坚持论文分享不易,如果喜欢我们的内容,希望可以推荐或者转发给周围的同学。

- END -