【NAACL2022】自然语言处理的对比数据与学习

来源:专知 本文为教程,建议阅读10+分钟

本教程旨在帮助自然语言处理和计算语言学领域的研究人员理解这一新兴主题,并推动将对比学习用于自然语言处理应用的未来研究方向。

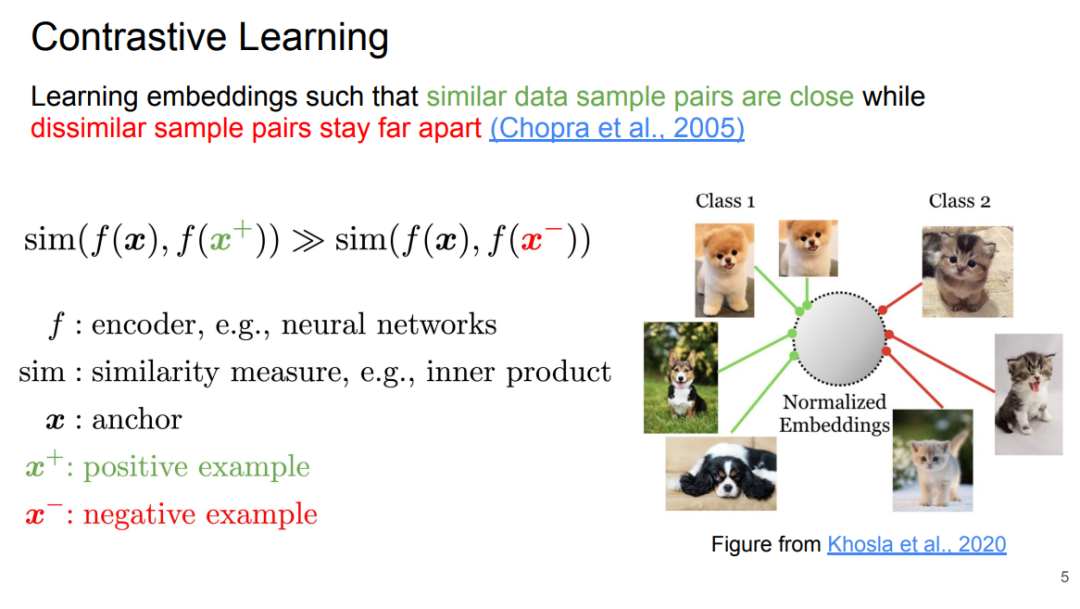

对比学习基础 Part 1: Foundations of Contrastive Learning Contrastive Learning Objectives Contrastive Data Sampling and Augmentation Strategies Successful Applications Analysis of Contrastive Learning NLP对比学习 Part 2: Contrastive Learning for NLP Contrastive Learning in NLP Tasks Task-agnostics Representation Faithful Text Generation Data-efficient Learning Interpretability and Explainability 经验教训与未来 Part 3: Lessons Learned, Practical Advice, and Future Directions Lessons Learned Practical Advice Future Directions

评论