可交互的 Attention 可视化工具!我的Transformer可解释性有救了?

文 | Sherry

转自 | 夕小瑶的卖萌屋

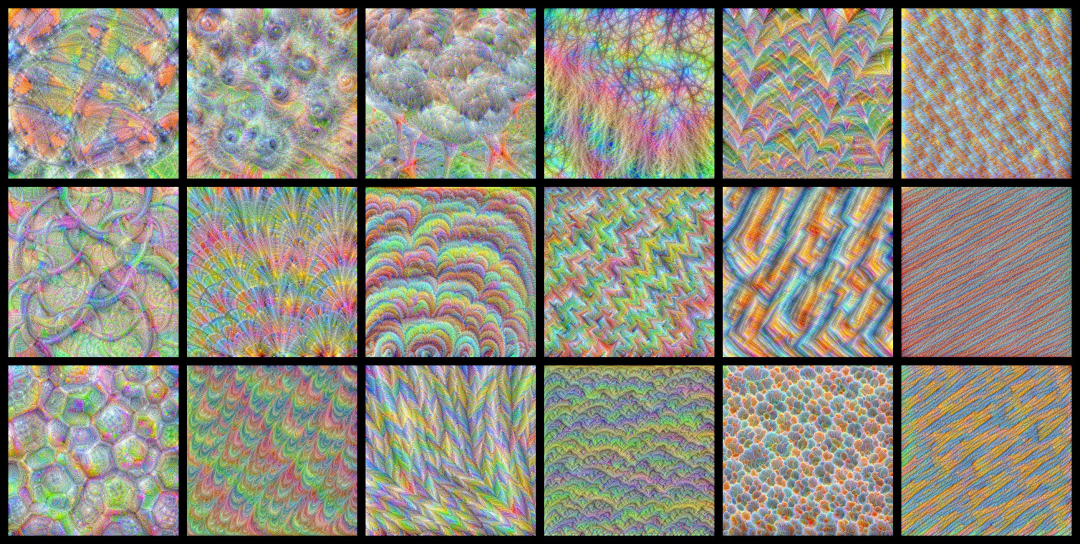

视觉是人和动物最重要的感觉,至少有80%以上的外界信息是经过视觉获得的。我们看论文的时候,通过图表来确定文章的大致内容往往也是一个更高效的 说到深度神经网络的可视化,最经典的莫过于的CNN密恐图了:

这种可视化方法可以让我们清晰的知道每一层的每一个Cell关注何种信息,模型最后是如何逐层迭代处理得到最后的判断。但是对NLP而言,文字并不容易转换成这样直观的视觉表示。对Transformer而言,理解注意力机制是最为关键的一步。比较常见的一种注意力可视化是用灰度图表示不同token之间的注意力权重: 但这种可视化的一大缺点是,每张图只能表示一个注意力头,我们很难获得一个更直接的全局感受。

但这种可视化的一大缺点是,每张图只能表示一个注意力头,我们很难获得一个更直接的全局感受。

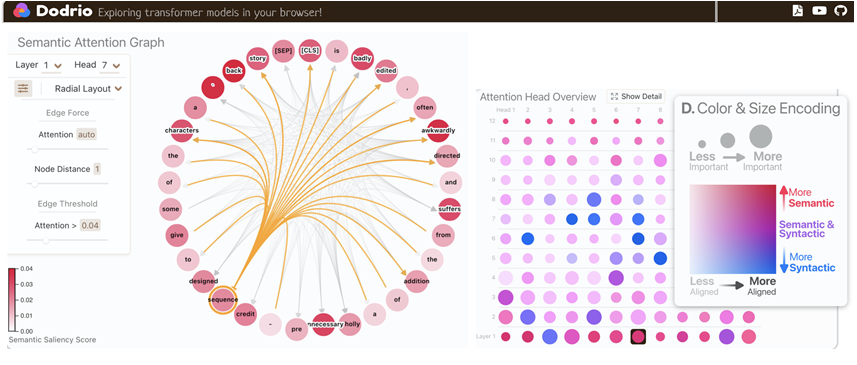

乔治亚理工最近提出了DODRIO,一种可交互的Attention可视化工具,从句法和寓意层面总结了不同注意力头的信息。Transformer的可解释性终于有救啦?

赶紧试试他们的Demo吧:

https://poloclub.github.io/dodrio/

论文题目:

DODRIO: Exploring Transformer Models with Interactive Visualization

论文链接:

http://arxiv-download.xixiaoyao.cn/pdf/2103.14625.pdf

Github:

https://poloclub.github.io/dodrio/

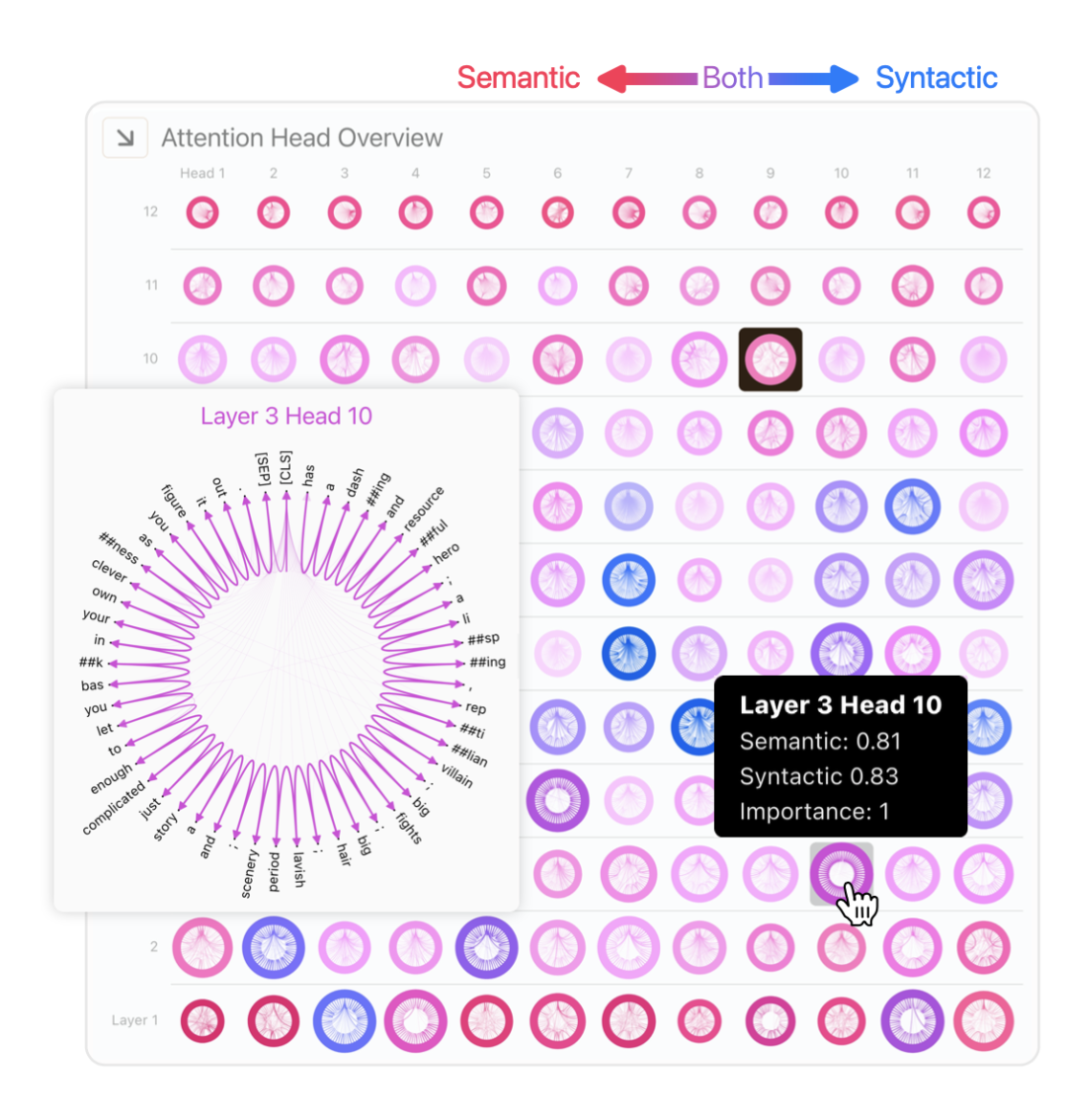

注意力头概览

在概览图中,我们可以看到不同层的不同注意力头都化身成了大小,深浅不一的圆点。本文计算了几种分数并用颜色、深浅、大小来表示。

第一个是语义得分m:它是从注意力向量和显著性得分的cosine相似度得到。

其中S表示的是每个token对模型最终预测的贡献程度[1], 表示注意力权重。圆点颜色越红,表示这个注意力头对语义的贡献越大。

接着是句法得分n: 我们使用最被关注的源token作为依赖关系预测的目标,对于每个依赖关系,我们计算每个注意力头在所有样例上的平均准确性。最后,将每个头所有依赖关系中的最大值作为他的句法得分。圆点颜色越蓝,表示这个注意力头对句法的贡献越大。

然后是重要性得分c:直接计算当前头的最大注意力权重在所有样例上的平均

圆点颜色越大表示注意力头对最终预测的贡献越高。句法依赖

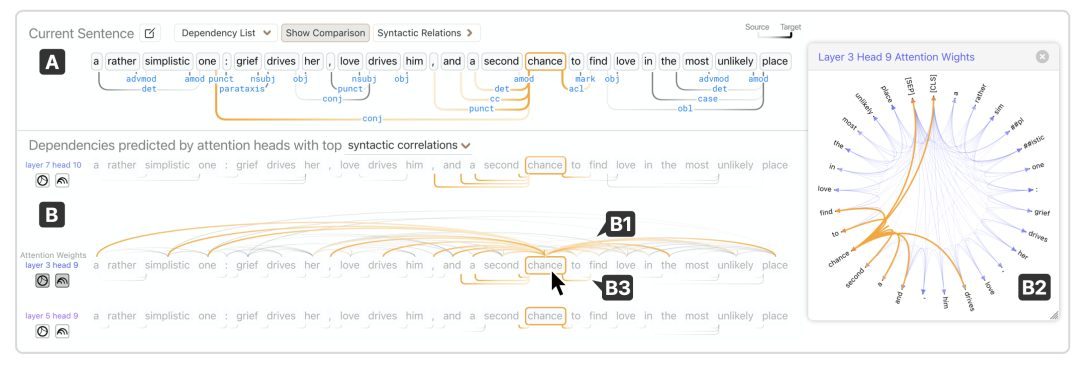

除了注意力头概览,本文根据依赖关系也给出了注意力头的分析。

注意力权重可以被看作是模型对词之间依赖关系的预测。切换到句法依赖的可视化之后,鼠标移动到每个token都会高亮跟这个词有关的注意力连接。在展开的依赖关系图上还可以看到指定的关系在不同层的权重会如何变化。

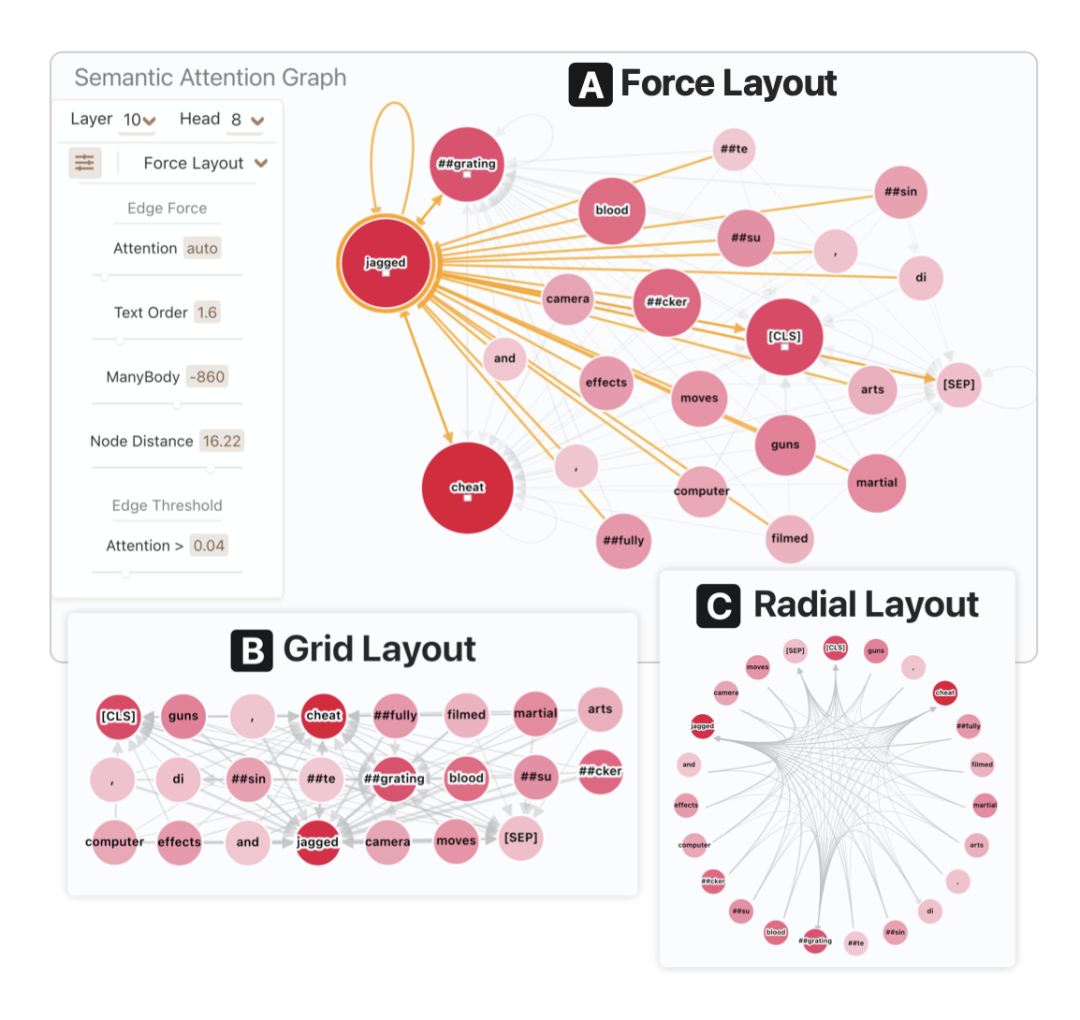

语义关系图

同样,本文也对语义关系进行了可视化。 点击每个概览中的注意力头即可展开在这个位置的注意力表示。颜色依然表示的是每个token的显著性得分。

点击每个概览中的注意力头即可展开在这个位置的注意力表示。颜色依然表示的是每个token的显著性得分。

一些结论

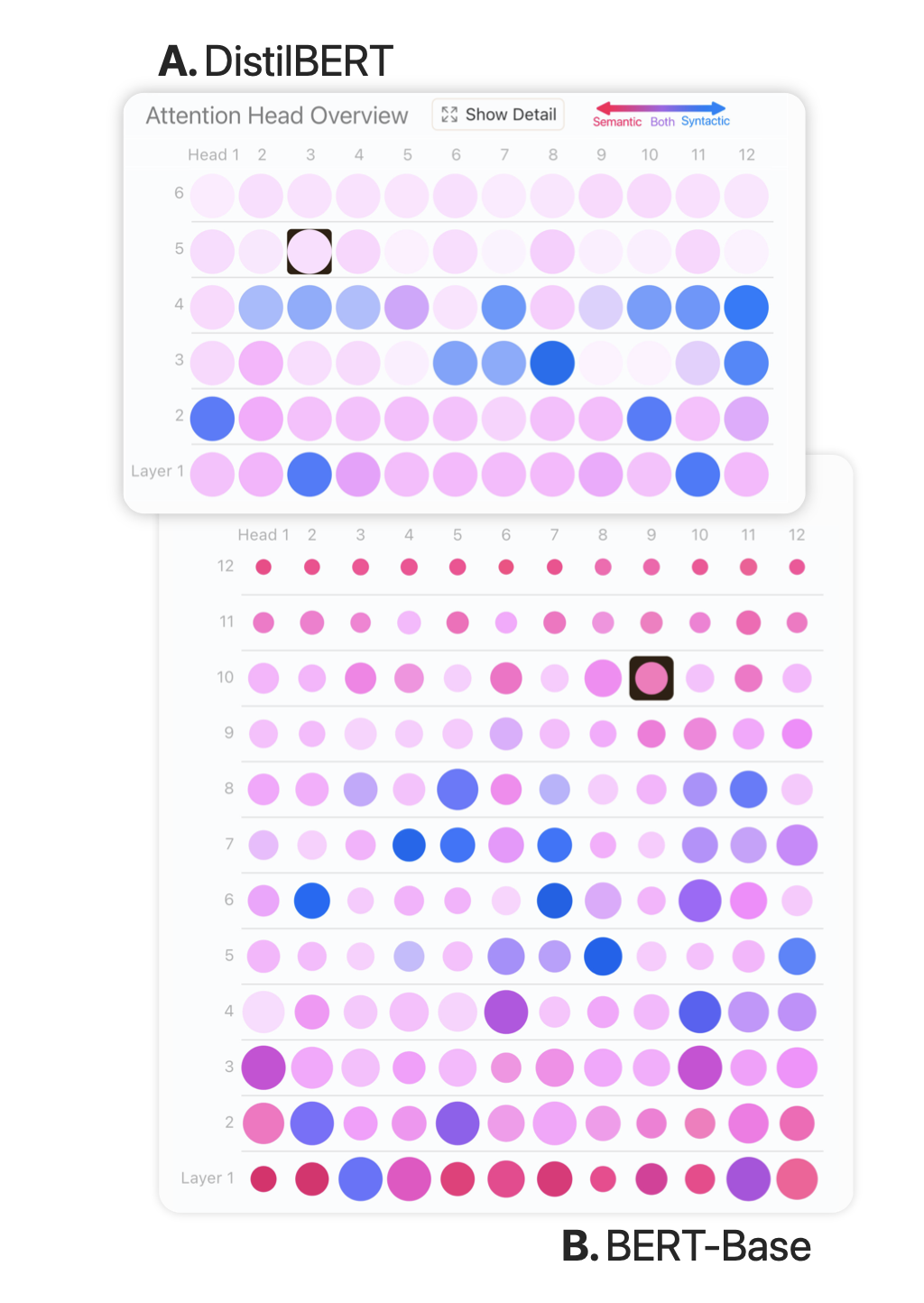

本文的可视化方法再一次验证了一些之前BERT可解释性文章的结论。例如:BERT的中间层更关注句法信息,以及BERT最后1-2层是分类的关键等。

一个有意思的实验是DistillBERT和BERT的可视化比较:

我们知道DistillBERT只用了40%的参数量达到了BERT97%的效果。用Dodrio来比较他们俩会发现什么呢?DistillBERT的所有注意力头大小都差不多,进一步分析发现大多数头的置信度都很接近1。另外,DistillBERT的亮度也更高一些,这表示整体每个头对句法或者语义的关注度都不高。这些发现暗示我们,DistillBERT可能学到了语义和句法之外的信息。

萌屋作者:Sherry。

本科毕业于复旦数院,转行NLP目前在加拿大滑铁卢大学读CS PhD。经历了从NOIer到学数学再重回CS的转变,却坚信AI的未来需要更多来数学和自认知科学的理论指导。主要关注问答,信息抽取,以及有关深度模型泛化及鲁棒性相关内容。

作品推荐:

往期精彩:

点个在看