超越YOLOv4的目标检测算法-PP-YOLO

点击上方“AI算法与图像处理”,选择加"星标"或“置顶”

重磅干货,第一时间送达

来源:深度学习与计算机视觉

YOLO发展史

https://blog.roboflow.ai/a-thorough-breakdown-of-yolov4/

https://blog.roboflow.ai/training-yolov4-on-a-custom-dataset/

PP代表什么?

PP-YOLO贡献

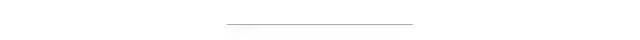

解剖YOLO检测器

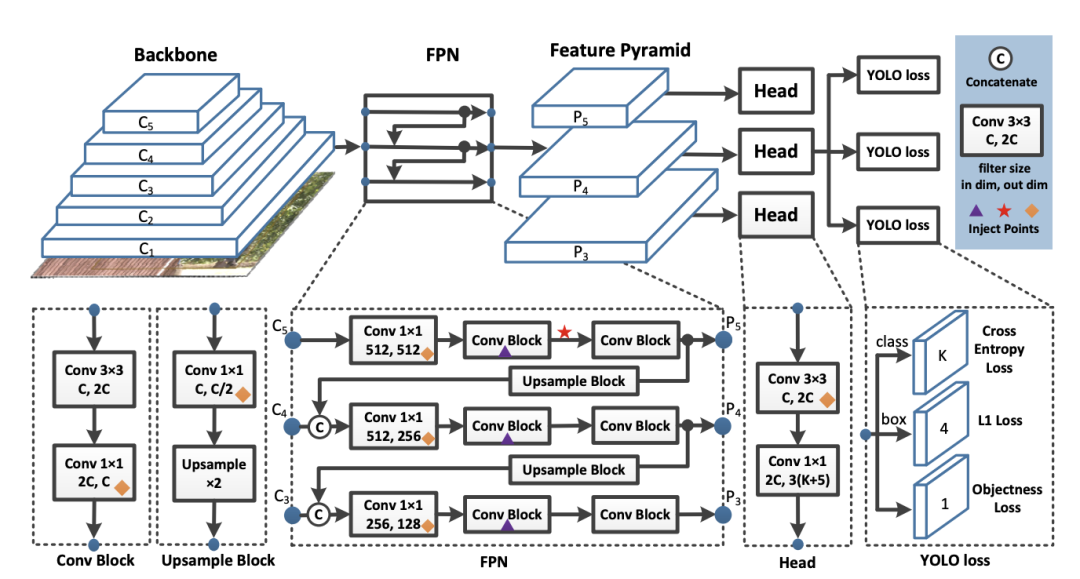

现在,让我们深入了解PP YOLO做出的贡献。

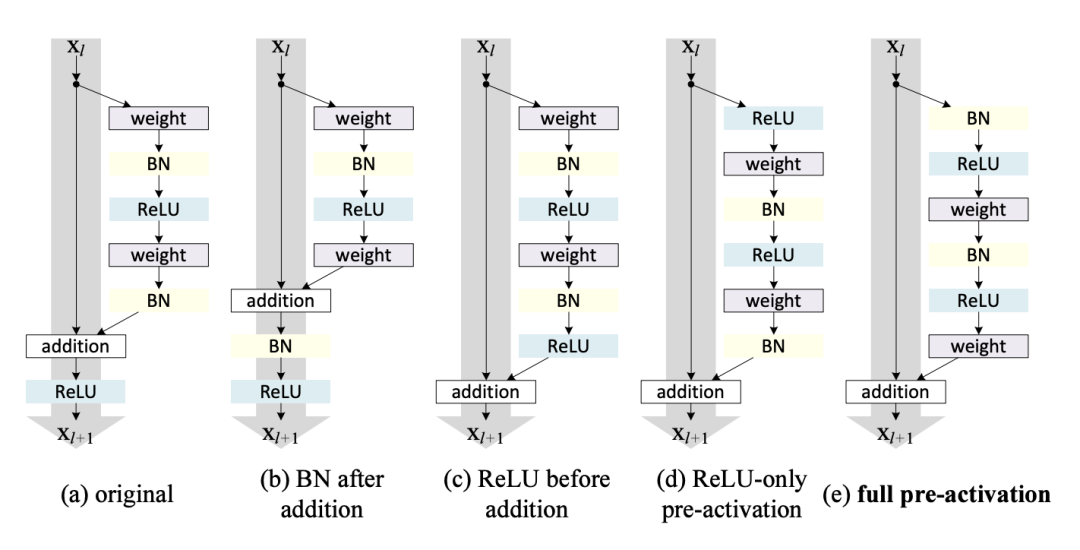

更换骨干网

模型参数的EMA

更大的批量

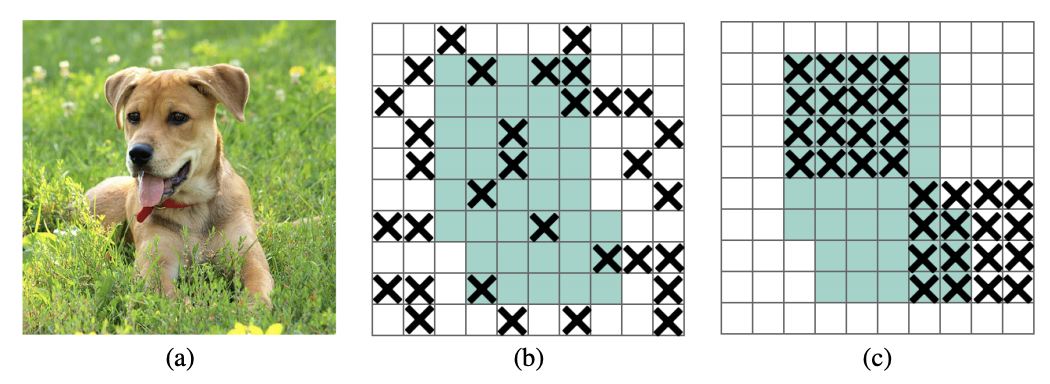

DropBlock正则化

IOU损失

IoU Aware

电网灵敏度

矩阵非最大抑制

CoordConv

https://arxiv.org/pdf/1807.03247.pdf

SPP

更好的预训练骨干

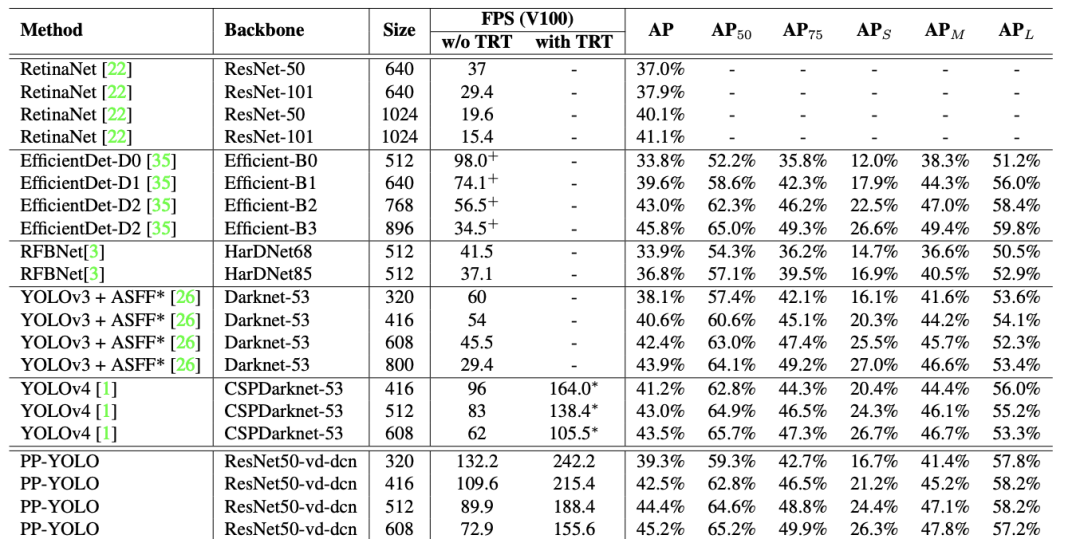

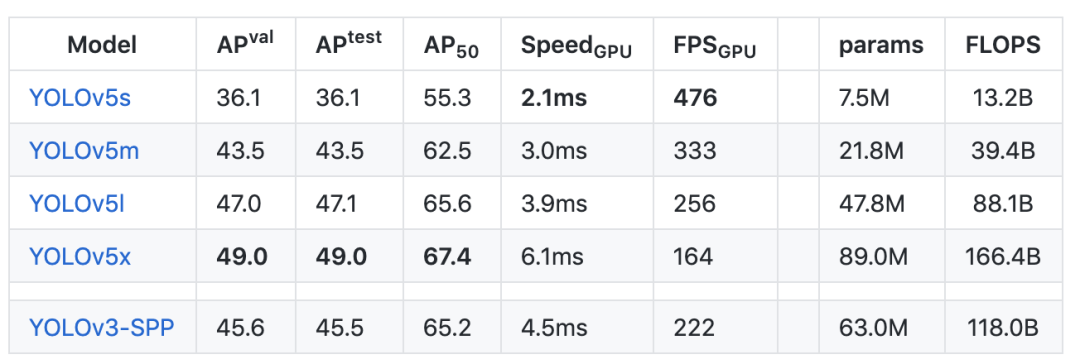

PP-YOLO是最先进的吗?

YOLOv4:https://arxiv.org/pdf/2004.10934.pdf

https://github.com/ultralytics/yolov5/issues/6

我应该从YOLOv4或YOLOv5切换到PP-YOLO吗?

如何在Darknet中训练YOLOv4 https://blog.roboflow.ai/training-yolov4-on-a-custom-dataset/ 如何在PyTorch中训练YOLOv5 https://blog.roboflow.ai/how-to-train-yolov5-on-a-custom-dataset/

下载1:OpenCV黑魔法

在「AI算法与图像处理」公众号后台回复:OpenCV黑魔法,即可下载小编精心编写整理的计算机视觉趣味实战教程

下载2 CVPR2020 在「AI算法与图像处理」公众号后台回复:CVPR2020,即可下载1467篇CVPR 2020论文 个人微信(如果没有备注不拉群!) 请注明:地区+学校/企业+研究方向+昵称

觉得有趣就点亮在看吧

评论