[开放源代码] 爬取微博用户所有文章的爬虫

点击上方 月小水长 并 设为星标,第一时间接收干货推送

在微博上发布的内容有的短文本+图片(也就是微博),还有视频,文章等形式,爬取用户微博可以使用之前的源代码文章:一个爬取用户所有微博的爬虫,还能断网续爬那种

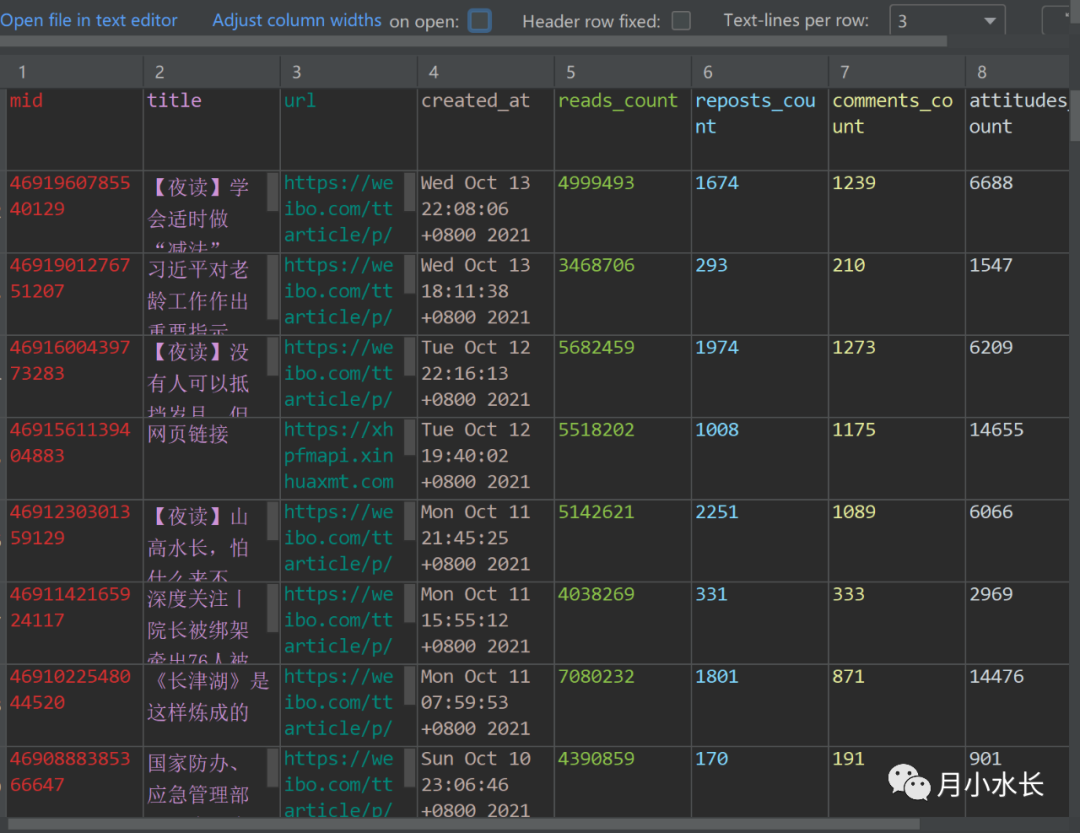

本次分享的是如何爬取用户的所有文章。有文章标题,id,内容,发布时间,阅读数,评论数,点赞数,图片链接等字段或信息,并开放源代码。

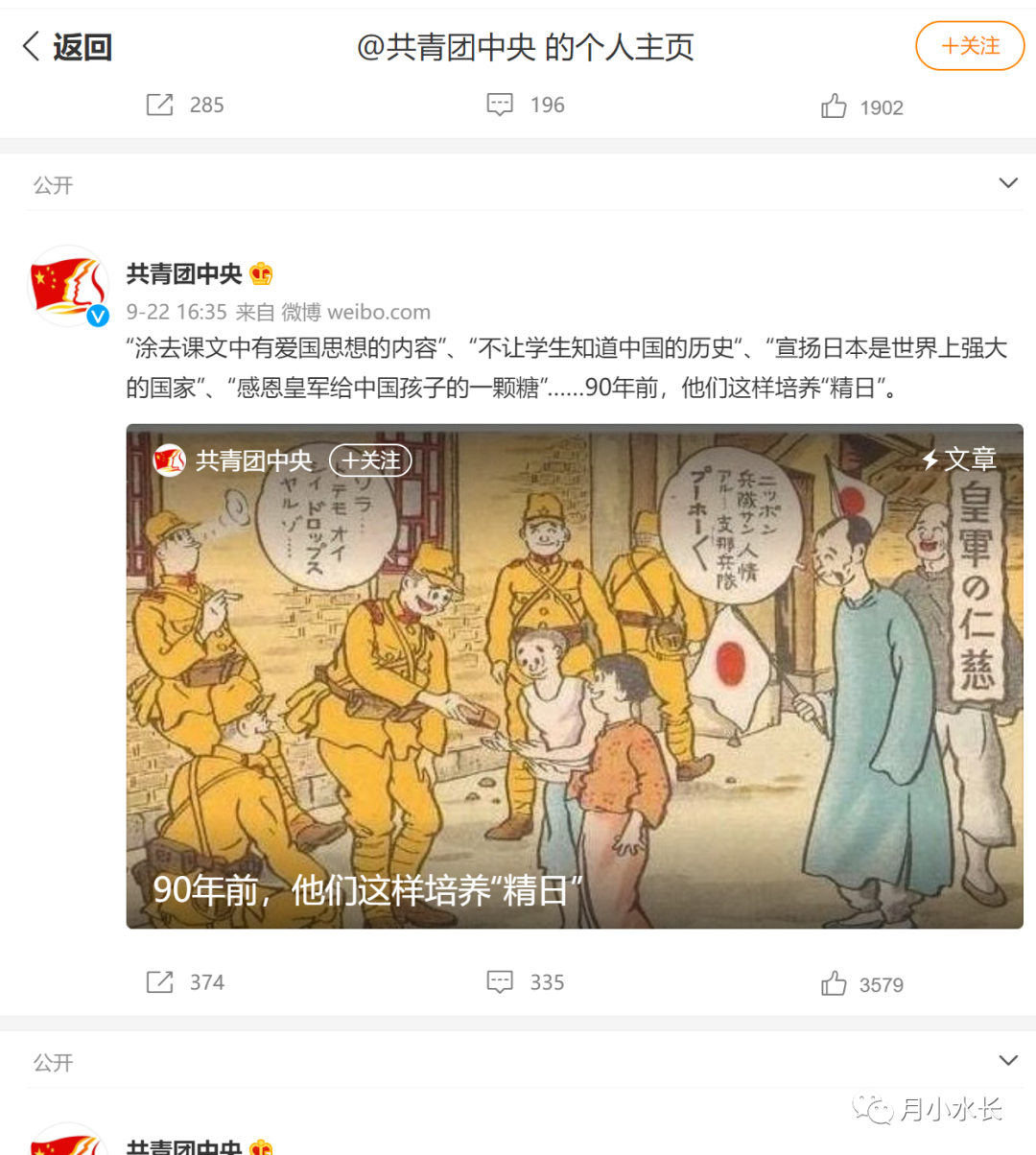

下面以【共青团中央】微博为 target,抓取该账号发布的所有文章,大部分都是深度好文,值得保存起来细细品读。

https://weibo.com/u/3937348351?tabtype=articlehttps://weibo.com/ajax/statuses/mymblog在 Filter 框输入 mymlog 就能过滤出此类请求,然后在请求上右键 Copy as cURL(bash),方便自动转换成爬虫代码,具体可以参见不写一行,自动生成爬虫代码,自动生成的代码如下

import requestsheaders = {'authority': 'weibo.com','sec-ch-ua': '"Chromium";v="94", "Google Chrome";v="94", ";Not A Brand";v="99"','x-xsrf-token': 'M5-ZNBqYi4YtNkfZ8nh_Oz_0','traceparent': '00-348dc482c55e89d8cded23aaa7d56105-8f3e5ce7e78653bc-00','sec-ch-ua-mobile': '?0','user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/94.0.4606.71 Safari/537.36','accept': 'application/json, text/plain, */*','x-requested-with': 'XMLHttpRequest','sec-ch-ua-platform': '"Windows"','sec-fetch-site': 'same-origin','sec-fetch-mode': 'cors','sec-fetch-dest': 'empty','referer': 'https://weibo.com/u/3937348351?tabtype=article','accept-language': 'zh-CN,zh;q=0.9,en-CN;q=0.8,en;q=0.7,es-MX;q=0.6,es;q=0.5','cookie': '看不见我',}params = (('uid', '3937348351'),('page', '2'),('feature', '10'),)response = requests.get('https://weibo.com/ajax/statuses/mymblog', headers=headers, params=params)

我们第一步要做的事情是将 params 改成如下的字典形式

params = {'uid': '1516153080','page': '1','feature': '10',}

评论