爬取过程:

你好,李焕英 短评的URL:

https://movie.douban.com/subject/34841067/comments?start=20&limit=20&status=P&sort=new_score

分析要爬取的URL;

34841067:电影ID

start=20:开始页面

limit=20:每页评论条数

代码:

url = 'https://movie.douban.com/subject/%s/comments?start=%s&limit=20&sort=new_score&status=P % (movie_id, (i - 1) * 20)

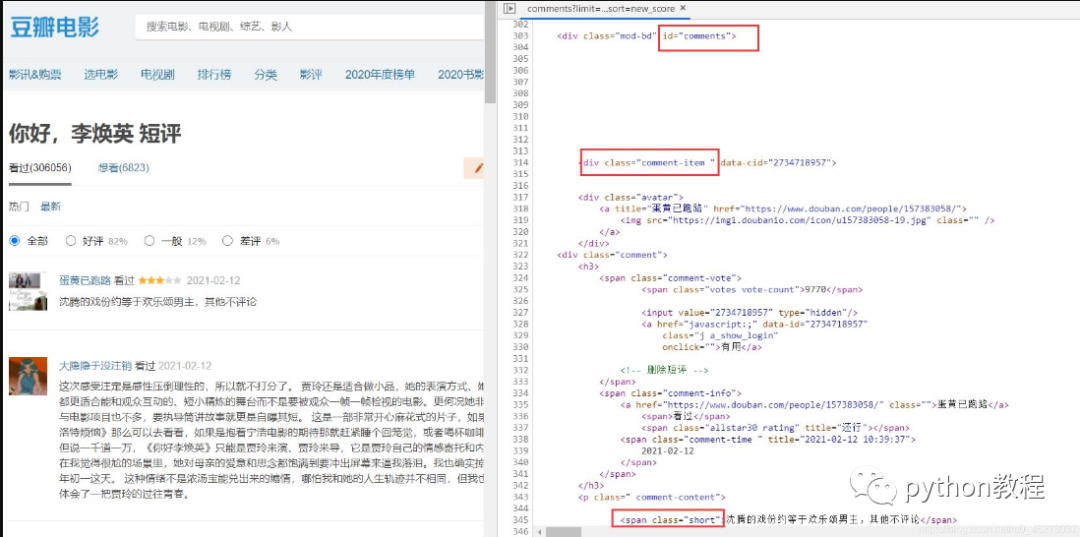

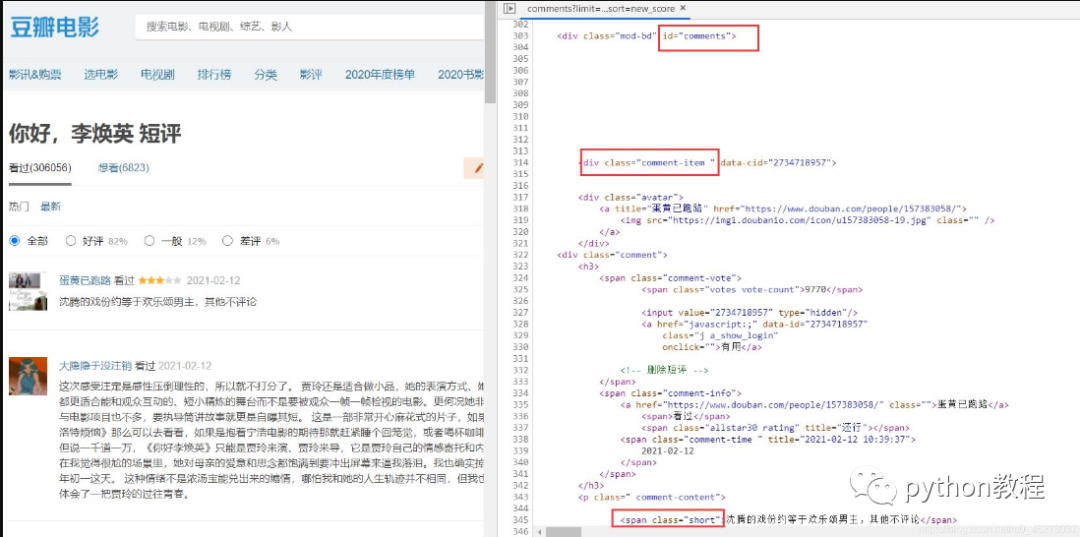

在谷歌浏览器中按F12进入开发者调试模式,查看源代码,找到短评的代码位置,查看位于哪个div,哪个标签下:

可以看到评论在div[id=‘comments']下的div[class=‘comment-item']中的第一个span[class=‘short']中,使用正则表达式提取短评内容,即代码为:

url = 'https://movie.douban.com/subject/%s/comments?start=%s&limit=20&sort=new_score&status=P' \

% (movie_id, (i - 1) * 20)

req = requests.get(url, headers=headers)

req.encoding = 'utf-8'

comments = re.findall('<span class="short">(.*)</span>', req.text)

背景图:

生成的词云:

完整代码:

import re

from PIL import Image

import requests

import jieba

import matplotlib.pyplot as plt

import numpy as np

from os import path

from wordcloud import WordCloud, STOPWORDS

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:64.0) Gecko/20100101 Firefox/64.0'

}

d = path.dirname(__file__)

def spider_comment(movie_id, page):

"""

爬取评论

:param movie_id: 电影ID

:param page: 爬取前N页

:return: 评论内容

"""

comment_list = []

for i in range(page):

url = 'https://movie.douban.com/subject/%s/comments?start=%s&limit=20&sort=new_score&status=P&percent_type=' \

% (movie_id, (i - 1) * 20)

req = requests.get(url, headers=headers)

req.encoding = 'utf-8'

comment_list = re.findall('<span class="short">(.*)</span>', req.text)

print("当前页数:%s,总评论数:%s" % (i, len(comment_list)))

return comment_list

def wordcloud(comment_list):

wordlist = jieba.lcut(' '.join(comment_list))

text = ' '.join(wordlist)

print(text)

# 调用包PIL中的open方法,读取图片文件,通过numpy中的array方法生成数组

backgroud_Image = np.array(Image.open(path.join(d, "wordcloud.png")))

wordcloud = WordCloud(

font_path="simsun.ttc",

background_color="white",

mask=backgroud_Image, # 设置背景图片

stopwords=STOPWORDS,

width=2852,

height=2031,

margin=2,

max_words=6000, # 设置最大显示的字数

#stopwords={'企业'}, # 设置停用词,停用词则不再词云图中表示

max_font_size=250, # 设置字体最大值

random_state=1, # 设置有多少种随机生成状态,即有多少种配色方案

scale=1) # 设置生成的词云图的大小

# 传入需画词云图的文本

wordcloud.generate(text)

wordcloud.to_image()

wordcloud.to_file("cloud.png")

plt.imshow(wordcloud)

plt.axis("off")

plt.show()

# 主函数

if __name__ == '__main__':

movie_id = '34841067'

page = 11

comment_list = spider_comment(movie_id, page)

wordcloud(comment_list)

WordCloud各含义参数如下:

font_path : string #字体路径,需要展现什么字体就把该字体路径+后缀名写上,如:font_path = '黑体.ttf'

width : int (default=400) #输出的画布宽度,默认为400像素

height : int (default=200) #输出的画布高度,默认为200像素

prefer_horizontal : float (default=0.90) #词语水平方向排版出现的频率,默认 0.9 (所以词语垂直方向排版出现频率为 0.1 )

mask : nd-array or None (default=None) #如果参数为空,则使用二维遮罩绘制词云。如果 mask 非空,设置的宽高值将被忽略,遮罩形状被 mask 取代。除全白(#FFFFFF)的部分将不会绘制,其余部分会用于绘制词云。如:bg_pic = imread('读取一张图片.png'),背景图片的画布一定要设置为白色(#FFFFFF),然后显示的形状为不是白色的其他颜色。可以用ps工具将自己要显示的形状复制到一个纯白色的画布上再保存,就ok了。

scale : float (default=1) #按照比例进行放大画布,如设置为1.5,则长和宽都是原来画布的1.5倍

min_font_size : int (default=4) #显示的最小的字体大小

font_step : int (default=1) #字体步长,如果步长大于1,会加快运算但是可能导致结果出现较大的误差

max_words : number (default=200) #要显示的词的最大个数

stopwords : set of strings or None #设置需要屏蔽的词,如果为空,则使用内置的STOPWORDS

background_color : color value (default=”black”) #背景颜色,如background_color='white',背景颜色为白色

max_font_size : int or None (default=None) #显示的最大的字体大小

mode : string (default=”RGB”) #当参数为“RGBA”并且background_color不为空时,背景为透明

relative_scaling : float (default=.5) #词频和字体大小的关联性

color_func : callable, default=None #生成新颜色的函数,如果为空,则使用 self.color_func

regexp : string or None (optional) #使用正则表达式分隔输入的文本

collocations : bool, default=True #是否包括两个词的搭配

colormap : string or matplotlib colormap, default=”viridis” #给每个单词随机分配颜色,若指定color_func,则忽略该方法

random_state : int or None #为每个单词返回一个PIL颜色

fit_words(frequencies) #根据词频生成词云

generate(text) #根据文本生成词云

generate_from_frequencies(frequencies[, ...]) #根据词频生成词云

generate_from_text(text) #根据文本生成词云

process_text(text) #将长文本分词并去除屏蔽词(此处指英语,中文分词还是需要自己用别的库先行实现,使用上面的 fit_words(frequencies) )

recolor([random_state, color_func, colormap]) #对现有输出重新着色。重新上色会比重新生成整个词云快很多

to_array() #转化为 numpy array

to_file(filename) #输出到文件

到此这篇关于python爬取你好李焕英豆瓣短评生成词云的文章就介绍到这了!

扫下方二维码加老师微信

或是搜索老师微信号:XTUOL1988【切记备注:学习Python】

领取Python web开发,Python爬虫,Python数据分析,人工智能等学习教程。带你从零基础系统性的学好Python!

也可以加老师建的Python技术学习教程qq裙:245345507,二者加一个就可以!

欢迎大家点赞,留言,转发,转载,感谢大家的相伴与支持

万水千山总是情,点个【在看】行不行

*声明:本文于网络整理,版权归原作者所有,如来源信息有误或侵犯权益,请联系我们删除或授权事宜