NeurIPS 2020论文评审结果出炉,提前拒稿、作者审稿惹争议,网友:改投别家吧

点击蓝字

关注我们

来源|机器之心

NeurIPS 2020 论文评审结果出来了,你有被评审结果「摧残」到吗?

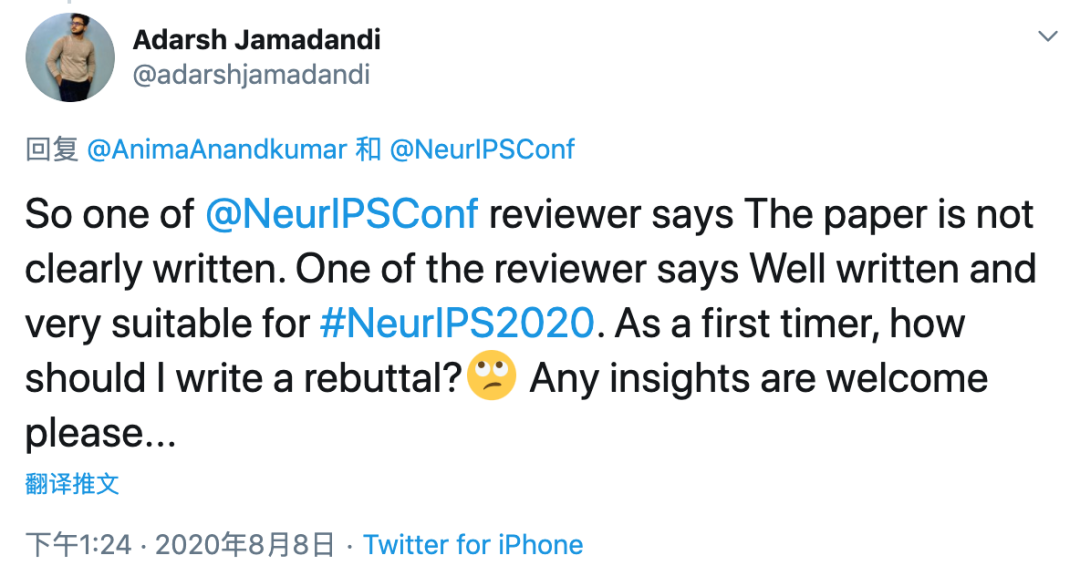

评审结果一出来,众多作者「在线摊手」

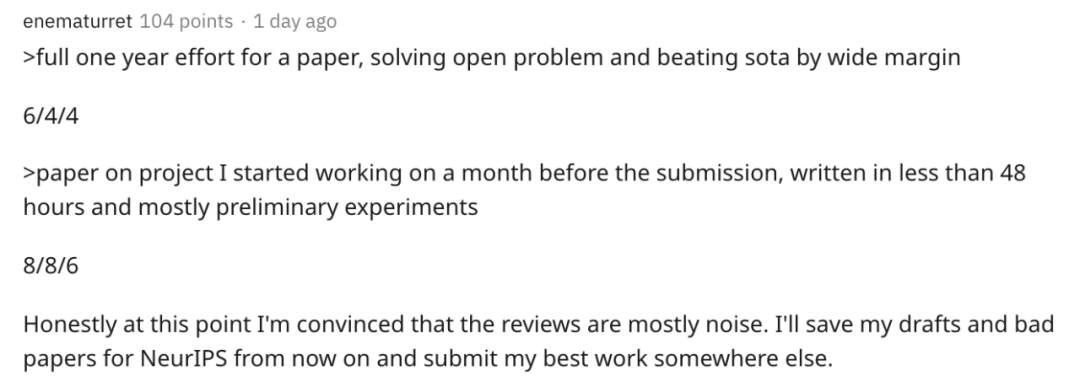

我花了一年时间写的论文,解决了开放性问题,性能大幅超越 SOTA 结果,得了 6/4/4 分;提交前一个月才开始做项目,不到 48 小时写完论文,而且实验大多比较初级,这篇论文竟然得了 8/6/6 分。 现在我确信,评审结果大部分是噪声了。从现在开始,我要保存自己的论文草稿和 NeurIPS 认为不好的论文,将自己最好的工作投到别的渠道。

NeurIPS 2020 新审稿机制惹争议

提前拒稿:领域主席会有两个星期时间去建议哪些论文会被提前拒绝,而且目前预计将有 20% 左右的论文会被提前拒绝。紧接着高级领域主席会有一个星期的时间来审核及批准这一决定。批准之后,这些论文作者将会得到通知。

作者也是审稿人:此次改变提出,在需要时,论文作者或联合作者都需要同意审稿。这一改变有助于增加审稿人员的总量,并可以在提交论文的人员中更加公平地分配审稿的工作量。

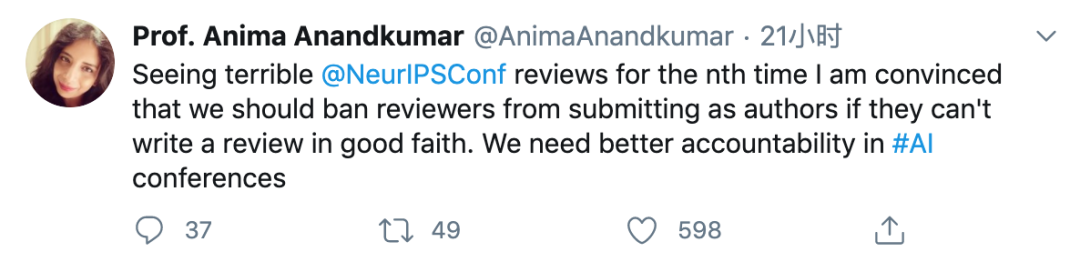

再一次看到 NeurIPS 会议糟糕的论文评审结果,我确认了一点:如果评审人员没办法真诚地写评审结果,那就应该禁止他们同时作为作者提交论文。我们的 AI 会议需要更有可信度。

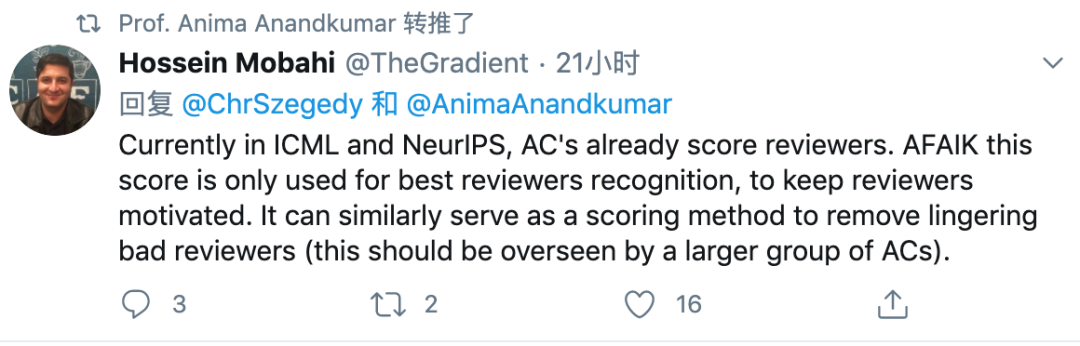

目前在 ICML 和 NeurIPS 会议评审过程中,领域主席(AC)已经对评审人员进行评分了。据我所知,这个分数仅用于发现优秀的评审人员,进而激励评审者。它其实可以有另一种类似的用途:摒弃不好的评审人员(这一过程应该接受更多 AC 的监督)。

认真工作了好几个月或好几年,评审一两天就结束了,评审结果还像出自机器人之手——不具备恰当的 pointer、叙述、构造、善意等。大部分学术研究评审结果都是这样,唉!

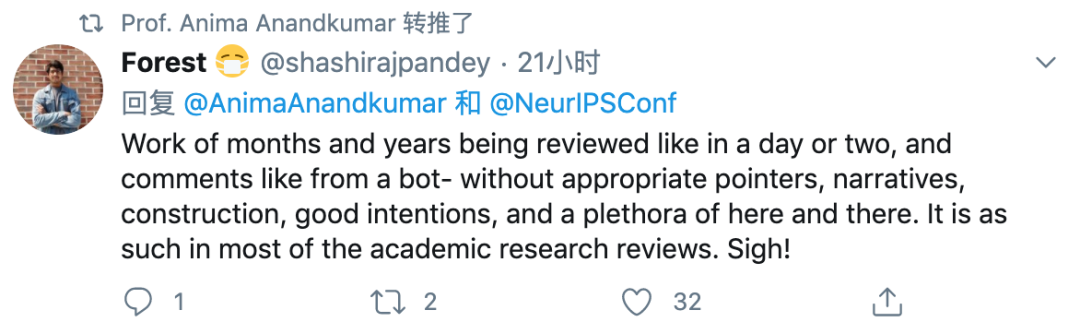

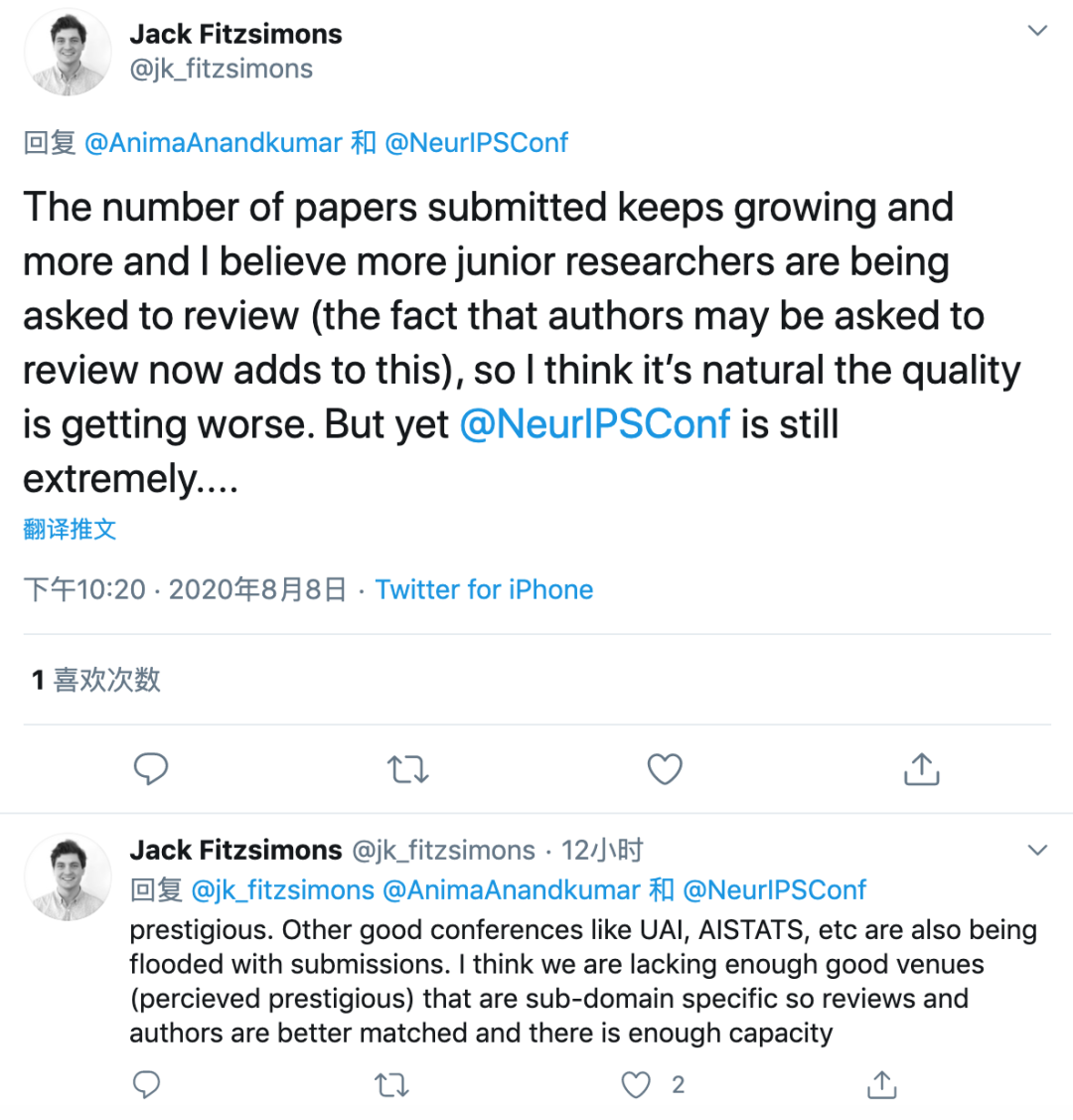

论文提交数量日益增长,肯定会有更多初级研究者担任评审(论文作者兼任评审加剧了这一点),因此我认为评审质量变差在情理之中。但是 NeurIPS 会议仍然具备很高的声誉。其他不错的会议(如 UAI、AISTATS)也收到了大量投稿。我认为我们缺乏足够好、具备较高声誉的子领域会议,不然评审和作者能够得到更好的匹配,这方面还大有可为。

禁止并非解决问题的良策。我们需要更好地教育论文评审(和作者)。我们还需要重新思考 21 世纪的会议论文发表系统。

我对此的建议包括四部分。 核心部分是包含以下三个主要组件的 wiki:1)已发表论文的有标注、有组织的目录;2)机器学习实验设计和分析流程(包含代码)的集合;3)证明优化和学习理论发现的数学结果和分析技术集合。 该 wiki 应由包含高级编辑的研究社区维护,这些人员分别归属于三个专家组:1)领域专家组,负责持续跟进某些研究领域;2)方法论专家组,负责实验设计和统计分析部分;3)数学专家组,负责分析机器学习算法。 高级编辑应拥有不错的职业路径,具备相关的知名度和奖项。作者应查询该 wiki,找到相关的研究结果和方法。没有引用该 wiki 中的相关工作或方法的论文可被拒。

第二部分:论文投稿应包括结构化的摘要和附录。摘要应表明研究动机、研究问题、方法和贡献。附录应包含:a)解释作者认为论文与哪些 wiki 类别相关,与哪些不相关;b)实验设计和分析流程的伪代码;c)对所有形式化结果的陈述和证明。 第三部分:每篇论文分配一名编辑 / 指导者,负责帮助作者改进论文。 编辑阅读论文并就其「叙事」提供反馈,然后将建议以 pointer 的形式发送给作者。作者根据编辑的反馈更新论文,然后编辑通过,将该论文发布在某个平台上(如 Open Review),邀请研究社区进行评审和复现。 第四部分:如果研究社区认为某篇论文很重要或效果惊人,则论文进入深入的正确性检查环节。

由某个受资助组织接受聘请评审进行此类检查。论文发送给三类评审人员:a)研究类似问题的人员:这类评审负责评估论文的研究问题、论断和证据是否得到准确描述;b)方法论专家(如果论文包含实验的话):这类评审负责评估方法和分析的正确性;c)分析专家(如果论文做出了形式化论断):这类专家负责检查理论论断和证明。 其整体目标是对重要的论文进行再次检查,相当于「可编辑的 arXiv」,扩展性优于现有系统。 社区创建和维护 wiki 以跟踪领域最新知识,与为作者提供「doing research right」的更好工具同等重要。

推荐阅读

评论