东南大学EGVSR: 基于GAN的实时超分系统 | 太惊艳!

点击下方“AI算法与图像处理”,一起进步!

重磅干货,第一时间送达

来源:新智元 arXiv 编辑:Priscilla

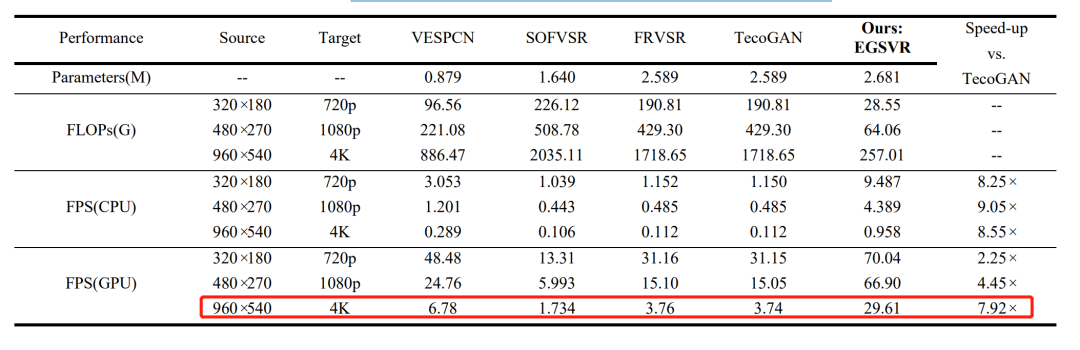

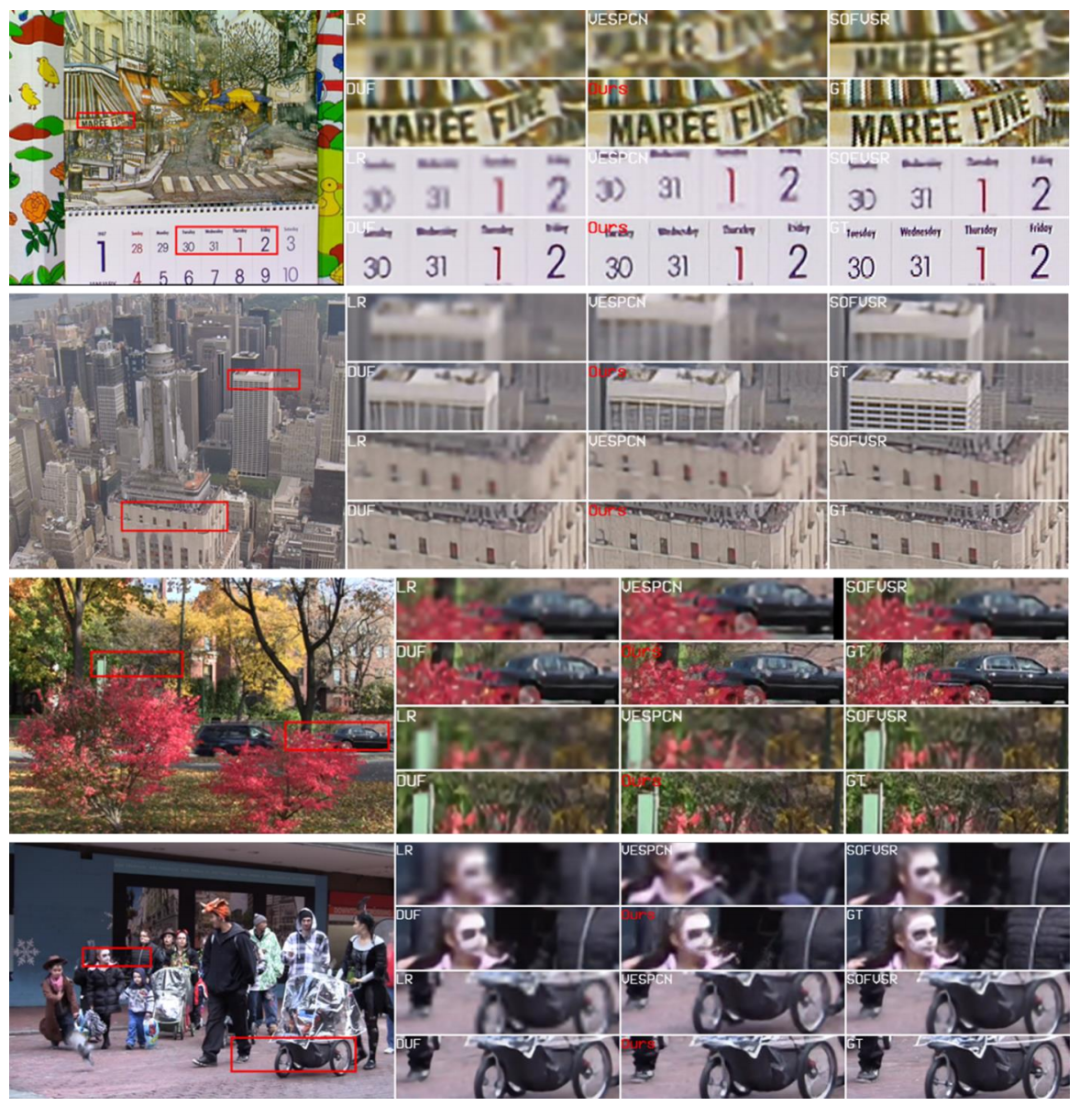

【导读】东南大学研究团队最新提出的4K实时处理超分辨率系统(EGVSR)不仅能够修复高糊画质,运行速度还比TecoGAN快9倍,代码已开源。

代码:https://github.com/Thmen/EGVSR

什么是VSR?

GAN:重建视频质量的工具

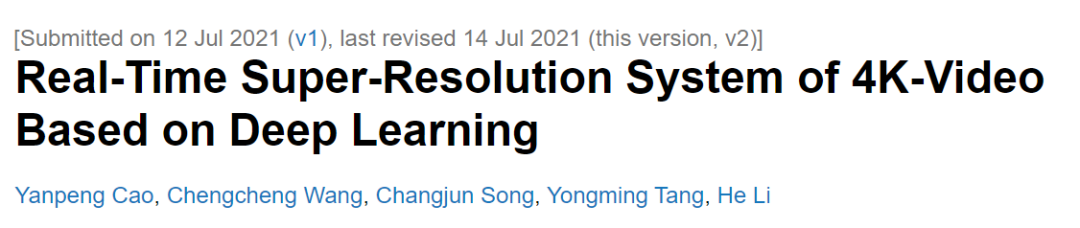

EGVSR生成器部分的框架和推理阶段的数据流

EGVSR生成器部分的框架和推理阶段的数据流快点,再快点!

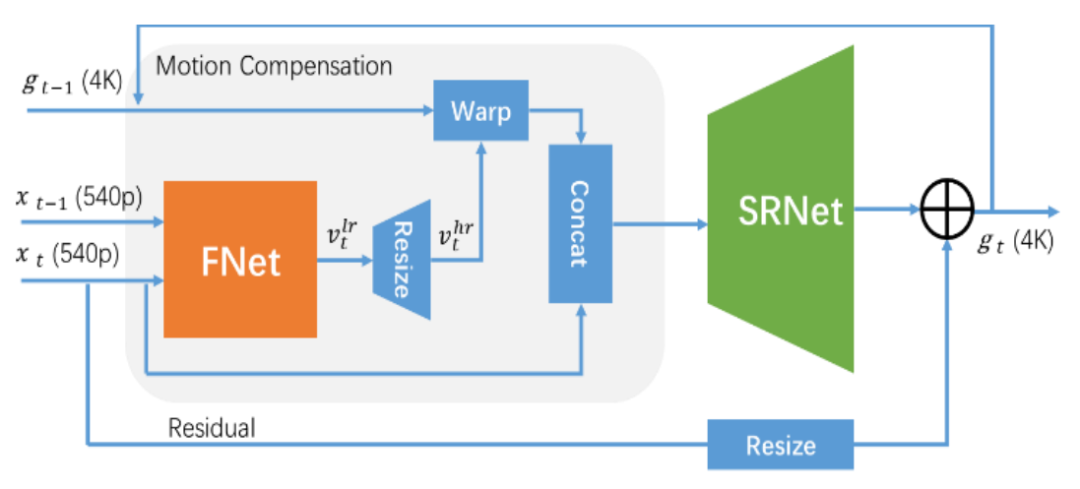

快点,再快点!

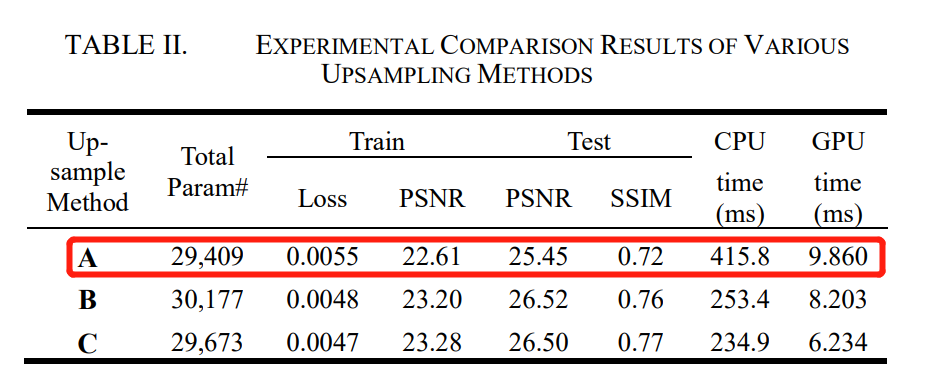

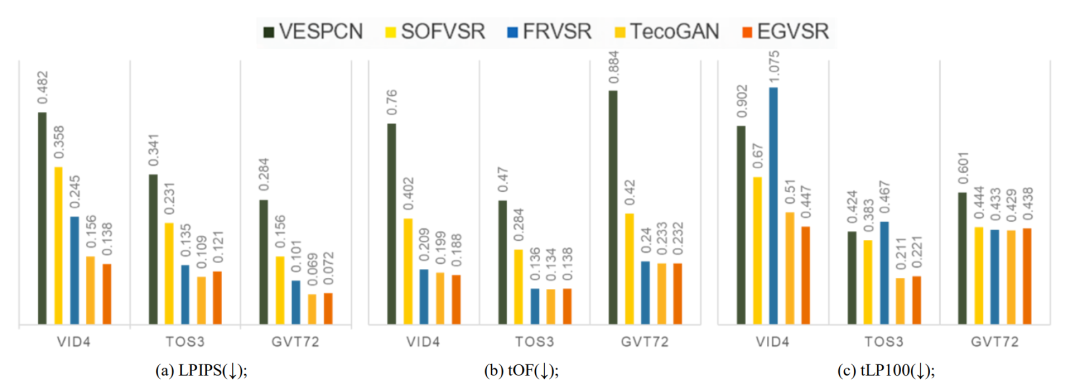

实验结果

实验结果

作者介绍

参考资料:

https://arxiv.org/abs/2107.05307

努力分享优质的计算机视觉相关内容,欢迎关注:

个人微信(如果没有备注不拉群!) 请注明:地区+学校/企业+研究方向+昵称

下载1:何恺明顶会分享

在「AI算法与图像处理」公众号后台回复:何恺明,即可下载。总共有6份PDF,涉及 ResNet、Mask RCNN等经典工作的总结分析

下载2:终身受益的编程指南:Google编程风格指南

在「AI算法与图像处理」公众号后台回复:c++,即可下载。历经十年考验,最权威的编程规范!

下载3 CVPR2021 在「AI算法与图像处理」公众号后台回复:CVPR,即可下载1467篇CVPR 2020论文 和 CVPR 2021 最新论文

点亮  ,告诉大家你也在看

,告诉大家你也在看

评论