SIGGRAPH 2022 | 基于GAN的新动作合成

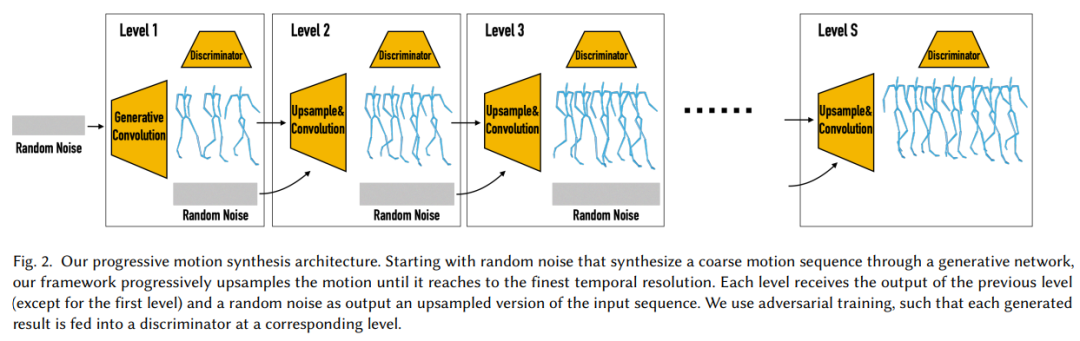

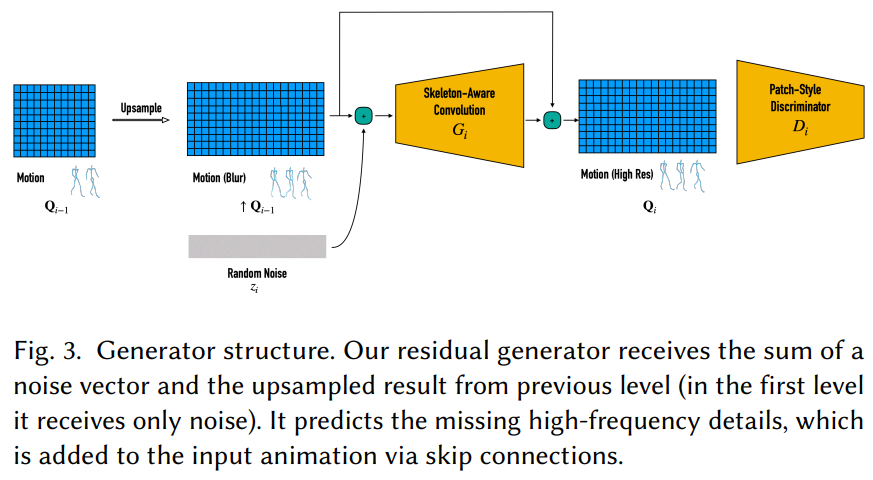

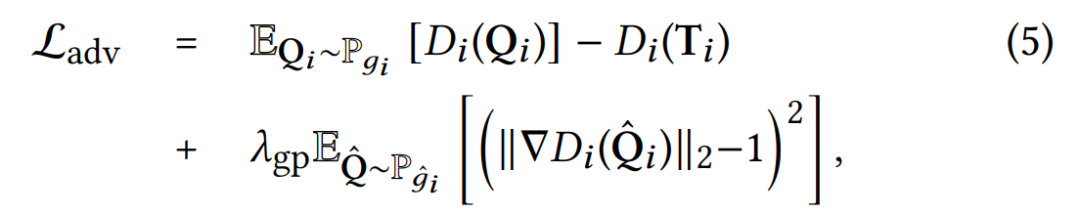

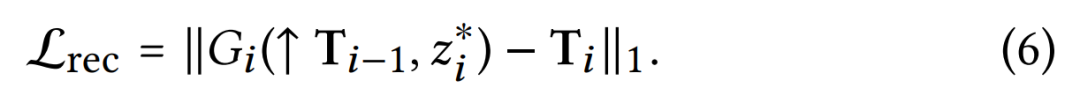

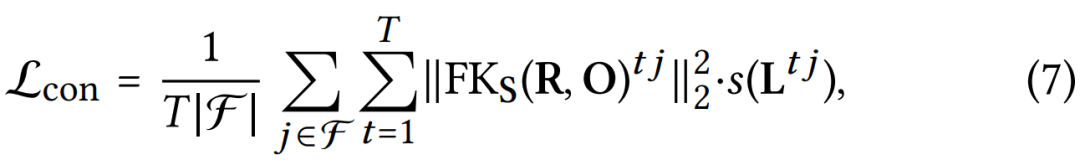

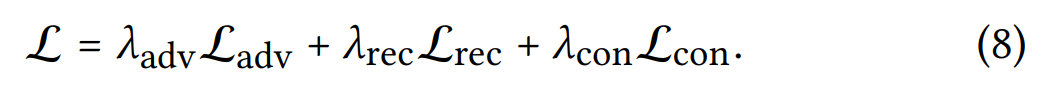

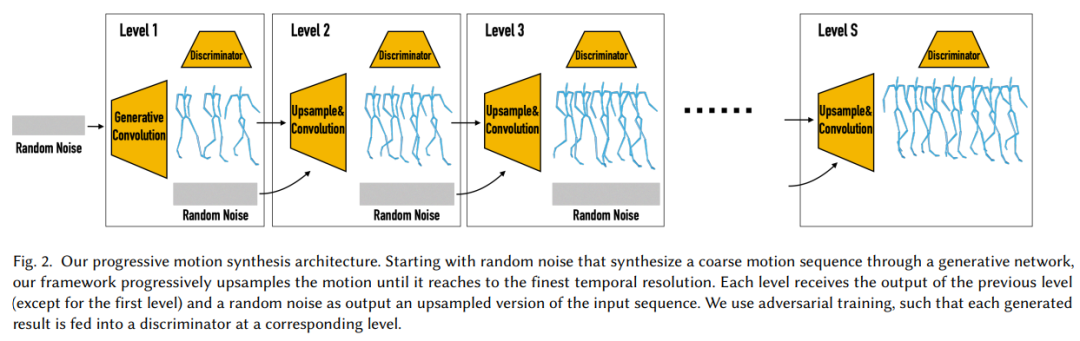

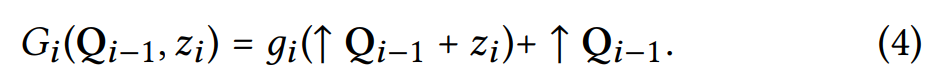

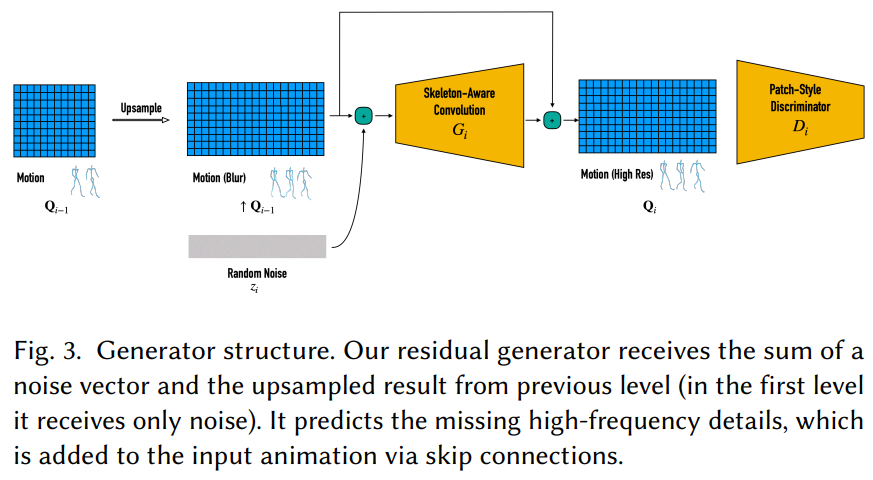

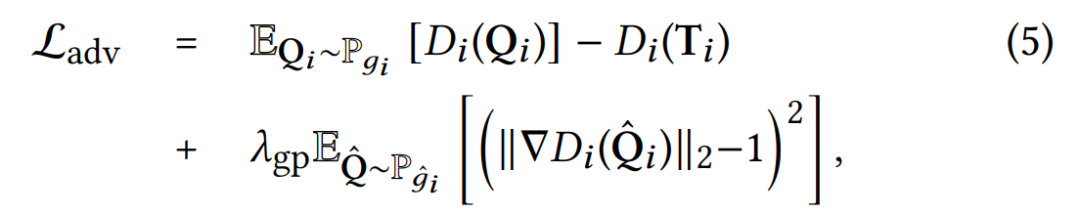

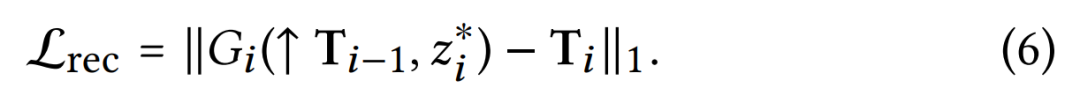

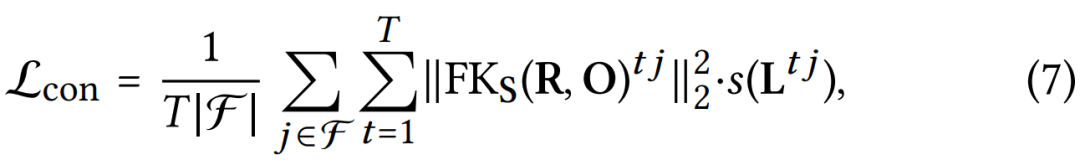

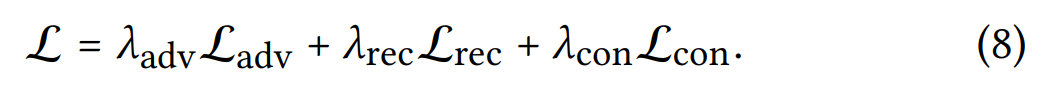

酷炫的神经动作合成技术,单个序列就能完成。

论文地址:https://arxiv.org/pdf/2205.02625.pdf

项目地址:https://peizhuoli.github.io/ganimator/

猜您喜欢:

戳我,查看GAN的系列专辑~!

戳我,查看GAN的系列专辑~!附下载 |《TensorFlow 2.0 深度学习算法实战》

评论

下载APP

下载APP酷炫的神经动作合成技术,单个序列就能完成。

论文地址:https://arxiv.org/pdf/2205.02625.pdf

项目地址:https://peizhuoli.github.io/ganimator/

猜您喜欢:

戳我,查看GAN的系列专辑~!

戳我,查看GAN的系列专辑~!附下载 |《TensorFlow 2.0 深度学习算法实战》