拳打GAN创始人,脚踢深度学习三巨头,LSTM之父又发威!

【导读】LSTM之父Jürgen Schmidhuber又开炮了,他在博客上发文表示,现在引用最多的神经网络论文成果,都是建立在我实验室完成的工作之上的。这其实是老调重弹了。Jürgen Schmidhuber成就等身,但在圈内一直怼人怼的飞起,借此文来了解一下这位暴脾气大爷吧。

LSTM之父Jürgen Schmidhuber又开炮了。

不要问“为什么要说又”了。这位大爷是圈内有名的老暴脾气。他发了一篇博客,回顾了上世纪90年代以来,神经网络领域高引用数的论文,以及这些论文的成果和他本人和他的实验室之间的渊源。

简单一句话来说就是:

这些高引用成果,都建立在我的成果之上。

简单几句话来说就是:

LSTM自不用说了。此外,其他今天鼎鼎大名的开创性工作比如ResNet,比如AlexNet,比如GAN,比如Transformer,都和我的工作有关系,有些第一版就是我做出来的,但是现在这些人不讲武德,引用不规范,搞得这些成果现在的归属认知有问题。

虽然这些话不是Schmidhuber大爷第一次说了,但是圈内老前辈的话还是有必要听一听 ,了解一下究竟是为什么让Schmidhuber如此不甘。

LSTM

根据 Google Scholar 的说法,20 世纪被引用次数最多的 神经网络论文是我们 1997 年发表的LSTM 的文章。LSTM 现在已经广泛应用于现实世界,涵盖医疗保健、学习机器人、游戏、语音处理和机器翻译等领域。

LSTM每天被无数人使用数十亿次。彭博社称 LSTM 是“可以说是最具商业价值的 AI 成就”。我们今天所知的 LSTM 超越了早期的工作,是通过我的学生 Sepp Hochreiter、Felix Gers、Alex Graves、Daan Wierstra 和其他人实现的。

从Highway Net到ResNet

21 世纪最常被引用的神经网络论文介绍了“ResNet”一词。文中引用了我们早期的 Highway Net(2015 年 5 月),ResNet是前者的一个版本。Highway Nets 是第一个100 层以上的前馈神经网络(以前的神经网络最多只有几十层)。实际上,ResNets 就是一种 Highway Nets。Highway Nets 体现出了深层神经网络的工作方式,并且在 ImageNet 上的表现大致与 ResNets 一样。

Highway Net是通过我的学生Rupesh Kumar Srivastava 和 Klaus Greff 实现的。美国专利商标局于 2021 年将这项发明的专利授予了NNAISENSE。

值得注意的是,20 世纪和 21 世纪最常被引用的LSTM和ResNet是紧密相连的,因为Highway Net 实际上是我们循环 LSTM 的前馈神经网络版本。LSTM 为监督式循环神经网络带来了本质上无限的深度;Highway Nets 把这个优势带到了前馈神经网络上。

从DanNet 到 AlexNet再到 VGG Net

21 世纪第二个最常被引用的神经网络论文描述了AlexNet,这是一个卷积神经网络 (CNN) ,类似于我们早期开发的 DanNet (2011),DanNet曾暂时垄断了计算机视觉比赛,并在 AlexNet 出现之前赢得了其中的 4 场比赛。

AlexNet引用了DanNet,但也使用了ReLUs (1973)和随机增量规则/dropout (1990),但没有标明引用。DanNet 和 AlexNet 实际上遵循了我们更早时候在监督深度神经网络上的成果(2010),其他高引用CNN的论文进一步扩展了我在2011 年的工作成果DanNet。

DanNet是在 Ueli Meier 和 Jonathan Masci 的帮助下,由我的博士后 Dan Ciresan 开发完善的。

从好奇心网络到生成对抗网络(GAN)

2014 年另一篇关于生成对抗网络(GAN) 的高引论文描述的模型,也和我开发的对抗性的神经网络系统相似,该系统使用可预测性最小化来创建解缠表示(1991)。

事实上,GAN 是我在 1990 年中更早流行的对抗好奇心原则的一个简单应用,其中两个对抗网络(一个生成器和一个预测器)试图在极大极小游戏中最大化彼此的损失。GAN 就是这个原则下的一个实例。

从Fast Weight Programmers到Transformer

最近,Transformers风靡一时。事实证明,Transformers 是我 1991 年的 Fast Weight Programmers的扩展,后者可归为一个线性的Transformer。

现在世界上的一些最有价值技术公司深受我们上述贡献成果的影响。ResNet的论文由微软发表,其第一作者被 Facebook 聘用。大多数 AlexNet/VGG Net 的论文作者去了谷歌。

谷歌还发表了与我1991年的研究相关的Transformer论文,并收购了我实验室的一个学生与DeepMind共同创立的一家公司。提出DANNet的论文的第二作者和 2014 年关于 GAN的论文的第一作者被 Apple 聘用。

上面所有公司都广泛使用了LSTM。

在衡量开创性工作的价值上,看引用数不是什么好方法。正如我在 Nature 上指出的那样:“和2008 年金融泡沫中的不值钱的抵押债务一样,引用数很容易膨胀,这不是科学进步的动力。看看现在相对不知名的科学家,很多时候领域内最有影响力的开创者的引用数更多。

关于深度学习的历史。如果考察范围只在英语文化圈内,你可能并不是很清楚深度学习最初发源于非英语圈。

事实上,深度学习于 1965 年诞生于乌克兰(当时还是苏联),产生了第一个真正实现“学习”的任意深度网络,超越了数学家高斯和勒让德在1800年左右提出的“浅层学习”(即线性回归)。

1970年,现代意义上的反向传播(即自动微分的反向模式)在芬兰发表。基础的深度卷积神经网络架构于上世纪70 年代在日本提出。1987年,卷积神经网络后来与“权重共享”和反向传播相结合。

今天的我们其实是站在了这些成果的肩膀上的。

基于梯度的无监督或自监督对抗网络起源于德国慕尼黑,这里也是上世纪80 年代第一辆真正自动驾驶汽车的诞生地。

线性Transformer的原理、神经网络蒸馏,以及基于反向传播的深度学习的基本问题也都是在慕尼黑提出的。第一批深度学习的研究人员是通过无监督预训练和 LSTM克服这个问题的。

LSTM 在瑞士了得到进一步发展,这也是首个在图像识别竞赛获胜的基于GPU 的深度 CNN 的发源地。第一个表现超过人类的视觉模式识别模型(2011),以及第一个具有数百层的超深的工作前馈神经网络也诞生于瑞士。

其实Jürgen Schmidhuber这么多年来一直有些意难平,同为AI领域的前辈级人物,开创性成果没少做,但获得的声誉和认可度似乎总与期望值有很大差距。

早在2018年,深度学习三巨头:Yoshua Bengio、Geoffrey Hinton、Yann LeCun荣获图灵奖时,也有不少的网友发出了质疑:图灵奖为什么没颁给LSTM之父Jürgen Schmidhuber?他也是深度学习领域的大家啊。。

获得图灵奖的为什么是Yoshua Bengio、Geoffrey Hinton、Yann LeCun,而不是Jürgen Schmidhuber呢?

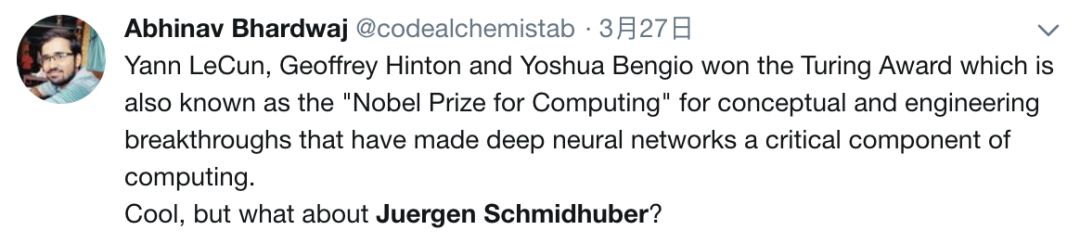

Yoshua Bengio、Geoffrey Hinton和Yann LeCun获得了图灵奖(计算机界的诺贝尔奖),让深度神经网络成为计算机中的重要环节。非常酷!但是Jürgen Schmidhuber呢?

而实际上,Jürgen Schmidhuber和圈内几位大佬的关系都不算融洽。

他曾经和GAN的创始人Ian Goodfellow在学术会议上发生直接交锋。

2016年NIPS大会,Goodfellow在现场有个Tutorial,正当他讲到GAN与其他模型相比较时,被一个听众的提问打断了。

这个听众就是Jürgen Schmidhuber。

Jürgen Schmidhuber向Goodfellow提问

Jürgen Schmidhuber的问题很长,大概说了两分钟,主要内容是强调说自己在1992年就已经提出来PM,接着说了一大堆它的原理、实现过程等等,最后图穷匕见:你说说你的GAN和我的PM有没有相似之处?

Goodfellow也不示弱:你说的问题我们之前在邮件里已经交流过很多次了,我也早就公开回应过你了,不想在现在的场合浪费听众的耐心。

2015年5月,Bengio、Hinton和LeCun三位大神联手在Nature上发了一篇review,题目直接就叫《Deep Learning》。此文从传统的机器学习技术讲起,总结了现代机器学习的主要架构和方法,描述了训练多层网络架构的反向传播算法,以及卷积神经网络的诞生,分布式表示和语言处理,以及递归神经网络及其应用等等。

从这篇文章的行文风格和内容来看,相当一部分内容是三位作者赖以成名的划时代成就,大有为深度学习“回顾历史、展望未来”的意思,字里行间透露出“盖棺定论”的豪迈之意挡也挡不住。

不过Nature上这篇文章发表后不到一个月,他就在自己的博客上发文,对这篇论文进行了批评。

Schmidhuber在文中表示,这篇文章让他非常不爽,因为全文多次引用三位作者自己的研究成果,而对于其他先驱人物对深度学习更早的贡献则只字不提。

这篇文章中认为,获得图灵奖的“深度学习三巨头”俨然成了贪他人之功,以为己利的鸡贼、借助江湖地位互相吹捧,压制老前辈的学阀。这一篇文章的操作也真是刚的很。

并且,Schmidhuber还发表过Hinton、LeCun等人出名,是因为背后有谷歌、Facebook这样的大公司在背后做宣传的言论。

后来,LeCun在一封email回复中写道:“Jürgen 对众人的认可过于痴迷,总是说自己没有得到应得的很多东西。几乎是惯性地,他总是在别人每次讲话结束时都要站起来,说刚刚提出的成果有他的功劳,大体上看,这种行为并不合理。”

出生于1963年的Jürgen Schmidhuber,在他15岁时就坚信通用人工智能一定会实现,当时那个年代中国刚刚改革开放。

婴儿时期的Jürgen Schmidhuber,左边是他父亲

“作为一个少年,我意识到人们可以做的最重要的事情就是建立一种学会变得比人类聪明的东西。”

Jürgen Schmidhuber在年轻时候曾对他弟弟讲,人类可以一个原子一个原子地重建大脑,可以用铜线代替我们缓慢的神经元作为连接,想象力非常大胆。弟弟刚开始很反对哥哥这套人造大脑可以模仿人类情感和自由意志的观点。但最终,”我意识到他是对的。“

高中毕业后,Schmidhuber从1981年开始学习计算机科学和数学,并在西德军队服役15个月,服兵役时就展现出他特立独行的性格,他不喜欢被人颐指气使,特别是被要求做一些他认为没用的事情。

他的在线简历精心编制了他在学术界的历程,包括诸如“加州理工学院拒绝了他的博士后申请”等等,到现在,Schmidhuber的个人主页也是颇有特色。

Schmidhuber对通用人工智能的追求一直持续了40多年,他坚定不移的认为:我们生活在《黑客帝国》形式的(Matrix-style)计算机模拟中。

他曾说过:“在我的成长的过程中,我一直追问自己,我能产生的最大的影响是什么?这个问题后来变得清楚了,就是我要造出比我自己更聪明的东西,而这个东西又将造出更聪明的东西,如此等等,最终它将掌管并改变整个宇宙,使整个宇宙变得智能。”

参考链接:

https://people.idsia.ch/~juergen/most-cited-neural-nets.html

https://www.bloomberg.com/news/features/2018-05-15/google-amazon-and-facebook-owe-j-rgen-schmidhuber-a-fortune

https://www.quora.com/Was-J%C3%BCrgen-Schmidhuber-right-when-he-claimed-credit-for-GANs-at-NIPS-2016

https://www.inverse.com/article/25521-juergen-schmidhuber-ai-consciousness

本文素材来源于网络,如有侵权,联系删除!

— 推荐阅读 — NLP ( 自然语言处理 )

CV(计算机视觉)

推荐

最新大厂面试题

AI开源项目论文