计算机视觉是否已经进入瓶颈期?

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

本文转自|新机器视觉

但CV领域自身的理论发展仿佛速度在放缓,那么未来CV的发展会不会因为自身发展的不足而只能依托其他领域发展的支持,计算机视觉领域是否会产生饱和甚至萎缩。不论兴趣,单从时机考虑,现在进入这个领域还来得及吗?

周博磊:

谢邀, 其实这个问题也是我近段时间一直在思考的问题. 昨天刚在组里做了个ECCV'16 Recap, 整理一下思路, 来尝试抛砖引玉.

我的观点是:计算机视觉在人工智能和深度学习的大背景下方兴未艾.

这里进入瓶颈期的,可能是一些计算机视觉的经典问题,如物体识别和检测(人脸,行人,物体,场景 etc).但是如果能死磕这些经典问题,往往能带来质的突破,比如说对于ImageNet物体识别GoogLeNet之后,大部分人应该都不会想到还有ResNet这种牛逼网络的出现:).计算机视觉这个领域本身,我觉得是正在蓬勃发展, 经典问题得到了更好的解决, 新的问题也不断涌现.

如果把Deep Learning进入CV的2012年作为新时代的开始,我自己是从旧时代来的人.对于从旧时代过来的人,现在无疑是CV以及AI最好的时代.我自己当年是看着Dahua Lin的blog,以及Filestorm和 田渊栋在SJTU饮水思源AI版的论战进入CV和AI研究圈子的(这里特别感谢三位师兄当年的分享),那时候大家讨论的东西都是graphical model, sparse coding, bag of SIFT, spatial pyramid 啥的,也没有工作抢着放arXiv的传统,也没有满大街的open source libraries. 每年CVPR接收的论文到现在的1/2都不到. 每次开会前proceeding放出来的时候都会沐浴更衣把大部分感兴趣的论文扫一遍.

现在的CV和AI研究其实是变得越来越扁平快了.随手可得的open source libraries和pretrained models, 互联网上各种分享的学习资料和经, 便宜的GPU计算资源, 以及百花齐放的研究方向,都使得新入行的生猛年轻人能很快倒腾出新东西. 发表CVPR, NIPS, AAAI等顶会文章也不再是难事. 论文数量和研究方向也是繁多. 已经很难follow.

现在很多时候, 我觉得做CV的研究更像是在拼工程能力, 而不是拼insight和积累了. 后来的人也许并没有多少动力和精力去学习和了解之前的经典. 这也是我担忧的地方. 但时代造人, 这些也是无可厚非的, 毕竟我们希望更多有闯劲的年轻人进入CV和AI圈子, 一起大炼钢:). 争先放arXiv, 开源code等无疑加速了研究的迭代速度, 有更大的可能性激发出新的研究方向和成果. 大公司们(Google, Facebook, Amazon)以及诸多startup们, 也都虎视眈眈地渴望着更多更好的研究工作出现.

另外, 如果硬要我说几个CV目前有肉容易啃的方向, 那我就大致提提(注:这些方向大致都偏纯学术,有什么商业价值我并不是怎么关心):

Robotics (or Simulation Graphics)+Vision. Robotics那边的人普遍比较保守, 更执着于传统template matching之类的传统方法. 这里有个段子, 我们MIT机械工程系robotics方向的大牛教授John Leonard很久以前评论Computer vision, 直接说你们'CVPR'里面的各种论文, 就是Computer Vision and Precision Recall. 什么意思大家应该能理解:). 不过在deep learning开始真正work的时代, 他这句话应该不太适用了(笑). 回到正题, Robitics本身是块非常大的饼, 很多问题和方法都可以用deep learning (CNN + Deep Reinforcement learning) 重新解决. 偏Robotics的话, 大家可以留意一下Berkeley的大红人Sergey Levine最近的工作(Sergey Levine). 偏Vision的话,可以看看CMU的大红人Abinav Gupta的ECCV paper Curious Robot (https://arxiv.org/pdf/1604.01360v2.pdf). Jianxiong Xiao之前主打的3D deep learning (http://robots.princeton.edu/talks/2016_MIT/RobotPerception.pdf)也可以算在这个里面,他们团队和MIT团队最近搞了个Amazon Pick challenge, 模型和方法还有点意思(MIT-Princeton Vision Dataset for the APC 2016). 不过Xiao已经下海经商, 不知道还会不会actively publish. 现在各大公司和startup猛搞的autonomous drive, 也可以放在这个方向之下.

最近我还留意到一个非常有潜力的方向Simulation+Vision. 我觉得有两个具体方向,一个是利用graphics里面的rendering仿真技术,生成大量数据.这些数据因为是生成出来的,任何ground-truth都有,而且要多少有多少, 是获取训练数据的一个捷径.CVPR'16有篇做synthetic image dataset for semantic segmentation of urban scene(http://www.cv-foundation.org/openaccess/content_cvpr_2016/papers/Ros_The_SYNTHIA_Dataset_CVPR_2016_paper.pdf).另外一个方向是结合graphics中的simulation,利用deep reinforcement learning等active learning的算法可以无监督/弱监督训练出agent model,这里就不仅限于纯CV了.DeepMind和OpenAI在猛搞这个方向.偏vision的话大家可以参考下Allen Institute这篇(https://arxiv.org/pdf/1609.05143v1.pdf).

Generative visual models. 目前大部分的模型都是discrminative model, 给定input, 然后识别label. 但这个故事的另外一半其实是generative model, 给定label, 然后生成图片. generative models是一个很有潜力的大方向. 这里的最新进展一方面是基于GAN (https://arxiv.org/pdf/1511.06434v2.pdf) 所带来的一种训练图片生成的新思路, 也包括一些基于传统image model, 如MRF和CRF在deep learning的新思路下面进行重新理解. DeepMind的这篇PixelCNN(https://arxiv.org/pdf/1606.05328v2.pdf), 最近Zhirong和Dahua的挺不错的ECCV论文(http://dahua.me/papers/dhlin_deepmrf.pdf). 个人觉得Varionational Autoencoder也是个蛮漂亮的模型, 这里有篇关于VAE的最新的tutorial还不错(https://arxiv.org/pdf/1606.05908v2.pdf). 以后deep learning跟bayesian model的结合也会是个颇具潜力的方向.

Multimedia Computer Vision. 其实人的感知系统本身就是多模态的, 视频和声音共同结合.Video analysis不再局限于action recognition, 对内容本身有更深的理解. 比如说最近的MoiveQA (MovieQA), Visual Anticipation prediction (http://web.mit.edu/vondrick/prediction.pdf

). 另外, sound也是一个大家普遍忽略掉的一个东西. 大家可以看看我们组Andrew Owen的两个蛮有意思的工作ECCV'16 Ambient Sound Provides Supervision for Visual Learning (https://arxiv.org/pdf/1608.07017.pdf), CVPR'16 Visually Indicated Sounds (Visually Indicated Sounds). 多模态来研究vision是个大趋势.

微软亚洲研究院:

谢邀。近几十年来,计算机视觉技术从研究领域到工业应用领域,已从最初的冷门发展到今天的炙手可热。在微软亚洲研究院建院之初,计算机视觉应用非常少,很冷门,然而微软亚洲研究院成立的第一个研究小组却是视觉计算组。

视觉计算组由优秀的研究员和工程师组成,他们的专长涵盖了计算机视觉研究领域的整个范畴:从数学理论到现实应用,从物理系统到软件开发,从低层次的图像处理到高层次的图像理解。该组的研究成果已经对许多重要应用产生了深刻影响,例如人脸检测、追踪、识别,图像搜索,物体检测、追踪、识别,以及机器人避障和导航。

关于这个问题,我们很乐于给出自己的见解。

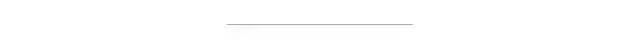

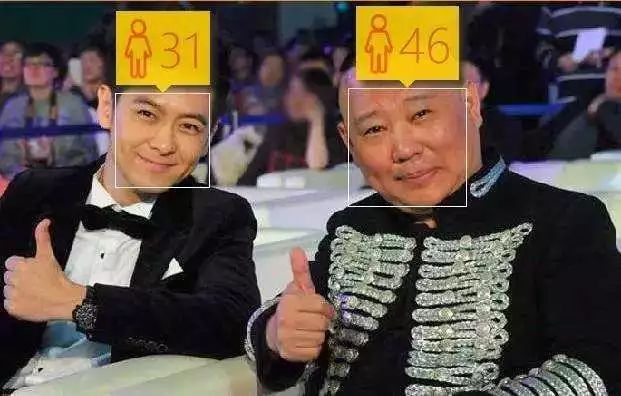

————这里是正式回答的分割线———— 在一个网页上上传自己的照片,让电脑判断自己照片中看起来的年龄,这款名叫http://How-old.net的应用在2015年红爆了社交网络,一时间刷爆了各个社交网络平台,在全球风靡,即使是平常对自己外貌再不关心的人也不介意花上一分钟测测自己照片中显示出来的年纪,虽然结果并没有百分之百的准确,但是科技与诙谐结合带来的新鲜感,让众多网友对这个简单的应用爱不释手,也让不少人对计算机视觉技术产生浓厚的兴趣。

在一个网页上上传自己的照片,让电脑判断自己照片中看起来的年龄,这款名叫http://How-old.net的应用在2015年红爆了社交网络,一时间刷爆了各个社交网络平台,在全球风靡,即使是平常对自己外貌再不关心的人也不介意花上一分钟测测自己照片中显示出来的年纪,虽然结果并没有百分之百的准确,但是科技与诙谐结合带来的新鲜感,让众多网友对这个简单的应用爱不释手,也让不少人对计算机视觉技术产生浓厚的兴趣。 这款应用是微软Build 2015开发者大会的衍生品,据说是两个技能爆表而又闲得无聊的工程师用了两天的时间,基于Azure云里的微软认知服务 Face API 等API识别照片中的人脸和特征,实现了整个应用的功能。

这款应用是微软Build 2015开发者大会的衍生品,据说是两个技能爆表而又闲得无聊的工程师用了两天的时间,基于Azure云里的微软认知服务 Face API 等API识别照片中的人脸和特征,实现了整个应用的功能。

1.从获取图像到读懂图像

计算机视觉是从图像和视频中提出数值或符号信息的计算系统,更形象一点说,计算机视觉是让计算机具备像人类一样的眼睛,看到图像,并理解图像。

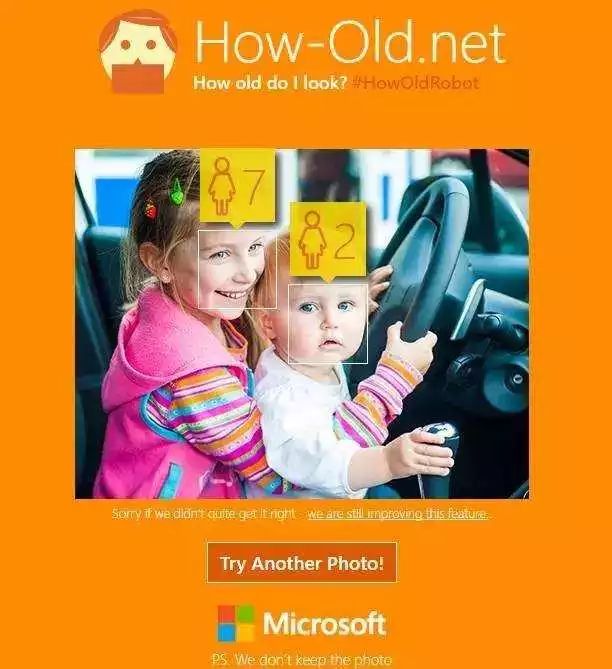

在计算机起步阶段,就有人觉得计算机应该具备“眼睛”,能够看能够理解。20世纪50年代末,图像增强第一次应用在对太空和航拍图像进行处理方面,人们开始发现计算机视觉真的可以应用。60年代初,模式识别在计算机视觉领域得到广泛的应用,例如字符识别等应用成了模式识别的经典应用。到了60年代末,有个麻省理工的博士生第一次从图像中提取出三维信息,把一个实体的物体从二维图像中提出来。随后,麻省理工学院在70年代成立了机器视觉的研究组,并且开设了相关的课程。

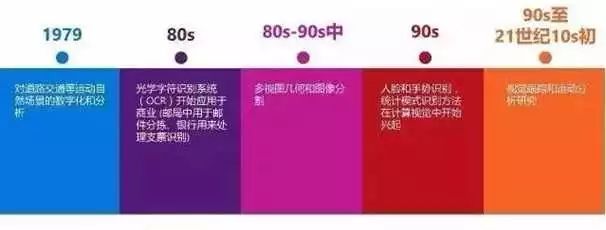

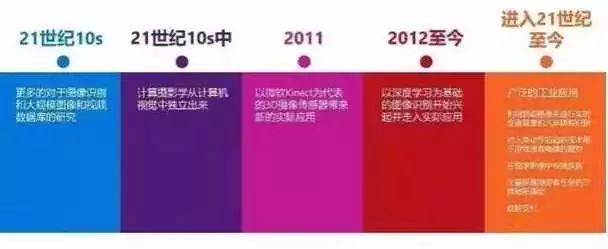

从70年代到现在,40年间计算机视觉得到迅速地发展,许多计算机视觉的应用出现在了生产生活领域,例如对道路交通等自然场景进行数字化分析、OCR应用在邮局分拣信件以及手写体的支票、人脸识别的门禁……期间,多视图几何和图像分割、视觉跟踪和运动分析、大型图像和数据库等研究对计算机视觉起了很大的推进作用。到了2011年,人们才真正发现计算机视觉的巨大商业价值,这一年以Kinect为代表的3D摄像传感器出现在公众的视野内,人们发现计算机不仅能看见,能够理解动作并实时做出反应。

然而,计算机识别的准确性始终是计算机视觉应用的瓶颈,直至2012年,基于深度学习的图像识别技术出现,极大地提高了计算机视觉的识别精确度。这些算法的可靠性促进了工业界的应用,比如车牌识别、游戏中的动作追踪、疾病监测等。

2.深度学习变革图像识别领域

在2012年深度学习技术出现后,识别的错误率有了突变性的改变,但是错误率降到一定阶段之后,再降下去就非常困难了。而且,计算机难以跟上环境变化的节奏,一旦光线和角度等环境因素发生变化,就会误识。以人脸为例,最初研究者试图将人脸想象成一个模板,用机器学习的方法掌握模板的规律,然而人脸虽然看起来很固定,但角度、光线、打扮不同,样子就有差别,令模板难以匹配所有人脸。人脸识别的核心问题在于,如何让计算机忽略同一个人的不同时刻的差异,又能发现两个人之间的差别。人工神经网络技术的引进是计算机视觉超越模板识别的关键。

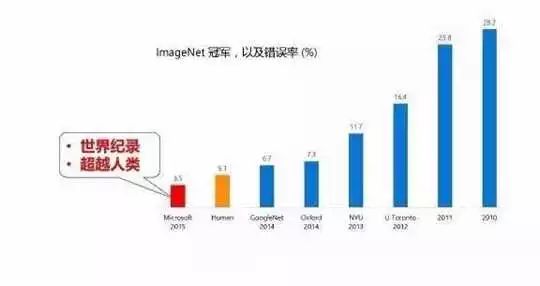

2006年,有研究者发现多隐层的人工神经网络一方面具备更优异的特征学习能力,另一方面能通过逐层初始化克服机器学习的训练问题。但是,通常神经网络仅能做两三层,深度越深越不稳定,无法算出结果。2012年多伦多大学的研究者在神经网络研究有了一个新突破,将神经网络做到8层。2014年剑桥大学的研究者把深度升级到19层。2015年,微软亚洲研究院的研究员们基于残差学习,将深度提升到152层,凭借深度神经网络带来的准确识别能力,微软在2015的 ImageNet 大规模视觉挑战赛中以绝对优势获得图像分类、图像定位以及图像检测三个主要项目的冠军。

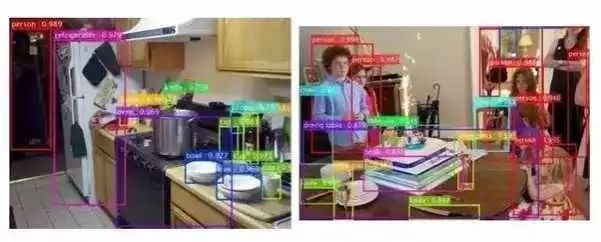

3.物体检测的新突破

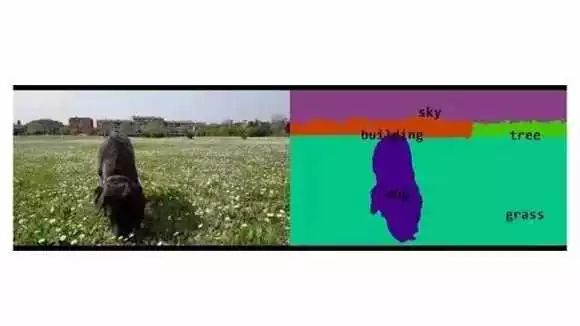

在图像识别中,物体检测是人类从做计算机视觉开始便怀揣着的梦想——拿到一张图可以辨别里面有什么东西、在哪里?在微软的识别技术中,不仅能高准确度判断出有没有某件物体,判断出在什么位置,甚至还能达到像素级别的物体分割,将图像中的每一个像素属于哪个物体精确地识别出来。

物体检测=定位+识别

视频中的物体分割

4.未来:计算机视觉触手可及

http://How-old.net应用火爆社交网络之后,微软又推出了一款 “微软我们”应用,用户只要登陆“微软我们”网站,任意上传两张人物照片,就可以获知人脸的相似度。与此同时,更多基于计算机视觉技术的有趣应用也逐渐出现在公众的视野中:可以帮你找到和你长得相似的明星的应用CelebsLike、帮助你鉴别狗狗品种的应用Fetch、识别你的表情并用相应emoji表情代替的应用FaceHero……尖端的计算机视觉技术,正在以诙谐有趣的形象引起公众的兴趣,让公众轻松体验到其中的奇妙。计算机视觉不再是深藏楼阁的技术,而将在生活中随处可见,触手可及。

2015年5月初,微软正式公布了牛津计划(如今已融入微软认知服务中),这是一系列基于云端的与计算机学习相关的智能API、SDK和相关的服务被提供给开发者,开发者不再需要拥有繁复的机器学习等背景也能轻松开发出智能的包括计算机视觉在内的应用,让想法不再只是想法。微软认知服务:Seeing AI应用youku.com视频萨基博·萨科(Saqib Shaikh)是微软在英国团队的一位软件工程师,7岁就不幸失明,他凭借着自己的不懈努力,成为一位软件工程师。在微软工作时,他参与了微软正在研发阶段的人工智能项目:Seeing AI,这个项目帮助萨科“看见”和“了解”他眼前的世界。在展示视频中,当萨科滑动镜腿时,Seeing AI就可以识别出景象,并通过语音告诉萨科眼前是什么,例如公园中正在玩耍的人,会议室的空位,与会者的年龄、性别以及情绪,帮他读懂餐馆的菜单……这种科幻小说中才有的场景,正在逐渐被实现。这个充满人文关怀的应用,背后正是微软认知服务的开放API提供的强有力的支持。在诙谐之外,微软亚洲研究院的计算机视觉技术数十年的技术积淀已经在生活的方方面面展现出更加实在的价值,而这仅是开始。

卢策吾:

我很同意博磊的看法,计算机视觉在人工智能和深度学习的大背景下方兴未艾。如果我们站在人工智能的big picture上看,在迈向强AI的路上,vision还有太多的东西可以去开拓了。

举个例子:

博磊特别提到的Robotics (or Simulation)+Vision,我见到北美几个组热火朝天地搞起来了(比如我好朋友Yuke做的https://arxiv.org/pdf/1609.05143v1.pdf)。

我感觉这是往强AI方向的升级。以前,vision一直都在做“let

machine see like human”。现在,开始思考“let machine act like human”(大家想想,这显然更AI,能干更多的事情啦)。

以前是 “see“这个基础都没有,机器就是一个瞎子,让它“act

like human”就很不靠谱了。现在因为深度学习,基本具备“see”这个条件后,自然有一批visioner去琢磨这件事了。这对vision也就提出新的挑战,同时学习perception和how to

act。deep reinforcement learning 刚好就是干这个事的,所以关注的人也很多,也很work,我自己也在无人车仿真玩过,效果真不错(当然做到真正强AI, deep RL目前也有自己的缺陷)。

想想baby 的学习过程中 , 学习perception和how to act是相互伴随,互相促进的。这样也会使perception的档次提高,目前的object

detection and segmentation,对应到人类语言语义大概是名词级别的语义,是非常浅的,接下来还有动词,短语级别,句子级别 ,故事级别。如果机器完全理解了how to act,会很大程度地帮助我们获得更深层的perception。当然,深语义的perception也帮助了how to

act。Deep

reinforcement learning 比传统reinforcement learning好,就是因为perception 更好了。

为什么是simulation+vision呢?因为要在真实世界里学习how to

act成本太高了(找个机器人来不停试错不现实)。所以一条路就是create

strong AI in virtual world, thus apply in real world。从研究角度来讲,simulation+vision

to create stronger AI就是成为第一步,后面apply to real world还有一大堆问题可以探索的。要是做好了按在各种机器人上让它自主干活,那就是威力巨大了(从AI角度看,无人车算是简单的机器人吧),估计也是不小的产业。

以上只是一个例子而已(也是一个尝试),我想说的我们在解detection和segmentation这些传统问题同时,作为研究者,不妨也站在整个大AI的背景下看看,想想vision和DL如何面向强AI,迈一小步,再迈一下步,再迈一小步…….

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~