Trick详解|pytorch 中实现余弦退火重启动学习率机制

极市导读

主要介绍在pytorch 中实现了余弦退火重启动学习率机制,支持 warmup 和 resume 训练。并且支持自定义下降函数,实现多种重启动机制。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

代码:https://github.com/Huangdebo/CAWB

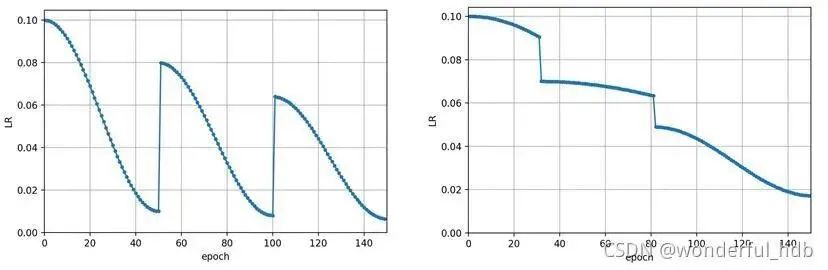

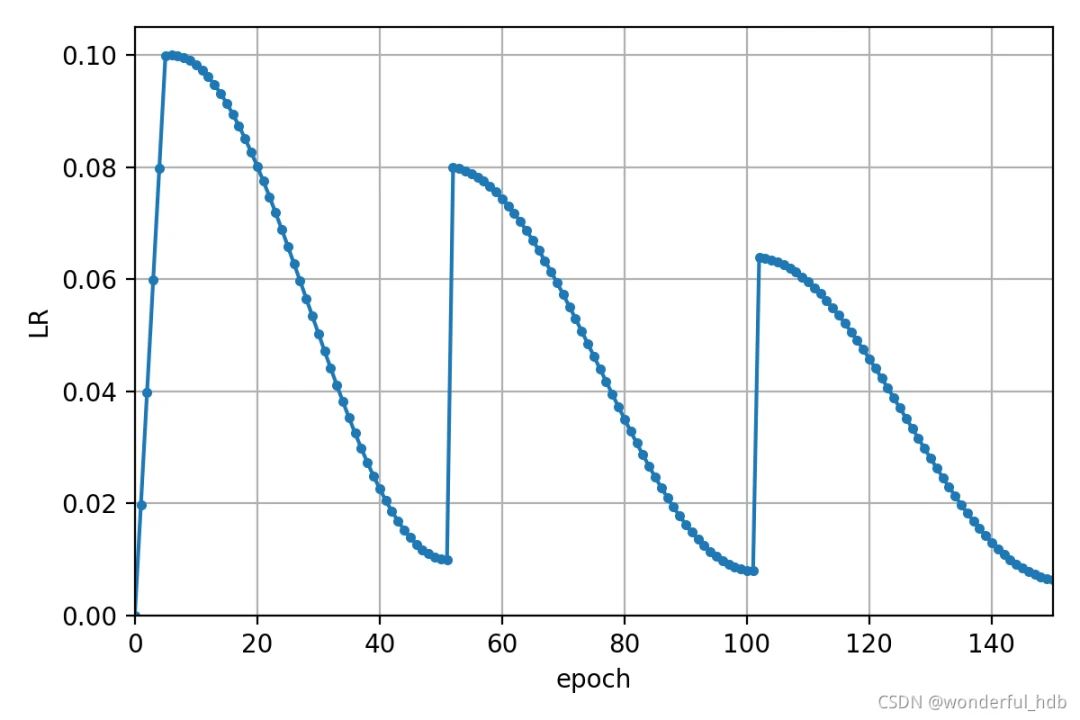

1. 多 step 重启动

设定 cawb_steps 之后,便可实现多步长余弦退火重启动学习率机制。每次重启动时,开始学习率会乘上一个比例因子 step_scale。调整 step_scale 和 epoch_scale 等参数,可以实现学习率跳变的时候是上升还是下降。也可以调整中间的 step 不用走完一个退火过程,保持较高的学习率,实现更复杂的学习率变化机制。

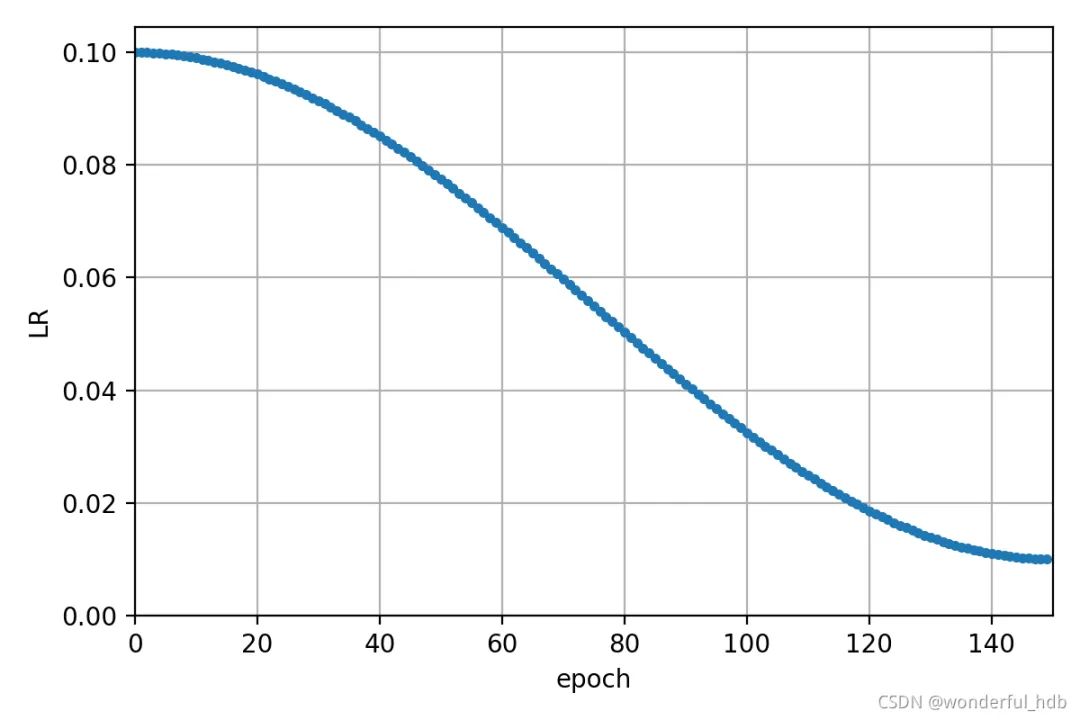

2. 正常余弦退火机制

如果 cawb_steps 为 [], 则会实现正常的余弦退火机制,在整个 epochs 中按设定的 lf 机制一直下降

3. warmup

设定 warmup_epoch 之后便可实现学习率的 warmup 机制。warmup_epoch 结束后则按设定的 cawb_steps 实现重启动退火机制。

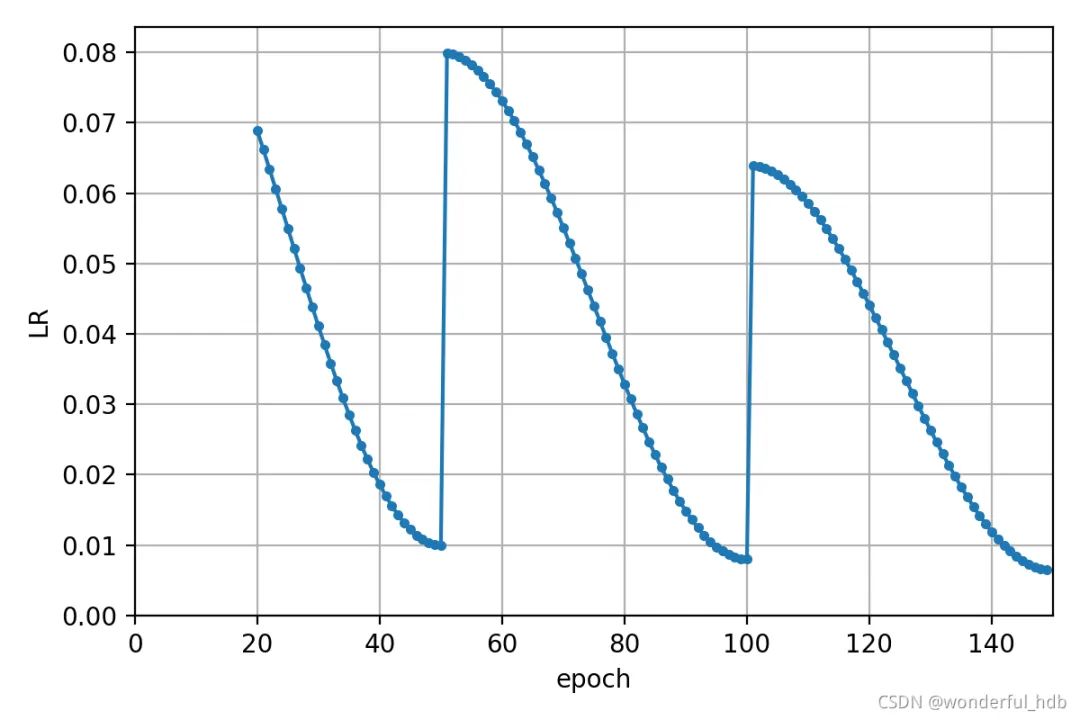

4. resume

设定 last_epoch 便可实现 resume 训练,接上之前中断的训练中的学习率。

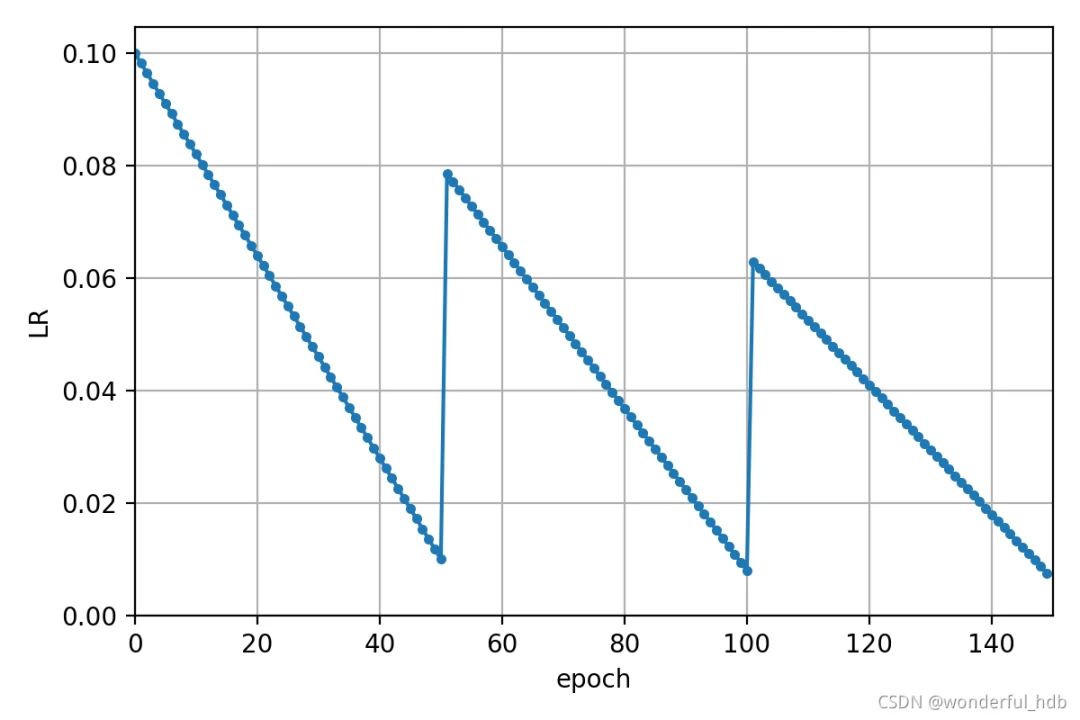

5. 自定义下降函数

可通过自定义下降函数,实现多种重启动机制

# lf = lambda x, y=opt.epochs: (((1 + math.cos(x * math.pi / y)) / 2) ** 1.0) * 0.9 + 0.1lf = lambda x, y=opt.epochs: (1.0 - (x / y)) * 0.8 + 0.2scheduler = CosineAnnealingWarmbootingLR(optimizer, epochs=opt.epochs, step_scale=0.7,steps=opt.cawb_steps, lf=lf, batchs=len(data), warmup_epoch=0)

6. 实验结果

本实验是在 COCO2017中随机选出 10000 图像和 1000 张图像分别作为训练集和验证集。检测网络使用 yolov5s,学习率调整机制分别原版的 cos 和 本文实现的 CAWB。

6.1 学习率:

# yolov5lf = lambda x: ((1 - math.cos(x * math.pi / steps)) / 2) * (y2 - y1) + y1scheduler = lr_scheduler.LambdaLR(optimizer, lr_lambda=lf)# 本文lf = lambda x, y=opt.epochs: (((1 + math.cos(x * math.pi / y)) / 2) ** 1.0) * 0.65 + 0.35scheduler = CosineAnnealingWarmbootingLR(optimizer, epochs=opt.epochs, steps=opt.cawb_steps, step_scale=0.7,lf=lf, batchs=len(train_loader), warmup_epoch=3, epoch_scale=4.0)

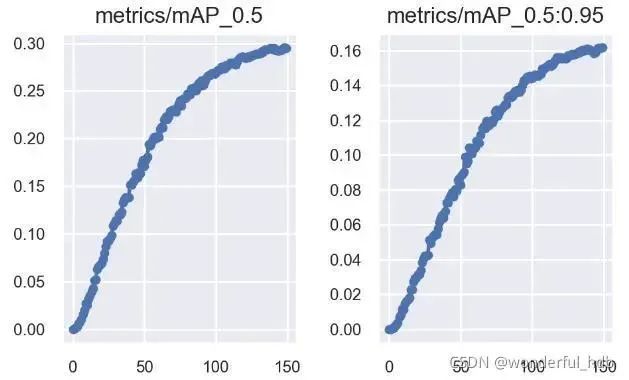

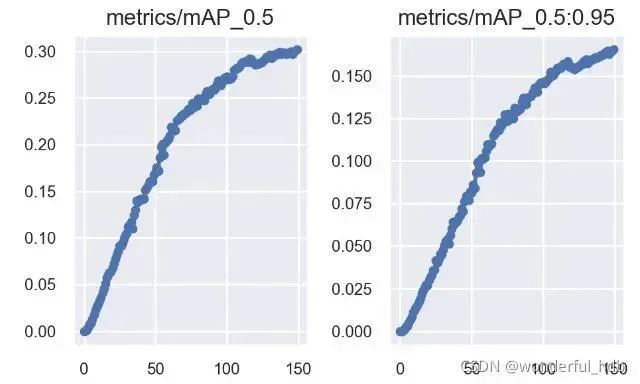

6.2 map:

6.2.1 cos:

6.2.2 CAWB :

7. 结论

在实验中使用了 CAWB 学习率机制时候,mAP_0.5 和 mAP_0.5:0.95 都提升了一丢丢,而且上升趋势更加明显,增加 epochs 可能提升更大。改变 CAWB 的参数可以实现更多形式的学习率变化机制。增加学习率突变就是想增加网络跳出局部最优的概率,所以不同数据集可能合适不同的变化机制。小伙伴们在其他数据集上尝试之后,记得来提个 issue 哈...

代码:https://github.com/Huangdebo/CAWB

如果觉得有用,就请分享到朋友圈吧!

公众号后台回复“CVPR21检测”获取CVPR2021目标检测论文下载~

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~