本文约4000字,建议阅读10+分钟

本文与你讨论一种新的半监督,多任务医学成像方法。

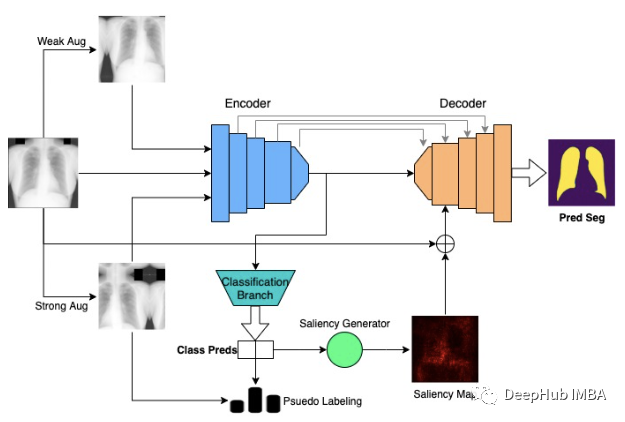

在本文中,我将讨论一种新的半监督,多任务医学成像方法,称为Multimix,Ayana Haque(ME),Abdullah-Al-Zubaer Imran,Adam Wang、Demetri Terzopoulos。该论文被ISBI 2021收录,并于4月的会议上发表。MultiMix通过采用基于置信的增强策略和新型桥模块来执行联合半监督分类和分割,该模块还为多任务提供了可解释性。在完全监督的情况下深度学习的模型可以有效地执行复杂的图像分析任务,但它的性能严重依赖于大型标记数据集的可用性。特别是在医学成像领域,人工标注不仅费钱,而且还耗时。因此允许从有限数量的标记数据的半监督学习,被认为是解决标注任务的一个方案。在同一模型中学习多个任务可以进一步提高了模型的通用性。多任务允许在任务之间进行共享表示的学习,同时需要更少的参数和更少的计算,从而使模型更有效,更不容易过拟合。对不同数量的标记数据和多源数据进行了广泛的实验,论文证明了其方法的有效性。还提供了跨任务的域内和跨域评估,以展示模型适应具有挑战性的泛化场景的潜力,这对医学成像方法来说是一个具有挑战性但重要的任务。背景知识

近年来,由于深度学习的发展,基于深度学习的医学成像技术得到了发展。然而深度学习的根本问题一直存在,那就是它们需要大量的标记数据才能有效。但是这在医学成像领域是一个更大的问题,因为收集大型数据集和标注是非常困难的,因为它们需要领域专业知识,昂贵、耗时,并且很难在集中的数据集中组织起来。另外在医学成像领域中,泛化也是一个关键问题,因为来自不同来源的图像在定性和定量上都有很大的差异,所以很难在多个领域中使用一个模型获得较强的性能,这些问题促使了该论文的研究:希望通过一些以半监督和多任务学习为中心的关键方法来解决这些基本问题。为了解决有限的标签数据问题,半监督学习(SSL)作为一种有前途的替代方法受到了广泛的关注。在半监督学习中,将无标记示例与有标记示例结合使用,使信息收益最大化。关于半监督学习已有大量的研究,包括一般的和医学领域特有的。我不会详细讨论这些方法,但如果你感兴趣,这里有一个突出的方法列表供你参考[1,2,3,4]。解决有限样本学习的另一个解决方案是使用来自多个来源的数据,因为这增加了数据中的样本数量以及数据的多样性。但是这样做是具有挑战性的,因为需要特定的训练方法,但是如果做得正确,它可以非常有效。多任务学习(multitask Learning, MTL)已被证明可以提高许多模型的泛化能力。多任务学习被定义为在单个模型中优化多个损失,通过共享表示学习完成多个相关任务。在一个模型中联合训练多个任务可以提高模型的泛化性,因为每个任务都相互影响(要选择有相关性的任务)。假设训练数据来自不同的分布,这样可以用于有限的不同任务,多任务在这样的场景中对于以很少监督的方式学习是有用的。将多任务与半监督学习相结合可以提高性能,并在这两个任务中取得成功。同时完成这两项任务是非常有益的,因为一个单独的深度学习模型可以非常准确地完成这两项任务。关于医学领域的相关工作,具体方法如下:[1,2,3,4,5,6,7,8,9,10]。然而,这些发现的主要局限性是它们没有使用来自多个来源的数据,限制了它们的泛化性,并且大多数方法都是单一任务方法。因此,论文提出了一种新的、更通用的多任务模型MultiMix,该模型结合基于置信度的桥接块,从多源数据中共同学习诊断分类和解剖结构分割。显著图可以通过可视化有意义的视觉特征来分析模型预测。有几种方法可以生成显著性映射,最显著的方法是从输入图像计算类分数的梯度。虽然任何深度学习模型都可以通过显著性图来研究更好的解释性,但据我们所知,在单一模型中两个共享任务之间的显著性桥梁还没有被探索。算法

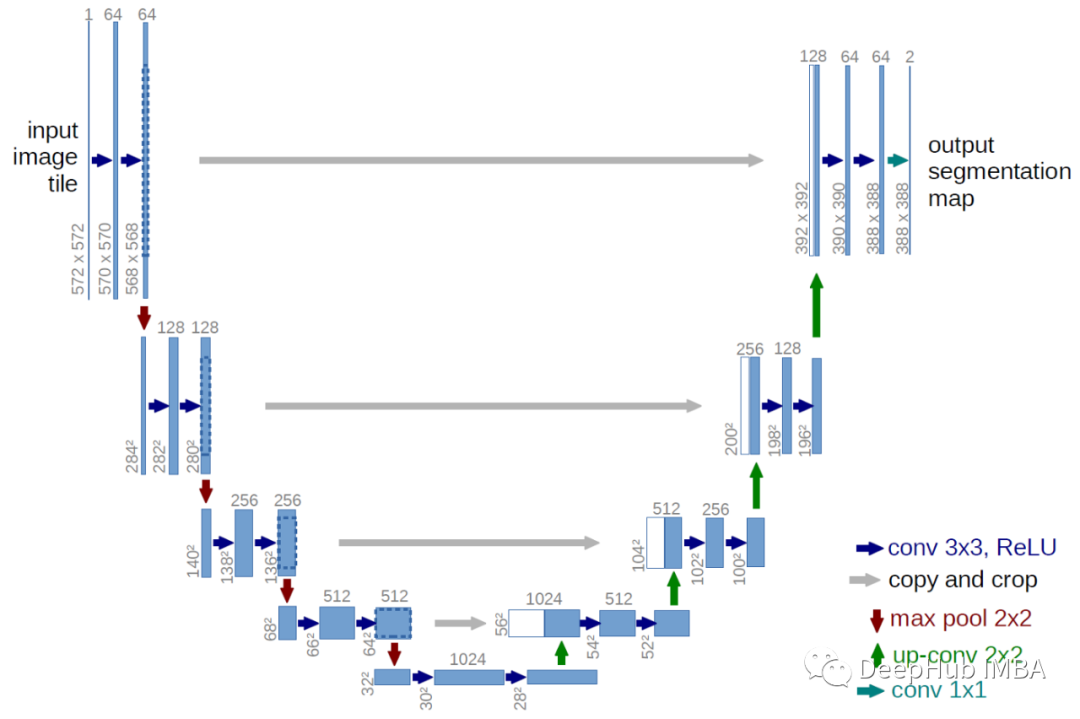

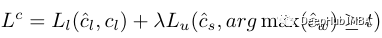

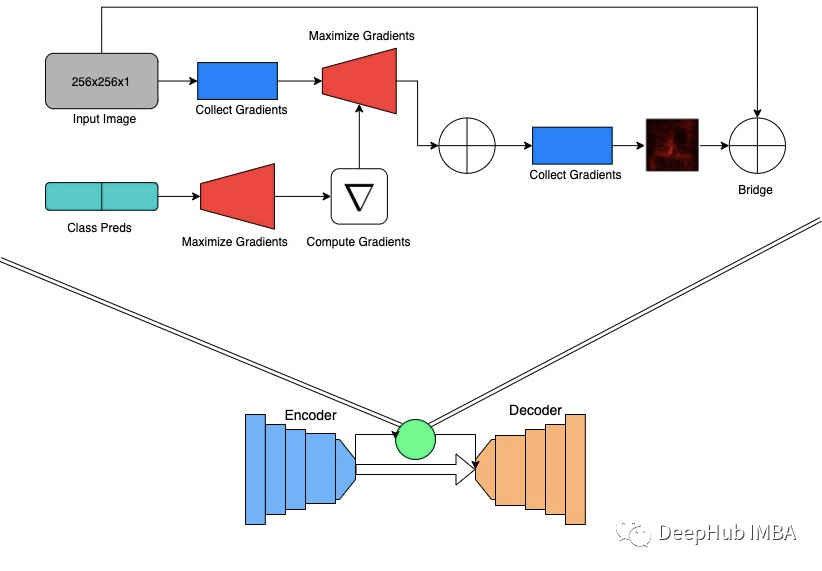

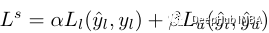

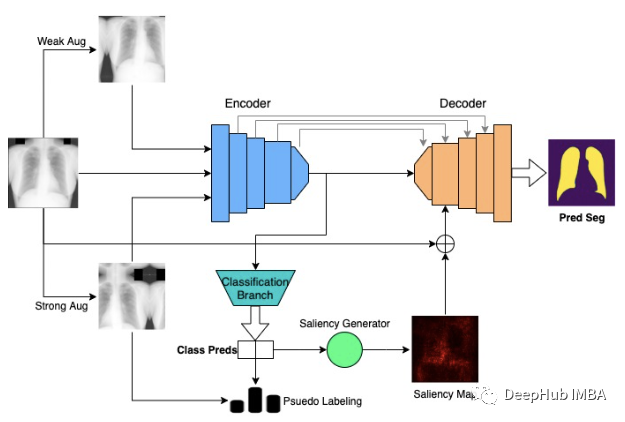

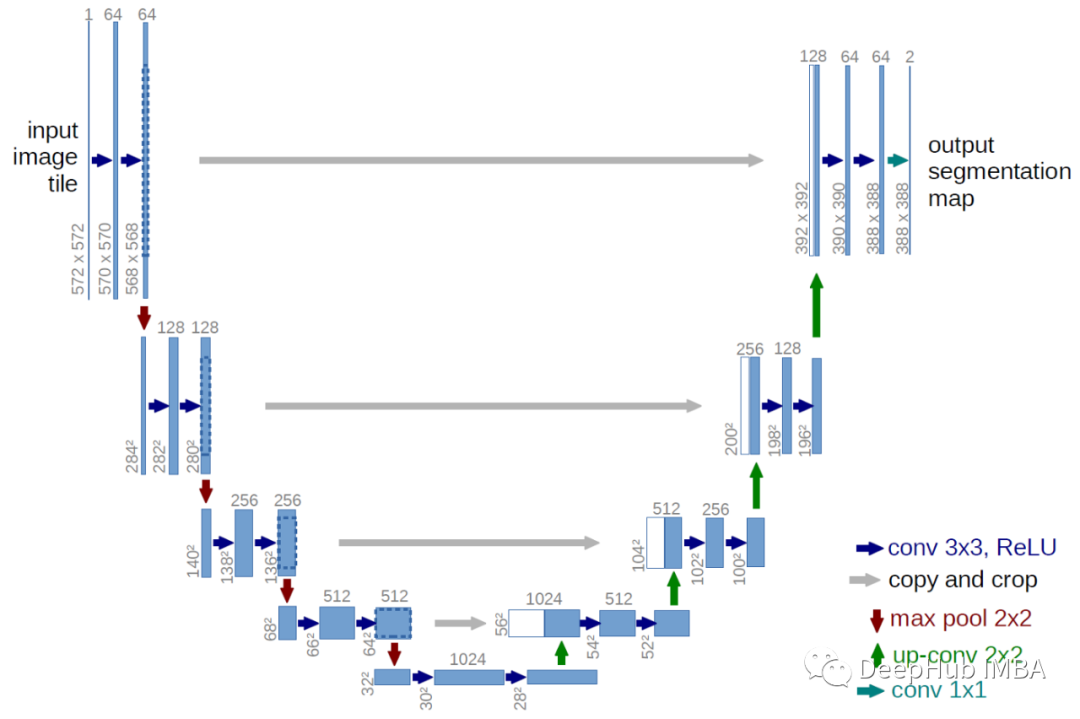

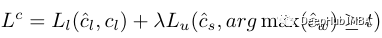

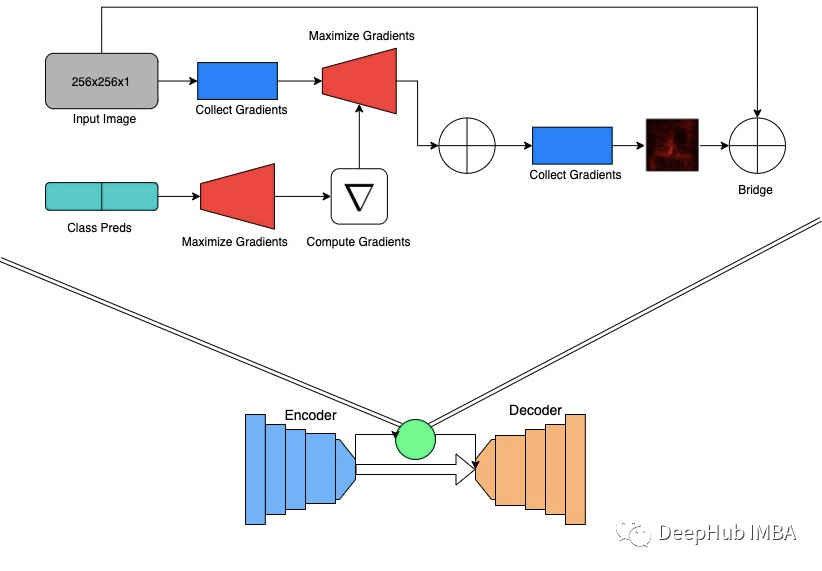

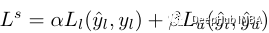

让我们首先定义我们的问题。使用两个数据集进行训练,一个用于分割,一个用于分类。对于分割数据,我们可以使用符号XS和Y,分别是图像和分割掩码。对于分类数据,我们可以使用符号XC和C,即图像和类标签。模型体系结构使用基线U-NET架构,该结构是常用分割模型。编码器的功能类似于标准CNN。要使用U-NET执行多任务处理,我们将从编码器上分支,并使用池化和全连接的层分支以获取最终的分类输出。对于分类方法,利用数据增强和伪标记。受[1]的启发,使用了一个未标记的图像并执行两个单独的增强。首先,未标记的图像被弱增强,并且从图像的弱增强版本中,将模型当前状态的预测定为伪标签。这就是为什么该方法被半监督的原因,但是我们将稍后再讨论伪标记的标签。其次,强增强相同未标记的图像,并用弱增强图像和强增强图像本身的伪标记计算损失。这样的操作理论基础是,希望该模型将弱增强图像映射到强增强的图像中,这样可以迫使模型学习诊断分类所需的基本基础特征。增强图像两次还可以最大化唯一图像的潜在知识收益。这也有助于改善模型的概括能力,就好像模型被迫学习图像中最重要的部分一样,它将能够克服由于不同域而出现的图像中出现的差异。论文使用常规的增强方法来进行弱增强的图像,例如水平翻转和轻微旋转。而强增强策略要有趣得多:创建一个非常规,强大的增强池,并将随机数量的增强量应用于任何给定的图像。这些增强非常“变态”,比如裁剪、自对比度、亮度、对比度、均衡、一致性、旋转、锐度、剪切等等。通过应用任意数量的这些元素,我们可以创建非常广泛的图像,这在处理低样本数据集时尤为重要。我们最终发现,这种增强策略对于强大的性能非常重要。现在让我们回过头来讨论伪标记的过程。如果模型生成伪标签的置信度超过了一个调优的阈值,则该图像标签可以防止模型从错误和糟糕的标签中学习。因为当预测在一开始不太确认时,模型主要从标记的数据中学习。慢慢地,该模型对未标记图像的标签生成变得更加自信,因此该模型变得更加高效。在提高性能方面,这也是一个非常重要的特性。现在我们来看看损失函数。分类损失可以用以下公式来建模:其中L-sub-l为监督损失,c-hat-l为分类预测,c-l为标签,lambda为无监督分类权重,L-sub-u为无监督损失,c-hat-s为强增强图像的预测,argmax(c-hat-w)为弱增强图像的伪标签,t为伪标签阈值。对于分割,通过带有跳过连接的编码器-解码器体系结构进行预测,这非常简单。论文对分割的主要贡献是合并了一个桥接模块来连接两个任务,如上图所示。根据模型预测的类生成显著映射,使用从编码器扩展到分类分支的梯度。整个过程如上所示,但本质上强调了模型用于对肺炎图像进行分类的图像的哪些部分。虽然我们不知道分割图像是否代表肺炎,但生成的地图却突出了肺部。因此当使用显著图产生和可视化图像的类预测时,它在某种程度上类似于肺面膜。所以我们假设这些图可用于指导解码器阶段的分割,并且能够改善分割效果,同时从有限的标记数据中学习。在MultiMix中,生成的显著性映射与输入图像连接,进行下采样,并添加到输入到第一解码器阶段的特征映射。与输入映像的连接可以增强两个任务之间的连接,并提高桥接模块的有效性(提供了上下文)。同时添加输入图像和显著性映射为解码器提供了更多的上下文和信息,这在处理低样本数据时非常重要。现在我们来讨论一下训练和损失。对于标记样本,我们通常使用参考肺面面膜和预测分割之间的dice 损失来计算分割损失。由于我们没有未标记的分割样本的分割掩码,我们不能直接计算它们的分割损失。因此计算标记和未标记示例的分割预测之间的KL散度。这使得模型做出与已标记数据越来越不同的预测越来越接近,这可以使模型更恰当地适合未标记数据。虽然这是一种间接计算损失的方法,但它仍然允许模型从未标记的分割数据中学到很多东西。与分类相比,alpha是分割减少权重,y-hat-l是标记的分割预测,y-l是相应的掩码,beta是无监督的分割权重,而y-hat-u是未标记的分段预测。

数据集

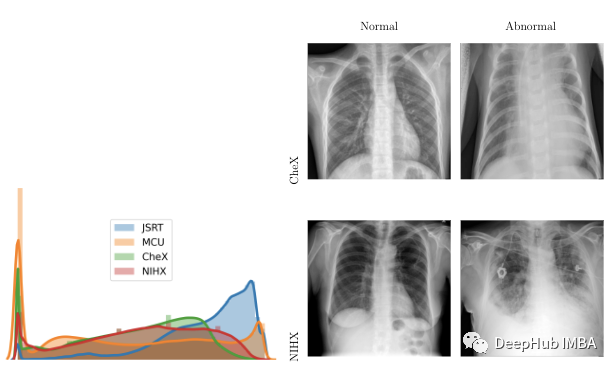

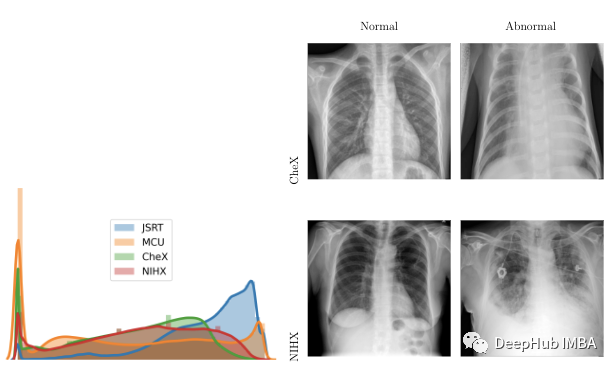

对模型进行了分类和分割任务的训练和测试,每个任务的数据来自两个不同的来源:肺炎检测数据集,我们将其称为Chex [11]和日本放射学技术学会或JSRT [12] [12] ,分别用于分类和分割。为了验证了模型,使用了两个外部数据集蒙哥马利县胸部X射线或MCU [13],以及NIH胸部X射线数据集的子集,我们将其称为NIHX [14]。来源的多样性对模型构成了重大挑战,因为图像质量,大小,正常图像和异常图像的比例以及四个数据集的强度分布的差异都大不相同。下图显示了强度分布的差异以及每个数据集的图像示例。所有4个数据集均使用CC BY 4.0许可证。

结果

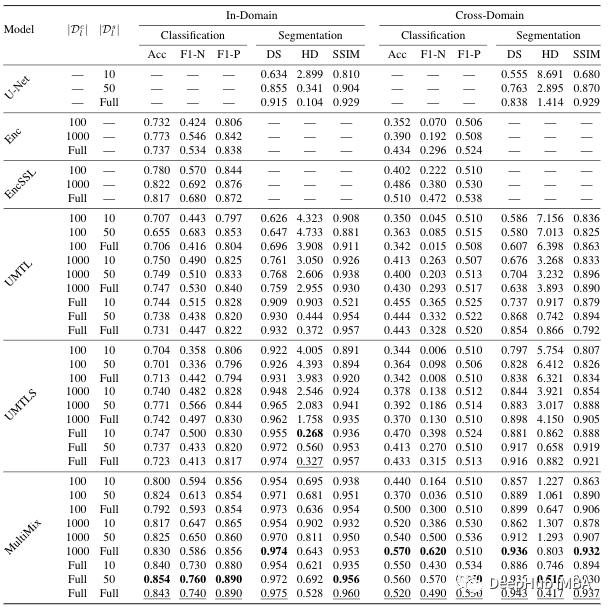

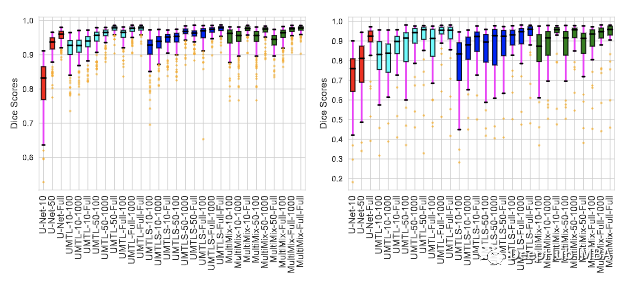

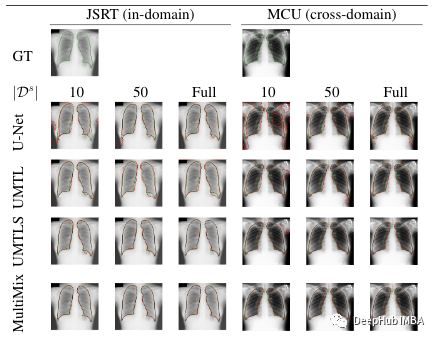

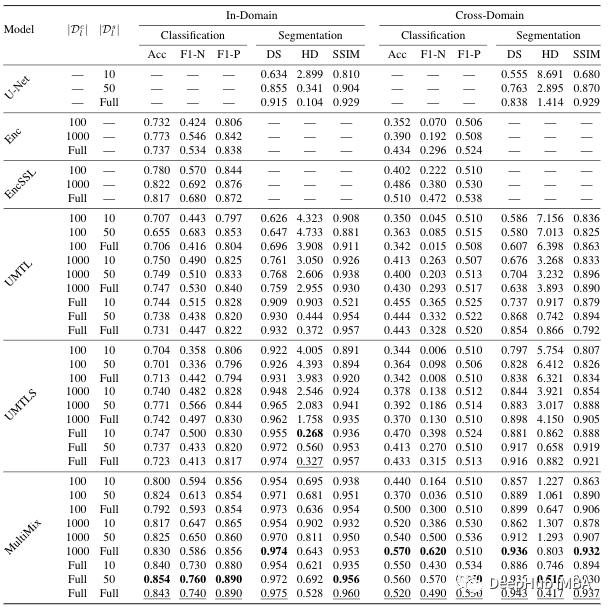

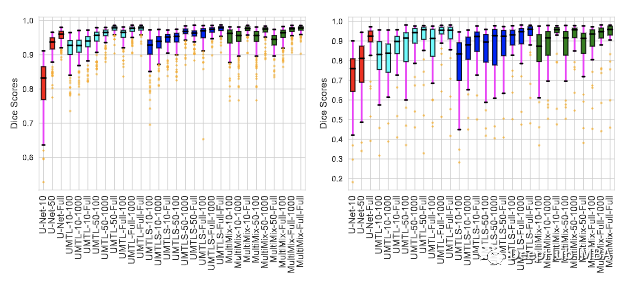

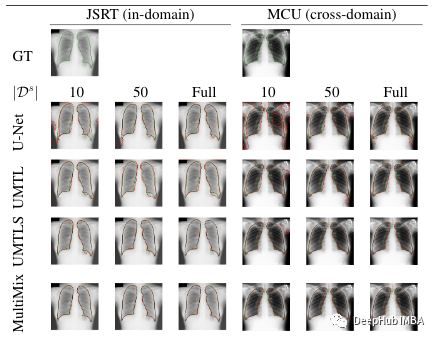

论文进行了许多实验,并在多个数据集中和跨域上使用了不同数量的标记数据。在测试中使用了多个基线,从Arale-net和标准分类器(ENC)开始,该分类器是具有密集层的编码器提取器。然后,我们将两者组合为基线多任务模型(UMTL)。还使用半监督方法(ENCSL),(UMTLS)以及多任务模型和半监督方法(UMTLS-SSL)的多任务模型。在训练方面,在多个标记的数据集上进行了训练。为了进行分类,我们使用了100、1000和所有标签,对于分割,我们使用了10、50和所有标签。对于结果,将使用符号:模型 - 标签(例如Multimix-10–100)的方式进行标记。为了进行评估,使用准确性(ACC)和F1分数(F1-N和F1-P)进行分类,分割则使用了DS相似性(DS),JACCARD相似性评分(JS),结构相似性指数(SSIM) ,平均Hausdorff距离(HD),精度(P)和召回(R)。该表显示了添加了每个新组件的模型性能如何改善。对于分类任务,与基线模型相比,基于置信的增强方法可显著提高性能。Multimix-10–100也以准确性的方式优于完全监督的基线编码器。为了进行分割,桥模块对基线U-NET和UMTL模型产生巨大改进。即使具有最低分段标签,我们也可以看到其性能增长30%,这证明了论文提出的Multimix模型的有效性。如表所示,多模中的性能与内域一样有希望。在所有基线模型上,Multimix在分类任务中的得分更好。由于NIHX和CHEX数据集存在显著差异,如前所述,得分不如内域模型结果好。但是它的确比其他模型更好。上图显示了分割结果对内域和跨域评估的一致性。我数据集中的每个图像显示了模型的dice分数。从图中,可以看到,与基线相比,Multimix是最强的模型。最后一个图是模型的分割预测的可视化。展示了的预测的边界使为每一个提出的分割任务添加对不同标记数据的真值对比。图中显示了与MultiMix针对真实边界的边界预测的强烈一致性,特别是与基线相比。对于跨域MultiMix在很大程度上也是最好的,显示了强大的泛化能力。总结

在这篇文章中,我们解释了一个可用于联合学习分类和分割任务的新的稀疏监督多任务学习模型MultiMix。该论文使用四种不同的胸部x射线数据集进行了广泛的实验,证明了MultiMix在域内和跨域评估中的有效性。https://arxiv.org/abs/2010.14731https://github.com/ayaanzhaque/MultiMix

下载APP

下载APP