多模态深度学习:用深度学习的方式融合各种信息

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

本文转载自AI公园。

作者:Purvanshi Mehta

编译:ronghuaiyang

使用深度学习融合各种来源的信息。

多模态数据

我们对世界的体验是多模态的 —— 我们看到物体,听到声音,感觉到质地,闻到气味,尝到味道。模态是指某件事发生或经历的方式,当一个研究问题包含多个模态时,它就具有多模态的特征。为了让人工智能在理解我们周围的世界方面取得进展,它需要能够同时解释这些多模态的信号。

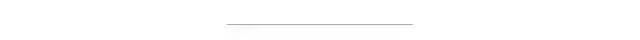

例如,图像通常与标签和文本解释相关联,文本包含图像,以更清楚地表达文章的中心思想。不同的模态具有非常不同的统计特性。

多模态深度学习

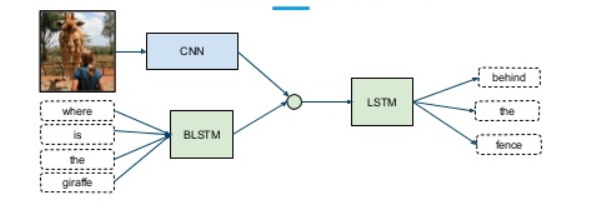

虽然结合不同的模态或信息类型来提高效果从直观上看是一项很有吸引力的任务,但在实践中,如何结合不同的噪声水平和模态之间的冲突是一个挑战。此外,模型对预测结果有不同的定量影响。在实践中最常见的方法是将不同输入的高级嵌入连接起来,然后应用softmax。

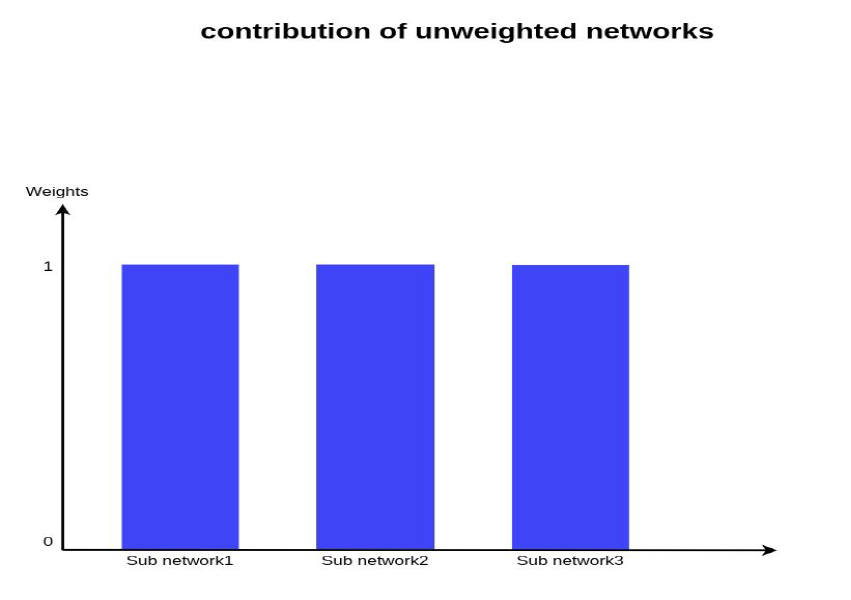

这种方法的问题是,它将给予所有子网络/模式同等的重要性,这在现实情况中是非常不可能的。

对网络进行加权组合

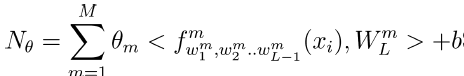

我们采用子网络的加权组合,以便每个输入模态可以对输出预测有一个学习贡献(Theta)。

我们的优化问题变成-

对每个子网络给出Theta权值后的损失函数。

把所有的都用起来!

准确性和可解释性

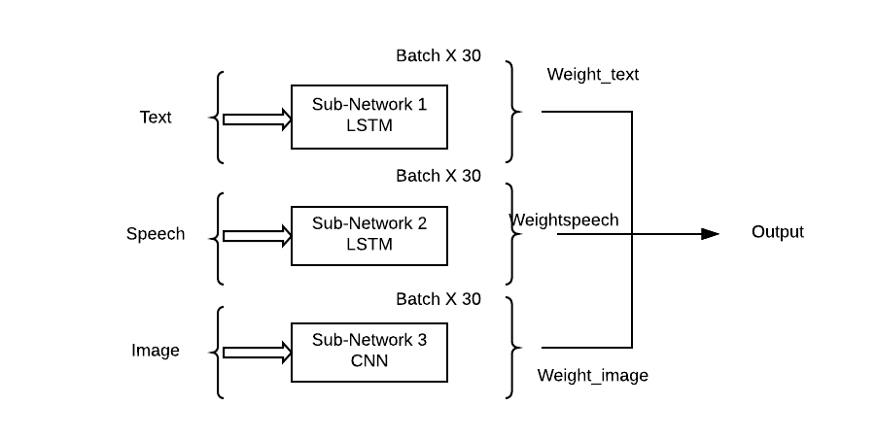

我们在两个现实多模态数据集上得到了SOTA:

Multimodal Corpus of Sentiment Intensity(MOSI) 数据集 —— 有417个标注过的视频,每毫秒标注的音频特征。共有2199个标注数据点,其中情绪强度定义为从strongly negative到strongly positive,线性尺度从- 3到+3。

模态包括:

1、文本

2、音频

3、语言

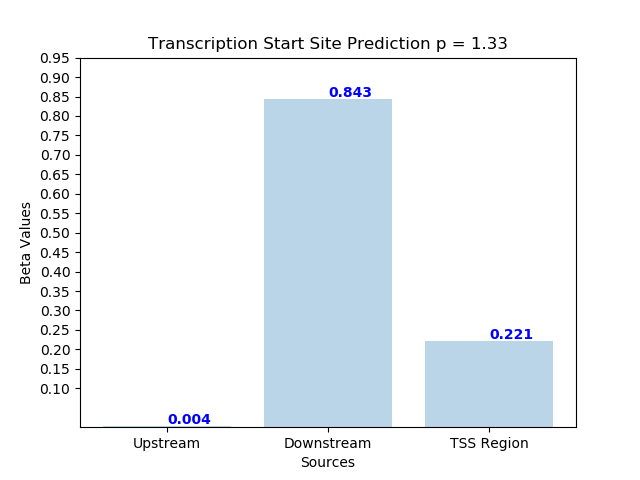

Transcription Start Site Prediction(TSS)数据集 —— Transcription是基因表达的第一步,在这一步中,特定的DNA片段被复制到RNA (mRNA)中。Transcription起始位点是transcription开始的位置。DNA片段的不同部分具有不同的特性,从而影响其存在。我们将TSS分为三个部分:

上游DNA 下游DNA TSS位置

我们取得了前所未有的改善,比之前的最先进的结果3%。使用TATA box的下游DNA区域对这一过程影响最大。

英文原文:https://towardsdatascience.com/multimodal-deep-learning-ce7d1d994f4

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~