使用有限的数据来训练GANs

点击上方“程序员大白”,选择“星标”公众号

重磅干货,第一时间送达

作者:Mayank Agarwal

编译:ronghuaiyang

使用自适应增强判别器(ADA)来训练StyleGAN2。

生成对抗网络(GANs)的长期挑战之一是在很少数据的情况下训练它。小数据集的关键问题是识别器对训练样本的快速过拟合。鉴别器的工作是将其输入分类为假的或真的,但由于过拟合,它把除了训练数据集以外的所有东西都作为是假的。结果,生成器收到的反馈很少,无法改进它的生成,训练失败。在本文中,我们讨论了Karras等人的最近的工作,通过自适应鉴别器增强来解决这个问题。

在深度学习的几乎所有领域,数据增强是防止过拟合的标准解决方案。例如,在旋转、噪声、模糊等条件下训练图像分类器,会导致在失真情况下这些语义保持不变性增加 —— 这是分类器非常需要的品质。然而,这并不能直接用于训练GANs,因为生成器将学习如何生成增强后的分布。这种对生成的样本的增强的“泄漏”是非常不可取的。

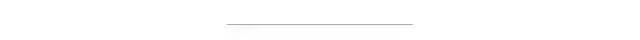

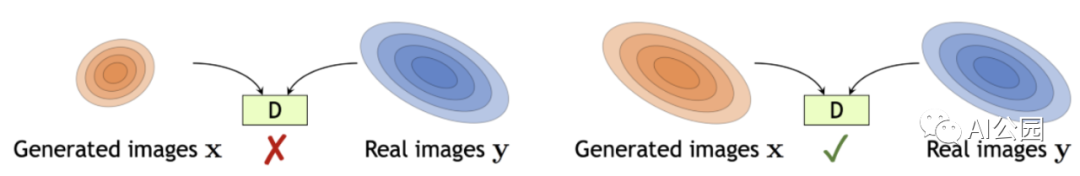

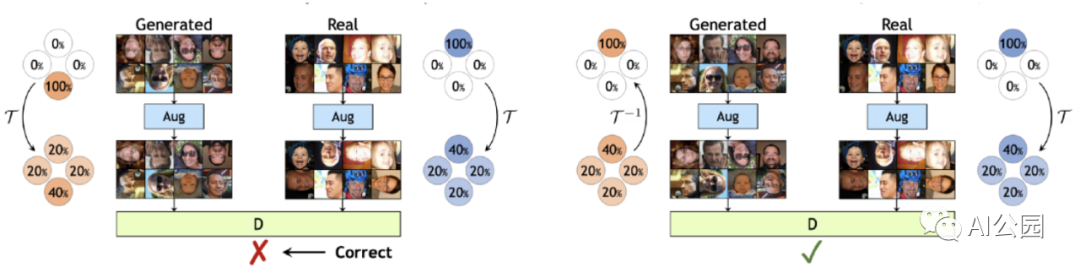

为了克服这种“泄漏”问题,作者提出了一种称为随机鉴别器增强的增强技术。他们只使用增强图像来评估鉴别器,并且在训练生成器时也这样做。鉴别器增强相当于在鉴别器上戴上失真镜,并要求生成器生成的图在通过失真镜观察时无法与训练集样本区分。

然而,这种方法只有在这种扭曲可以用数据空间上的概率分布的“可逆”变换来表示时才有效。重要的是要理解,这并不意味着在单个图像上执行的增强就必须是可逆的。例如,从概率分布的意义上讲,将输入图像的90%置为零这样极端的增强是可逆的,即使对人类来说,通过忽略黑色图像直到只剩下10%的图像,来推断原始分布是很容易的。

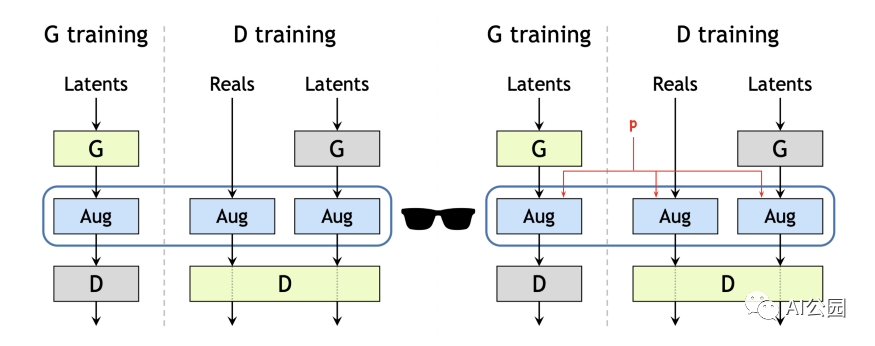

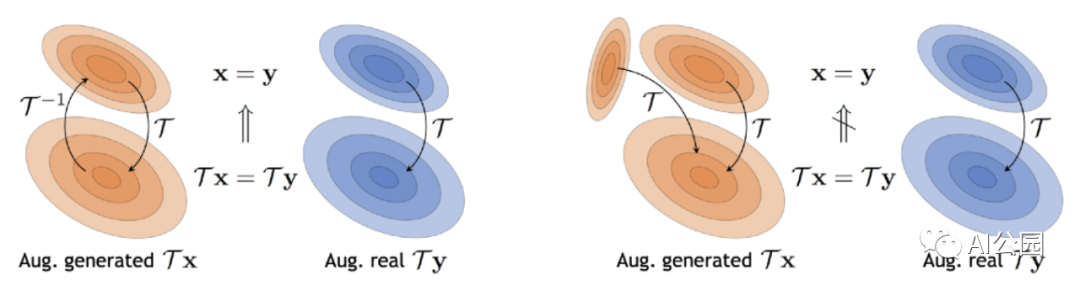

让我们借用文中的另一个例子来直观地理解可逆变换。从{0,90,180,270}度均匀选择的随机旋转是不可逆的(图4):增强后无法辨别方向的差异。这里,生成器可以自由地生成上下颠倒的图像,因为在增强分布中,{0,90,180,270}度的相对位置是相同的。因此,尽管生成器学会了匹配增强的分布Tx和Ty,但匹配虚假和真实数据分布x和y的潜在目标仍然没有得到解决。

如果这个旋转仅以概率p<1进行(图2,右):这增加了0度的出现率,现在只有生成的图像有正确的方向时,增强分布才能匹配(图5)。现在,当生成器试图生成颠倒的图像时,增强分布不再一致。因此,为了匹配转换后的分布Tx和Ty,生成器被迫匹配假分布x和真实分布y。

更一般地说,如果我们对生成的分布x和真实的分布y应用一个可逆变换T,那么为了匹配原始分布x和y,匹配增强分布Tx和Ty就足够了(图6)。

理论上,如果增强操作T是可逆的,存在一个且只有一个增强分布Tx, 而且x不应该有“泄漏”。然而,在实践中,由于有限的样本的局限性,有限的网络表示能力,归纳偏差和训练动态,很高的p值导致了生成图像的增强的泄漏。作者还表明,p的最优值对数据集大小非常敏感。他们通过使过程自适应来解决对p进行昂贵的网格搜索的问题。在深入细节之前,让我们先了解如何在GANs中度量过拟合。

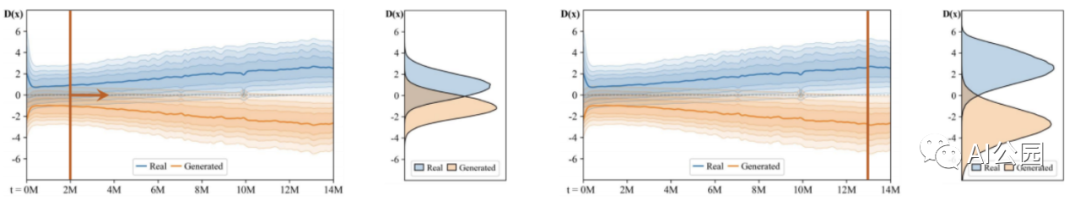

不同大小的数据集,在每种情况下训练开始以同样的方式,但最终优化停止了,并且FID开始上升(图8)。同时,开始的时候,鉴别器输出分布的和生成的图像重叠,但随着鉴别器(图7)变得越来越自信,这两个分布变得渐行渐远,并且,从FID开始恶化的点开始,随着分布的充分重叠,loss开始变得恒定。

量化过拟合的标准方法是使用一个单独的验证集,并观察其相对于训练集的行为。当过拟合开始时,验证集的行为开始越来越像生成的图像,而真实样本和生成样本的鉴别器输出开始发散。从图8可以看出,对于较小的数据集,这种情况发生得更早。

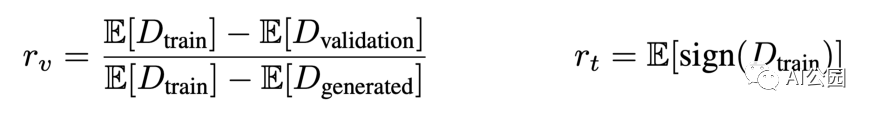

作者提出了两种似是而非的过拟合启发式方法来度量过拟合(图9)。第一个是启发式的r*v,*表示了验证集相对于训练集和生成的图像的输出。当训练集和验证集表现完全相同时,分子为0,因此r=0表示没有过拟合。当生成的和验证集行为完全相同时,分子和分母是相同的,因此r=1表示完全过拟合。

因为它假设在一个已经很小的数据集中存在一个单独的验证集,所以不可能计算rv启发式。因此,作者转向rt,它使用训练集的鉴别器预测为正的部分来识别过拟合,并随着训练的进展动态调整增强概率p:

rt太高→增加更多(增加p) rt过低→增加更少(减少p)

总之,作者提出了一种即插即用技术,通过引入一个应用增强的概率p来将不可逆转的图像增强转换为可逆变换。它们还提供了一种机制来自适应地调整这些增强,以改善GAN训练过程到最优状态。想要了解更多细节,我强烈推荐阅读原文。

英文原文:https://medium.com/swlh/training-gans-with-limited-data-22a7c8ffce78

推荐阅读

关于程序员大白

程序员大白是一群哈工大,东北大学,西湖大学和上海交通大学的硕士博士运营维护的号,大家乐于分享高质量文章,喜欢总结知识,欢迎关注[程序员大白],大家一起学习进步!