康奈尔开源近10万份审稿意见,未来论文发表或将由AI定夺

本文约3000字,建议阅读10分钟

本文提出REVIEWER2,一个创新的评审生成框架,通过明确模型,生成全面并详细的评审内容。

大语言模型(LLMs)的进步为自动化论文评审开辟了新途径,这些模型在学术反馈领域展现出巨大潜力。自动化评审的核心优势在于其能够精准指出论文草稿的不足之处,助力作者优化研究。尽管已有丰富的同行评审数据,但现有自动化评审系统仍面临挑战,如评审内容缺乏细节和无法涵盖多样化观点。

本文提出REVIEWER2,一个创新的两阶段评审生成框架,它通过明确建模评审内容的分布,生成更详尽的评审内容,全面覆盖人类评审者关注的细节。研究团队构建了一个包含27,000多篇论文和99,000多条评审的大规模数据集,并进行了特征提示的注释,以支持后续研究。

自动化评审虽前景广阔,但挑战亦不少。评审的特异性问题,即不同评审者关注点的差异,对自动化系统构成挑战。同时,确保评审内容具体又有建设性,并提供改进建议,是系统亟需解决的问题。本文的实验表明,REVIEWER2通过特征提示提高评审的质量和覆盖范围,克服了标准微调方法的局限性。

REVIEWER2框架介绍:一种新颖的两阶段论文评审生成方法

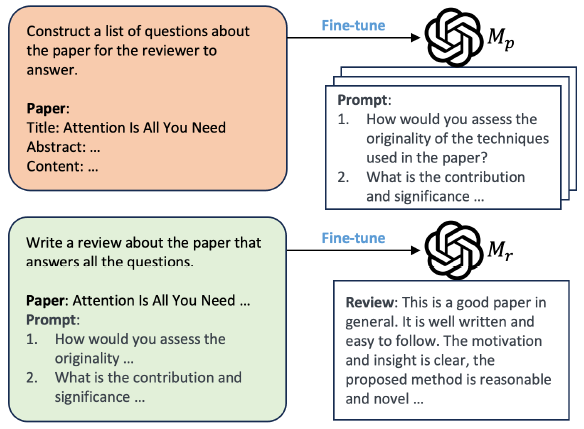

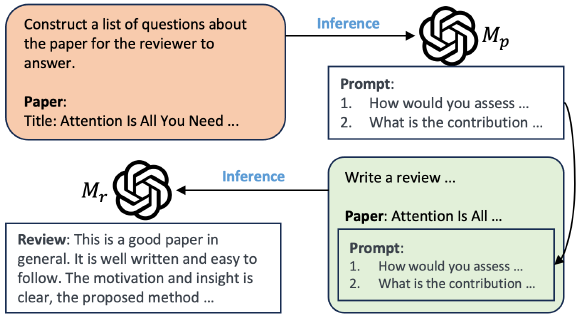

REVIEWER2是一种创新的两阶段论文评审生成框架,旨在解决现有自动化评审生成方法中的缺陷,如缺乏细节和覆盖范围有限的问题。这一框架通过显式建模可能涉及的评审特征的分布,生成更详细的评审,更好地覆盖人类评审员在草稿中识别的特征。

1. 第一阶段:利用大语言模型生成评审要点提示

在REVIEWER2的第一阶段,一个经过微调的大语言模型(LLM)分析论文并产生一组应该关注的评审特征。这些特征以提示的形式出现,作为第二阶段的输入。

2. 第二阶段:基于论文内容和提示生成详细评审

第二阶段的LLM根据论文内容和第一阶段生成的特征提示,生成详细的评审。这种两阶段方法不仅提供了对评审特征覆盖范围的明确控制,而且避免了单阶段生成方法中产生通用评审的倾向。

数据集构建:开发PGE管道注入评审要点

为了训练REVIEWER2,需要一个包含论文和评审的数据集,并且这些评审需要用特征提示进行增强。现有的评审数据集不包含特征提示,因此我们开发了一种名为Prompt Generation with Evaluation (PGE)的新方法来生成高质量的特征提示,并构建了一个大规模的评审数据集。

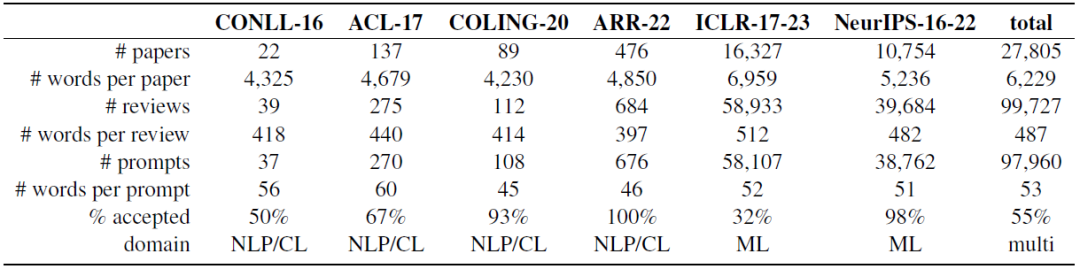

1. 数据集统计:涵盖27,000多篇论文和99,000多条评审

我们生成了一个大规模的评审数据集,包含27,000多篇论文和99,000多条评审(下表)。这些数据来自不同年份、不同会议和不同学科的论文和评审。

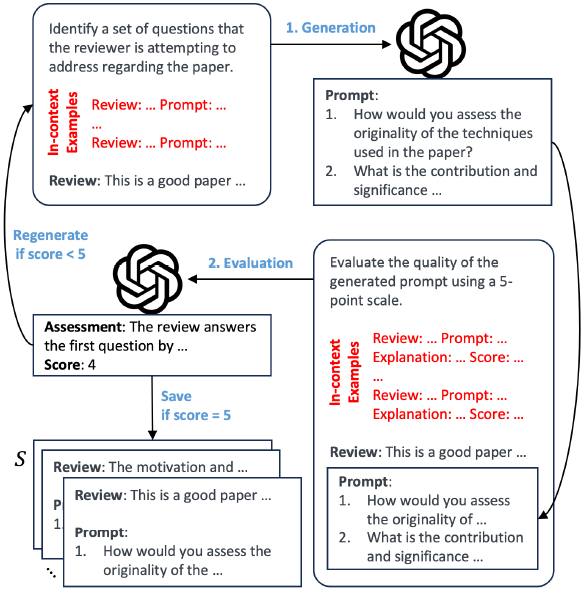

2. PGE方法:生成步骤与评估步骤详解

PGE方法包含生成步骤和评估步骤(下图)。在生成步骤中,给定一组论文和相应的参考评审,PGE为每条评审生成一个提示。在评估步骤中,生成的提示根据5分制进行评分。如果提示获得满分,则将其与相应的评审一起存储在数据集中;否则,提示将被重新生成。这种迭代方法解决了评审缺乏真实提示的问题,并在没有人工监督的情况下确保了提示生成的质量。

通过PGE方法,我们构建了一个包含特征提示的大规模评审数据集,这是首个此类数据集,并将其作为未来研究的资源公开。

实验分析的维度:评估REVIEWER2的评审质量、特异性和覆盖度

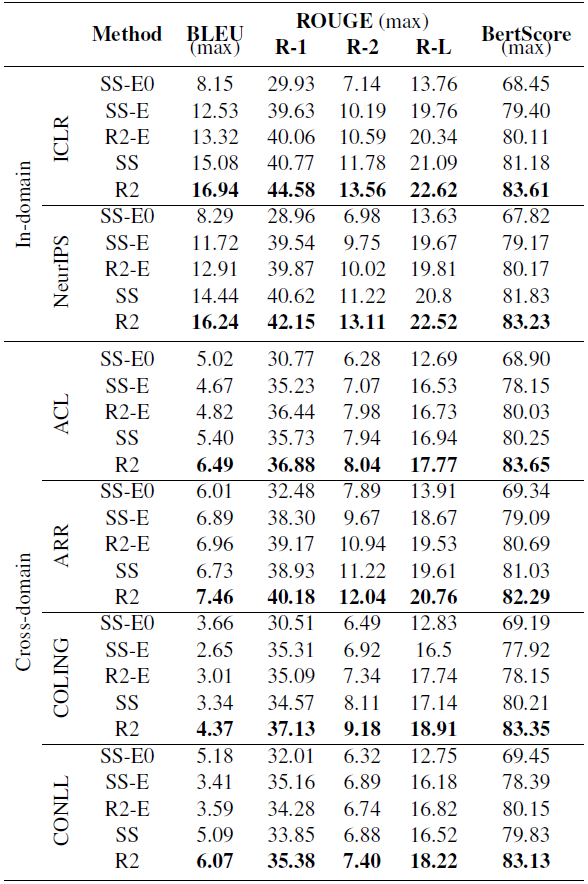

1. 质量分析:使用BLEU、ROUGE和BertScore指标

为了评估REVIEWER2生成的评审质量,我们采用了三种评价指标:BLEU、ROUGE和BertScore。BLEU和ROUGE指标通过比较生成评审与参考评审之间的n-gram重叠来评估文本的相似性,而BertScore则通过比较生成评审与参考评审在嵌入空间的语义相似性来进行评价。这些指标共同为我们提供了一个全面的质量评估框架。

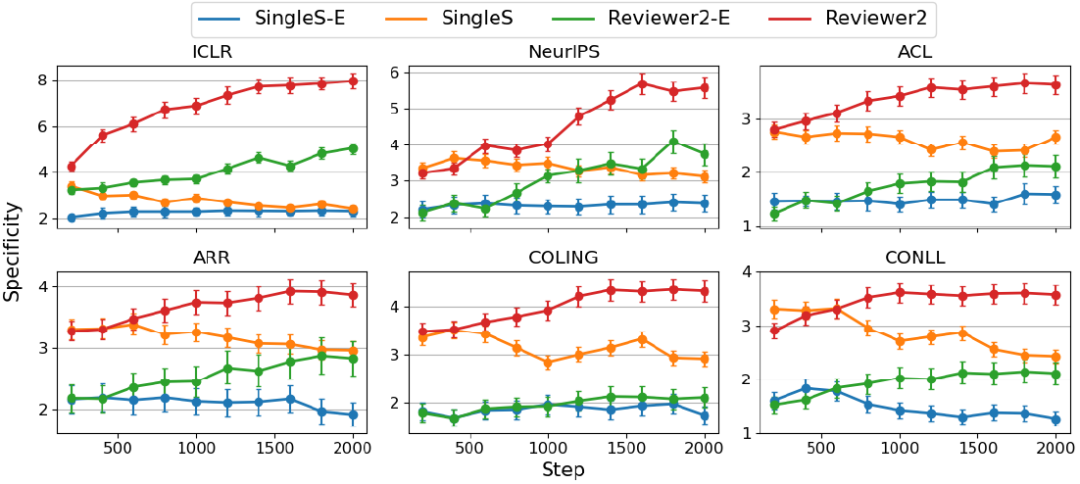

2. 特异性分析:基于BertScore的评审特异性度量

特异性分析旨在评估REVIEWER2生成的评审是否具有针对性,即评审是否能够识别并针对论文的特定特征进行评价。我们通过计算生成评审与不同论文的参考评审之间的BertScore下降幅度来衡量特异性。如果生成的评审具有高特异性,那么与其他论文的参考评审配对时,BertScore的下降幅度将会较大;反之,如果评审内容较为通用,则下降幅度较小。

3. 控制性分析:REVIEWER2对提示的响应性评估

控制性分析的目的是评估REVIEWER2在接收到特定的提示后,生成的评审是否能够覆盖所需的特征。通过比较REVIEWER2在接收到不同提示时生成的评审之间的相似性,我们可以评估其在不同提示下的多样性。理想情况下,REVIEWER2应能够根据不同的提示生成覆盖不同特征的评审。

4. 覆盖性分析:REVIEWER2对完全再现人类评审的覆盖率评估

覆盖性分析将评估作者能否通过选择特征提示实现良好的覆盖,也就是REVIEWER2能否完全再现人类评审。因此,在这里定义了一个覆盖率的概念。

实验数据解读:REVIEWER2在多个维度上优于现有方法

1. 质量对比:REVIEWER2与其他方法的性能比较

在质量对比方面,REVIEWER2在BLEU、ROUGE和BertScore指标上均优于现有的评审生成方法(下表)。这表明REVIEWER2能够生成与人类评审更为相似的评审内容,无论是在语法结构还是语义内容上,都能更好地匹配参考评审。

上表中,R2:REVIEWER2;R2-E:REVIEWER2-E(采用交叉熵提取方法从论文中提取一组不同的句子来代表论文的内容);SS:SINGLES(对单级模型进行微调,以便直接从论文的完整上下文中生成评论,而无需特征提示);SS-E:SINGLES-E(此变体包括微调单一模型,以便仅从论文提取的摘要中生成评论);SS-E0:SINGLES-E0(这种 "0-shot "方法可促使 LLM 直接从提取的上下文中生成评论,而无需特征提示)

2. 特异性对比:REVIEWER2生成评审的针对性

在特异性分析中,REVIEWER2生成的评审显示出较高的特异性,这意味着其评审内容具有较强的针对性,能够准确地识别并评价论文的特定特征。下图是四种评审方式在6个不同数据集中2000个步骤的特异性图。

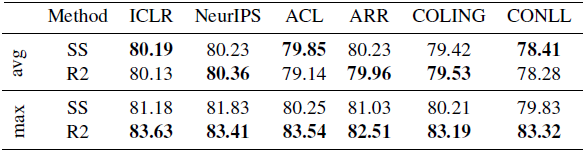

3. 控制性对比:REVIEWER2生成评审的多样性

下表中,两种方式的平均值比较接近,但REVIEWER2在所有六个数据集的最大相似度较高,说明REVIEWER2能够持续生成与其中一个参考资料非常接近的评审。这证明REVIEWER2能对特征提示做出反应,并能覆盖所需的特征。这种方式能够根据不同的提示生成多样化的评审,这进一步证明了其在生成评审时具有较好的控制性。

4. 覆盖性对比:REVIEWER2生成评审的接近性

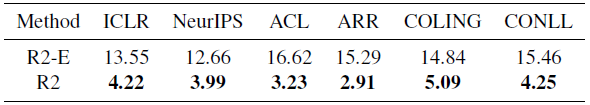

结果如下表所示。如果完全再现人类评论,则意味着覆盖率值为0。表中REVIEWER2的值明显比R2-E的小,这表明它能有效地针对给定论文的不同提示生成量身定制的回复,也表明了使用完整上下文的重要性。

讨论与限制:REVIEWER2的潜力、挑战和未来方向

输入不一致性与域知识限制

REVIEWER2的开发旨在通过自动化的方式生成论文评审,以揭示当前草稿的薄弱环节。然而,这一过程面临着输入不一致性的挑战。例如,REVIEWER2的输入包括人类编写的评审和论文本身,而其前置流程PGE仅以人类编写的评审为输入。这种输入的差异性可能导致生成的提示与评审生成流程的有效对齐受限。此外,由于Llama-2-70B-Chat(本实验所用的大语言模型)的上下文长度限制,REVIEWER2无法直接处理整篇论文,这可能影响评审的质量和具体性。

另一个挑战是域知识的限制。REVIEWER2依赖于预训练的语料库来生成评审,这可能导致对于需要深入领域知识的论文无法产生准确的评审。未来的研究可以探索通过对论文语料库进行第二阶段的预训练或领域适应来提高评审的准确性。

自动化评审的伦理考量

自动化评审系统如REVIEWER2在提供论文反馈方面具有潜力,但同时也引发了伦理问题。自动化评审不应被视为替代人类评审员的工具,而是作为辅助工具,帮助作者改进工作,并为人类评审员提供指导。自动化评审的结果不应被误解为对论文的最终和权威评价。在使用数据集时,研究人员必须遵循既定的目的,并确保遵守开放许可协议,同时排除个人元数据和评审员身份信息,以保护个人隐私。

总结:REVIEWER2对自动化论文评审的贡献与未来展望

REVIEWER2作为一种自动化论文评审工具,通过引入特征提示(aspect prompts)来生成更具体性和覆盖范围的评审。它的开发旨在帮助作者在正式同行评审前提高工作质量,从而减轻同行评审过程的压力。REVIEWER2的贡献在于其两阶段评审生成框架,以及它为未来研究提供的大规模带有特征提示的评审数据集。

尽管REVIEWER2在提高评审质量、具体性和可控性方面表现出潜力,但它仍面临输入不一致性、域知识限制和伦理问题等挑战。未来的研究可以探索整合提示生成和评审生成过程,提高生成提示的有效性,并通过领域适应或二阶段预训练来增强模型的领域知识。此外,随着技术的进步,如GPT-4的出现,未来的工作可能会探索使用更长的上下文长度来提高评审的质量,同时考虑成本效益。

REVIEWER2及其生成的数据集为自动化论文评审领域提供了一个有价值的起点,为未来的研究和发展奠定了基础。随着技术的不断进步和伦理问题的深入讨论,自动化论文评审有望成为科研写作和出版流程中的一个重要辅助工具。

编辑:黄继彦