ICLR 2022博客赛道出炉:接收21篇,特斯拉AI总监也有稿

新智元报道

新智元报道

编辑:LRS

【新智元导读】博客在技术交流中占据着重要的角色,但因其内容的随意性,似乎让博客与顶会论文无缘。最近ICLR 2022的博客赛道出炉21篇接收文章,意在用非正式的语言讨论正经的科学问题。

把博客当成论文投,是种什么体验?

ICLR 2022在去年征稿时就加了这样一个实验性质的新玩法:博客投稿(blog post track),相比论文来说,博客的写作更加随意,但也更容易发现新问题、激发新的思考。

接收博文的内容主要是讨论以前在ICLR发表过的论文,为了保持客观中立,不能写与自己利益冲突的工作,比如自己以前的文章或是源自相同机构或公司的论文。

博客经由双盲评审以保证内容的质量、问题的新颖性,即论述的清晰度、新的理论或实验见解,可重复的扩展实验等。

本次共接收了21篇博客文章,其中包括一篇特斯拉AI高级总监Andrej Karpathy的受邀报告,回顾了33年前的神经网络与今天的区别。

网站地址:https://iclr-blog-track.github.io/

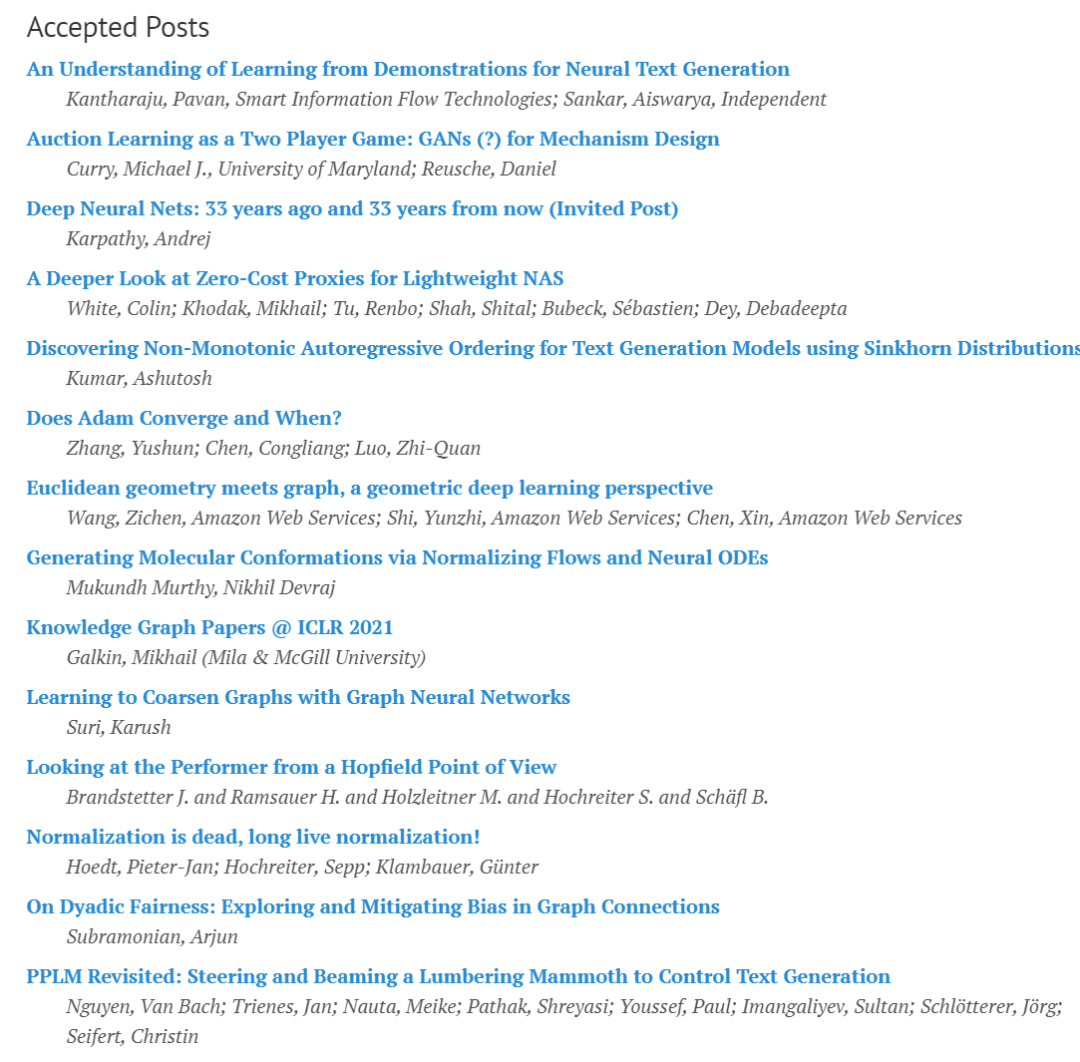

接收博客的研究内容五花八门,从各种神经网络trick的重新思考到特定领域的近期论文总结,看起来绝对比看论文要省脑力。

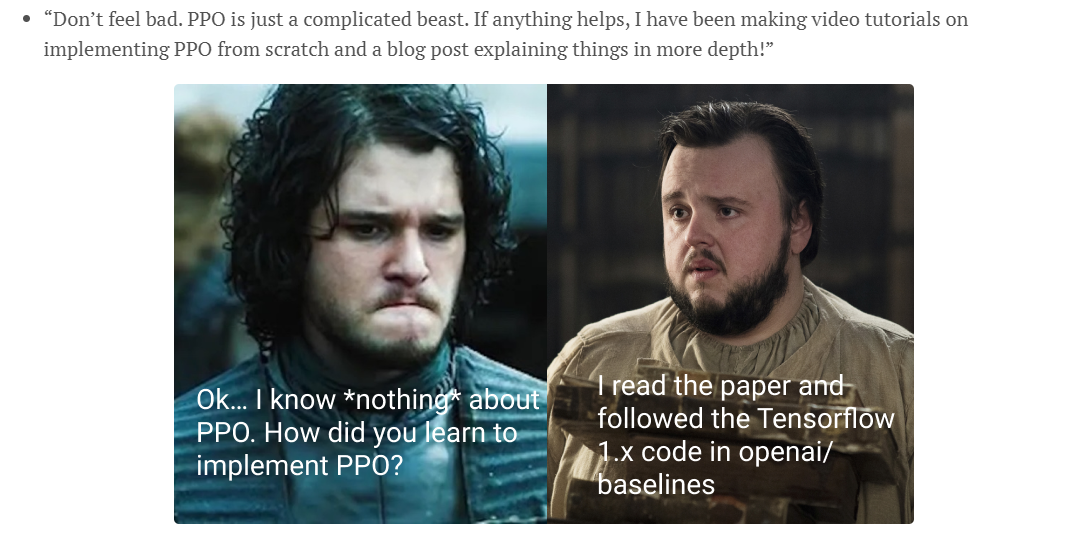

博客的写法也是百无禁忌,使用表情包,以轻松、口语化的对话让读者更快理解内容,确实能够起到科学传播和讨论的作用。

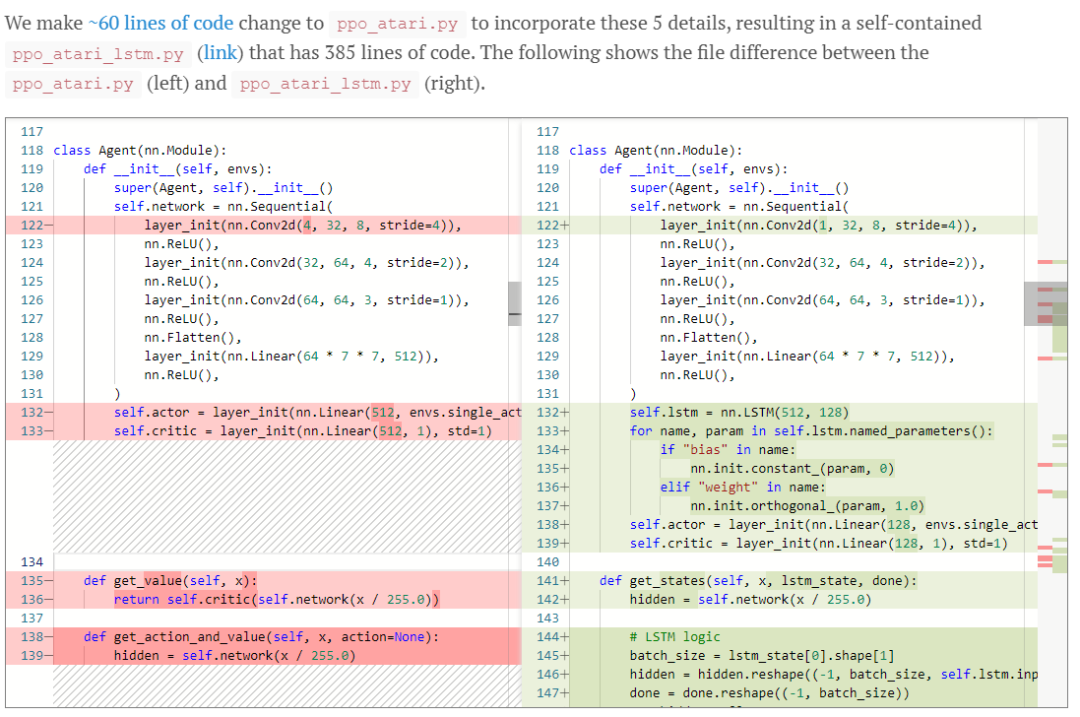

文章链接:https://iclr-blog-track.github.io/2022/03/25/ppo-implementation-details/

并且文章里也是直接「贴代码」,可复现的概率直接拉满。

下面简要介绍几篇接收的博客文章。

Adam的收敛性

Adam的收敛性

博客链接:https://iclr-blog-track.github.io/2022/03/25/does-adam/

研究人员重新审视了Adam的(非)收敛行为,并简要回顾了Reddi等人的非收敛结果和Shi等人的收敛结果。这两个结果是否相互矛盾?如果不是,Shi等人的收敛分析是否符合Adam的实际设置?理论和实践之间的差距有多大?这篇博客从多个不同的角度讨论这些问题。实验结果将表明,这个差距实际上是不可忽略的,关于Adam收敛性的讨论还远远没有结束。

文章的指导作者为罗智泉,于1984年在北京大学数学系获学士学位,1989年获得美国麻省理工学院博士学位,1998年成为加拿大麦克马斯特大学终身教授。

2014年5月,罗智泉教授被聘为香港中文大学(深圳)副校长,主管学术和科研。自2016年3月起,罗智泉教授兼任深圳市大数据研究院院长。自 2018年 6月起,罗智泉教授兼任香港中文大学(深圳)-腾讯 AI LAB 机器智能联合实验室主任。2020年9月,罗智泉教授兼任香港中文大学(深圳)—深圳市大数据研究院—华为未来网络系统优化创新实验室主任。

罗智泉教授的研究主要集中在优化理论、算法设计以及其在信息科学中的应用。

从几何学看深度学习

从几何学看深度学习

图神经网络(GNN)一直是机器学习研究的一个活跃领域,用于解决图数据中的各种问题。图是表示实体(作为节点)之间关系的一种有效的方式,有时节点和边可以有空间特征,如节点的三维坐标和边的方向。如何在考虑这些几何特征的同时对图的拓扑结构进行推理?这篇博客讨论了发表在ICLR 2021上的论文Learning from Protein Structure with Geometric Vector Perceptrons。

博客链接:https://iclr-blog-track.github.io/2022/03/25/euclidean_geometric_graph/

文章的第一作者Zichen Wang是AWS下亚马逊机器学习解决方案实验室的应用科学家,2016年在西奈山伊坎医学院获得博士学位。研究兴趣包括自然语言处理、生成模型、图神经网络、对比学习和强化学习的应用。在生命科学和医疗保健领域有超过10年的经验,致力于开发利用生物医学数据的机器学习模型,用于药物发现和人类疾病建模。

重新思考ValueDice

重新思考ValueDice

许多实际应用涉及顺序决策。对于这些应用,代理人实施一个政策来选择行动并使长期回报最大化。模仿学习方法(Imitation learning)从专家的演示中获得最优策略,并成功应用于游戏、推荐系统和机器人学等。模仿学习的里程碑之一是引入生成式对抗性模仿学习(GAIL),以对抗方式进行状态-动作分布匹配。即使在专家演示稀缺的情况下,GAIL也被经验证明可以匹配专家的表现。代价是GAIL需要大量的环境交互,也限制了GAIL在在线环境下的应用。

其中一个改进策略就是ValueDice,作为一种off-policy算法,ValueDice在交互效率方面优于其他方法。现有的结果都表明ValueDice是完美的。这篇博客研究的核心问题为:这些改进是否得益于更先进的算法设计?并对算法内的「矛盾」做出解释。

博客链接:https://iclr-blog-track.github.io/2022/03/25/rethinking-valuedice/

文章的作者Ziniu Li是香港中文大学(深圳)的博士生,导师为罗智泉,研究兴趣包括强化学习、优化和学习理论。

33年前的卷积

33年前的卷积

博客链接:https://iclr-blog-track.github.io/2022/03/26/lecun1989/

1989年,图灵奖得主Yann LeCun首次在论述网络结构时使用「卷积」一词,距今已有33年。通过跟现代卷积神经网络对比,我们可以站在上帝视角来看当年到底哪些问题困扰着LeCun,影响了卷积神经网络的进一步发展;还可以了解到深度学习领域在这33年发展期间到底发生了哪些变化。

除了完整复现LeCun当年的代码外,还用上许多现代深度学习技巧,将图像识别的错误率从5%降低到1.25%,借助更强大的计算设备,训练时间也从三天降低到了几十秒。

文章作者为特斯拉AI高级总监Andrej Karpathy,博士毕业于斯坦福大学,师从李飞飞,主要研究研究卷积/循环神经网络架构与计算机视觉应用,以及它们在计算机视觉、自然语言处理以及二者交叉领域的应用。

为啥开始接收博客?

为啥开始接收博客?

组织者介绍,开设博客通道的另一个原因是机器学习领域的「浮夸风」,几乎所有的论文都面临可重复性危机和评审危机。

每年顶会的投稿数量都在增加,为了在竞争中收获Accept,投稿人有动机在论文中夸大实验结果,「虚假繁荣」一定程度上会削弱科学社区的权威性。

与之相对的,博客文章在学术圈的地位与日俱增,所有人都可以对论文发表自己的见解,并进行公开、人性化且透明的讨论,能够对科学界有实质性的提升。

博客更像是「成功者的游戏」,许多成熟的研究人员或者大公司才会有精力维持一个博客,并以此来提高自己的知名度,比如Google AI, Meta AI, DeepMInd, Nvidia都有博客网站,专门刊登一些团队的研究成果介绍,并有专门的作者对文章进行润色。

不过毕业找工作、评绩效的时候,人家不会看你发表了多少篇博客,只会看论文的数量和质量。

所以写科学博客大多都是自我驱动的,赔本赚呦喝,要求大部分机器学习从业者都来写博客做贡献是不合理的。

ICLR下场,就相当于给博客盖了个「官方认证」的戳,以鼓励研究人员回顾过去的工作、总结成果或强调一些现有的不足之处,提供一种新的方式来总结机器学习社区的科学知识。

不过顶会接收博客毕竟还属于新鲜玩意,未来如何发展还未可知,改变或许就是好事。

参考资料:

https://iclr-blog-track.github.io/