这个网站,可以一键爬取网页上的所有图片!

大家好,我是崔庆才。

今天给大家推荐一个网站,可以一键下载分析和获取网页上的所有图片,并且可以一键打包下载!

介绍

开门见山了,这个网站的链接是:https://extract.pics/

长这个样子:

大家可以看到,打开之后就是一个醒目的输入框,可以直接输入一个网站链接,然后它就可以把网站上的图片都爬取下来。

我们来做一个测试吧。

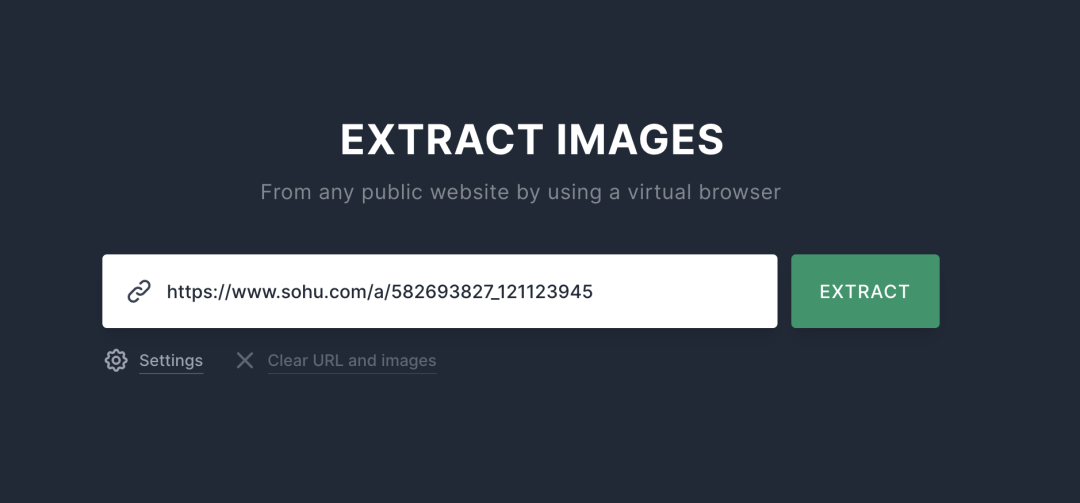

比如我随便搜了一个包含一些手机壁纸图片的链接:https://www.sohu.com/a/582693827_121123945

为方便大家查看,我把这个链接转了下二维码,可以扫描这个二维码来直接查看这个样例网站:

看完了吧,里面的好看的手机壁纸图还不少吧~

那怎么快速保存下来呢?

我们就直接把这个链接贴到 https://extract.pics/ 就好了:

接下来,直接点击 EXTRACT 按钮即可。

这时候我们可以在网站下方看到一些“爬取”进度,比如启动爬取器、分析、滚动、提取等等。

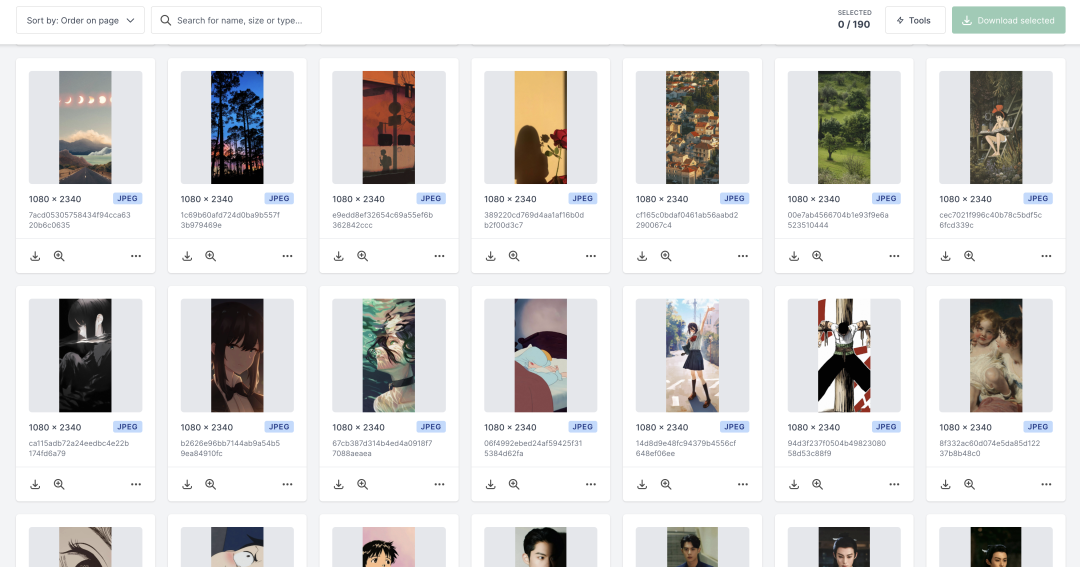

稍等片刻,我们就可以发现所有的图片都被分析出来了:

看,所有好看的壁纸都在这里了!

接下来我们可以直接选中想要的图片,就可以直接下载到本地了,不用一个个保存~

当然也可以自行选择某张图片下载,非常方便!

原理

好,其实这个网站基本功能就这么多,当我们想要批量下载某个网页上的图片的时候,它就是一个不错的选择~

下面我们看看这个网站的原理究竟是啥。

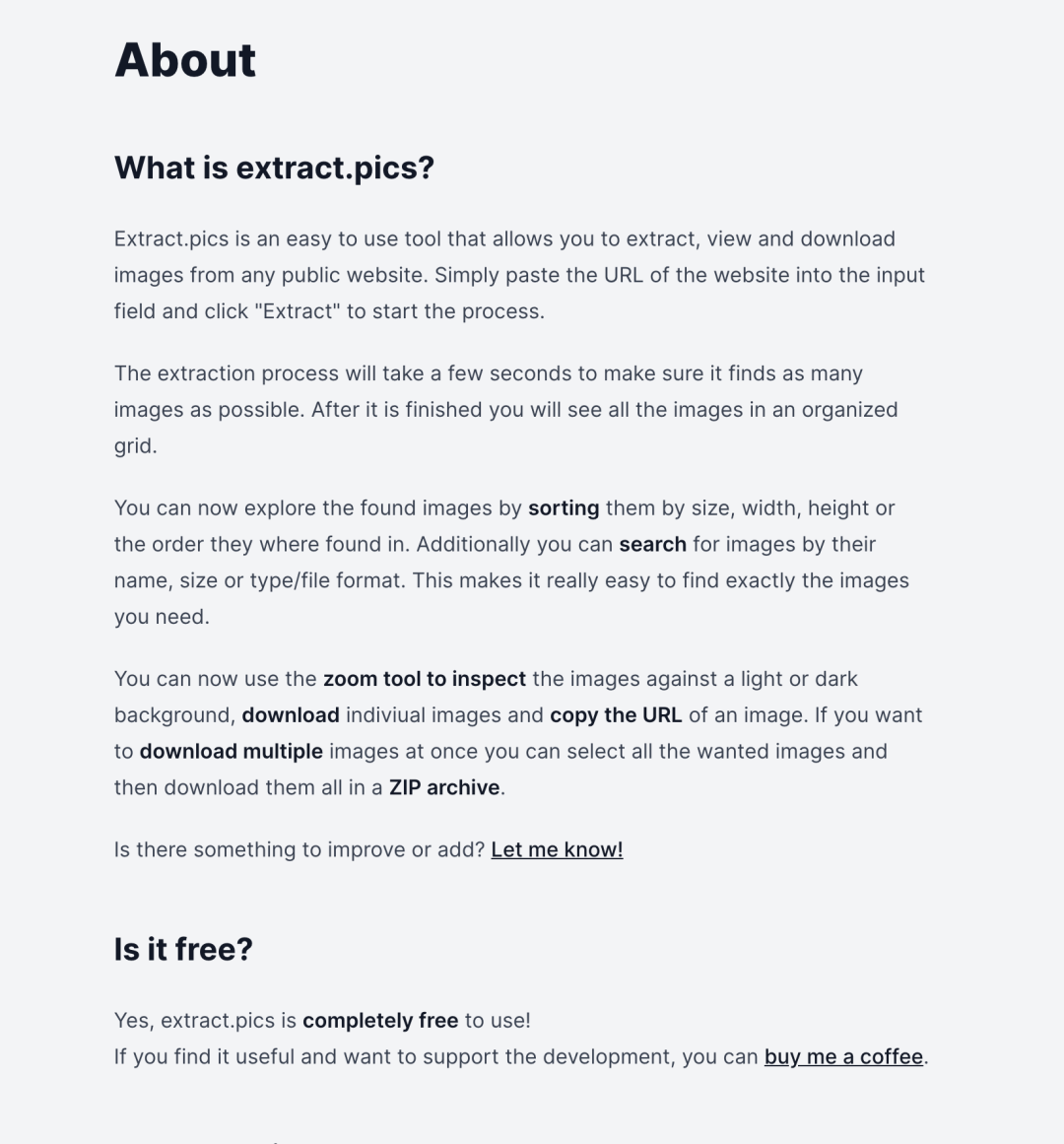

滚动到页面下方,其实可以看到网站的一些介绍内容:

和我们理解的一样,就是用来快速提取公开网站图片的一个网站。

当然网站还提供了排序、搜索功能,让我们能更方便地找到想要的图片,也可以多选直接将多张图片以 zip 压缩包的形式下载下来。

网站同时也是完全免费的,当然我们也可以选择捐赠支持。

怎么运作的呢?

接着看。

其实原理也非常简单了,其实背后就是开了一个 Google Chrome 的浏览器,就是一个 Headless 的 WebDriver,估计大概率就是基于 Selenium、Pyppeteer、Playwright 等做的,然后自动化地把这个页面渲染出来,然后提取所有的图片并返回结果就行了。

似乎对于我们专门做爬虫的程序员来说,没什么稀奇的哈哈。

关于更多内容大家也可以到网站里面去了解下。

今天的分享就先到这里啦,感谢大家!

End

崔庆才的新书《Python3网络爬虫开发实战(第二版)》已经正式上市了!书中详细介绍了零基础用 Python 开发爬虫的各方面知识,同时相比第一版新增了 JavaScript 逆向、Android 逆向、异步爬虫、深度学习、Kubernetes 相关内容,同时本书已经获得 Python 之父 Guido 的推荐,目前本书正在七折促销中!

内容介绍:《Python3网络爬虫开发实战(第二版)》内容介绍

扫码购买