DeepMind丢掉了归一化,让图像识别训练速度提升了8.7倍 | 已开源

金磊 发自 凹非寺

量子位 报道 | 公众号 QbitAI

在大规模图像识别任务上,DeepMind的新方法火了。

不仅拿到了SOTA,训练速度还提升了8.7倍之多!

方法关键:去“批处理归一化”

对于大多数图像识别模型来说,批处理归一化(batch normalization)是非常重要的组成部分。

但与此同时,这样的方式也存在一定的局限性,那就是它存在许多并不重要的特征。

虽然近期的一些研究在没有归一化的情况下,成功训练了深度ResNet,但这些模型与最佳批处理归一化网络的测试精度不相匹配。

而这便是DeepMind此次研究所要解决的问题——提出了一种自适应梯度剪裁 (AGC) 技术。

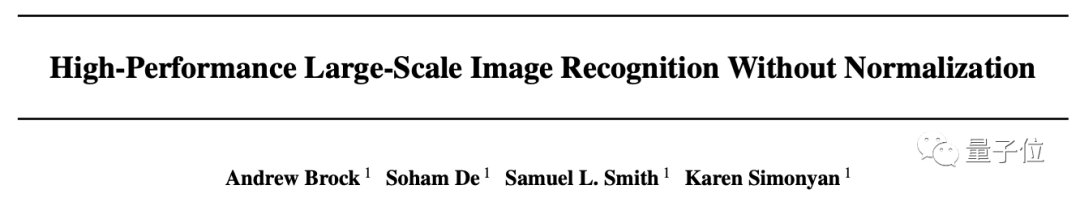

具体而言,这是一种叫做Normalizer-Free ResNet (NFNet)的新网络。

整体来看,NFNet的整体结构如上图所示。

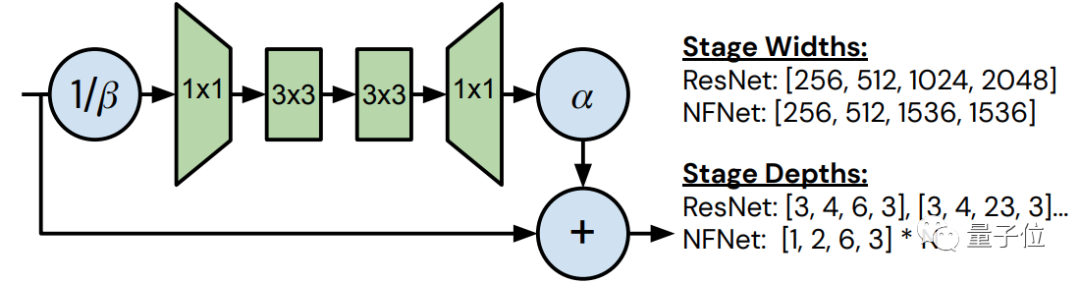

以有无“transition块”来划分,可以再细分为2种情况。

其中,它们的bottleneck ratio均设置为0.5,且在3 x 3的卷积中,无论信道的数量为多少,组宽都固定为128。

二者的区别在于skip path接收信号的方式,左侧的是在用β进行variance downscaling和缩放非线性之后;而右侧则是在用β进行variance downscaling之前完成。

实验结果

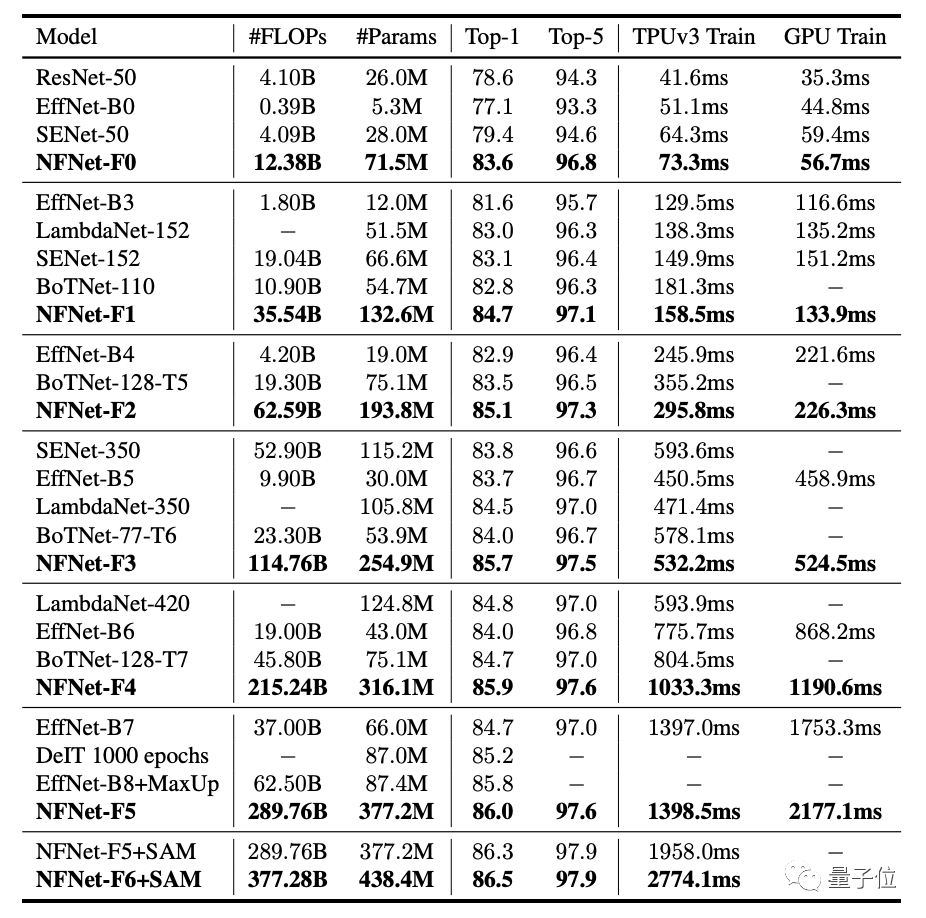

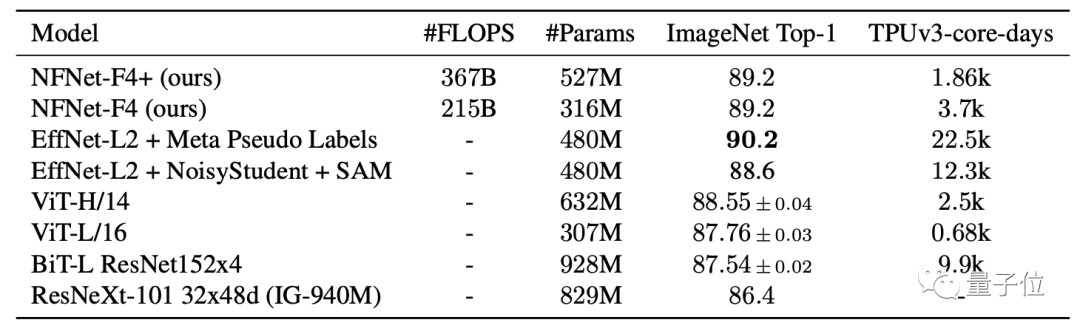

在实验部分,DeepMind的研究人员,采用了与NFNet相关的7个模型做了对比实验,分别是NFNet-F0至NFNet-F6。

不难看出,在各个模型的对比过程中,在Top-1精度方面均取得了最好结果。

值得一提的是,与EfficientNet-B7相比,训练速度方面提升了8.7倍之多。

此外,在对3亿张标记图像进行大规模预训练后,在ImageNet上还取得了89.2%的Top-1精度。

最后,对于这项研究的代码,也已在GitHub上开源。

传送门

论文地址:

https://arxiv.org/abs/2102.06171

代码地址:

https://github.com/deepmind/

— 完 —

本文系网易新闻•网易号特色内容激励计划签约账号【量子位】原创内容,未经账号授权,禁止随意转载。

推荐阅读

加入AI社群,拓展你的AI行业人脉

量子位 QbitAI · 头条号签约作者

վ\\'ᴗ\\' ի 追踪AI技术和产品新动态

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见~