全新PyTorch库:让模型训练速度提升2到4倍

↓↓↓点击关注,回复资料,10个G的惊喜

登陆 GitHub 以来,这个项目已经收获了 800 多个 Star。

20 多种加速计算机视觉和语言建模训练网络的方法。当 Composer 为你完成工作时,你就不需要浪费时间尝试复现研究论文。

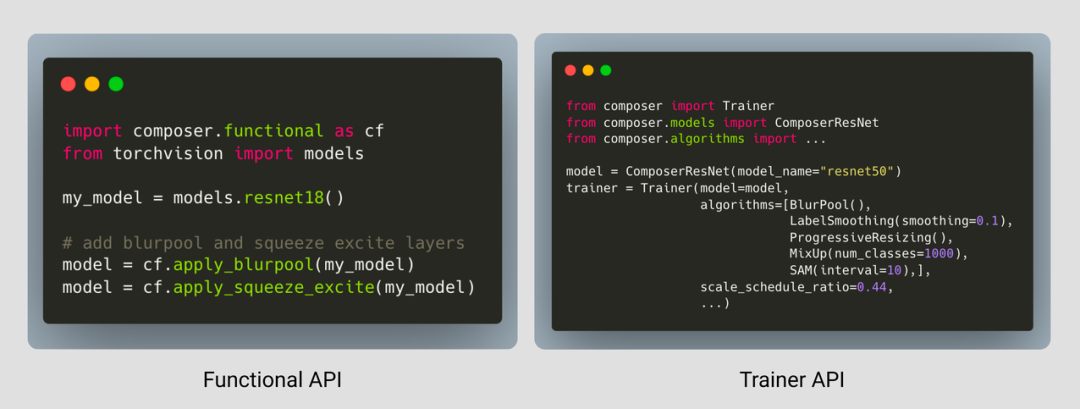

一个易于使用的 Trainer,其编写的目的是尽可能提高性能,并集成了高效训练的最佳实践。

所有加速方法的功能形式,都允许用户将它们集成到现有的训练循环中。

强大、可重现的基线,让你尽可能地快开始工作。

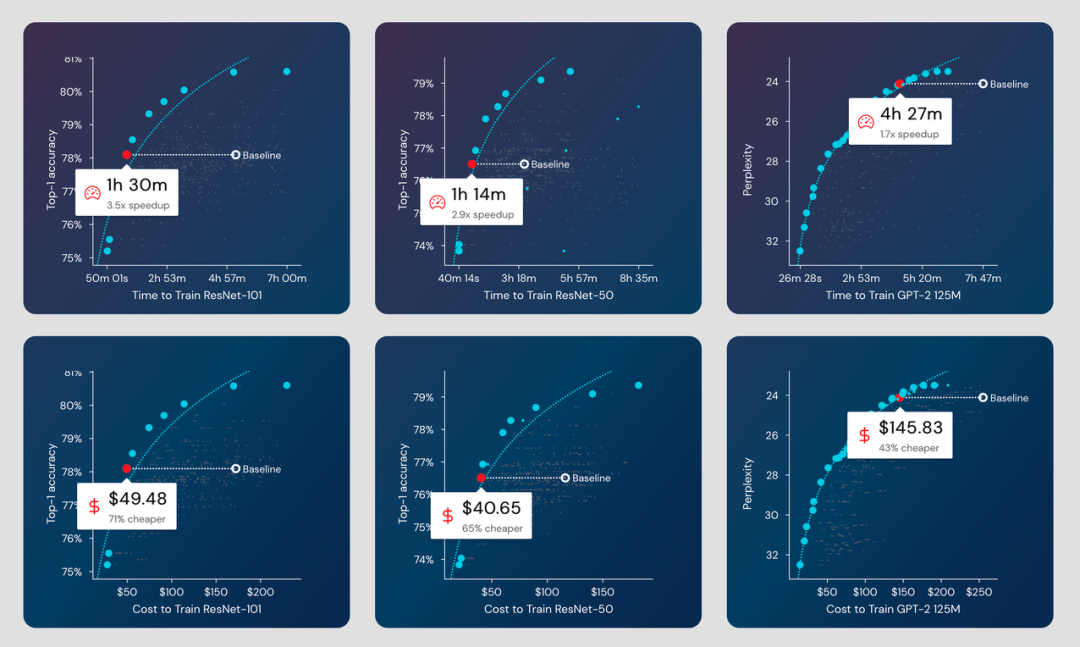

ResNet-101 在 ImageNet 上的准确率在 1 小时 30 分钟内达到 78.1%(AWS 上 49 美元),比基线快 3.5 倍,便宜 71%。

ResNet-50 在 ImageNet 上的准确率在 1 小时 14 分钟内达到 76.51%(AWS 上 40 美元),比基线快 2.9 倍,便宜 65%。

在 4 小时 27 分钟内将 GPT-2 在 OpenWebText 上的困惑度提高到 24.11(AWS 上 145 美元),比基线快 1.7 倍,便宜 43%。

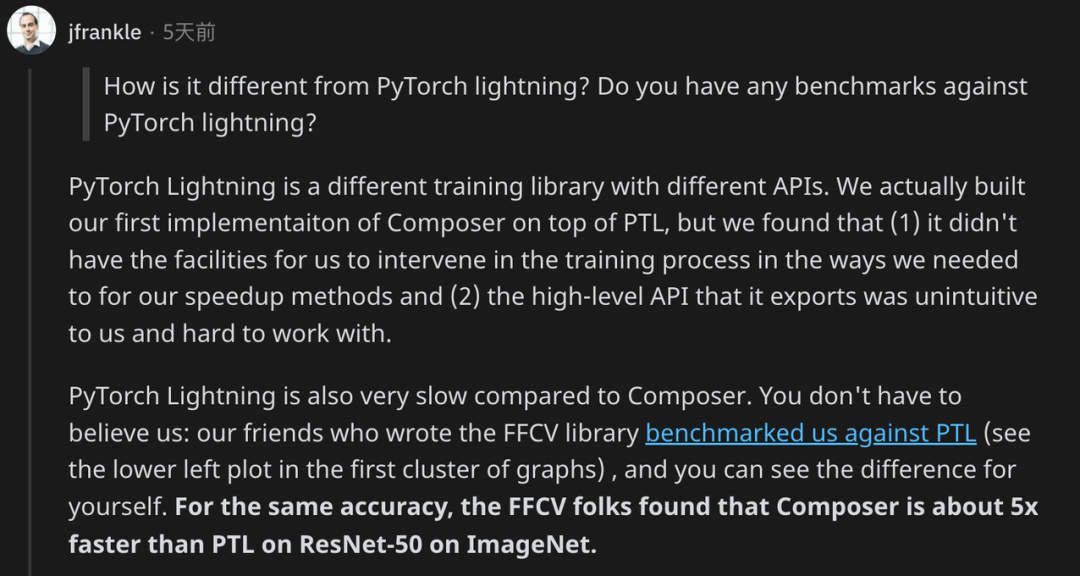

评论