【深度学习】动漫风格迁移AnimeGANv2,发布线上运行Demo

By 超神经

内容一览:最强二次元风格迁移模型 AnimeGAN 更新啦,现在可以在线上轻松运行模型,还可以调整风格参数,输出你想要的照片效果。

关键词:风格迁移 机器视觉 二次元

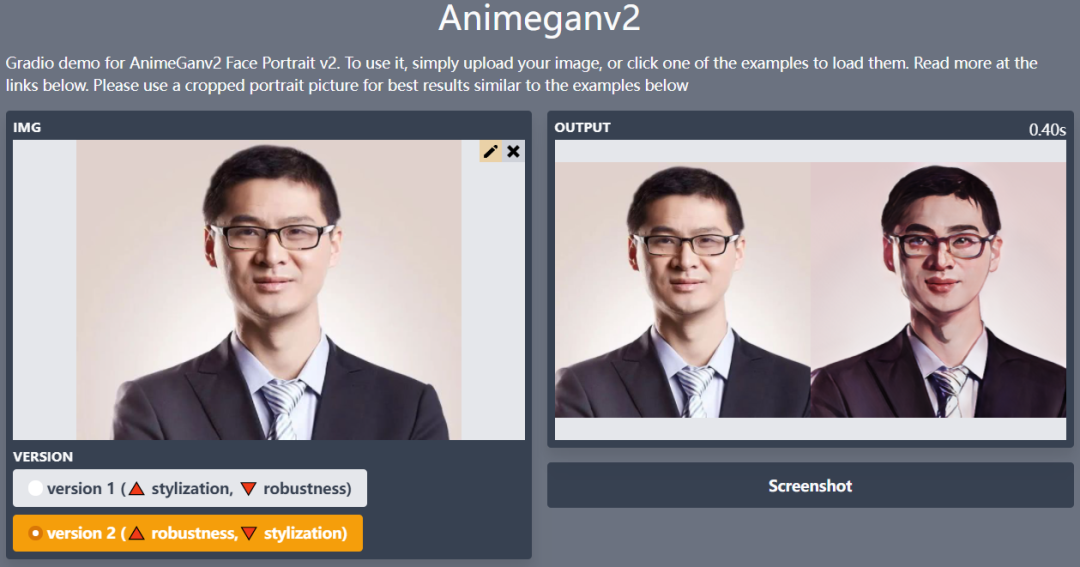

AnimeGANv2 最近发布了一项更新,由社区贡献者开发,通过 Gradio 实现了一个可以在线运行的 Demo,发布在 huggingface 上。

访问

https://huggingface.co/spaces/akhaliq/AnimeGANv2

即可在线上轻松实现 AnimeGANv2 的处理效果(仅支持静态图片处理)。

AnimeGAN:三次元通通变二

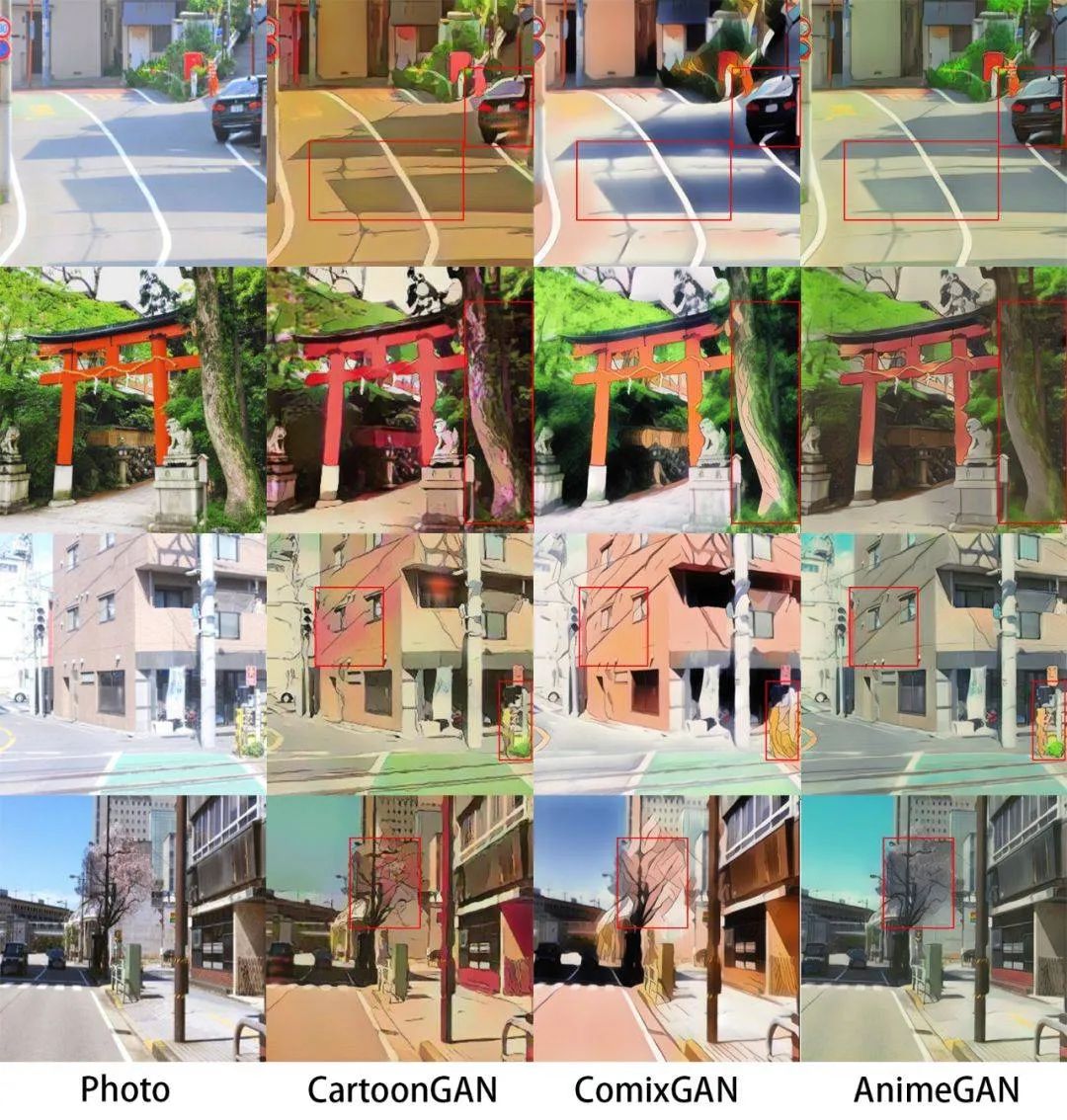

AnimeGAN 是基于 CartoonGAN 的改进,并提出了一个更加轻量级的生成器架构,2019 年 AnimeGAN 首次开源便以不凡的效果引发了热议。

AnimeGANv2 线上测试效果

在初始版本发布时的论文《AnimeGAN: a novel lightweight GAN for photo animation》中还提出了三个全新的损失函数,用于提升风格化的动漫视觉效果。

这三个损失函数分别是:灰度风格损失,灰度对抗损失、颜色重建损失。

AnimeGAN 与其他动漫风格迁移模型的效果对比

去年九月发布的 AnimeGANv2 优化了模型效果,解决了 AnimeGAN 初始版本中的一些问题。

在 v2 中还新增了新海诚、宫崎骏、今敏三位漫画家漫画风格的训练数据集。

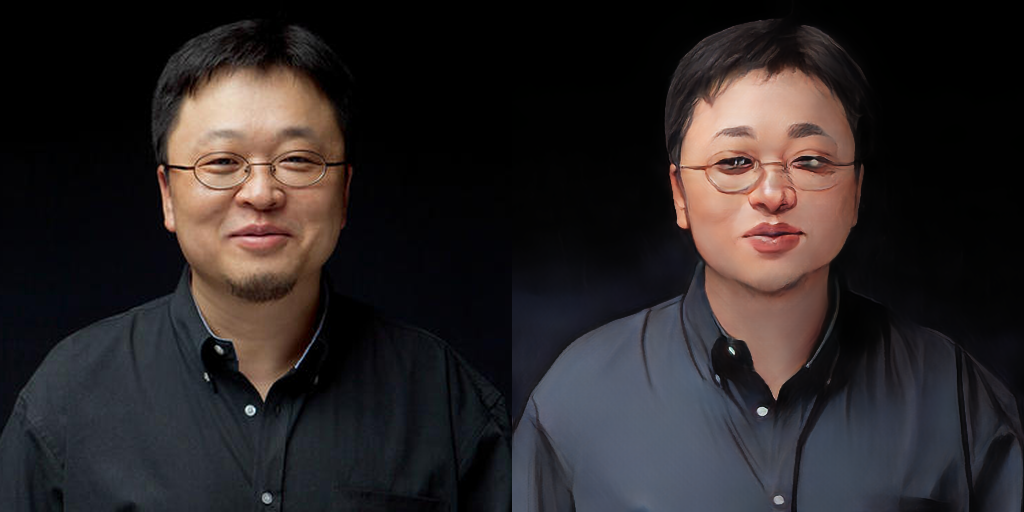

AnimeGAN 初代模型运行效果

AnimeGANv2 模型运行效果

以马斯克为例,AnimeGAN 初代的效果已经很令人惊艳,只是太过于白嫩病娇,仿佛韩国男团成员。相比之下,v2 更加自然,也更贴合真实气质。

AnimeGANv2 的更新重点:

- 解决了生成的图像中高频伪影的问题;

- v2 更易于训练,并能直接达到论文所述的效果;

- 进一步减少生成器网络的参数数量。(生成器大小 8.17Mb);

- 加入更多高质量影像数据。

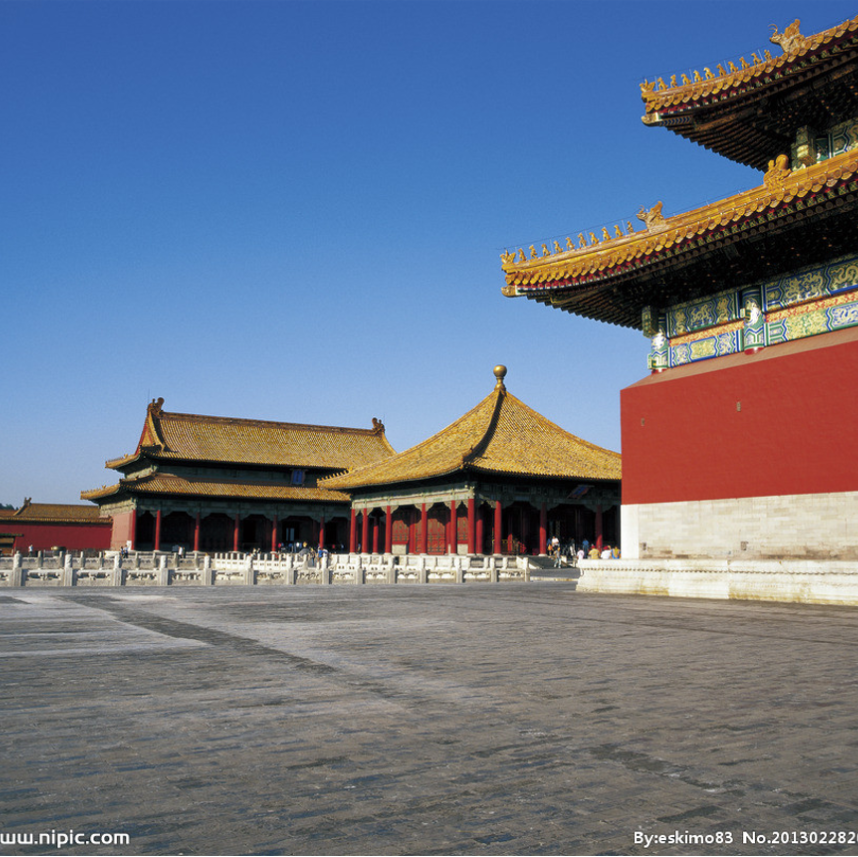

风景建筑图片 AnimeGANv2 模型运行效果

项目信息

TensorFlow 版本环境配置要求

python 3.6

tensorflow-gpu

tensorflow-gpu 1.8.0 (ubuntu, GPU 1080Ti or Titan xp, cuda 9.0, cudnn 7.1.3)

tensorflow-gpu 1.15.0 (ubuntu, GPU 2080Ti, cuda 10.0.130, cudnn 7.6.0)

opencv

tqdm

numpy

glob

argparse

PyTorch 实现

权重转换

git clone https://github.com/TachibanaYoshino/AnimeGANv2python convert_weights.py

推理

python test.py --input_dir [image_folder_path] --device [cpu/cuda]墙内 Colab 运行

项目 GitHub

https://github.com/TachibanaYoshino/AnimeGANv2

线上 Demo

https://huggingface.co/spaces/akhaliq/AnimeGANv2

墙内 Colab

https://openbayes.com/console/open-tutorials/containers/pROHrRgKItf

眉清目秀的张三不像坏人

—— 完 ——

往期精彩回顾 本站qq群955171419,加入微信群请扫码: